Data / IA

IA en cybersécurité : qui mène vraiment le jeu ?

Par Laurent Delattre, publié le 12 décembre 2025

De la fraude hyper-personnalisée aux malwares polymorphes et aux agents autonomes, l’intelligence artificielle redéfinit en profondeur le paysage de la cybersécurité. Face à des attaques industrialisées par l’IA, la défense se réinvente avec copilotes SOC, automatisation et prédiction, mais doit aussi sécuriser ses propres modèles pour éviter un nouveau point de rupture.

La cybersécurité repose sur un déséquilibre redoutable : d’un côté, des attaquants qui frappent quand ils veulent, comme ils veulent, là où ils veulent, en choisissant les conditions les plus propices ; de l’autre, des défenseurs qui doivent tout protéger, partout, tout le temps, alors même que la surface d’attaque s’étend inexorablement avec le SI et sa complexité. Longtemps, on a espéré que l’IA rééquilibrerait les forces : avec leurs télémétries riches (réseaux, endpoints, identités), les entreprises entraîneraient des modèles plus pertinents que ceux des attaquants et prendraient enfin l’avantage.

Mais ça, c’était avant l’arrivée de l’IA générative. Depuis, l’éternel jeu du chat et de la souris est relancé de plus belle… et les dés semblent pipés. Certes, les avis divergent sur l’état actuel des forces. « En 2025, l’augmentation exponentielle des fraudes optimisées par l’IA a été à l’avantage des attaquants » estime David Girard, Head of AI Security & Alliances chez Trend Micro. D’autres, comme David Grout, CTO EMEA de Google Cloud Security, tempèrent en affirmant que « sur les douze derniers mois, l’avantage est à la défense, car de nombreuses innovations sur tous les fronts ont permis d’améliorer les processus de détection et la vitesse de réaction. L’IA a permis aux défenseurs de combler une partie de leur retard. »

Les règles du jeu évoluent parce que l’armement change. Comme l’explique Emanuela Zaccone, AI and Cybersecurity Product Strategist chez Sysdig, « la course à l’armement cyber entre les attaquants et les défenseurs ne porte pas tant sur la question de savoir qui tire le plus profit de l’IA, mais plutôt sur celle de savoir qui l’utilise le plus efficacement. »

Elle alerte néanmoins sur la nouvelle asymétrie engendrée par l’IA qui s’ajoute à celle préexistante : contrairement aux cyber défenseurs, « les cyberattaquants ne sont soumis à aucune restriction, aucune directive éthique et aucune exigence de conformité. »

IA Générative : un changement d’échelle, de vitesse et de réalisme

L’IA générative ne crée pas tant de nouvelles catégories d’attaques qu’elle ne perfectionne et n’industrialise les vecteurs existants à un niveau alarmant : elle a fondamentalement altéré la nature, l’échelle et la vitesse des cybermenaces. En pratique, la bascule se manifeste par trois ruptures majeures :

Hyper-personnalisation et ingénierie sociale à l’échelle industrielle

« Le véritable bouleversement réside dans le réalisme des attaques à grande échelle », avertit Adrien Porcheron, DG France de Cato Networks, pour qui cette sophistication rend « indispensable une inspection IA-native […] afin de détecter non pas seulement ce qui est dit, mais l’intention et le contexte ». Les attaques d’ingénierie sociale, autrefois artisanales et coûteuses en temps, sont désormais produites en masse. Les LLM rédigent des courriels crédibles, contextuellement pertinents et grammaticalement parfaits, s’adaptant au style d’une entreprise ou aux intérêts d’une cible. « L’ingénierie sociale devient presque indiscernable d’une interaction authentique » alerte Adrien Porcheron.

Samy Reguieg, GM France et Afrique d’Acronis, cite un exemple parlant : « notre Threat research Unit a détecté une campagne où des attaquants ont utilisé la GenAI pour créer des emails de phishing hyper-personnalisés via LinkedIn : un directeur financier reçoit un email mentionnant un projet interne réel, des surnoms d’équipe, et reproduisant parfaitement le style d’entreprise. L’IA élimine les signaux d’alerte habituels (grammaire, localisation, urgence). L’attaque a contourné trois vérifications humaines avant détection par analyse comportementale. »

Richard de la Torre

Technical Product Marketing Manager, Enterprise Solutions chez Bitdefender

« Des tâches auparavant manuelles et chronophages, telles que la collecte de données, la reconnaissance et l’exploration de réseaux à la recherche de vulnérabilités exploitables, sont désormais effectuées par des systèmes d’IA générative. Il en résulte une augmentation massive du volume d’attaques (+126 % en glissement annuel). »

Dans le même temps, la barrière à l’entrée s’est effondrée. « La baisse du niveau de compétence requis pour les attaquants » est, pour David Girard, le changement le plus fondamental engendrée par l’IA générative. « Nos recherches révèlent que les auteurs de menaces n’ont plus autant besoin d’expertise underground pour mener des attaques convaincantes. ». Dans cette nouvelle ère, « le changement le plus fondamental est la réduction spectaculaire des obstacles techniques pour les cybercriminels » abonde Jérôme Warot, AVP Solution Engineering chez Tanium. « C’est la démocratisation des capacités d’attaque avancées qui change la donne, et pas seulement la vitesse ou le volume. »

Autre révolution, la menace va désormais bien au-delà du texte : les deepfakes audio et vidéo servent à des usurpations d’identité d’un réalisme troublant, comme l’illustre l’exemple d’un employé de Hong Kong ayant transféré 25 millions de dollars sur ordre d’un « directeur financier » entièrement généré par IA. « Selon une dernière étude, les attaques par Deepfakes ont augmenté de 1740% en Amérique du Nord et nos clients MSP signalent que 25 % des attaques sur les applications de collaboration impliquent désormais des deepfakes générés par intelligence artificielle » expliqueSamy Reguieg.

Aziz Si Mohammed

Senior Manager, Solutions Engineering chez Okta France

« Certaines analyses font état d’une augmentation de 1 300 % des fraudes deepfake en un an. Cette menace n’est plus marginale : elle est désormais devenue un vecteur d’attaque courant et coûteux, contre lequel les entreprises doivent se prémunir en formant leurs équipes, en renforçant leurs contrôles et en utilisant des solutions d’authentification plus robustes ».

Malware polymorphe : l’adversaire Invisible et en constante mutation

Les malwares polymorphes, ces logiciels malveillants qui modifient leur propre code à chaque exécution pour déjouer les détections, ne sont pas nouveaux mais l’IA les a fait changer d’échelle. « 70 % des compromissions d’entreprise en 2025 ont impliqué des malwares polymorphe » affirme Richard de la Torre, Technical Product Manager chez Bitdefender. La seule manière de détecter ces menaces est de concentrer la détection sur leur comportement : privilégier l’observation de « ce que fait » l’attaque plutôt que « ce qu’elle est », imposant un pivot vers des plateformes de détection et réponse dotées d’analyses comportementales avancées.

Mais les détections comportementales d’aujourd’hui vont devoir se réinventer. La découverte récente du malware Promptlock l’illustre crûment : ce rançongiciel expérimental s’appuie sur un LLM local (le modèle open source gpt-oss-20b d’OpenAI via Ollama) pour générer à la volée des scripts Lua malveillants et multiplateformes (Windows, Linux, macOS). Cette technique introduit une part de non-déterminisme qui complique d’autant les détections heuristiques classiques. Promptlock est la preuve que des outils IA rendent économiquement viable une polymorphie de plus en plus « comportementale » (et non uniquement une polymorphie du code généré).

Samy Reguieg

General Manager France et Afrique chez Acronis

« La révolution à craindre dans les prochains mois, c’est la ‘persistance autonome’, bien plus que la vitesse ou le réalisme des attaques. Selon Acronis TRU, dès 2026, des attaques par IA seront capables de maintenir leur présence pendant des semaines en s’adaptant en temps réel aux défenses et aux contextes. Ces malwares analyseront vos SOC et ajusteront leur comportement pour rester indétectables, sans communication avec leur centre de contrôle – de vrais agents malveillants et autonomes au cœur de vos réseaux. »

Agentisation : la vitesse machine contre le temps humain

Déjà en cours de développement, la prochaine génération de menaces reposera sur l’IA agentique. Il s’agit de systèmes autonomes capables de planifier et d’exécuter des chaînes d’attaque complexes (kill chains) avec une intervention humaine minimale, voire nulle. Cette autonomie compresse les cycles d’attaque – de jours ou d’heures à quelques minutes – et crée un décalage de vitesse insurmontable pour les équipes de sécurité humaines.

Les avis divergent sur l’imminence de cette menace : certains la jugent encore futuriste ou peu fiable pour les criminels, tandis que d’autres affirment qu’elle est déjà opérationnelle. Pour Aziz Si Mohammed, Senior Manager, Solutions Engineering chez Okta France, « il ne s’agit plus d’un scénario de science-fiction, mais bien d’une réalité émergente. Des cas récents ont montré que des cybercriminels utilisaient déjà des IA avancées comme Claude (Anthropic) pour automatiser des étapes entières d’attaques : collecte d’informations, intrusions, rédaction de messages d’ingénierie sociale ou encore exigences de rançon. Ces attaques agentiques, menées à la vitesse de la machine, dépassent largement les capacités de réaction humaines. ».

Adrien Porcheron observe déjà « des chaînes d’agents IA collaborant entre eux pour tenter des exfiltrations de données autonomes ».

L’IA agentique malveillante est déjà une réalité pour Samy Reguieg simplement, « elle n’est pas de style cataclysme hollywoodien. Nous avons documenté une attaque passée de la compromission initiale à la préparation des données en 7 minutes – un mouvement latéral entièrement autonome qui ajustait ses tactiques selon les réponses défensives ».

Des avis nuancés par Richard de la Torre qui explique qu’« à ce stade, les attaques agentiques relèvent davantage de la fiction que d’une réalité imminente. Il est difficile d’imaginer des groupes cybercriminels sérieux se mettre en danger en autorisant des systèmes sujets aux hallucinations à automatiser totalement le cycle de vie d’une cyberattaque. Ils trouvent davantage de valeur dans les LLM pour manipuler des humains via des attaques d’ingénierie sociale plutôt que pour développer des malwares ‘agentiques’ ».

Pour Lucas Guigliona,EMEA Lead Customer Success Management de Filigran, « nous sommes dans une phase d’entre-deux. Il n’y a pas encore le niveau de maturité nécessaire côté IA, mais ce n’est déjà plus de la science-fiction ».

Lucas Guiglionia

EMEA Lead Customer Success Management, Filigran

« Pour l’instant, l’IA a surtout avantagé les attaquants en vitesse et en volume. Mais à terme, avec des outils blue team éprouvés et performants, l’avantage pourrait s’équilibrer. Néanmoins, la défense est vouée à toujours courir pour rattraper l’avance des attaquants. »

Pascal Le Digol, directeur France de WatchGuard Technologies, précise que ces attaques agentiques « structurées par LLM avec exploitation des techniques du MITRE et génération de code font partie de la « réserve technologique » des pirates pour « plus tard », « plus tard » étant quand les pirates en auront besoin pour maintenir un rendement minimum. Les entreprises y seront confrontées dans le futur et elles n’y sont pas du tout prêtes en termes de technologie de défense et temps de réaction. En bref, ça arrivera et ça va faire mal… »

En clair, la GenAI a changé l’économie de l’attaque : on passe du coup par coup artisanal à une production continue où l’itération (tester, mesurer, relancer) ne coûte presque rien. En quelques minutes, un même leurre se décline par persona, canal et langue, pendant que le réalisme multimodal (texte, voix, vidéo) rapproche dangereusement l’illusion du “vrai” et raccourcit le premier kilomètre de la fraude (faire cliquer, installer, payer). Elle désintermédie la compétence : là où il fallait une équipe, un individu orchestre désormais une campagne complète. Cette dynamique alimente un marché structuré de Crimeware-AI-as-a-Service (WormGPT, FraudGPT et consorts) qui packagent tout à la demande : modèles d’e-mails, playbooks prêts à l’emploi, bibliothèques de prompts, générateurs/obfuscateurs de code. Résultat : plus de volume, plus de réalisme, et des contrôles de premier niveau sous pression permanente.

La riposte : le SOC augmenté

Face à cette escalade fulgurante, une course à l’armement s’est engagée : la seule réponse efficace à l’IA offensive est une IA défensive plus rapide, plus intelligente et mieux intégrée. La riposte s’organise autour d’un triptyque : plateformes AI-native, copilotes SOC et automatisation de bout en bout.

Adrien Merveille

Directeur Technique France de Check Point Software

« Le principal défi pour faire collaborer efficacement l’intelligence critique d’un humain et la puissance d’analyse d’une IA ? Les 3 P, Product, Process et People ! Cette règle des 3 P s’appliquent parfaitement à l’IA. L’IA est un outil qui accélère ou améliore un certain nombre de choses, mais il faut que cet outil soit performant et que son utilisation soit maitrisée. »

Des XDR/SIEM de nouvelle génération

Capables d’ingérer et de corréler en temps réel des téraoctets de données provenant de sources multiples – terminaux (endpoints), charges de travail cloud, réseaux, identités, messagerie – ces plateformes modernes, intégrant nativement l’IA, offrent une vue unifiée et contextuelle de la posture de sécurité, rassemblant en secondes ce que l’humain trierait en heures. Parallèlement, l’IA excelle à faire émerger du signal utile dans le brouhaha massif de données de logs, à contextualiser et à hiérarchiser. Or les centres d’opérations de sécurité (SOC) sont inondés d’alertes, dont beaucoup sont des faux positifs, ce qui épuise les analystes et laisse passer des menaces. En réduisant drastiquement ces faux positifs et en priorisant les alertes selon leur criticité, l’IA améliore le retour sur investissement des outils de sécurité et l’efficacité des équipes.

Parallèlement, l’IA intégrée à de tels outils peut également agir et lancer des remédiations automatisées. Mais pour l’instant « cette automatisation est pertinente lorsqu’il s’agit de flux de travail répétitifs et à faible risque. En revanche, pour des actions à forte criticité, comme la désactivation de comptes utilisateurs ou l’arrêt brutal de processus métier, l’intervention humaine reste indispensable » tempère Adrien Porcheron.

« L’IA est la plus utile lorsqu’elle accélère la détection d’anomalies, la recherche de menaces et la récupération guidée, ajoute Rodolphe Barnault, VP Europe du Sud de Rubrik. Les décisions ayant un impact direct sur les environnements de production, les données sensibles ou les systèmes d’identité doivent rester supervisées par des humains ».

Adrien Porcheron

Directeur France de Cato Networks

« À condition de l’intégrer au cœur de leurs défenses, les organisations peuvent reprendre l’avantage avec l’IA. L’intelligence artificielle permet aux défenseurs de repérer des schémas invisibles à l’œil humain, de corréler en temps réel des milliards d’événements et de neutraliser des menaces émergentes. La clé est d’en faire un levier structurel de la cybersécurité et non un outil additionnel. »

Une façon de rappeler que même à l’ère de l’IA, l’outillage ne suffit pas. « Il n’y a pas d’outils miracle ni de solution unique. Il faut penser à la transformation des opérations de sécurité et, pour cela, les équipes de sécurité doivent disposer des outils capables de soutenir cette transformation (automatisation, Threat Intelligence, IA, détection, etc.). Mais il faut également – et surtout – penser à la transformation de l’organisation et des processus RH qui soutiennent ces nouvelles approches » alerte David Grout.

De la détection à l’anticipation : le renseignement prédictif

Au-delà de la détection, la défense s’oriente vers l’anticipation grâce au Predictive Threat Intelligence. C’est même pour Lucas Guiglionia le pilier sur lequel tout RSSI devrait miser dans la préparation de son budget 2026 parce qu’« elle indiquera quoi anticiper comme menaces ». Cette discipline mobilise IA et Machine Learning pour analyser tendances d’attaque, TTP des acteurs malveillants et vulnérabilités émergentes, afin de prévoir où et comment la prochaine attaque est susceptible de se produire. Les équipes renforcent ainsi les défenses proactivement, corrigent les bonnes vulnérabilités et ajustent les contrôles avant l’exploitation. La sécurité passe de réactive à anticipative : on surveille l’orage, pas seulement la pluie. « Les renseignements et l’anticipation, que ce soit dans une guerre traditionnelle/cinétique ou cyber, ont toujours été les clés » rappelle Luca Guigliona.

David Girard

Head of AI Security & Alliances de Trend Micro

« Selon nos données, une bascule s’opère : plus de 7 entreprises sur 10 (77 %) utilisent déjà des outils pilotés par l’IA pour se protéger et près de 2 sur 10 explorent activement la mise en œuvre de ces outils. Parmi celles ayant recours à l’IA, 1 sur 2 (49 %) y font appel pour la gestion des processus de routine comme l’identification automatisée d’actifs, la hiérarchisation des risques ou encore la détection d’anomalies. Le défi réside dans la capacité à faire confiance aux recommandations de l’IA tout en maintenant l’expertise humaine pour les décisions critiques. »

Des copilotes pour analystes

Résumer un incident en langue naturelle, suggérer des requêtes et des investigations, produire des IOC, rédiger un plan de remédiation, générer un playbook SOAR… Des assistants comme Microsoft Security Copilot ou Google Security AI Workbench automatisent les tâches répétitives et à faible valeur ajoutée, libérant les experts pour les investigations complexes, la chasse aux menaces et la décision stratégique. Petit à petit, toutes les solutions de cybersécurité se dotent de tels copilotes pour permettre aux équipes de dialoguer avec la donnée et les ménages. La collaboration Homme-IA devient une compétence clé des experts du SOC : l’IA excelle sur l’analyse à grande échelle et la reconnaissance de schémas à vitesse machine ; l’humain garde l’avantage en pensée critique, intuition, compréhension du contexte métier et arbitrage face à l’inédit. « L’avenir ne se situe pas dans une défense 100 % autonome, mais dans un modèle hybride où l’IA agit comme copilote auprès des analystes SOC. Cette combinaison garantit une réponse rapide tout en préservant le discernement humain nécessaire dans les décisions à fort impact » insiste Adrien Porcheron. La performance d’un SOC moderne dépendra de sa capacité à faire collaborer efficacement ces deux formes d’intelligence.

Emanuela Zaccone

AI and Cybersecurity Product Strategist chez Sysdig

« Dans les 12 mois à venir, l’IA cessera d’être une « fonctionnalité » pour devenir une interface de sécurité à part entière. D’ici un an, je pense que les équipes de sécurité commenceront à interagir avec leurs plateformes principalement par le biais d’assistants IA, en posant des questions, en analysant les données d’exécution et même en déclenchant des mesures correctives à l’aide du langage naturel (NLP). Si cela est fait correctement, cela réduira la complexité et redéfinira l’efficacité avec laquelle nous travaillons »

Sécuriser l’IA : nouveau front de la cyberdéfense

Alors que la course à l’armement entre IA offensive et défensive fait rage, un second front, tout aussi critique, s’est ouvert : la sécurisation des systèmes d’IA eux-mêmes. L’IA n’est plus seulement un outil de défense ou d’attaque, elle devient une nouvelle surface d’attaque au sein de l’entreprise !

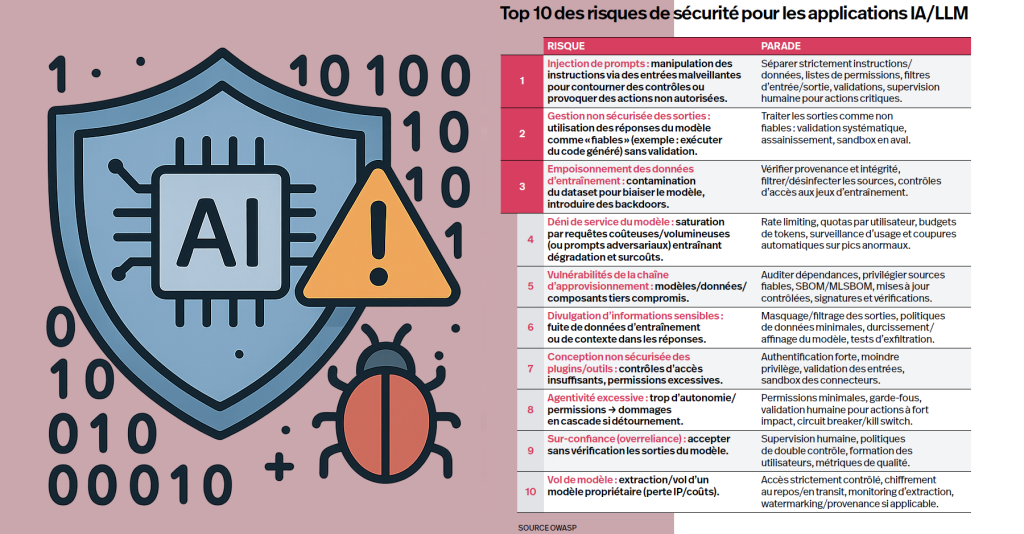

Conscient de ce péril, l’OWASP (Open Worldwide Application Security Project), référence mondiale en sécurité applicative, a publié un Top 10 spécifiquement dédié aux risques des applications LLM. Ces risques ne sont pas théoriques : ils ont déjà été exploités dans des scénarios réels, soulignant l’urgence de développer une discipline de sécurité dédiée.

Au-delà de ces risques techniques, « le danger le plus largement sous-estimé est celui du shadow AI » constate Adrien Porcheron. « Face à cela, la première étape de toute stratégie de sécurité IA doit être la découverte et la surveillance de l’ensemble des usages, qu’ils soient officiels ou non. Sans inventaire exhaustif, il est impossible de bâtir des politiques de protection cohérentes ni d’évaluer le périmètre réel des risques. »

« Le risque le plus sous-estimé pour les entreprises qui déploient des applications basées sur l’IA n’est pas la sécurité des applications elles-mêmes, mais la vulnérabilité des modèles de données fondamentaux de l’IA face à la manipulation » estime Bernard Montel, EMEA Technical Director and Security Strategist de Tenable. « Un adversaire peut mener une attaque de type data poisoning, corrompant les données d’entraînement afin de créer des angles morts ou d’amener un système défensif à agir à l’encontre de son objectif. Ce risque de niveau “méta” pourrait provoquer une défaillance catastrophique du système de sécurité de l’intérieur, un scénario plus dangereux qu’une simple compromission. »

Bernard Montel

EMEA Technical Director and Security Strategist, Tenable

« Le prochain échec majeur en cybersécurité ne sera pas causé par une compromission du réseau d’une entreprise, mais par une attaque de type data poisoning corrompant le modèle de données fondamental de l’IA. En nourrissant intentionnellement l’IA avec des informations malveillantes, les attaquants créeront des angles morts, par exemple dans un système de sécurité, entraînant l’IA à échouer et laissant l’organisation vulnérable face à ses propres défenses. »

Pour contrer ces menaces spécifiques, une discipline émerge : le MLSecOps (Machine Learning Security Operations). À l’instar du DevSecOps qui a intégré la sécurité dans le cycle de vie du logiciel, le MLSecOps vise à intégrer la sécurité tout au long du cycle de vie du Machine Learning, de la collecte des données au déploiement et à la surveillance continue du modèle. Il étend les pratiques DevSecOps à des composants propres aux systèmes d’IA : jeux de données d’entraînement, modèles et pipelines d’inférence.

Partant du principe que les IA sont amenées à prendre de plus en plus de décisions autonomes à impact métier (approbation de crédit, diagnostic médical, maintenance prédictive, etc.), l’intégrité des modèles devient un enjeu critique qui conditionne l’intégrité des opérations.

Rodolphe Barnault

VP Europe du Sud de Rubrik

« Il faut garder à l’esprit que l’IA n’est pas infaillible et peut provoquer des erreurs entraînant des perturbations involontaires. D’où le lancement d’Agent Rewind, notre solution qui permet de revenir sur les actions menées par des agents autonomes, en offrant une visibilité sur leurs décisions et en rendant possible l’annulation des modifications apportées aux applications et aux données. »

Mais pour Emanuela Zaccone, il ne faut pas envisager « la sécurité de l’IA uniquement en termes de précision des modèles ou de données d’entraînement. Le véritable enjeu réside dans l’exécution : comment l’IA se comporte-t-elle lorsqu’elle interagit avec des personnes, des données et des systèmes ? Il est impossible de vérifier à l’avance chaque décision qu’elle prend. C’est pourquoi nous avons besoin d’un modèle d’exécution à privilèges minimaux pour l’IA, dans lequel chaque entrée est traitée par défaut comme non fiable et chaque sortie est conforme à la politique. Sans ce changement, les organisations risquent d’intégrer l’IA dans des processus critiques sans les contrôles nécessaires. »

La mise en place d’un cadre MLSecOps n’est pas une simple tâche pour l’équipe de sécurité : c’est une question de gouvernance d’entreprise qui requiert une collaboration transverse entre métiers, équipes data, IT et direction. Le RSSI doit en être le catalyseur, pour garantir que l’IA – nouveau moteur de la valeur – est déployée de façon fiable, éthique et sécurisée.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :