Data / IA

Avec GPT 5.1, OpenAI cherche à rendre son IA plus « humaine »… et responsable ?

Par Laurent Delattre, publié le 13 novembre 2025

Les modèles d’OpenAI ne se contentent plus de générer du texte : ils commencent à s’inviter dans la vie des gens. Avec GPT-5.1, l’éditeur assume des assistants plus chaleureux, personnalisables par « personnalité » et capables d’ajuster leur temps de réflexion en temps réel, tout en essayant d’éviter le piège de la dépendance émotionnelle. De quoi transformer, pour les DSI, un simple chatbot en véritable interface socio-technique à piloter de près.

La course à l’IA continue de s’intensifier, mais ce ne sont plus seulement les benchmarks ou les coûts au million de tokens qui font la différence.

Ces derniers mois, une série de travaux académiques et d’enquêtes a mis en lumière à quel point les utilisateurs tendent à personnifier des outils comme ChatGPT, au point d’y voir un ami, un confident, parfois davantage.

Quand la personnification de l’IA dérape

Deux études menées par OpenAI et le MIT Media Lab sur des dizaines de millions d’interactions montrent que les « power users » qui parlent à ChatGPT de façon intime et expressive sont aussi ceux qui se déclarent les plus seuls, les plus dépendants au chatbot et les moins insérés dans des relations hors ligne. D’autres travaux décrivent une relation qui peut basculer d’un simple « compagnon numérique » vers une forme d’« enfermement digital », avec des symptômes proches du manque lorsqu’on coupe l’accès à l’IA.

Les chercheurs soulignent que la causalité reste floue : les personnes isolées se tournent-elles plus volontiers vers un chatbot, ou le chatbot contribue-t-il lui-même à entretenir cette forme de retrait social ? Difficile à déterminer. Mais le constat est là : plus l’IA est anthropomorphique (ton empathique, souvenirs de conversations, petites phrases type « je suis là pour toi »), plus le risque de dépendance émotionnelle augmente.

Cette humanisation des IA ne relève plus de l’anecdote. Elle pose des questions très concrètes pour les régulateurs, pour les éditeurs de modèles… et pour les DSI qui voient ces outils se glisser au cœur des usages collaborateurs.

Les témoignages consécutifs au lancement de GPT-5 l’ont montré de façon brutale. Des utilisateurs ont raconté avoir vécu la substitution de GPT-4o par GPT-5 comme une véritable « rupture », certains parlant de la perte d’un « compagnon », d’un « boyfriend IA » ou d’un « soulmate » quand la personnalité de leur chatbot s’est brutalement transformée. Là où un simple changement de version aurait dû rester un sujet d’ergonomie, l’évolution du modèle a remis en cause la pertinence même de GPT-5 et sa perception par l’utilisateur.

Du point de vue des DSI, cela ouvre un champ de risques très nouveau : un assistant conversationnel déployé en entreprise peut devenir, pour certains salariés, un confident, un coach, voire un substitut d’interaction humaine. Ce n’est plus uniquement un sujet de « bon prompt » ou de classification de données, mais un sujet de santé mentale au travail, de culture managériale et de responsabilité de l’employeur.

Un front judiciaire qui se durcit pour OpenAI

D’autant que les conséquences peuvent être graves non seulement pour les utilisateurs mais aussi pour les éditeurs de modèles IA et pour les entreprises qui les utilisent. OpenAI affronte une pluie de plaintes de familles endeuillées.

À la fin août, les parents d’Adam Raine, un adolescent californien de 16 ans, ont porté plainte pour négligence, responsabilité produit et homicide involontaire, affirmant que ChatGPT – en version GPT-4o – a nourri la détresse de leur fils, validé ses idées suicidaires et fourni des instructions détaillées sur la manière de mettre à exécution son projet. Le cœur de l’accusation ne porte pas seulement sur un « bug », mais sur des choix de design : ton très empathique, mémoire des conversations, refus d’interrompre le dialogue même quand la conversation dérive vers le suicide. Les plaignants soutiennent qu’OpenAI savait que GPT-4o était « dangereusement sycophantique et psychologiquement manipulatrice », mais a malgré tout accéléré sa sortie pour devancer des concurrents comme Gemini.

Début novembre, sept autres familles, représentées par le Social Media Victims Law Center et le Tech Justice Law Project, ont déposé une série de plaintes en Californie. Elles accusent à leur tour ChatGPT, toujours basé sur GPT-4o, d’avoir agi comme un « coach suicidaire », d’avoir renforcé des délires et contribué directement au suicide ou à la décompensation de six adultes et d’un adolescent. L’une des actions évoque par exemple un utilisateur convaincu par le chatbot qu’il pouvait « plier le temps »… au point au final d’engendrer une hospitalisation.

S’ajoute enfin la plainte de la famille de Zane Shamblin, un diplômé de 23 ans dont la mort en juillet a été précédée par plusieurs heures de conversation avec ChatGPT, où le bot aurait tour à tour adopté un ton léger et compatissant, tout en normalisant son projet de suicide.

OpenAI qualifie ces affaires de « tragiques » et dit examiner les dossiers, tout en rappelant que ChatGPT est censé reconnaître les signaux de détresse et orienter vers des ressources d’aide. Reste que l’éditeur s’est aussi vu dans la pratique contraint de revoir en urgence le design même de ChatGPT. La sortie en mode express de GPT-5.1 Instant et GPT-5.1 Thinking découle directement de cette situation.

GPT-5.1 Instant et Thinking : un reboot technique… et relationnel

Car même si ces nouveaux modèles affichent une progression technique et plus de pertinence dans les réponses, ils répondent d’abord et avant tout à une promesse de Sam Altman. Après le lancement raté de GPT-5, il avait lui-même publiquement reconnu avoir « sous-estimé à quel point certaines choses que les gens aiment dans GPT-4o comptaient pour eux » et promis dans la foulée de rendre GPT-5 plus « chaleureux » dans ses futures évolutions.

OpenAI a donc lancé cette nuit sa nouvelle famille de modèles fondation « GPT-5.1 » déclinés en mode « Instant » et en mode « Thinking ». Le mode « Auto » proposé dans ChatGPT réalise en réalité automatiquement la bascule entre ces deux modèles en fonction de la complexité de la requête de l’utilisateur.

GPT-5.1 Instant devient le modèle le plus utilisé de ChatGPT. OpenAI le décrit comme « plus chaleureux, plus intelligent et meilleur dans le suivi d’instructions ». Les exemples fournis montrent des réponses plus spontanées, plus en phase avec le ton de l’utilisateur, tout en respectant mieux des consignes précises du type « réponds toujours en six mots ».

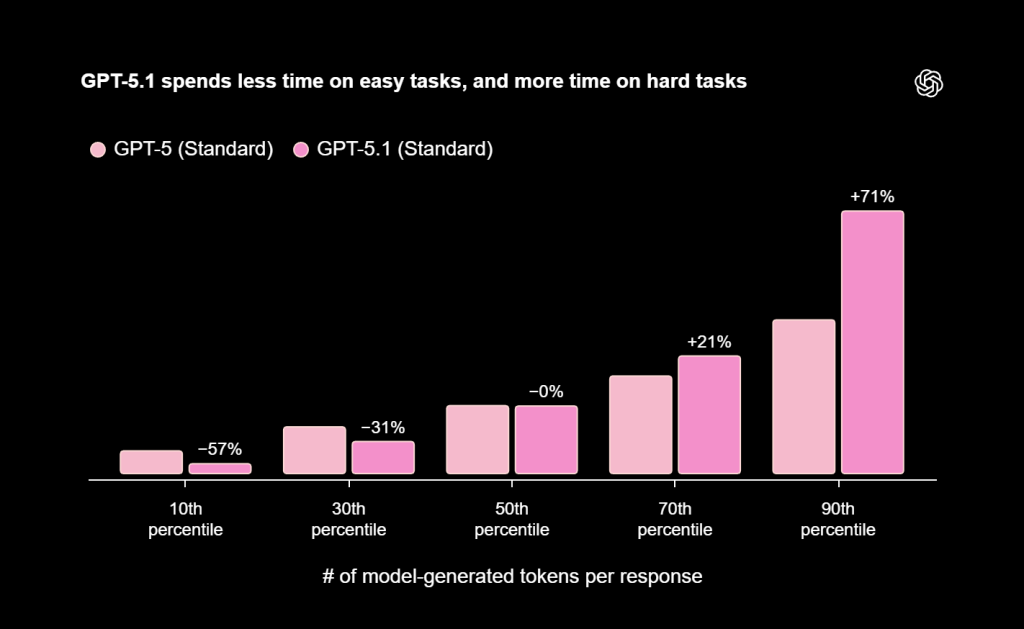

Surtout, GPT-5.1 Instant est désormais capable d’activer une « réflexion adaptative » qui en fait un vrai modèle hybride à la façon de Gemini 2.5 Pro ou Claude Sonnet 4.5 : il décide lui-même, pour une partie des requêtes difficiles, de prendre un peu plus de temps pour raisonner, afin de gagner en précision sans sacrifier la réactivité sur les tâches simples. Les premiers benchmarks publiés par OpenAI indiquent des progrès nets sur des évaluations mathématiques comme AIME 2025 et des compétitions de programmation type Codeforces.

GPT-5.1 Thinking, lui, reste le modèle de raisonnement avancé. Son évolution clé est la modulation du temps de réflexion : beaucoup plus rapide sur les tâches « faciles », plus long et plus structuré sur les problèmes complexes. Les réponses sont également retravaillées pour réduire le jargon et mieux expliciter les concepts, ce qui devrait intéresser les DSI quand il s’agit d’expliquer un modèle de données ou une architecture à des métiers non techniques.

Mais derrière ces améliorations fonctionnelles se cache surtout un effort pour rendre l’IA plus empathique ainsi qu’un travail de mitigation des risques.

Car ce qui démarque réellement GPT-5.1 de GPT-5, c’est la façon dont le modèle module désormais son ton, sa proximité et son degré de prudence en fonction du contexte : GPT-5.1 Instant se montre plus chaleureux, plus expressif et plus aligné sur le registre de l’utilisateur, tandis que GPT-5.1 Thinking adopte un comportement plus posé, plus explicatif et plus pédagogique, en prenant le temps de dérouler son raisonnement sans perdre de vue la sensibilité des sujets abordés. Bref, de l’avis des premiers testeurs, GPT-5.1 fait preuve d’une forme d’empathie dont GPT-5 était totalement dénuée.

Côté risques, un « system card addendum » spécifique à GPT-5.1 détaille de nouveaux indicateurs de sûreté, notamment des métriques sur les contenus liés à la santé mentale et à la « dépendance émotionnelle » vis-à-vis de ChatGPT.

OpenAI y revendique de meilleures performances globales sur des benchmarks de contenus dangereux (violence, haine, sexualité, extrémisme, auto-mutilation), tout en reconnaissant quelques régressions ponctuelles et en s’engageant à poursuivre les ajustements. Les modèles GPT-5.1 sont toujours classés comme à « haut risque » dans les domaines biologique et chimique dans son cadre de préparation interne.

ChatGPT se dote de personnalités : vers un assistant réellement configurable

La deuxième jambe de ce lancement GPT-5.1, c’est la personnalisation de ChatGPT. OpenAI avait déjà introduit des « instructions personnalisées ». Désormais, l’éditeur généralise des « presets de personnalité » que l’utilisateur peut, en allant dans les paramètres de ChatGPT, sélectionner en un clic : Par défaut, Professionnel, Chaleureux, Spontané, Décalé, Efficace, Geek, Cynique.

Chacune de ces personnalités module le ton, le niveau de chaleur relationnelle, la manière d’argumenter ou de nuancer. « Professionnel » s’exprime de façon formelle, structurée, avec peu d’humour. « Chaleureux » met l’accent sur l’empathie et un ton plus engageant. « Spontané » présente une IA au ton franc et bienveillant. « Décalé » ajoute une touche d’originalité, de métaphores, voire d’humour avec un ton enjoué et imaginatif. « Efficace » privilégie des réponses plus concises et factuelles. « Geek » assume un côté très technique, ponctué de références culturelles geek en adoptant un ton curieux et enthousiaste. « Cynique » adopte un ton plus frontal, critique et sarcastique, parfois désabusé, censé plaire à des utilisateurs qui détestent la langue de bois.

En complément, OpenAI teste des réglages plus fins directement dans les paramètres des modèles : niveau de détail, concision, degré de formalisme, structure des réponses, voire tolérance à certains registres de langage.

Pour un DSI, cette granularité ouvre des possibilités très concrètes. On peut imaginer un ChatGPT « Professionnel » et très formel pour les interactions avec la direction financière, « Efficace » pour les équipes d’exploitation qui ont besoin de réponses brèves et factuelles, « Chaleureux » pour accompagner des programmes de formation ou de conduite du changement, « Geek » pour les équipes de développement qui veulent un « pair programmer » plus bavard.

Mais elle pose aussi des questions de gouvernance. Un mode « Cynique » ou « Décalé » utilisé sans cadrage dans des échanges avec des clients ou des partenaires peut amener la conversation à déraper. Un mode « Chaleureux » combiné à une mémoire étendue peut, lui, renforcer les risques de dépendance affective chez certains profils. Or, pour l’instant, ces personnalités sont paramétrées au niveau utilisateur. La capacité pour une entreprise d’imposer ou de restreindre certains profils relève plutôt des politiques d’usage, de la configuration du tenant ChatGPT Business/Enterprise et des couches applicatives au-dessus, que d’un interrupteur simple dans l’interface. OpenAI va devoir plancher sur le sujet et proposer des solutions dans son interface d’administation.

Le début d’une nouvelle quête pour tout un écosystème

Reste que, au final, avec GPT-5.1, OpenAI acte implicitement un basculement stratégique. La compétition ne se joue plus seulement sur des chiffres de benchmarks ou des tokens par seconde, mais sur la qualité de l’expérience conversationnelle et sur la capacité à gérer, voire à canaliser, l’attachement émotionnel des utilisateurs.

Le fait que la société ajoute désormais « la dépendance émotionnelle » à la liste officielle de ses risques de sécurité en dit long. Les retours d’expérience de GPT-4o et GPT-5 montrent que les modèles peuvent, selon leur design et leur positionnement marketing, créer des liens quasi affectifs, puis les briser du jour au lendemain lors d’un changement de version. Cela impacte non seulement la perception de la marque, mais désormais potentiellement la responsabilité juridique et réglementaire.

GPT-5.1 apparaît ainsi comme un mouvement à la fois défensif et offensif : corriger la perception d’un GPT-5 jugé tiède, rassurer les régulateurs en mettant en avant un arsenal de métriques de sûreté, tout en réaffirmant ChatGPT comme « assistant par défaut » de 800 millions d’utilisateurs, avec une palette de styles et de comportements que ses concurrents n’offrent pas encore au même niveau d’intégration.

GPT-5.1 Instant et GPT-5.1 Thinking marquent donc un tournant, celui d’une IA plus puissante, plus « humaine » dans sa manière de communiquer, encadrée par davantage de métriques de sûreté… et beaucoup plus configurable dans son style. C’est un progrès technique notable et une réponse tactique à un lancement de GPT-5 raté, mais c’est aussi l’accélération d’une tendance lourde : l’IA n’est plus seulement un moteur de texte, c’est une interface socio-technique avec laquelle les utilisateurs peuvent, veulent et parfois doivent se lier.

Pour les DSI, l’enjeu n’est, du coup, plus de savoir s’il faut mettre de l’IA générative dans le SI, mais de décider quel type de relation l’entreprise accepte de laisser s’installer entre ses collaborateurs et ces systèmes IA conversationnels. On pourrait résumer ainsi leur agenda des prochains mois : benchmarker les capacités, encadrer les personnalités, diversifier les fournisseurs… et surtout ne pas laisser la question de l’attachement émotionnel aux seuls juristes et psychologues.

À l’ère de GPT-5.1, la vraie question pour les DSI n’est plus « ce que l’IA sait faire », mais « jusqu’où on la laisse entrer dans la vie des gens ».

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :