Newtech

Gartner dévoile les 12 technologies émergentes qui vont révolutionner les systèmes d’entreprise

Par Laurent Delattre, publié le 14 mai 2025

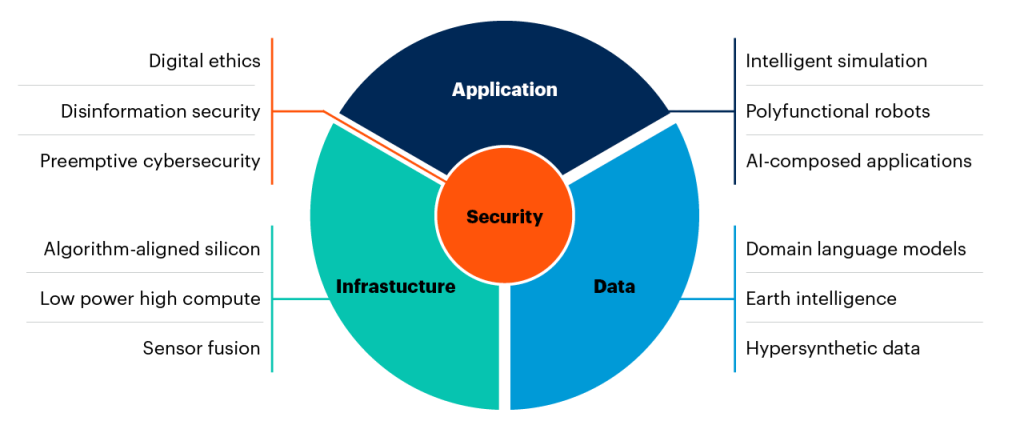

L’IA générative, la sécurité contre la désinformation et l’intelligence terrestre figurent parmi les 12 technologies disruptives mises en avant par le Gartner qui vont dans les années à venir redéfinir le Business et impacter les systèmes d’information des entreprises.

Toujours en mouvement est l’avenir… Dans sa dernière analyse, Gartner appelle les DSI à « agir sans tarder pour décrocher l’avantage du pionnier » et dévoile les 12 « early‑stage disruptors », 12 innovations disruptives naissantes repérées cette année qui devraient passer du prototype au marché de masse en moins de cinq ans. Selon le célèbre cabinet d’analyse, ces innovations représentent des opportunités compétitives à court terme parce qu’elles deviendront à n’en pas douter des leviers incontournables dans les années à venir.

Parmi elles, trois locomotives se détachent — l’architecture de code pilotée par GenAI, la sécurité contre la désinformation et la Earth intelligence — mais l’ensemble forme un écosystème où les progrès de l’IA servent sans surprise de catalyseur transversal.

Ces 12 innovations sont réparties selon 4 grands axes d’évolution des systèmes d’information : les applications, les données, l’infrastructure et la cybersécurité. Décryptage…

Applications : simulation, robotisation et code autonome

Les applications sont le moteur de notre univers numérique et au cœur de la transformation numérique. Mais avec l’IA leur rôle et leur forme changent. Satya Nadella expliquait récemment que les « Agents IA » étaient les « Apps » de l’ère de l’IA. Et les applications de demain seront invisibles et intelligentes, dotées de capacités modulaires invoquées en langage naturel, pilotées par des agents autonomes, nourries de données temps réel et sécurisées par design.

Tendance 1 – Intelligent simulation (la simulation intelligente)

Imaginez tester un plan de relance logistique ou un scénario financier dans un environnement virtuel indestructible mais incroyablement fidèle à la réalité. Les jumeaux numériques dopés à l’IA promettent une prise de décision instantanée et sans risque, transformant les DSI en salles de pilotage ou virtuelles. Des jumeaux intelligents virtuels notamment capables de tester en temps réel impacts financiers, climatiques ou supply‑chain. Gartner prévoit qu’à l’horizon 2032, plus de 25 % des décisions stratégiques reposeront sur ces simulations intelligentes

Une tendance portée par des acteurs comme le français « Cosmo Tech », AnyLogic, SimScale, Nvidia (et son Omniverse) et bien sûr Dassault Systèmes.

Tendance 2 – Polyfunctional robots (les robots polyfonctionnels)

Contrairement aux robots traditionnels, souvent conçus pour une seule fonction, un robot polyfonctionnel est une plateforme matérielle et logicielle capable d’exécuter plusieurs tâches différentes, souvent dans des environnements humains, et de s’adapter à de nouvelles missions sans nécessiter de reprogrammation complexe. Ces machines modulables, capables de passer d’une tâche à l’autre en quelques minutes, promettent de révolutionner l’industrie et le service.

Les robots humanoïdes en cours de développement chez Tesla (Optimus), Boston Dynamics (Atlas), Unitree (G1) et bien d’autres en sont une des branches. Mais d’autres branches existent, comme les robots d’automatisation de restaurants de Kaikaku, les robots industriels du français Agibot, les robots HandEffector et AeonDog d’Aeon Robotics, le Stretch de Boston Dynamics, le YuMi d’ABB, voire les systèmes agro-robotique de John Deere.

De la préparation de commandes à la maintenance, les machines polyfonctionnelles promettent de réécrire les règles de l’usine et de l’entrepôt… à condition d’adopter de nouveaux standards middleware et API pour en piloter la chorégraphie.

Tendance 3 : AI‑composed applications & GenAI-enabled code

Fini les développements qui s’étalent sur des mois : des agents intelligents génèrent code, interfaces et tests en quelques clics. Les plateformes low‑code deviennent des ateliers de prototypage instantané, permettant aux équipes métiers de créer elles‑mêmes leurs applications par simple dialogue avec leur ordinateur. Gartner prévoit que d’ici 2026, 30 % des nouvelles applications seront composées par l’IA.

Dit autrement, les « AI-Composed Apps » sont des applications conçues, assemblées et optimisées pour l’essentiel par l’intelligence artificielle, à l’aide de modèles génératifs (GenAI). Ces applications ne sont plus simplement codées manuellement par des développeurs, mais composées dynamiquement à partir de blocs fonctionnels, d’APIs, de modèles de données et d’interfaces, en fonction des besoins métier.

Dérivant de cette tendance, une autre se dessine : celle du « GenAI-enabled code ». Une tendance où l’IA devient l’interface. Cette technologie va révolutionner les applications d’entreprise en remplaçant les interfaces utilisateur séquentielles traditionnelles par des systèmes d’IA générative acceptant des entrées en langage naturel et multimédia (interfaces multimodales). « Pour rester compétitifs, les fournisseurs traditionnels de logiciels d’entreprise devront refactoriser leurs applications pour servir des solutions d’IA générative composables, invoquées à la demande via des prompts textuels et multimodaux » avertit Ray Valdes, VP Analyste chez Gartner. L’impact sera considérable : d’ici 2029, plus de 50% des interactions utilisateurs liées aux processus d’entreprise exploiteront des LLM ou SLM pour contourner la couche d’interface utilisateur dans les applications traditionnelles !

Ces tendances sont portées par des startups comme Cogram, Unqork, Glean, BuilderAI, Replit, Cursor mais aussi par des acteurs bien connus du Low-Code comme OutSystems, Salesforce (avec Einstein Copilot) et bien évidemment par Microsoft dont on comprend bien que l’avenir de Power Platform passe par l’IA.

Données : vers l’expertise fine et la météo mondiale du business

Il n’y a pas d’IA sans données et au final, pas de Business sans données. Longtemps considérées comme un simple carburant pour les tableaux de bord, les données se muent aujourd’hui en système nerveux de l’entreprise. De leur volume et leur vélocité naissent désormais deux exigences : la précision pour capter chaque nuance métier, et la confiance pour sécuriser chaque décision.

Demain, cette matière première deviendra encore plus vivante : contextualisée en temps réel, enrichie de connaissances expertes et répliquée de façon éthique pour explorer des scénarios à l’infini. L’enjeu n’est plus seulement de stocker ou de visualiser, mais d’orchestrer un écosystème d’informations capables d’anticiper les marchés avec la même acuité qu’un service météo anticipe les orages. Oubliez vos rapports mensuels, demain, vos dirigeants rechercheront une « météo du business » en continu, guidant leurs choix au rythme des cycles économiques et environnementaux.

Tendance 4 : Domain language models (des modèles spécialisés dans des domaines)

Les LLM n’auraient-ils donc aucun avenir en entreprise ? Ils sont déjà remplacés par des SLM qui permettent non seulement une exécution locale mais surtout une totale personnalisation aux données et besoins de l’entreprise. Mais ce n’est pas tout…

Des modèles de langage taillés sur mesure (juridique, médical, industriel), et appelés DLM (modèles linguistiques de domaine), offrent désormais des réponses et recommandations ultra‑précises, capables d’infuser l’expertise métier directement dans les process et d’accélérer la personnalisation de masse.

Gartner prévoit qu’en 2027, les entreprises utiliseront trois fois plus de petits modèles spécialisés que de LLMs généralistes et anticipe que 90 % de systèmes GenAI reposeront sur des DLMs plutôt que des LLM généralistes d’ici 2030.

Tendance 5 : Earth intelligence (L’intelligence terrestre)

Agriculture de précision, gestion durable des ressources, assurances paramétriques… Le croisement en temps réel de données géospatiales et climatiques crée un « dashboard » planétaire pour optimiser chaque décision, de la semence au sinistre.

Cette technologie utilise l’IA pour analyser des données satellitaires, aériennes et terrestres afin de surveiller les actifs et les activités de la Terre, fournissant des informations précieuses pour la prise de décision.

« Il ne s’agit pas simplement de cartes et de graphiques. L’intelligence terrestre fournit des données sur la production mondiale de nickel, les revenus des parcs d’attractions et la santé des cultures de blé, pour ne citer que quelques exemples » souligne Bill Ray, Distinguished VP Analyst chez Gartner.

Gartner prédit que d’ici 2028, 80% des principaux actifs de surface terrestre seront surveillés par des satellites actifs au niveau mondial. Initialement adoptée par le secteur de la défense, cette technologie s’étend désormais à tous les secteurs d’activité grâce à l’amélioration de la qualité des données et des techniques d’analyse.

Cette tendance se concrétise avec des acteurs comme Planet Labs, Descartes Labs, Orbital Insight, Satellogic et justifie l’intérêt de Microsoft avec son Azure Space et celui d’AWS avec Ground Station.

Tendance 6 : Hypersynthetic data (le donnée hyper-synthétique)

Quantifier, diversifier et protéger ses données n’a jamais été aussi facile : l’IA génère pour vous des jeux de données réalistes, conformes RGPD, sans jamais toucher aux informations sensibles. Les tests de vos algorithmes gagnent en robustesse dès la phase de conception.

Nous entrons dans l’ère des données générées artificiellement par des modèles avancés avec un niveau de réalisme, de diversité et de contextualisation bien supérieur à celui des données synthétiques traditionnelles.

Certains y voient l’avenir des grands modèles alors que l’humanité commence à manquer de données pour leur apprentissage (un comble).

Des acteurs comme Mostly AI, DataGen ou encore Synthetaic explore le potentiel de ces données hypersynthétiques.

Infrastructure : du silicium militaire à l’IA dans votre poche

Des salles blanches des hyperscalers aux capteurs glissés dans nos vêtements, l’infrastructure informatique vit une révolution silencieuse : elle se rapproche de l’usage tout en s’adaptant à chaque charge. Aujourd’hui, la performance se mesure encore en téraflops cloisonnés dans des centres de données géants. Demain, elle se réinventera en un continuum fluide où la logique décide d’elle‑même du lieu (cloud, edge ou appareil personnel) le plus efficace pour s’exécuter. Au cœur de cette transition : une électronique repensée pour l’IA, des architectures sobres capables d’embarquer des calculs autrefois réservés aux superordinateurs, et une prolifération de capteurs multipliant les regards sur le monde physique. L’infrastructure n’est plus un socle distant : elle devient une toile élastique, éco-énergétiquement optimisée et contextuelle…

Tendance 7 : Algorithm‑aligned silicon (des puces spécialisées)

Les puces généralistes ne disparaissent pas mais, pour concrétiser les objectifs d’efficience et de numérique responsable, de plus en plus de traitements seront réalisés par des puces conçues pour un algorithme précis.

On voit déjà cette tendance émerger avec l’arrivée des NPU aussi bien dans les PC que dans les clouds (Google TPU, Microsoft Maia-100, AWS Trainium & Inferentia). D’autres acteurs comme Graphcore, Cerebras, SambaNova, Tenstorrent développent des composants optimisés dès la conception pour exécuter des modèles d’IA spécifiques de manière plus efficace, rapide et économe en énergie.

Tendance 8 : Low power high compute (le calcul frugal)

C’est l’un des Graals de l’informatique moderne : fournir une puissance de calcul élevée tout en consommant très peu d’énergie.

L’explosion des besoins énergétiques provoquée par l’arrivée de l’IA générative a remis le thème au centre des débats. Il nous faut réduire l’empreinte carbone et énergétique de nos IA et d’une manière générale de nos infrastructures numériques.

Adoption de micro-architectures denses (avec des cœurs de plus en plus compacts et des finesses de gravures extrêmes), d’accélérateurs dédiés (comme les NPU), d’architectures chiplets et de packaging 3D, de centres de données « carbon-aware », de logiciels « power-aware »… Il va falloir combiner de nombreuses tendances pour concrétiser cette « tendance n°8 ». À terme, smartphones, objets connectés et wearables exécuteront vos algorithmes d’IA en local, réduisant drastiquement la latence et la facture datacenter.

Le « Low Power / High Compute » n’est pas un simple slogan marketing : c’est la convergence entre la pression écologique, le coût énergétique et la faim de calcul de l’IA.

Tendance 9 : Sensor fusion (la fusion des capteurs)

Vidéo, LiDAR, son, biométrie : la superposition de flux sensoriels délivre un contexte opérationnel sans équivalent. Sécurité industrielle, mobilité autonome, retail augmenté… Les données multi‑capteurs deviennent la colonne vertébrale d’applications adaptatives.

La tendance « fusion des capteurs » (Sensor Fusion) cherche à combiner de façon plus intelligente et plus utile les données des milliards de capteurs qui perçoivent notre monde sous toutes les coutures. Elle sera essentielle à l’AGI (L’IA générale) pour appréhender les contextes physiques et analogiques de nos environnements.

Sécurité : éthique, traçabilité et prévision des cybermenaces

La cybersécurité ne se limite plus à dresser des murailles et colmater des brèches. Elle devient le grand horloger qui rythme et garantit la confiance numérique. Sous la pression des régulateurs, des deepfakes et d’un périmètre informatique sans frontières, elle doit trouver les parades aux nouvelles menaces du monde numérique en s’appuyant sur des systèmes capables de s’expliquer, de signer chaque donnée à la source et de surveiller leur propre exposition en continu afin de préserver la réputation, la conformité et, in fine, la résilience des systèmes et des entreprises.

Tendance 10 : Digital ethics (Une nécessaire éthique numérique)

Il est temps de faire passer la gouvernance algorithmique de l’IA du discours à l’acte : chartes éthiques, audits automatisés et « explainability » s’insèrent d’emblée dans les pipelines CI/CD pour garantir transparence et équité.

Aujourd’hui, cela se traduit en pratique par des audits automatisés dans les chaînes CI/CD, des mécanismes d’explicabilité intégrés aux modèles et des chartes éthiques contractualisées avec les fournisseurs. Mais il faut aller encore plus loin.

Les organisations doivent bâtir un socle d’éthique numérique, un « système de valeurs régissant les interactions électroniques entre personnes, organisations et objets », un ensemble de valeurs de transparence, équité, responsabilité directement inscrit dans les outils qui conçoivent, valident et déploient les algorithmes et tout particulièrement les algorithmes IA.

Nous avons largement évoqué ce thème dans notre récent article : Est-il l’heure d’insuffler les Lois de la Robotique à nos IA ?

À LIRE AUSSI :

On voit naître des techniques de chiffrement homomorphe ou de fédération des données pour concilier conformité (AI Act, GDPR) et valeur métier.

Des plateformes de gouvernance d’IA commencent à émerger surveillant en continu robustesse, biais et conformité réglementaire : Selon Gartner, les organisations qui les adoptent devraient afficher, d’ici 2028, des scores de confiance client 30 % plus élevés que leurs concurrentes et une conformité 25 % supérieure.

Tendance 11 : Disinformation Security (la sécurité contre la désinformation)

Deepfakes de PDG, faux rapports ESG ou campagnes de bots : Gartner pousse les RSSI à ajouter un « socle d’authenticité » dans chaque produit.

La sécurité contre la désinformation est une discipline à part entière émergente qui se concentre sur les menaces provenant de l’extérieur du réseau contrôlé par l’entreprise. Elle vise à détecter, attribuer et neutraliser les contenus falsifiés — deepfakes, faux communiqués, usurpations de dirigeants — qui ciblent la réputation d’une marque ou manipulent ses clients. Elle englobe un ensemble de technologies comme la détection de deepfakes, la prévention d’usurpation d’identité et la protection de la réputation. « Les attaques de désinformation utilisent des infrastructures externes comme les médias sociaux et proviennent de zones avec une surveillance juridique limitée, » précise Alfredo Ramirez IV, Directeur Analyste Senior chez Gartner. « Les dirigeants technologiques doivent intégrer la ‘protection contre la désinformation’ dans leurs produits en utilisant l’IA et le ML pour la vérification du contenu et le suivi de la provenance des données. »

Selon Gartner, d’ici 2030, au moins la moitié des entreprises auront adopté des produits ou services pour lutter contre la désinformation, contre moins de 5% en 2024.

Des startups telles que Reality Defender ou SynthID (Google) intègrent des filigranes IA et des modèles de détection de média synthétique. D’autres jeunes pousses planchent sur des scanners automatiques qui certifient l’authenticité des contenus et tracent leur origine via la blockchain.

Tendance 12 : Preemptive cybersecurity (la sécurité préemptive)

Fini la réactivité : les systèmes s’auto‑surveillent et anticipent les attaques avant qu’elles ne surviennent. Il est grand temps de passer de l’ère du « Patch & Pray » (patcher et prier) à celle de l’anticipation continue.

Gartner promeut une sécurité préventive qui cartographie l’exposition en temps réel, valide les scénarios d’attaque avant qu’ils ne se produisent et neutralise l’infrastructure adverse dès sa mise en place. Les programmes de Continuous Threat Exposure Management (CTEM) illustrent ce basculement : les organisations qui y adossent leurs investissements verront les violations chuter des deux‑tiers d’ici 2026 selon une étude Ionix.

Gartner prévoit que l’adoption des solutions de défense préemptive passera de 5 % en 2024 à 35 % en 2028, et que 75 % des outils aujourd’hui centrés sur la détection intègreront des capacités préemptives dès 2030.

Au final, les 12 ruptures émergentes du Gartner en 2025 dessinent un futur où l’IA charpente les systèmes d’information et le business des organisations. Face à un tel panorama d’innovations vertigineuses, le rôle du DSI bascule : plus que jamais, il doit désormais se métamorphoser en stratège systémique chargé d’orchestrer la création de valeur, de confiance et de résilience. La prochaine décennie sacrera les DSI capables de faire converger innovation technologique, durabilité et souveraineté numérique. Gartner en est convaincu : celles et ceux qui sauront piloter ces douze ruptures comme un portefeuille cohérent façonneront l’avantage compétitif de leur organisation et renforceront durablement la confiance de leurs parties prenantes.

À LIRE AUSSI :

À LIRE AUSSI :