Data / IA

Des architectures pour simplifier les projets Deep Learning

Par Laurent Delattre, publié le 02 août 2018

Après Pure Storage, c’est au tour de NetApp d’annoncer une architecture de référence dédiée à l’intelligence artificielle et imaginée en partenariat avec NVidia. Le Deep Learning peut désormais se concrétiser simplement « On Premises ».

Le Deep Learning (au travers de réseaux de neurones le plus souvent convolutionnels) est sans conteste la technologie d’Intelligence artificielle qui focalise le plus d’attention depuis quelques années. D’importants progrès sont régulièrement réalisés sur la conception même des réseaux de neurones et sur les algorithmes qui sous-tendent les modèles IA notamment en matière de reconnaissance de la parole, de traduction automatique, de reconnaissance d’objets au sein d’images et vidéos, etc.

Mais le Deep Learning n’est pas uniquement au cœur des interactions homme-machine, il est aussi utilisé pour apprendre aux ordinateurs à jouer (cf. Pourquoi l’intelligence ludique d’OpenAI va servir l’IA d’entreprise), à détecter des failles de sécurité, à faire parler les données…

Car outre les réseaux et les algorithmes, le Deep Learning est aussi une histoire de « data ». Les phases d’apprentissage sont en effet autant voraces en puissance qu’en volumétrie. Mettre en œuvre une infrastructure cohérente pour répondre aux besoins du Deep Learning n’est pas chose aisée. Jusqu’ici, la plupart des entreprises se tournaient vers des services Cloud « clés en main » proposés par Azure, AWS, Google Cloud et d’autres. Mais, quelles que soient leurs raisons (confidentialité, optimisations, etc.), nombre d’entreprises cherchent aussi des solutions « On-Premises », simples à mettre en œuvre et à même d’accueillir leurs projets IA actuels et à venir.

Car outre les réseaux et les algorithmes, le Deep Learning est aussi une histoire de « data ». Les phases d’apprentissage sont en effet autant voraces en puissance qu’en volumétrie. Mettre en œuvre une infrastructure cohérente pour répondre aux besoins du Deep Learning n’est pas chose aisée. Jusqu’ici, la plupart des entreprises se tournaient vers des services Cloud « clés en main » proposés par Azure, AWS, Google Cloud et d’autres. Mais, quelles que soient leurs raisons (confidentialité, optimisations, etc.), nombre d’entreprises cherchent aussi des solutions « On-Premises », simples à mettre en œuvre et à même d’accueillir leurs projets IA actuels et à venir.

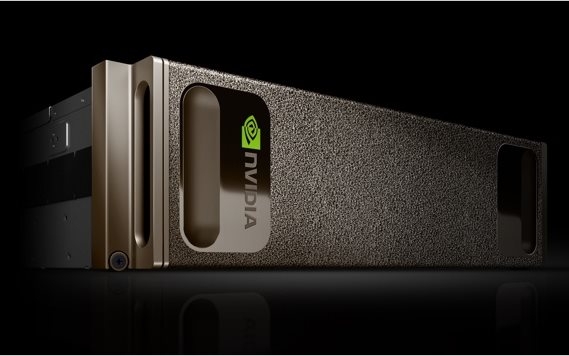

Quelques semaines après l’annonce par Pure Storage d’une architecture de référence IA – conçue en partenariat avec NVidia et dénommée AIRI -, c’est au tour de NetApp de répliquer en proposant là aussi sa propre architecture de référence (et non véritablement une solution clés en main) dédiée au Deep Learning : NetApp ONTAP AI.

Elle s’appuie sur des serveurs NVidia DGX-1 (jusqu’à 5 nœuds à base de GPU Tesla P100 soit 28672 cœurs CUDA et 170 TFLops par nœud) et une baie full flash NetApp AFF A800 (364 To, bande passante : 25 Go/sec, latence inférieure à 300 µsec), le tout relié par deux switches Cisco Nexus 100 Gbit Ethernet. La baie AFF A800 est conçue pour mise à l’échelle au travers d’un cluster 24 nœuds offrant 74,8 Po de stockage. Une configuration assez proche de l’AIRI de Pure Storage qui s’appuie également sur des serveurs (jusqu’à 4 nœuds) NVIDIA DGX-1 et deux switches 100 GbitE.

Au-delà des performances matérielles, la cohérence de l’ensemble est assurée par la Data Fabric de NetApp, une solution à la fois SaaS et On-Premises qui permet d’unifier les sources de données entre les différents clouds et fournit un accès optimal aux données quel que soit leur format et leur situation géographique. Cette Data Fabric crée un pipeline de données fluide et sécurisé, s’étendant du Edge à l’infrastructure interne et aux Clouds.

Cette Data Fabric est le gros différentiateur de la solution NetApp face aux autres architectures IA que NVidia essaye de monter autour de ses offres DGX-1 et DGX-2. Car, après NetApp et Pure Storage, NVidia cherche encore à étendre ses partenariats et s’imposer comme un acteur incontournable des infrastructures dédiées à l’IA. Il faut ainsi s’attendre à d’autres annonces similaires avec d’autres acteurs du monde du stockage dans les prochains mois…