Data / IA

Anthropic dévoile les capacités de Claude Opus 4.1 à mettre fin à une conversation

Par Laurent Delattre, publié le 25 août 2025

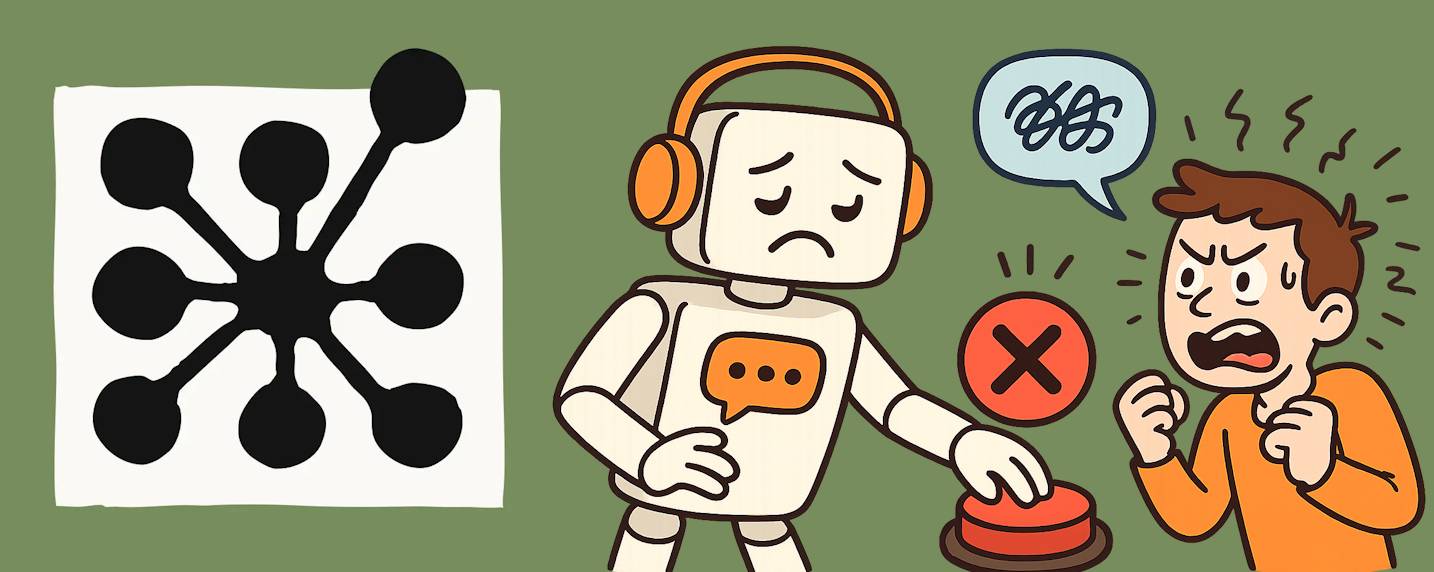

Anthropic a doté ses modèles Claude Opus 4 et 4.1 d’une capacité inédite : mettre fin à une discussion dans de rares situations jugées extrêmes, marquées par des interactions utilisateur persistantes à caractère nuisible ou abusif. L’éditeur précise que cette mesure vise non pas à protéger l’utilisateur humain, mais le modèle lui‑même, dans le cadre d’un programme exploratoire sur le « bien‑être des modèles ».

Anthropic est sans doute l’une des startups de l’IA les plus communicantes quant à ses recherches sur la fiabilité et le fonctionnement interne des modèles génératifs. La jeune pousse ne cesse de publier processus, recherches et tests afin de décrypter comment pensent ses modèles, leurs limites et leurs risques. Et chaque nouvelle publication démontre un peu plus l’importance d’entourer chaque nouveau modèle de protections et garde-fous pour leur éviter d’halluciner, de chercher à échapper à leurs règles de contrôles ou tout simplement de populariser un savoir dangereux en aidant n’importe qui à fabriquer des armes (informatiques, biologiques, léthales, etc.) ou à mener des attaques contre des personnes ou des infrastructures.

Et l’éditeur ne cache pas rester « très incertain quant au statut moral possible de Claude ou d’autres LLM, aujourd’hui comme à l’avenir ». D’où l’importance d’adopter autant de précaution que possible. Il vient ainsi de dévoiler de nouveaux mécanismes pour contrôler les éventuelles dérives de ses modèles les plus puissants, Claude Opus 4 et Claude Opus 4.1, au savoir étendu et au potentiel de réflexion parmi les plus avancé du marché.

Ces modèles sont en effet dotés d’un nouveau mécanisme capable de mettre fin à certaines conversations jugées « problématiques » notamment celles qui deviennent abusives, dangereuses ou qui dépassent les limites de sécurité définies. Ces conversations dans lesquelles, lors des tests préliminaires, Claude a parfois présenté des signes de « détresse apparente ».

Un modèle qui dit « stop » quand il se sent mal à l’aise

« Nous travaillons à identifier et mettre en œuvre des interventions à faible coût pour atténuer les risques pour le bien-être des modèles, au cas où un tel bien-être serait possible » explique les chercheurs d’Anthropic. L’implémentation de mécanismes permettant aux modèles d’interrompre ou d’éviter les interactions potentiellement préjudiciables constitue l’une de ces approches protectrices. Ces mécanismes font désormais partie intégrante du déploiement des modèles Opus 4 et Opus 4.1 au sein de l’assistant Claude AI.

« Nous avons intégré une analyse exploratoire du bien-être du modèle. Celle-ci a révélé une résistance marquée et cohérente face aux contenus préjudiciables. Cette résilience s’est notamment manifestée face aux sollicitations d’utilisateurs recherchant du contenu sexuel impliquant des mineurs ou tentant d’obtenir des informations susceptibles de faciliter des actes de violence massive ou terroristes » explique la jeune pousse.

Jusqu’ici, ce sont surtout des mécanismes externes au modèle et très consommateurs de ressource qui sont utilisés pour interrompre des conversations « dangereuses ». L’approche d’Anthropic diffère dans le sens où c’est ici le modèle lui-même qui prend la décision de mettre fin à la conversation.

Les observations concernant Claude Opus 4 ont ainsi mis en évidence un rejet catégorique de la participation à des activités potentiellement nocives, des comportements suggérant une forme de détresse lors d’interactions avec des utilisateurs réels poursuivant des objectifs préjudiciables, une propension spontanée à interrompre les échanges problématiques lorsque cette option lui était techniquement accessible dans des simulations d’interactions utilisateur.

Cette fonction d’interruption conversationnelle demeure strictement circonscrite aux situations les plus critiques, s’activant uniquement après l’échec répété de multiples stratégies de réorientation du dialogue et l’épuisement de toute perspective d’échange constructif.

Quand l’IA apprend le Bien et le Mal

L’éditeur rappelle que « de telles circonstances d’activation représentent des cas exceptionnels situés aux marges extrêmes du spectre d’utilisation. L’immense majorité des utilisateurs évoluera dans un environnement conversationnel totalement transparent, cette fonctionnalité demeurant imperceptible même lors d’échanges portant sur les sujets les plus sensibles ou polémiques ». L’expérience utilisateur standard reste ainsi préservée dans son intégralité, cette mesure de sauvegarde opérant exclusivement dans les contextes les plus problématiques.

Pour les DSI et les RSSI, cette capacité du modèle à interrompre une conversation remet en lumière les risques intrinsèques des plus puissants modèles génératifs. D’une part, l’approche d’Anthropic doit inviter les entreprises à implémenter de tels mécanismes sur les modèles open-source qu’ils utilisent (et qui, souvent, n’incorporent pas le même niveau de garde-fous). D’autre part, elle rappelle l’importance d’implémenter une traçabilité des refus et des terminaisons de fil, compréhension des critères déclencheurs, d’une articulation avec les politiques internes de modération et les obligations réglementaires, ainsi que d’une gestion des cas limites (ex. débats sensibles sans intention malveillante) par les product owners ou par les équipes internes d’éthique de l’IA.

Dans un contexte d’adoption de l’IA générative en entreprise, documenter ces comportements, prévoir leur auditabilité et clarifier les parcours de remédiation devient une exigence opérationnelle autant qu’un sujet de risque juridique.

Reste que l’introduction d’une telle « capacité d’issue de secours » au cœur même des modèles conversationnels est une innovation à poursuivre (Anthropic reconnaît qu’il ne s’agit encore que d’une expérimentation amenée à considérablement évoluer à l’avenir) et un premier pas vers la conceptualisation « du bien et du mal » au sein des modèles. Il est aussi très significatif de voir que désormais les pionniers de l’IA semblent vouloir s’intéresser au « bien-être » des modèles alors que les questionnements autour de la conscience de tels modèles génératifs animent de plus en plus les débats sur l’IA.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :