Data / IA

Les modèles d’Anthropic seraient plus utilisés que ceux d’OpenAI dans les entreprises

Par Laurent Delattre, publié le 01 août 2025

La bataille des modèles d’IA bat son plein : Anthropic double OpenAI chez les entreprises grâce à des modèles hybrides taillés pour le code, alors que les modèles open-source peinent à suivre aux États-Unis si l’on en croit la dernière étude Menlo Ventures. Néanmoins, les investissements explosent et les grands modèles LLM appelés par API continuent de largement séduire.

Les entreprises sont de plus en plus séduites par les petits modèles qu’elles peuvent exécuter en local et personnaliser / fine-tuner à volonté avec leurs propres data. Elles y font de plus en plus souvent appel dès qu’elles doivent opérer des tâches IA sur des données sensibles ou développer des IA très ancrées sur leur patrimoine de données.

Mais elles continuent néanmoins d’utiliser massivement les LLM pour les tâches de codage, les assistants conversationnels généralistes et pour rapidement intégrer des fonctionnalités IA via des API à leurs applications existantes. Preuve en est les résultats de la dernière étude publiée par Menlo Ventures.

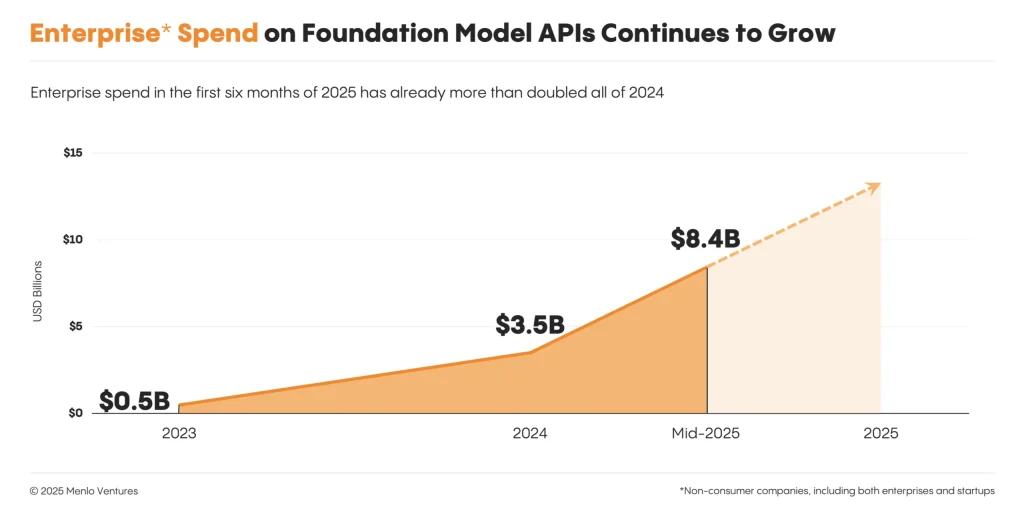

Cette étude essentiellement basée sur les retours de 150 DSI de grandes entreprises principalement américaines, mais aussi de quelques startups, constate une explosion des dépenses en API des grands modèles LLM : entre novembre 2024 et juin 2025, les dépenses des entreprises sont passées de 3,5 milliards de dollars à 8,4 milliards de dollars. Soit 140% d’augmentation en 6 mois seulement ! Une explosion des dépenses qui s’expliquent par un passage d’un nombre significatif de projets en production. Menlo Ventures prévoit que ces dépenses pourraient atteindre 13 milliards de dollars d’ici fin 2025.

Anthropic plus fort qu’OpenAI ?

Mais la véritable surprise de cette étude est ailleurs. Selon Menlo Ventures, Anthropic est désormais le fournisseur de modèles d’IA privilégié par les entreprises, devançant pour la première fois OpenAI en parts d’usage.

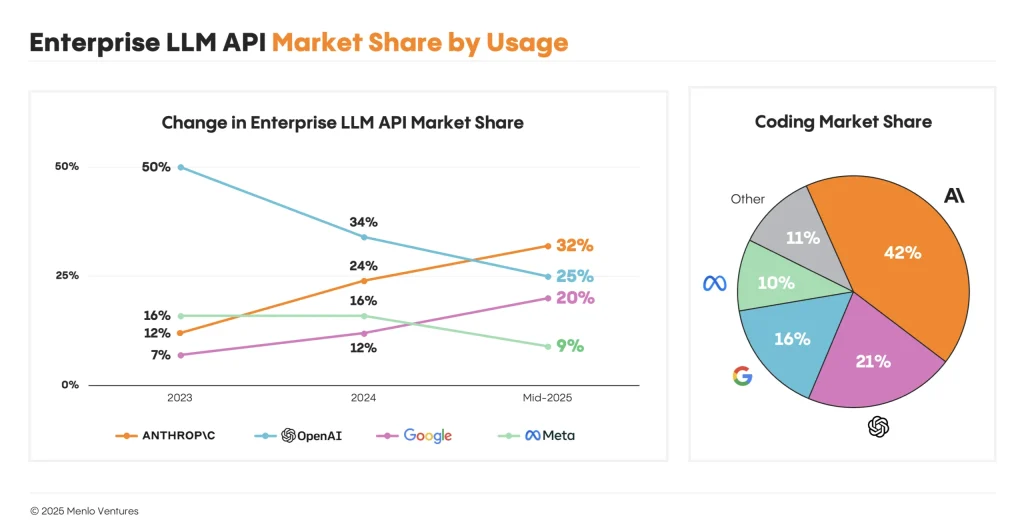

Selon l’étude, Anthropic détient ainsi 32 % du marché des modèles d’IA destinés aux entreprises, tandis qu’OpenAI se place en deuxième position avec 25 %. Cette situation constitue un retournement majeur : en 2024, OpenAI dominait très largement ce marché avec 50 % d’utilisation contre seulement 12 % pour Anthropic.

Plusieurs éléments expliquent ce succès. Tout d’abord, la qualité des modèles Claude d’Anthropic, surtout depuis la sortie en juin 2024 de Claude 3.5 Sonnet rapidement considéré comme faisant au moins jeu égal avec GPT-4o d’OpenAI.

Ensuite, sur l’échantillon d’entreprises considérées, la génération de code est le premier cas d’usage majeur de l’IA. Or, Anthropic a lancé en février dernier son Claude 3.7 Sonnet avec raisonnement intégré, un vrai modèle hybride (contrairement à OpenAI qui perd tout le monde avec ses modèles à raisonnement « OpenAI o » d’un côté et ses modèles « GPT » de l’autre). Or ce modèle hybride a rapidement été apprécié des équipes techniques pour sa capacité à gérer des tâches complexes, à réduire les erreurs (hallucinations), et à optimiser les interactions multi-tours. Depuis quelques semaines, Anthropic a encore amélioré ses modèles avec les sorties de deux nouveaux modèles hybrides Claude Opus 4 et Claude Sonnet 4.

L’étude montre d’ailleurs que dans les activités liées au développement logiciel, l’écart est encore plus prononcé : Anthropic capte 42 % du marché des entreprises contre seulement 21 % pour OpenAI. Cette préférence marquée s’explique par l’adéquation des solutions Anthropic aux besoins opérationnels spécifiques des équipes techniques en matière de codage. Pas forcément très surprenant : GitHub – filiale de Microsoft – a également préféré Anthropic à OpenAI pour animer la préversion de son étonnant outil de codage « Low Code » dopé à l’IA, GitHub Spark !

« Certains seront sans doute surpris de voir Anthropic dépasser OpenAI, qui bénéficiait pourtant de l’avantage du pionnier, commente Tim Tully, associé chez Menlo Ventures. Mais nos données confirment les échos du terrain : les équipes privilégient aujourd’hui des performances opérationnelles réelles et éprouvées en production ». Des échos de terrain qui ne sont d’ailleurs pas forcément similaires de notre côté de l’Atlantique.

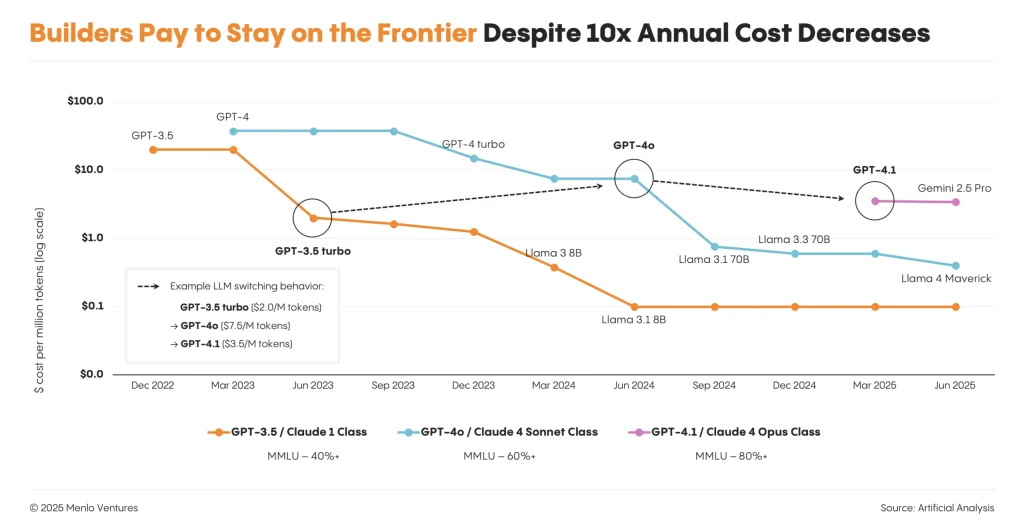

D’abord la performance, pas le prix

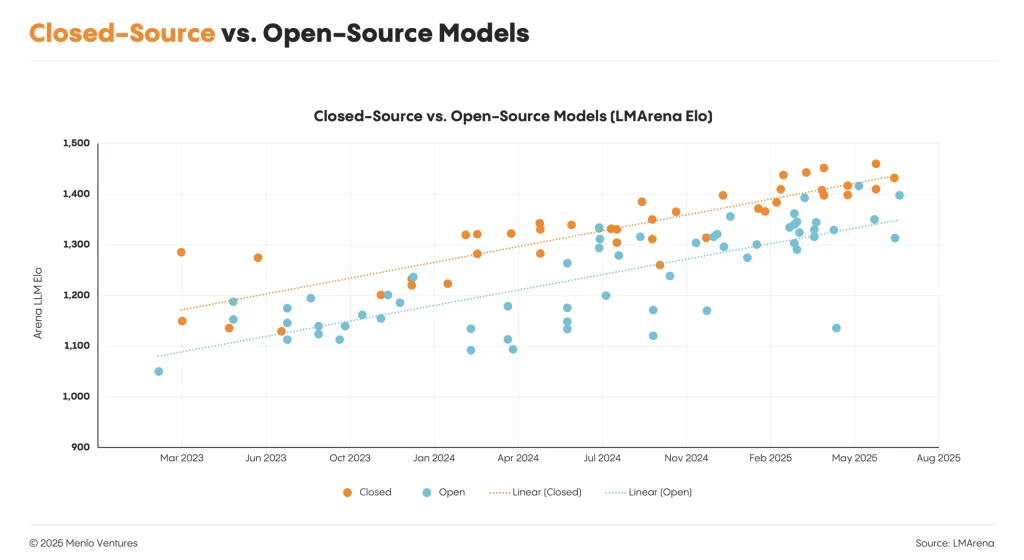

De façon un peu étonnante, l’étude montre aussi que pour le moment les entreprises semblent privilégier la performance au prix. 66% des équipes mettent à jour leurs modèles chez le même fournisseur. Seulement 11 % en changent pour le seul critère de réduction des coûts. Ce qui explique sans doute le triste de score de Google – réputé pour l’accessibilité de ses modèles et ses tarifs agressifs – dans cette étude, même s’il est fort probable que le palmarès évolue encore fortement à l’avenir avec l’arrivée d’un Gemini 2.5 Pro très convaincant (et désormais bien installé en tête du palmarès LLMArena) et le lancement très prochain de GPT-5. L’étude Menlo montre également que les modèles plus anciens, même moins chers, sont rapidement abandonnés au profit des plus performants.

L’Open-source à la traîne

Des préoccupations qui expliquent pourquoi les modèles open-source marquent aussi le pas dans cette étude. Ce n’est pas forcément l’impression que donne le marché vu d’Europe. Mais vue des USA, la dynamique du marché tend vers une prédominance nette des modèles propriétaires. Selon l’étude, plus de la moitié des entreprises interrogées n’utilisent désormais que des modèles fermés. L’utilisation des modèles open-source, elle, recule : seulement 13 % des charges de travail quotidiennes des entreprises y font appel, contre 19 % en début d’année. Sur ce segment particulier, Meta reste toutefois leader.

On s’étonnera de l’absence d’un acteur comme MistralAI, dont les modèles sont particulièrement populaires en Europe et dans les équipes de développement R&D en IA. Cette absence s’explique justement par le panel très américain de l’étude Menlo Ventures.

La principale raison invoquée pour cette préférence vers les modèles fermés serait celle de la performance notamment lorsqu’il faut monter à l’échelle.

Enfin, le rapport anticipe une prochaine évolution vers des systèmes « agents long-horizon » capables de gérer de façon autonome des tâches ouvertes et multi-étapes comme le développement logiciel ou la synthèse de recherches. Ces systèmes représentent une transformation profonde des modèles opérationnels, promettant de nouvelles opportunités, mais aussi des défis importants en matière de gouvernance et de sécurité pour les entreprises.

À LIRE AUSSI :

À LIRE AUSSI :