Cloud

Google I/O 2024 : Une « Google I/A » seconde édition !

Par Laurent Delattre, publié le 15 mai 2024

De l’audio, de la vidéo, de la photo, de la recherche, de l’analyse, du classement, de la sécurité… La conférence Google I/O 2024 confirme que l’IA Gemini infiltre désormais tous les appareils, toutes les stacks et tous les services Google, révolutionnant au passage les produits, les usages et les interfaces homme-machine.

Historiquement, Google I/O est un peu l’équivalent Google de la WWDC d’Apple, le grand rendez-vous de la mobilité et des développeurs Android. Mais l’an dernier, en pleine crise « Code Red » face à l’avance prise par OpenAI et Microsoft, Google avait lancé toute sa stratégie IA lors de Google I/O prononçant 143 fois le mot IA en moins de deux heures et transformant la conférence en « Google I/A ». Même ses employés s’en étaient amusés.

Si, depuis, l’éditeur a refait en partie son retard et s’est imposé en partenaire clé des organisations pour les aider à adopter de l’IA générative, la concurrence demeure intense. Si les modèles « Gemini » sont unanimement reconnus pour leur excellent rapport qualité/prix, ils n’en demeurent pas moins souvent mis à mal voire carrément surpassés par des modèles comme GPT-4o, Mistral Large ou Claude-3 Opus d’Anthropic, voire par le modèle open source Llama 3 de Meta.

Alors qu’OpenAI a lancé cette semaine à grands coups de spectaculaires démos live son nouveau modèle « GPT-4o », Google a une fois encore donné bien plus la priorité à l’IA qu’à Android à l’occasion de l’édition 2024 de Google I/O. Dit autrement, c’est à une nouvelle conférence « Google I/A » que développeurs et DSI ont été conviés, avec une keynote de 110 minutes durant laquelle le mot « IA » aura été prononcé 121 fois !

Google s’est évertué à démontrer comment l’IA générative continuait à s’insérer dans tous les processus, dans tous les services, dans toutes les applications et plus encore dans tous les moments du quotidien. L’éditeur s’est évertué à montrer le potentiel de ses modèles Gemini, à convaincre de ses capacités d’innovation en matière d’IA et à démontrer comment l’IA allait transformer les expériences Android, Gmail et Google Search dans les semaines et mois à venir.

Voici ce que les DSI doivent retenir de cette édition 2024 de Google I/O…

Google à l’ère Gemini

Si les animateurs de Google I/O ont prononcé plus de 120 fois le terme « IA » durant la conférence, ils ont probablement encore plus souvent prononcé le mot « Gemini ». Car chez Google, Gemini est synonyme d’IA. C’est à la fois le nom donné aux IA intégrées aux produits et le nom donné aux modèles sous-jacents.

Et les modèles estampillés « Gemini » se multiplient comme des petits pains chez Google. On connaissait déjà « Gemini Ultra 1.0 », « Gemini Pro » et « Gemini Nano ». À Google I/O 2024, l’éditeur a étendu la disponibilité de son nouveau modèle multimodal « Gemini Pro 1.5 » qui fait de plus en plus d’ombre à « Gemini Ultra ». Non seulement « Gemini Pro 1.5 » est désormais accessible aux Européens (enfin !) mais le modèle se voit enrichi d’une nouvelle option : une fenêtre contextuelle de 2 millions de tokens !

Google joue donc sur la fenêtre contextuelle pour se différencier. Gemini Pro 1.5 était déjà le seul modèle du marché à bénéficier d’une fenêtre d’un million de tokens. Google double la taille de la fenêtre pour permettre d’analyser des contenus encore plus vastes et notamment des vidéos longue durée !

C’est d’autant plus essentiel que, dans le même temps, Google a enrichi son API Gemini pour permettre l’appel de plusieurs fonctions en parallèle, d’extraire des trames vidéos, mais aussi de mettre en cache des contextes de sorte à réduire les coûts d’utilisation lorsque plusieurs prompts doivent embarquer un même contexte.

Gemini Live est une nouvelle expérience qui exploite Gemini Flash pour offrir des intéractions vocales temps réel, un peu à la façon de ce qu’OpenAI a démontré avec GPT-4o.

Par ailleurs, Google a annoncé un nouveau membre dans sa gamme de modèles : Gemini 1.5 Flash. Ce modèle « Flash » est une version de « Gemini 1.5 Pro » optimisée pour réduire au maximum la latence, autrement dit le temps de réponse, et s’approcher d’interactions en temps réel. Ceci, tout en conservant une fenêtre contextuelle de 1 million de tokens !

Quant à Gemini Nano qui a déjà fait son apparition sur les Google Pixel 8 et pourrait se généraliser sur d’autres smartphones Android, Google a désormais l’intention de l’intégrer directement dans Google Chrome (pour Desktop, avec support de l’accélération WebGPU). Reste à déterminer les usages concrets d’une telle intégration des modèles dans le navigateur et l’intérêt d’un « WEB IA » comme le présente l’éditeur.

Sans oublier l’open source

Le géant américain a publié cette année une série de modèles open source dénommés Gemma destinés à s’imposer en alternatives aux modèles open source de Meta (LLama), de Microsoft (Phi, Mai) ou encore de Mistral (Mistral 7B, Mixtral 8x7B…).

Google a démontré cette semaine une version « multimodale » intégrant la vision et dérivant de Gemma. Dénommé PaliGemma, ce modèle permet d’analyser le contenu d’une image, de la sous-titrer, de la labéliser ou de concrétiser des applications de recherche visuelle.

Par ailleurs, l’éditeur a annoncé pour Juin prochain la génération 2 de ses modèles Gemma qui s’enrichiront d’une version à 27 milliards de paramètres (en plus des versions 2B et 7B).

Cette génération 2 est optimisée pour s’exécuter sur des machines dotées d’accélérateurs Google TPU ou de GPU NVidia. Selon Google, les modèles Gemma de première génération ont été téléchargés ‘des millions de fois’.

L’IA réinvente la recherche

Soyons francs. Microsoft a été le premier à comprendre qu’en matière de recherche Web, l’IA allait tout changer. Et son Bing IA a initié de nouvelles habitudes chez ceux qui s’y sont intéressés. Par ailleurs, Microsoft Copilot en mode « Plus Précis » est sans doute l’IA la plus pertinente du moment pour obtenir les réponses Web précises sur des questions précises.

Depuis, You.com, Andi Search et Perplexity.ai sont venus renforcer l’idée que la recherche « à la Google » appartenait au passé. D’autant que, parallèlement, Google s’est aussi aperçu que les jeunes générations passaient presque systématiquement par TikTok ou Instagram pour leurs recherches de lieux, bars et restaurants et non par Google Search et Google Maps.

Et si le leader de la recherche WEB s’est montré jusqu’ici très frileux à l’idée de révolutionner son service, il a semblé vouloir opérer un changement de stratégie à l’occasion de ce Google I/O. Avec à la clé plusieurs transformations.

La plus importante est sans conteste « AI Overview », une fonctionnalité expérimentée depuis plusieurs mois et qui va finalement être déployée plus largement aux USA dans les prochaines semaines avant un déploiement à l’international. La fonction explore les premiers liens d’occurrence et présente une sorte de résumé combiné de leurs contenus.

« Circle To Search » est une autre expérience de recherche sur mobile que Google veut généraliser à l’avenir pour remplacer Google Lens.

Mais Google veut aussi aller plus loin et notamment exploiter l’IA pour réorganiser l’affichage des résultats. Dit autrement, à l’avenir, cela pourrait être bien davantage l’IA qui décide de l’ordre des liens présentés que les optimisations SEO qui ont jusqu’ici toujours dictées le fonctionnement du moteur et le Business de Google Search ! Une véritable révolution !

Google a aussi d’autres idées en tête avec notamment une nouvelle recherche vidéo en preview dans son « Labs ». L’idée est de permettre à l’utilisateur d’uploader une vidéo et de lancer une recherche en combinant son contenu et du texte. Dit autrement, la recherche visuelle de Google va s’ouvrir aux vidéos et ne plus se limiter aux photos.

À titre d’exemple, Google a montré une vidéo d’une platine vinyle dont le bras ne restait pas sur le disque. La requête comprenait une vidéo montrant le problème en action accompagnée de la question : « Pourquoi le bras ne reste-t-il pas en place ? ». L’IA Gemini de Google prend alors la main et analyse la vidéo image par image pour comprendre son contenu, puis propose une série de conseils pratiques pour résoudre la panne.

L’IA, la formation et YouTube

Par ailleurs, Google continue d’explorer de nouveaux cas d’usage de l’IA. Et notamment en matière de formation et d’éducation. À l’occasion de Google I/O, l’éditeur a annoncé une nouvelle série de modèles d’apprentissage dérivés de Gemini, dénommée « LearnML ». L’idée consiste à proposer des IA à même de générer des résumés, des explications ou des idées créatives avec une optique orientée sur l’éduction, l’apprentissage, la formation afin de mieux répondre aux besoins des étudiants, professeurs et chercheurs. Ces modèles sont déjà intégrés dans l’outil expérimental de Google Labs « NotebookLM » qui permet de synthétiser et d’analyser rapidement les informations contenues dans des documents personnels tels que des Google Docs.

Ces modèles doivent permettre de proposer des solutions de formation et d’apprentissage plus interactive et personnalisée grâce à l’IA.

Et pour illustrer ce potentiel, Google expérimente LearnML Google pour présenter des quiz générés par l’IA directement sur YouTube. Cette nouvelle fonctionnalité – qui bénéficie de la large fenêtre contextuelle des modèles Gemini – permet aux utilisateurs de poser des questions, demander des explications, générer un résumé ou passer un quiz lorsqu’ils regardent des vidéos éducatives.

L’IA au cœur d’Android

« Nous sommes à un moment charnière dans une génération où les dernières avancées en matière d’IA réinventent ce que les téléphones peuvent faire », a ainsi affirmé Sameer Samat, président de Google. « Avec l’IA Google au cœur du système d’exploitation Android, les milliards d’utilisateurs peuvent désormais interagir avec leurs appareils d’une manière entièrement nouvelle. »

Et pour démontrer cette nouvelle réalité, Google a notamment dévoilé son projet Astra, réponse directe aux annonces d’OpenAI de ce début de semaine. Grâce à des capacités temps réel de perception en temps réel du monde physique par le truchement des caméras du smartphone, l’IA peut analyser, décrire, enrichir, commenter l’environnement.

L’éditeur compte aussi continuer d’enrichir l’application mobile Gemini sur Android pour en faire un « Assistant Google » de nouvelle génération bien plus puissant, loquace et interactif.

Google a déjà introduit sa fonction « Circle To Search » pour lancer une recherche simplement en entourant un élément sur l’écran du mobile. Désormais la fonctionnalité peut aussi être utilisée pour résoudre des problèmes de mathématiques ou de physique.

Mais les intégrations IA vont aller bien plus loin avec l’apparition d’une surcouche Gemini – plein écran et au cœur du système – capable de s’afficher par-dessus n’importe quelle application pour y insuffler de l’IA (dans une logique qui n’est pas sans rappeler les démos ChatGPT Desktop d’OpenAI) pour reformuler du texte, insérer des images générées par IA ou obtenir la description d’une vidéo par exemple.

Un nouveau TPU

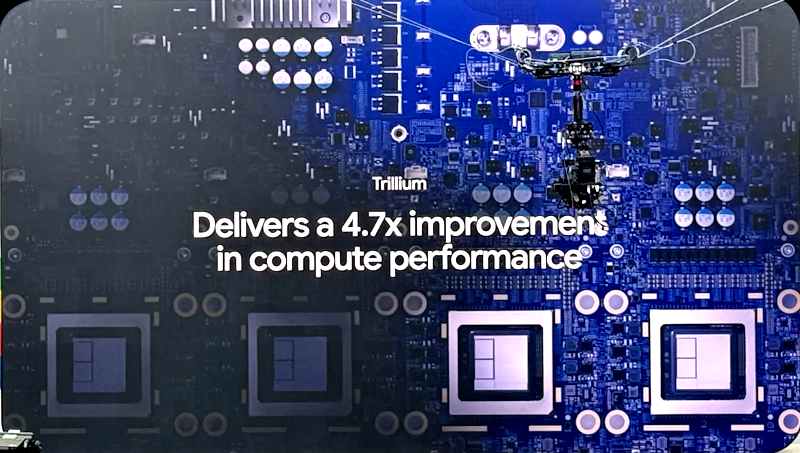

À l’occasion de sa conférence Google Cloud Next le mois dernier, l’éditeur s’était longuement étendu sur l’arrivée de ses accélérateurs TPU v5p. L’annonce de « Trillium », 6 ème génération de TPU est donc une grosse surprise même si les précédents TPU ont souvent été annoncés à Google I/O.

Google annonce un boost de performance de 4,7 fois sur cette nouvelle génération, boost obtenu en multipliant les unités matricielles MXU, en gonflant la fréquence d’horloge et en doublant la bande passante mémoire ! En outre, Trillium est équipé de cœurs SparseCore de troisième génération, un accélérateur spécialisé pour le traitement des embeddings ultra-larges, couramment utilisés dans les tâches de classement et de recommandation. Selon Google, les TPU Trillium vont permettre d’entraîner la prochaine vague de modèles fondation plus rapidement et d’inférer ces prochains modèles avec une latence réduite et un coût moindre. « Fait essentiel, nos TPU de sixième génération sont également les plus durables : les TPU Trillium sont plus de 67 % plus écoénergétiques que les TPU v5e » précise également Google.

Ces TPU sont destinés à rejoindre la prochaine génération de « TPU Pods » de Google, chaque Pod embarquant 256 TPU Trillium. Google Cloud peut assembler des centaines de Pods au sein d’un même cluster de calcul au sein d’un réseau « multi-petabit par seconde ».

Investir l’IA dans tous ses cas d’usage

L’une des forces de Google est d’avoir la capacité d’explorer les usages de l’IA dans toutes les directions comme le font aussi OpenAI et Microsoft.

Ainsi, à l’occasion de Google I/O, l’éditeur a annoncé la troisième génération de son modèle Imagen de génération d’images qui non seulement offre des rendus plus créatifs et détaillés mais se révèle également moins perméable aux hallucinations et erreurs mais également capable d’un rendu de texte précis et juste ce qui n’est clairement pas le fort de concurrents comme Dall-E 3 ou Firefly 2. Imagen 3 est disponible via VertexAI et via l’outil ImageFX malheureusement toujours inaccessible aux européens.

Toujours du côté des images fixes, Google a annoncé une nouvelle fonctionnalité « Ask Photos » pour son application « Photos ». Cette fonctionnalité permet de trier et rechercher des photos à l’aide du potentiel d’analyse de contenus de Gemini.

Autre nouveauté, VEO est un nouveau modèle de génération de vidéo présenté comme le concurrent direct du fameux modèle SORA d’OpenAI. Veo génère des séquences vidéo de plus d’une minute en qualité 1080p (Full HD). « Notre modèle offre un niveau de contrôle créatif sans précédent et comprend des termes cinématographiques tels que « timelapse » ou « prises de vue aériennes d’un paysage ». Veo crée des séquences homogènes et cohérentes, de sorte que les personnes, les animaux et les objets se déplacent de manière réaliste tout au long des prises de vue » explique Google.

Google a également démontré MusicFX un nouvel outil qui utilise l’IA générative pour créer de la musique en fonction d’une description textuelle.

Bref, Google poursuit ses efforts pour imposer l’IA dans tous ses appareils, tous ses services, toutes ses applications. Sa force réside dans l’omniprésence de ses outils (Chrome, Google Search, Google Photos …) qui lui procure une audience naturelle et immédiate mais aussi dans la simplicité et l’accessibilité de sa plateforme Vertex AI ainsi que dans le rapport qualité/prix de ses modèles « Gemini » significativement moins onéreux que ceux de ses concurrents. Et au rythme où vont les évolutions, nul doute que le prochain « Google I/O » sera une nouvelle fois très « Google A/I ».