Data / IA

Mistral AI lance ses modèles LLM commerciaux sur son portail développeur et sur Azure

Par Laurent Delattre, publié le 27 février 2024

Après ses modèles open source très populaires, Mistral AI lance cette semaine deux nouveaux modèles « commerciaux » aux performances largement supérieures et dignes des meilleurs modèles américains. Et pour que chacun puisse s’y confronter, Mistral AI lance aussi son service d’IA conversationnelle « Mistral Le Chat ».

Mistral AI est une startup étonnamment singulière. Singulière par ses fondateurs qui sont toutes des personnalités. Singulière aussi par la fulgurance de sa croissance : elle a levé 105 millions d’euros après quelques semaines d’existence et elle est devenue licorne moins d’un an après sa création (après une deuxième levée de fonds de 385 millions d’euros). Singulière aussi par son aura : en quelques mois, elle a su s’imposer comme le vrai concurrent européen d’OpenAI, Anthropic et Cohere. Singulière enfin, par la qualité de ses modèles qui — bien que n’accumulant pas de centaines de milliards de paramètres — rivalisent allégrement avec les puissants LLM d’OpenAI (GPT-4) et de Google (Gemini Pro).

Mistral AI lance deux modèles propriétaires et un ChatGPT-Like

Cette semaine, Mistral AI vient de franchir une nouvelle étape dans sa quête de parts de marché et s’impose un peu plus comme LE rival européen d’OpenAI. Microsoft ne s’y est d’ailleurs pas trompé. L’éditeur américain a réussi un joli coup en devenant le premier partenaire commercial de la startup (en revendant les modèles commerciaux de Mistral AI dans Azure) et en signant un partenariat pluriannuel qui ouvre les HPC-AI d’Azure à la R&D de Mistral AI. Microsoft annonce un investissement dans Mistral AI de 15 millions d’euros (certes très loin des milliards investis dans OpenAI).

Mistral AI a en effet annoncé cette semaine non seulement l’introduction sur sa plateforme (Mistral La Plateforme) de ces deux premiers modèles commerciaux « Mistral Large » et « Mistral Small » mais aussi l’ouverture en preview de « Le Chat » l’interface conversationnelle qui permet de discuter avec ses modèles et qui apparaît comme une ébauche de concurrent à Google Gemini (ex BARD) et ChatGPT.

À LIRE AUSSI :

« Mistral Large » et « Mistral Small » dérivent des travaux opérés sur les modèles open source « Mixtral 8x7B » et « Mistral 7B » mais s’en diffèrent probablement à la fois par les sources de données ayant servi à leur apprentissage et par des mécanismes de contrôles, de filtrages et de modération plus avancés. Ces nouveaux modèles ne sont pas disponibles en open source. Mais ils sont d’ores et déjà accessibles via « La Plateforme » de Mistral AI et via le service MaaS (Models as a Service) d’Azure AI Studio. Les modèles sont aussi commercialisés pour des déploiements « on-premises » ou sur cloud privé en contactant les équipes commerciales de Mistral AI.

Ils animent surtout « Le Chat », un nouveau service Web d’IA conversationnelle également lancé cette semaine par Mistral AI. « Le Chat » est lancé en preview publique et peut être testé gratuitement après inscription préalable.

Des modèles qui boxent dans la catégorie poids lourds

Avec Mistral Large, Mistral AI sort les gants de boxe et affrontent directement ce qui se fait de mieux en matière d’IA générative textuelle chez les américains. Mistral Large est le pendant européen de GPT-4 et Gemini Pro.

Mistral Large prétend :

– Maîtriser « nativement » l’anglais, le français, l’espagnol, l’allemand et l’italien, avec une compréhension nuancée de la grammaire et du contexte culturel.

– Proposer une fenêtre contextuelle de 32.000 tokens pour retrouver de l’information de manière précise dans des grands corpus de documents (ou dans jusqu’à 10 documents joints).

– Capable de suivre précisément des instructions pour permettre aux développeurs de définir leurs propres politiques de modération. Mistral AI propose parallèlement un mode sécurisé optionnel qui peut être activé pour la modération de contenu sensible sans avoir à développer une telle protection.

– Capable d’appeler des fonctions autrement dit des services et API. Cela, combiné avec le mode “JSON output”, mis en œuvre sur la Plateforme, permet le développement d’applications en lien avec des systèmes existants, et la modernisation des piles technologiques à grande échelle.

De son côté, Microsoft – qui n’a que des louanges à formuler sur son nouveau partenaire – estime que Mistral Large est aussi :

– Spécialisé dans le RAG et capable de s’intégrer au contexte informationnel d’une entreprise,

– Fort en codage, qu’il s’agisse de générer des lignes de code, de les analyser ou de les commenter,

– Multilingue par design avec une réelle aptitude à s’exprimer et penser à l’européenne,

– Responsable avec des garde-fous efficaces intégrés au cœur du modèle.

À LIRE AUSSI :

Mistral Large est disponible dès aujourd’hui sur le service « La Plateforme » de Mistral AI destiné aux développeurs ainsi que sur la Marketplace Azure. Au passage, on notera que Microsoft rend pour l’instant disponible « Mistral Large » sur deux régions : East US 2 et France Central ! Par défaut, l’accès est capé à 200.000 tokens par minute et 1000 requêtes par minute.

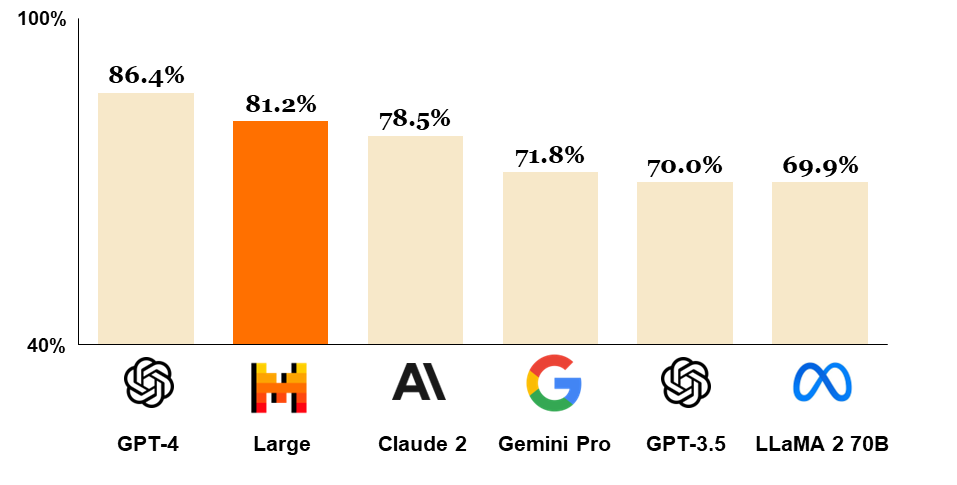

Côté performance, Mistral Large surpasserait Gemini Pro et Claude 2 en compréhension linguistique et en raisonnement ainsi qu’en calculs mathématiques. Il resterait cependant légèrement moins performant que GPT 4 d’une manière générale. Et, en matière de codage, il se montrerait un peu moins pertinent que Gemini Pro et GPT 4.

À l’usage, les capacités de compréhension et d’expression française de Mistral Large se révèlent excellentes et le modèle brille particulièrement pour la clarté et la concision de ses réponses.

Les prix pratiqués par Mistral AI sur « La Plateforme » sont identiques à ceux pratiqués sur Azure mais facturés différemment. Mistral AI facture au million de tokens, Azure au millier de tokens. Ainsi sur Azure, les appels sont facturés 0,024$ par mille tokens inférés (et 0,008$ pour 1000 tokens analysés), des prix significativement inférieurs à GPT-4 (0,12$ par mille tokens à l’inférence). Mais des prix qui semblent supérieurs à ceux pratiqués par Google avec Gemini Pro (0,005$ pour 1000 caractères inférés, on considère en général qu’il faut 3 caractères pour faire un token).

Quant au modèle Mistral Small, Mistral AI se montre très peu prolixe sur ses capacités. On sait qu’il s’agit d’un modèle « optimisé pour la latence et le coût, les tarifs étant 4 fois inférieurs à Gemini Large. Selon Mistral AI, « Mistral Small » est à la fois plus performant et plus rapide que son modèle open source Mixtral 8x7B. Si on en croit les Benchmarks réalisés par l’éditeur, Mistral Small serait même meilleur que Gemini Pro 1.0 et GPT 3.5, aussi bien dans la compréhension des formulations complexes (test MMLU) que dans le raisonnement (test HellaSwag).

Bref, comme nous l’évoquions la semaine dernière avec la preview de Mistral NEXT, l’Europe n’a plus à rougir du moindre retard technologique sur les leaders américains. Mistral AI est en train de démontrer tout le potentiel que les investisseurs y ont vu et sa maîtrise indéniable du sujet avec un savoir-faire qui ne peut qu’inquiéter la concurrence.

La compétition en matière de modèles LLM ne se joue désormais plus entre acteurs américains mais bien entre OpenAI, Google et Mistral AI, Microsoft prenant désormais soin de jouer plusieurs cartes à la fois.

On ne peut s’empêcher de penser que l’arrivée de Mistral Large est quand même un coup dur pour Google (oui, une startup française peut faire mieux que les milliards injectés par le géant américain dans DeepMind et Gemini) qui peut toutefois se défendre sur l’argument tarifaire et un coup encore plus dur pour AWS qui paraît plus que jamais distancé. Le cloud d’Amazon a eu beau essayer de surfer sur la vague Mistral AI en annonçant la disponibilité sur BedRock des modèles open source de la startup française, cela ne berne personne et pire encore dessert AWS tant les nouveaux modèles commerciaux de Mistral AI « explosent » en performance et pertinence les modèles open-source.

Mistral Le Chat : pour tous et pour l’entreprise

Mistral Le Chat est le service conversationnel qui permet de discuter avec les modèles Mistral Small, Mistral Large et le prototype « Mistral Next » (dont on a parlé la semaine dernière).

Actuellement en bêta, « Le Chat » est gratuit et accessible à tous. Mais, tout comme son concurrent ChatGPT, les données échangées avec les IA sont historisées et pourront être utilisées à des fins commerciales.

Dans les prochaines semaines, Mistral AI déclinera son service conversationnel en versions plus adaptées aux usages professionnels. Une version « Le Chat » payante permettra de disposer d’un mode « incognito » n’historisant pas les conversations et proposera en mode ‘opt-out’ d’un paramètre pour interdire l’usage des historiques à des fins d’apprentissage des prochains modèles.

Par ailleurs, une version « Le Chat Entreprise » – qui peut être déployée on-premises ou sur des infrastructures cloud privées ou managées – sera également disponible après discussion commerciale avec les équipes de vente de Mistral AI.

À LIRE AUSSI :