Data / IA

« SLM first », le choix rationnel pour déployer des agents IA à l’échelle

Par La rédaction, publié le 04 novembre 2025

Moins massifs, moins gourmands, plus rapides : les SLMs bousculent le paradigme des agents IA. En allégeant les coûts d’inférence et en renforçant la personnalisation, ils posent les bases d’une IA décentralisée et agile. Leur complémentarité avec les LLMs ouvre la voie à une IA réellement scalable et contextuelle.

De Mattéo Procoppe, Spécialiste Technique IA chez IBM

De nombreuses organisations connaissent déjà la valeur ajoutée des Small Language Models (SLM) : consommation énergétique et coûts d’inférence plus faibles, latence réduite, meilleure personnalisation. En septembre 2025, 52 % des modèles disponibles avaient moins d’un milliard de paramètres, et près de 70 % moins de 3 milliards. Gartner anticipe qu’à l’horizon 2027, les petits modèles spécialisés seront trois fois plus utilisés que les Large Language Models (LLM) généralistes, tirés par le besoin de contexte métier, de fiabilité et de maîtrise des coûts. Néanmoins, ces petits modèles sont-ils pertinents à l’ère de l’IA agentique ?

Rappel sur les systèmes agentiques

Un agent IA est un système conçu pour raisonner à la résolution de problèmes complexes, créer des plans d’action et exécuter ces plans en utilisant une suite d’outils adaptés. Parmi leurs limitations, les systèmes agentiques sont exigeants en termes de capacité de calcul. Ils consomment un nombre de token important et ont besoin de bonnes capacités de raisonnement afin de comprendre le problème et d’effectuer des appels aux bons outils. Face à la complexité des outils et des tâches, l’approche via des systèmes multi-agents (MAS) devient la norme.

Pourquoi passer à une architecture SLM first pour les agents ?

Dans la plupart des workflows agentiques, les tâches sont répétitives, cadrées et fortement formatées (extraction, rédaction structurée, appels d’outils, classification). Sur ces périmètres, les SLMs égalisent les performances des LLMs (majoritairement utilisés à date), tout en réduisant latence et coûts d’inférence (comme l’ont montré les chercheurs de Nvidia). Certains SLMs comme Granite démontrent que ces modèles coûtent 3 à 23 fois moins cher que les LLMs de pointe tout en surpassant leurs concurrents de taille similaire en termes de performance.

En termes de taille, les paramètres des SLMs vont de quelques millions à quelques milliards, en général pas plus de 10 milliards. Leur taille permet un déploiement on-device ou en périphérie (edge), réduisant la dépendance au cloud et améliorant la confidentialité des données. Par exemple, certains acteurs développent des fonctions agentiques embarquées permettant à un SLM d’accéder au contexte personnel stocké sur le smartphone (messages, photos, appels), tout en gardant les données en local, avec la possibilité d’appeler des plugins ou des LLMs plus puissants si nécessaire.

Quelle architecture pour un système agentique basé sur des SLMs ?

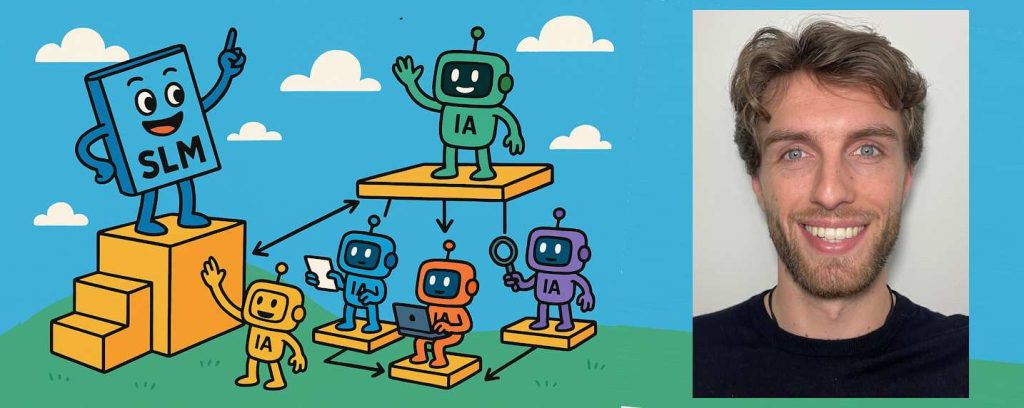

L’approche multi-agent permet de tirer parti des différents avantages des SLMs. Un système multi‑agents (MAS) est un ensemble d’agents IA spécialisés capables de prendre des décisions et de collaborer entre eux ou avec leur environnement pour atteindre des objectifs communs au nom d’un utilisateur ou d’un autre système. Parmi les différentes approches MAS, l’architecture hiérarchique s’avère particulièrement adaptée aux SLMs, car elle permet d’organiser les modèles selon leur spécialisation.

L’architecture hiérarchique est organisée en niveaux où un agent central supervise et répartit les tâches vers des agents spécialisés. L’agent superviseur utilise la description des agents collaborateurs et parfois des instructions de routage pour déterminer vers quel agent orienter la demande d’un utilisateur. À ce jour, l’agent superviseur est généralement basé sur un LLM qui analyse les requêtes et les décompose en sous-tâches. Ces sous-tâches sont ensuite déléguées à des agents spécialisés basés sur des SLMs et capable d’utiliser des outils spécifiques avec des instructions adaptées à la spécialité de l’agent et aux outils disponibles. Cette répartition permet non seulement de réduire la charge computationnelle en évitant de solliciter un LLM pour chaque étape, mais aussi d’améliorer la modularité et la scalabilité du système. Ainsi, les SLMs garantissent une exécution agentique performante et économique, tandis que le LLM superviseur assure la pertinence globale des réponses.

En résumé…

Dans une architecture agentique, la complémentarité entre LLMs et SLMs devient un levier stratégique : les SLMs assurent l’efficacité, la rapidité et la personnalisation, tandis que les LLMs peuvent intervenir ponctuellement pour des tâches complexes ou non spécialisées. L’approche MAS permet l’utilisation de modèles plus spécialisés et donc plus petits. En segmentant les tâches en différents prompts, les instructions globales du système sont plus robustes tandis que la spécialisation des outils apporte la fiabilité et la sécurité nécessaires au passage à l’échelle. Cette stratégie hybride permet de maximiser les performances tout en maîtrisant les coûts, ouvrant la voie à un déploiement à l’échelle et pragmatique des agents IA.

À LIRE AUSSI :

À LIRE AUSSI :