Gouvernance

Après l’Union Européenne, le G7 veut « gouverner » les IA génératives

Par Thierry Derouet, publié le 23 mai 2023

Pas une semaine ne s’écoule sans qu’il ne soit question de réguler l’utilisation « responsable » de l’IA. Après l’UE et en attendant le Congrès Américain, c’est au sein du G7 que le débat sur l’IA s’est déplacé.

L’urgence est palpable. Hier encore, une image trompeuse, générée par une IA, dépeignant une explosion près du Pentagone, a entraîné une chute éphémère de 0,26 % du S&P 500. Rapidement identifiée, cette image, initialement diffusée sur les réseaux sociaux, a renforcé les préoccupations de Sam Altman, le PDG d’OpenAI.

Une IA réglementée comme l’atome

En effet, lors de son intervention devant une commission parlementaire américaine le 16 mai 2023, Altman a insisté sur l’importance d’ancrer le développement de l’IA dans des valeurs démocratiques. Il a également plaidé pour la mise en place d’un cadre réglementaire international pour l’IA, malgré les défis que cela représente. Il a cité l’Agence internationale de l’énergie atomique (AIEA) comme possible modèle.

par IA.

Sam Altman,

plaide pour la mise

en place d’un cadre

réglementaire

international

pour l’IA

Le G7 donne rendez-vous à la fin de l’année

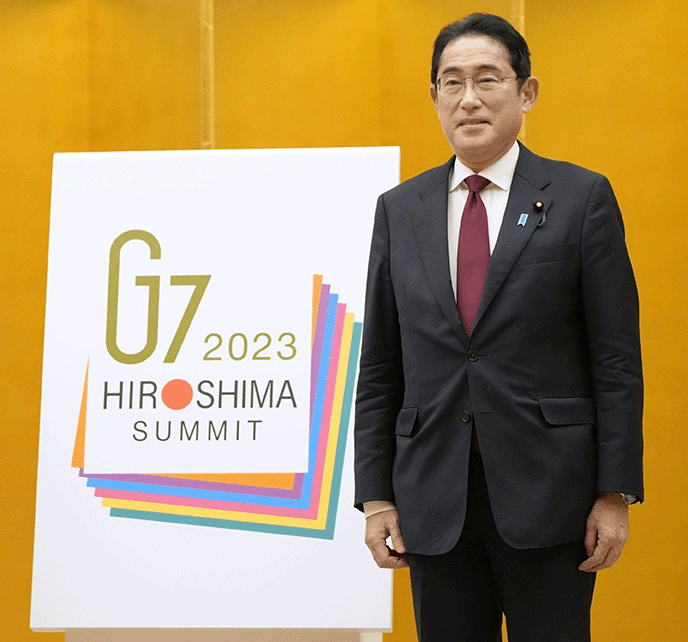

Son appel a retenti jusqu’au G7, qui, lors de sa réunion à Hiroshima, au Japon, a décidé de créer un groupe de travail pour définir une utilisation « responsable » de l’IA. Ce terme englobe la mise en place d’une gouvernance, la protection des droits de propriété intellectuelle comme la lutte contre la désinformation. Les dirigeants du G7 ont convenu que leurs ministres respectifs discuteraient de ces questions dans le cadre du « processus d’IA d’Hiroshima » et rendraient compte de leurs conclusions d’ici la fin de l’année.

Fumio Kishida a

insisté lors du G7

sur une approche

« centrée sur l’homme »

pour le développement

de l’IA et a appelé

à un échange mondial

et sécurisé de données.

L’AI Act soumis au vote dès le mois prochain

Cependant, ni le Congrès américain, ni le G7 ne sont aussi avancés que l’Union européenne dans ce domaine. En effet, l’UE a adopté l’Artificial Intelligence Act, qui doit être soumis à un vote à Bruxelles en juin prochain. Avec lui, le Parlement européen a franchi une étape importante dans l’élaboration des premières règles sur l’intelligence artificielle en Europe en approuvant de nouvelles règles de transparence et de gestion des risques en demandant de garantir que les systèmes d’IA soient supervisés par des personnes, qu’ils soient sûrs, transparents, traçables, non discriminatoires et respectueux de l’environnement. Les eurodéputés ont également souhaité une définition uniforme de l’IA pour qu’elle « soit technologiquement neutre, afin qu’elle puisse s’appliquer aux systèmes d’IA d’aujourd’hui et de demain ».

Un cadre pour soutenir l’innovation…

Pour ne pas mettre fin à l’innovation, les députés ont toutefois ajouté des exemptions pour les activités de recherche et les composants d’IA fournis sous licence open source. La nouvelle loi promeut les bacs à sable réglementaires, ou environnements contrôlés, établis par les autorités publiques pour tester l’IA avant son déploiement.

… comme pour protéger les citoyens

Enfin, les députés envisagent de renforcer la possibilité pour les citoyens de déposer des plaintes concernant l’IA et d’exiger des explications sur les décisions prises par des systèmes d’IA à haut risque.

À LIRE AUSSI :

Ce qu’un DSI doit retenir de l’IA Act

Les systèmes d’IA présentant un niveau de risque inacceptable pour la sécurité des personnes seront strictement interdits par l’IA Act, « y compris les systèmes qui déploient des techniques subliminales ou délibérément manipulatrices, exploitent les vulnérabilités des personnes ou sont utilisés pour la notation sociale (classification des personnes en fonction de leur comportement social, de leur statut socio-économique, de leurs caractéristiques personnelles) ».

Pour être commercialisés, les systèmes d’IA à haut risque doivent respecter des obligations strictes, incluant :

– une évaluation adéquate des risques,

– une qualité élevée des données,

– une traçabilité des activités,

– une documentation détaillée,

– une information claire pour l’utilisateur,

– un contrôle humain approprié,

– et une robustesse, sécurité et précision élevées.

Les systèmes d’IA basés sur l’identification biométrique à distance sont considérés comme à haut risque et sont soumis à des exigences strictes. Leur utilisation en temps réel dans l’espace public pour le maintien de l’ordre est généralement interdite, sauf exceptions strictement définies et réglementées.

Les systèmes d’IA à risque limité, comme les chatbots, doivent respecter des obligations spécifiques de transparence. Les utilisateurs doivent savoir qu’ils interagissent avec une machine.

Les systèmes d’IA à risque minime, comme les jeux vidéo ou les filtres anti-spam, peuvent être utilisés librement. La plupart des systèmes d’IA appartiennent à cette catégorie. Le projet de règlement ne prévoit pas d’intervention dans ce domaine, car ces systèmes présentent un risque minime ou nul pour les droits ou la sécurité des citoyens.