Data / IA

OpenAI réinvestit le terrain de l’IA ouverte avec deux modèles de raisonnement destinés aux entreprises

Par Laurent Delattre, publié le 06 août 2025

En proposant deux modèles « gpt-oss » de 20 milliards et 120 milliards de paramètres sous licence Apache 2.0, OpenAI rompt près de six ans de fermeture dans le domaine des grands modèles de langage et met entre les mains des entreprises des briques d’IA à raisonnement avancé, téléchargeables et finement personnalisables. Cette ouverture rebat les cartes d’un marché dominé par les modèles propriétaires et nourrit l’appétit des DSI pour des solutions souveraines, performantes et pilotables.

L’annonce du 5 août 2024 a surpris plus d’un observateur. Alors que l’écosystème technologique mondial attendait fébrilement l’arrivée de GPT-5, OpenAI a déjoué les pronostics en dévoilant deux modèles de raisonnement ouverts, marquant ainsi son premier retour significatif vers l’open weight depuis GPT-2 en 2019 et depuis Whisper v3 en 2023.

Ce lancement, loin d’être anodin, témoigne d’une évolution stratégique majeure pour l’entreprise californienne qui avait progressivement abandonné sa philosophie initiale d’ouverture au profit d’une approche propriétaire. Il concrétise une promesse formulée par Sam Altman en début d’année. Une promesse qui n’a d’ailleurs rien de philanthropique. « En matière d’ouverture de nos technologies, je pense que nous avons été du mauvais côté de l’Histoire » expliquait en début d’année Sam Altman tout en annonçant la publication en 2025 d’un modèle LLM en open source « state of the art ».

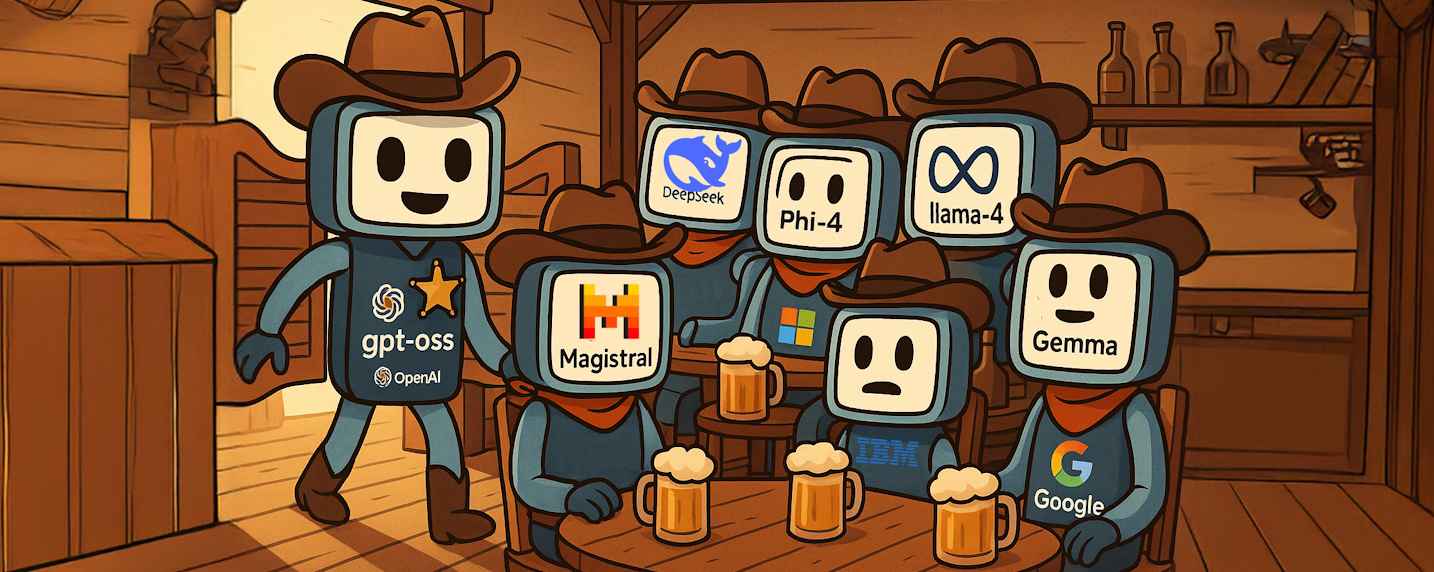

Car dans un contexte concurrentiel où les modèles ouverts de Meta avec Llama, de Mistral AI avec ses solutions européennes, et surtout l’onde de choc provoquée par DeepSeek R1, séduisent de plus en plus d’entreprises, OpenAI se devait de réagir pour conserver sa légitimité technologique et stratégique. Dans un contexte de tensions géopolitiques exacerbées qui favorisent l’adoption des technologies ouvertes, l’éditeur promet aux entreprises la puissance des « OpenAI o » dans des déploiements qu’elles contrôlent de bout en bout.

Mais cette « ouverture » nouvelle d’OpenAI s’inscrit également dans un contexte juridique tendu, marqué par les accusations répétées d’Elon Musk concernant la « trahison » de la mission originelle d’OpenAI et la volonté du milliardaire américain de tout faire pour empêcher son ancienne startup de modifier ses statuts et se transformer en une véritable société lucrative.

L’IA open weight : un levier stratégique pour l’autonomie des entreprises

L’émergence des modèles ouverts, qu’ils soient « open source » ou simple « open weight », représente une révolution silencieuse dans l’adoption de l’intelligence artificielle en entreprise. Contrairement aux solutions propriétaires qui maintiennent les organisations dans une relation de dépendance vis-à-vis des fournisseurs cloud, les modèles ouverts offrent une autonomie opérationnelle et stratégique fondamentale. Cette indépendance se manifeste à plusieurs niveaux : hébergement sur infrastructure propre, conservation des données sensibles en interne, et surtout, capacité d’adaptation fine aux spécificités métiers sans contraintes externes afin de disposer de modèles « sur mesure ».

« Nous avons le mot “open” dans notre nom, et il était grand temps que nous le respections : aujourd’hui, je suis fier d’annoncer la publication de gpt-oss, nos premiers modèles de langage entièrement open source depuis 2019 » a ainsi officialisé hier Sam Altman.

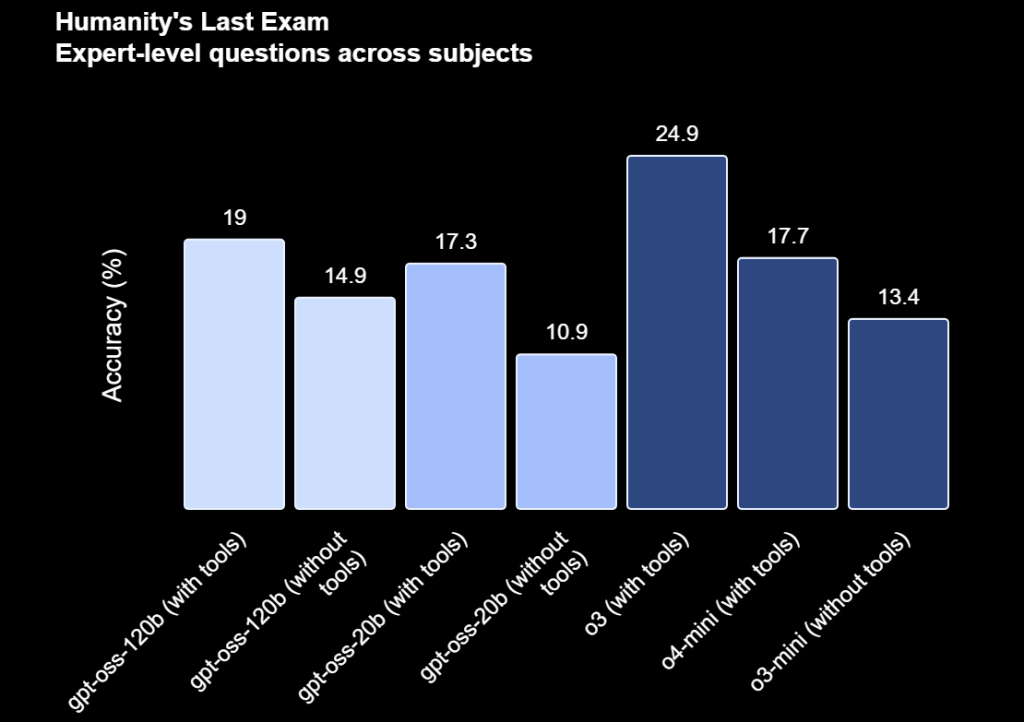

Les modèles gpt-oss s’inscrivent dans cette dynamique en proposant une architecture sous licence Apache 2.0, permettant aux entreprises de les télécharger, les modifier et les déployer selon leurs besoins spécifiques. Cette approche répond directement aux préoccupations croissantes des directions informatiques concernant la souveraineté numérique, la conformité réglementaire et la maîtrise des coûts opérationnels. Le modèle « gpt-oss-120b », avec ses 117 milliards de paramètres dont seulement 5,1 milliards sont activés par token grâce à son architecture Mixture-of-Experts, offre des performances comparables aux modèles propriétaires OpenAI o3 et o4-mini tout en optimisant considérablement les coûts d’inférence.

Des capacités techniques pensées pour l’intégration en entreprise

La conception technique des modèles gpt-oss révèle une compréhension approfondie des besoins opérationnels des entreprises. Le modèle gpt-oss-120b, conçu pour les environnements data center et les stations de travail haut de gamme, s’exécute sur un seul GPU avec 80 Go de RAM, une configuration désormais accessible pour de nombreuses organisations. Son homologue plus léger, gpt-oss-20B, démocratise davantage l’accès en fonctionnant avec seulement 16 Go de mémoire sur des machines équipées de NPU ou GPU standards, ouvrant ainsi la voie aux déploiements edge et aux itérations rapides. Les deux modèles se déclinent d’ailleurs aussi en quantisation 4-bit pour réduire encore l’empreinte mémoire sans vraiment sacrifier la qualité des réponses.

L’optimisation pour l’utilisation d’outils constitue l’un des atouts majeurs de ces deux modèles. Au-delà de la simple génération de texte, ils peuvent déclencher des actions, exécuter du code et interagir avec des environnements techniques complexes. Cette capacité d’orchestration agentique permet aux entreprises de créer des workflows sophistiqués où l’IA ne se contente plus de répondre mais devient un acteur à part entière des processus métiers, capable de piloter d’autres agents, d’interroger des bases de données ou de gérer des actions opérationnelles.

Toutefois, la tendance accrue aux hallucinations de ces modèles ouverts, reconnue par OpenAI lui-même, nécessitera une vigilance particulière et des stratégies de mitigation robustes. Néanmoins, une forte personnalisation de ces modèles devrait considérablement limiter les risques d’hallucination. Et cela tombe bien puisqu’OpenAI a tout fait pour simplifier l’alignement de ces modèles aux besoins métiers.

La personnalisation comme facteur différenciant

Car la véritable valeur ajoutée des modèles gpt-oss réside dans leur capacité de personnalisation. L’option de full-parameter fine-tuning autorise un réentraînement complet ; le ton, le style de rédaction ou la profondeur d’analyse peuvent être alignés sur la culture maison, un domaine d’expertise ou un jargon sectoriel. Les entreprises peuvent ainsi moduler l’« effort cognitif », équilibrer latence et qualité, et décider quand déléguer une tâche à une IA Cloud externe – par exemple la génération d’images ou la recherche documentaire. Cette adaptabilité va bien au-delà d’un simple ajustement cosmétique : elle permet de spécialiser le modèle dans des domaines hautement techniques comme le médical ou le juridique, d’adapter le style de communication aux standards de l’entreprise, et même de moduler la profondeur de raisonnement selon les contextes d’usage.

Un écosystème partenaire déjà mobilisé

OpenAI a manifestement préparé minutieusement le terrain avant cette annonce. La disponibilité immédiate des modèles sur Hugging Face, accompagnée de guides officiels détaillés, témoigne d’une volonté d’adoption rapide que confirme l’accessibilité des ressources via GitHub mais aussi son intégration à Ollama pour faciliter une exécution locale. Surtout, OpenAI a soigné ses partenariats stratégiques avec des grands acteurs du cloud comme Azure et AWS via leurs plateformes respectives AI Foundry et Bedrock, mais aussi Snowflake, garantissant une intégration fluide dans les environnements existants. La présence d’Orange Business parmi les partenaires de lancement est aussi un signal fort envoyé au marché européen. L’opérateur français annonce un déploiement « Jour 1 » dans ses infrastructures de confiance (Orange Cloud Avenue et son service Live Intelligence) pour des usages souverains, répondant ainsi aux préoccupations spécifiques du marché franco-européen en matière de protection des données et de souveraineté numérique.

Pour les DSI et leurs équipes Data Science, l’arrivée des modèles gpt-oss redessine l’équation économique et stratégique de l’adoption de l’IA en offrant à tous la quasi-puissance d’un modèle propriétaire. L’opportunité est double : accélérer l’innovation en rapprochant l’IA des données internes et négocier à la baisse les budgets liés aux appels API. Elle s’accompagne toutefois d’exigences nouvelles, tout au moins pour les DSI qui n’ont pas déjà adopté des modèles open-source et continuent de faire exclusivement confiance aux grands modèles propriétaires dans le Cloud : bâtir une chaîne MLOps robuste, former les équipes à la personnalisation de modèles massifs, instituer des contrôles de conformité continus et mesurer le coût total de possession dans la durée.

L’entrée d’OpenAI sur le marché des modèles open weight intensifie une compétition déjà féroce où s’affrontent géants technologiques (IBM avec Granite-3.2, Microsoft avec Phi-4, Google avec Gemma, Meta avec Llama-4, Alibaba Cloud avec Qwen 3) et startups innovantes (MistralAI, DeepSeek, MoonShot AI, etc.). Dans ce paysage en mutation rapide, les DSI doivent désormais trouver comment naviguer entre les promesses de l’autonomie technologique et les réalités opérationnelles de sa mise en œuvre. Le succès de cette transition dépendra moins de la technologie elle-même que de la capacité des organisations à développer les compétences, les processus et la culture nécessaires pour exploiter pleinement le potentiel de ces nouvelles architectures ouvertes. L’ère de l’IA d’entreprise véritablement personnalisable et souveraine ne fait que commencer, et les modèles « gpt-oss » d’OpenAI pourraient bien en être de nouveaux catalyseurs. Surtout si OpenAI continue à les faire progresser régulièrement. Reste que l’arrivée de ces deux modèles est un vrai bouleversement dans l’univers de l’IA ouverte jusqu’ici largement dominé par Meta et Mistral AI.

À LIRE AUSSI :

À LIRE AUSSI :