DOSSIERS

Pourquoi le big data ne tient pas encore ses promesses

Par La rédaction, publié le 15 mai 2013

Tout connaître de ses clients, prédire l’avenir de l’entreprise… voilà qui a de quoi séduire. Mais le concept de big data reste difficile à comprendre. Et encore plus complexe à mettre en œuvre.

Les technologies sont là, pas les hommes. Matteo Pacca, du cabinet McKinsey, est l’un des plus fervents partisans du big data. Depuis deux ans, il sillonne les conférences internationales pour vanter les bénéfices que tireront les entreprises du traitement massif de données informatiques et démontrer, prévisions à l’appui, qu’il deviendra pour elles le moyen ultime de se différencier. Pourtant, pour la première fois, en ouverture du dernier salon parisien consacré au big data, son discours si volontaire laissait planer comme un léger doute.

Du bout des lèvres, il s’est rendu à l’évidence : les acteurs ne savent pas encore tirer parti du concept. Ils ont même du mal à dire en quoi celui-ci pourrait les aider. “ Un cabinet de recrutement m’a contacté car il recherchait des profils de responsables de données (Chief Data Officer – NDLR) pour l’un de ses clients désireux de se lancer, expliquait-il en ouverture du salon. Mais ni le cabinet ni la société concernée n’étaient en mesure de définir précisément le contour de ce poste. ”

Une anecdote qui résume l’énorme décalage entre l’incompréhension des entreprises envers ce qu’est le big data et l’ultramédiatisation d’un phénomène qui fait la une des plus grands magazines américains (dont la prestigieuse Harvard Business Review). Aujourd’hui, de nouvelles technologies de traitement de données (Hadoop, bases NoSQL, Machine Learning) émergent, grâce auxquelles on peut analyser des volumes de données jamais égalés.

Ces fameuses données sont de plus en plus nombreuses : on connaît désormais le parcours des clients dans les magasins. On peut croiser cela avec des statistiques socio-économiques, ou la façon dont les internautes naviguent sur le Web, leur géolocalisation, les goûts qu’ils expriment sur les réseaux sociaux… Dès lors, il devient possible de cerner finement des comportements d’achat, de mesurer une qualité de service ou de calculer des risques. Les potentialités sont infinies, et les promesses immenses. Certaines villes américaines l’utilisent même pour déjouer les crimes avant qu’ils ne surviennent, comme dans le film Minority Report.

Le big data affiche des prévisions de croissance de 15 à 20 % par an, à faire pâlir les autres segments du secteur numérique. Ne pas y aller, c’est se priver d’un fantastique outil. Mais comment faire ? Il existe au moins cinq raisons pour lesquelles les organisations rechignent à se lancer dans l’aventure.

1. Les compétences nécessaires sont encore rares

Savoir tirer parti d’un nombre considérable d’informations disparates exige une triple sensibilité : il est indispensable d’aimer la statistique et l’informatique, et de connaître les besoins de la personne à laquelle on s’adresse (responsable marketing, commercial…). Autant le dire, ces profils polyvalents (baptisés Data Scientists) sont très recherchés. Leur rôle : déterminer les variables qui comptent, se poser les bonnes questions et repérer les tendances anormales (fraudes, dysfonctionnement de site Web, etc.).

Le tout en maîtrisant les nouvelles techniques de programmation indispensables pour extraire les informations pertinentes… “ Les quelques profils couvrant l’étendue du spectre émargent entre 1 500 et 1 800 euros par jour, contre 1 200 pour un prestataire classique. Rares sont les entreprises prêtes à payer ce prix. Et lorsqu’elles les font intervenir, c’est seulement pour une opération commando ”, explique Jeremy Harroch, fondateur de Quantmetry, spécialisé dans l’analyse de données.

Face à cette pénurie, les sociétés n’ont pas d’autre choix que de miser sur certains profils internes et de leur faire acquérir les compétences qu’ils n’ont pas. Elles se tournent alors vers les Dataminers. L’essor du big data obligera ces statisticiens, historiquement spécialisés dans la segmentation des clients, à revoir leurs méthodes de travail. “ Ne serait-ce qu’en raison du nombre bien plus élevé de variables qu’ils manipuleront ”, précise François de Charon, directeur de la stratégie digitale d’Ysance (conseil) et ancien directeur marketing de Pagesjaunes.fr.

Ils devront se rapprocher des responsables opérationnels de leur société. Et rendre leurs calculs prédictifs compréhensibles, même par un nul en maths. Cela les amènera à comprendre le cycle de vie des produits ou services pour lesquels ils travaillent. “ Et à s’initier à de nouveaux outils de visualisation sous forme de tableaux de bord, simples à comprendre ”, précise René Lefébure, directeur R&D de Conexance (étude des données clients).

Pourtant, il n’y a pas lieu de céder au pessimisme. Florien Douetteau, fondateur de Dataiku, cabinet de conseil dédié au big data, croit beaucoup à l’afflux de sang neuf, issu notamment de nouveaux masters spécialisés comme celui de Bretagne Télécom. Par ailleurs, “ les entreprises pourront s’appuyer sur les compétences pointues des anciens analystes de la finance, qui désertent de plus en plus ce secteur ”.

2. Les responsables opérationnels restent difficiles à convaincre

Les rares projets français de big data émanent soit d’une direction informatique, soit d’une cellule innovation. Dans tous les cas, il s’agit de techniciens qui ont d’abord lancé une initiative avant de tenter de convertir leurs directions métier. Quitte à s’arracher parfois les cheveux. “ Pour les responsables opérationnels auxquels nous avons proposé de nouveaux services liés à la géolocalisation, nous faisions figure de poil à gratter, sourit Mathieu Gras, en charge du big data chez SFR. Nous avions du mal à expliquer notre démarche, car c’était à eux d’imaginer les applications concrètes… ”

De la même façon, chez Bouygues Telecom, c’est d’abord la DSI qui a déployé la technologie de traitement de données, baptisée Hadoop. Elle souhaitait mesurer la qualité de services de ses sites Web et comprendre comment améliorer les temps de réponse des pages. Son expérimentation a rapidement séduit d’autres branches de l’organisation, qui ont profité de l’aubaine. Le service client s’appuie aujourd’hui sur la même plate-forme et les mêmes données pour optimiser le parcours des internautes sur les différents sites du groupe.

3. Toutes les données ne sont pas exploitables

Si les données existent en masse, rares sont celles directement exploitables en l’état. Et c’est un vrai problème, car il est alors nécessaire de les retraiter, ce qui engendre des surcoûts souvent négligés lors de la définition du projet. “ Les données tirées des réseaux sociaux ou celles reflétant l’activité des internautes sur les pages Web (on parle alors de logs) demandent à être un minimum nettoyées ”, précise Florian Douetteau. Certes, ce sujet de la qualité de la donnée n’est pas nouveau. “ Ce qui l’est, c’est le volume à traiter dans des temps toujours plus courts ”, poursuit le créateur de Dataiku.

Autre chantier souvent sous-estimé : parvenir à mettre en relation des informations piochées à différents endroits. “ C’est très bien de les stocker en masse, lance Serge Boulet, responsable marketing chez l’éditeur SAS. Mais comment, par exemple, rapprocher autour d’un même client des données résultant d’une navigation Web, d’une géolocalisation ou d’un ticket d’appel ? L’opération n’a rien d’évident. ”

4. La rentabilité des projets n’est pas toujours au rendez-vous

La question du retour sur investissement semble presque incongrue pour les partisans du big data, dont la devise pourrait être : “ Investissez d’abord, vous trouverez bien à l’utiliser ensuite. ” En effet, seule l’exploration des données disponibles permet de déduire a posteriori les questions intéressantes et les futures applications. En temps de crise, un tel message a de quoi rebuter les directions générales. “ Aucune solution miracle ne garantit la rentabilité d’un projet de big data, concède Frédéric Brajon, associé chez CGI Business Consulting (ex-Logica). Il faut tester les idées dès qu’elles apparaissent pour identifier très vite celles qui méritent d’être creusées. C’est un changement de méthodologie ”.

Pour ajouter à la confusion, tous les fournisseurs, même ceux qui ne proposent pas de nouvelles technologies, ont inondé le marché avec des messages marketing ciblés sur le big data. Jusqu’à l’écœurement… “ Bien des acteurs ont profité de cette vague pour repackager des solutions des années 70 ! Ce qui a, évidemment, créé une désillusion proportionnelle à l’engouement suscité ”, déplore Jean-Baptiste Dezard, responsable marketing logiciel d’IBM.

Heureusement, tous les freins existants n’ont pas empêché certains profils d’entreprise de plonger dans ce nouvel univers. Notamment les start up, dont le modèle de développement repose précisément sur la prédiction des comportements des consommateurs. Ou encore les opérateurs téléphoniques, à la recherche éperdue d’un élément différenciant pour se distinguer d’une concurrence féroce. Mais à moins d’y être contraintes (voir encadré), la plupart des organisations mettront, selon les experts, entre trois et quatre ans avant de faire le grand saut dans le big data.

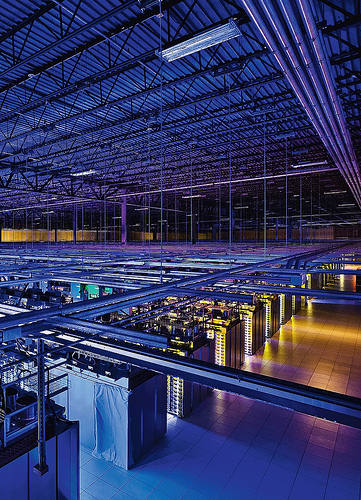

Crédit photos : Google.

Les dirigeants français sont réticents à se lancer

“ Les entreprises ne sont pas encore demandeuses d’analystes de données ”

La demande des sociétés en analystes de données croît-elle ?

Oui, depuis un an. Mais uniquement au sein des cabinets de conseil et des SSII qui anticipent la conduite de futurs projets big data. Côté entreprise utilisatrice, nous n’avons constaté aucun besoin particulier.

Quel est le profil des analystes recherchés ?

On exige d’eux qu’ils sachent utiliser les logiciels décisionnels. Ils doivent être capables de descendre assez profondément dans les bases de données. L’idée étant, ensuite, de les faire évoluer vers les deux volets du big data encore mal traités : la gestion des gros volumes et celle des contenus non structurés.

Où va-t-on les chercher ?

Principalement dans les autres SSII, et, dans une moindre mesure, chez les éditeurs spécialisés dans les logiciels décisionnels. Ces candidats, via leurs missions, ont pu connaître divers secteurs. Ils réalisent alors un bond de salaire important, de 15 %.

3 questions à Marlène Ribeiro, directrice au sein de la division système d’information chez Michael Page.

Le big data a séduit Crédit mutuel Arkéa

Hier, vingt-quatre heures. Aujourd’hui, quinze minutes. C’est le temps que met désormais Suravenir pour simuler les sommes à provisionner sur trente ans pour ses quelque 2 millions d’emprunteurs. Et ce, conformément aux exigences de la directive Solvency 2 garantissant la solvabilité des assureurs. La branche assurance prévoyance de Crédit mutuel Arkéa exploite Hadoop, une technologie phare du big data. “ Nous voulions pouvoir réaliser plusieurs fois par jour des simulations en jouant sur des variables comme les mesures fiscales ou les lois sur le rachat anticipé de prêt, détaille Julien Le Calvez, actuaire et responsable du déploiement de Solvency 2. Notre progiciel n’offrait pas cette souplesse. ” Ses calculs étaient limités à 20 000 dossiers à la fois, contre 200 000 avec le nouveau système. Sur le plan technique, Suravenir s’est appuyé sur l’un des meilleurs spécialistes français d’Hadoop, Matthias Herberts. Son équipe (au sein de la DSI de Crédit mutuel Arkéa) a d’abord monté la plate-forme big data. Elle a ensuite cherché à convaincre les opérationnels de l’utiliser. La collaboration avec Suravenir a été facilitée grâce aux compétences de ses actuaires en statistique et en développement, qui sont indispensables pour exploiter au quotidien les données dans le système Hadoop.