Data / IA

Ajuster le système d’information «data» aux métiers

Par La rédaction, publié le 05 octobre 2022

À transformation des besoins, transformation des traitements

Les architectures de données déployées lors de la grande vague du big data des années 2010 arrivent à leurs limites. Face aux besoins d’agilité des métiers, la montée en puissance du cloud public rebat heureusement les cartes.

Depuis quelques décennies, le pilotage des entreprises par les données, le modèle « data driven » s’est imposé dans toutes les grandes organisations. Depuis les systèmes opérationnels, jusqu’au pilotage tactique via des dashboards, aux prises de décisions stratégiques, les données constituent désormais le pivot du management. L’étude Capgemini Research « The data-powered enterprise » a montré qu’en 2020, 50 % des entreprises interrogées estiment être désormais dans une organisation « data driven ». Elles étaient seulement 38 % en 2018.

De facto, depuis les années 1990-2000 jusqu’à aujourd’hui, les DSI se sont attachées à amasser et délivrer les données les plus pertinentes possibles aux décideurs. Ce fut dans un premier temps la constitution des premiers data warehouses ultra-structurés et optimisés alors que le stockage et le traitement du moindre mégaoctet de données valait son pesant d’or. La grande vague du décisionnel, avec ses univers business objects et les premiers outils de data mining ont permis la diffusion d’une culture du dashboard et du reporting à l’échelle de toute l’entreprise. L’approche statique du reporting s’est peu à peu enrichie pour aller vers plus de souplesse et de capacités d’analyse, notamment avec l’arrivée de solutions in memory.

Les limites de l’approche « big data »

La grande vague du big data des années 2010 est venue enrichir ce travail de fond. En faisant voler en éclats les limites en termes de capacités de stockage et de puissance de traitement, les technologies de nouvelle génération issues des GAFAM ont ouvert les entreprises à la culture des algorithmes et, quelques années plus tard, à l’intelligence artificielle.

Les grandes entreprises ont rapidement construit de vastes data lakes pour centraliser les données issues de leurs entités métiers et mis en place des « data factories » (des usines à données) pour les exploiter. Néanmoins, les architectures monolithiques imaginées il y a une dizaine d’années montrent aujourd’hui leurs limites. Faire converger les données vers un data lake permet d’espérer des économies d’échelle et une mutualisation des moyens techniques, mais les cas d’usage de la data sont très différents et imposent une grande diversité de technologies. Hadoop et son approche batch est loin de pouvoir répondre à tous les besoins. Certains traitements nécessitent plus de réactivité et de calculs in-memory ; certains flux de données doivent être traités en quasi temps réel ; et les data sciences ont ajouté une couche de complexité supplémentaire avec leur lot de technologies dédiées. Christophe Vaudable, responsable de la data chez un gros acteur du commerce B2B, souligne : « La question est aujourd’hui de savoir comment casser ces monolithes qui sont devenus inmaintenables et difficiles d’accès pour les métiers. L’idée est d’aller vers de plus petites unités bien plus agiles et plus proches des équipes data et de business analysts, mais aussi des métiers. Ce sont des réflexions en cours. »

Face à l’approche monolithique du data lake, la grogne des métiers engagés dans leur transformation digitale monte. La centralisation des ressources sur une data factory entraîne d’une part un allongement des backlogs et l’insatisfaction des utilisateurs qui doivent attendre leur tour pour voir leurs projets data se concrétiser. D’autre part, la responsabilité de la donnée et du maintien de son niveau de qualité ne peut qu’échoir aux métiers qui en ont la connaissance. La mise en place d’une gouvernance permet en principe de régler ce problème, mais une approche hiérarchique ne stimule pas la collaboration entre les divisions métiers et l’émergence d’innovations. Plus qu’une approche hiérarchisée, c’est une vraie approche décentralisée qui est en train de s’imposer peu à peu. « Le constat de fond est que l’architecture technique doit coller avec l’organisation fonctionnelle de l’entreprise, ajoute Christophe Vaudable. Il faut mettre en place une architecture data très décentralisée et agile, spécialisée par grands domaines fonctionnels : la finance, la supply chain, la relation client, le marketing. Il faut en quelque sorte leur dédier des SI data adaptés à leur mode de fonctionnement. »

L’avenir est aux modèles data fabric et data mesh

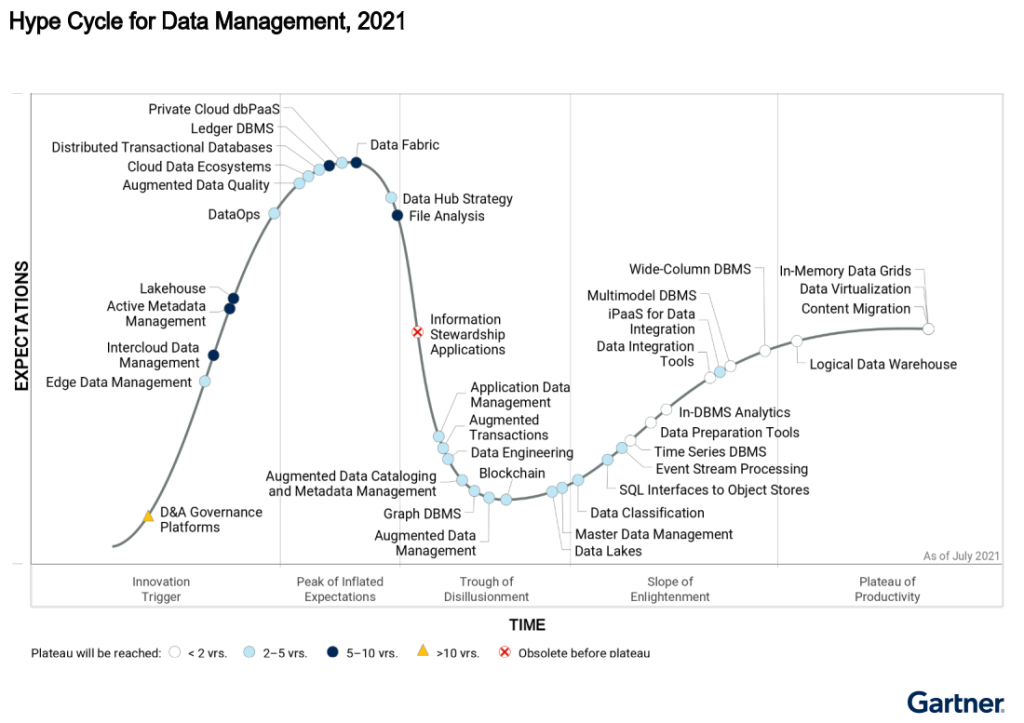

Face à cette demande des entreprises, de nouvelles architectures sont en train de monter en puissance. Le Hype Cycle du Gartner consacrait le modèle data fabric au sommet de la vague en 2021. Dans ce modèle, l’entreprise doit se doter d’un framework agnostique en termes de technologie, que ce soit avec le data warehouse « legacy », la brique big data, mais aussi des solutions « cloud native » de nouvelle génération. Selon les analystes de Gartner, ce modèle data fabric laisse espérer un accroissement de l’utilisation des données dans l’entreprise d’un facteur quatre, notamment en réduisant les tâches de manipulation de données manuelles de moitié.

Mais alors que ce modèle semblait faire consensus auprès des experts et des éditeurs, une nouvelle approche pourrait bien s’imposer dans les entreprises : le data mesh. Ce dernier a beaucoup de points communs avec l’approche data fabric, notamment une approche de « delivery » où les données sont proposées dans un mode « self-service » à leurs consommateurs potentiels. Mais, le data mesh reprend surtout à son compte les concepts des organisations agiles et met l’accent sur le rôle du data product owner, véritable porte-parole des données de sa division métiers auprès du reste de l’entreprise. Plus agile, plus décentralisée, la donnée n’en finit pas de se réinventer. À chaque CDO et DSI de piocher et d’implémenter les meilleures pratiques dans son organisation pour faire de la data un véritable levier de compétitivité et de différenciation.

TÉMOIN – LOBNA KAROUI, stratégiste et architecte data chez Capgemini

« Une réelle appétence des entreprises pour le data mesh »

« La majorité des entreprises ont encore aujourd’hui des architectures que j’appellerais “historiques”. Celles-ci ont des entrepôts de données avec des solutions qui ont bien évolué, elles ont aussi mis en place des infrastructures data un peu plus centrées sur les usages métiers et les utilisateurs, mais nous avons remarqué ces douze derniers mois une réelle appétence pour ce que l’on appelle le data mesh, notamment dans le secteur bancaire. J’ai personnellement déjà accompagné deux acteurs du secteur bancaire sur la mise en place de ce type d’architecture de données pour leurs métiers. »