Data / IA

Ajuster le système d’information «data» aux métiers

Par La rédaction, publié le 05 octobre 2022

De nouvelles approches pour briser les limites du data lake

Data lake virtuel ou bien « as-a-Service… », de nouveaux modèles d’architecture sont apparus ces dernières années afin de réduire, voire d’éliminer, les inconvénients liés au data lake central. L’accès aux données s’en trouve simplifié pour les utilisateurs métiers.

Le modèle centralisé du data lake montre aujourd’hui ses limites, notamment pour les métiers. Alors que son objectif était de casser les silos de données, il en est devenu un lui-même pour ces utilisateurs. Ceux-ci doivent désormais passer par la data factory pour obtenir leurs extractions de données et les bonnes analyses. Leurs requêtes s’accumulent dans un backlog où, à l’heure de la transformation digitale, tous les projets data se bousculent.

Le data lake virtuel gagne des adeptes

La mise en place d’un data lake centralisé implique de créer des flux de données convergents pour l’alimenter, ce qui demande un gros investissement initial et induit beaucoup de rigidité. Bien souvent, les équipes data doivent réaliser des extractions pour les métiers et renvoyer des données pour répondre à tel ou tel besoin ponctuel. L’idée de virtualiser le modèle de données a peu à peu émergé afin de limiter ces transferts de données. Casser les silos de manière logique en intégrant les sources de données virtuellement, c’est l’idée de la virtualisation du modèle de données.

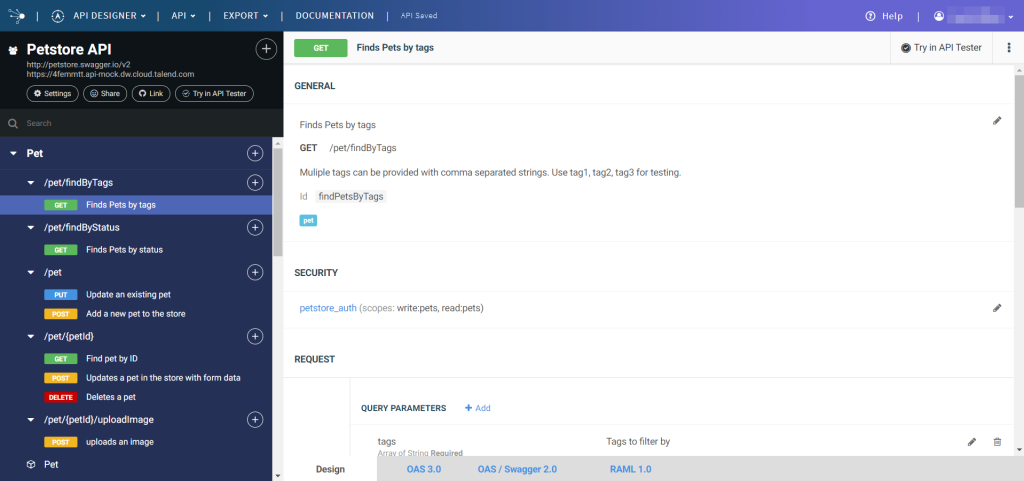

Les solutions de data fabric à l’image de l’offre Talend et son module Talend API Services offrent un moyen de partager et éventuellement de monétiser les données de l’entreprise.

Des entreprises comme Suez ou Coface ont opté pour cette approche avec un certain succès avec la solution Denodo. Samia Boujatioui, head of data processing de Coface, explique ce choix : « Nous avons une dizaine de référenciels de données, avec les données commerciales, contractuelles, les données liées aux risques… Il s’agit d’informations classiques dans le monde de l’assurance-crédit. Nous devons les valoriser et surtout en faciliter l’accès aux utilisateurs finaux. Pour y parvenir, nous avons choisi de nous appuyer sur une architecture hybride qui reprend la notion de virtual data lake. » L’entreprise a rapidement écarté l’option de déployer des data lakes physiques dont le ROI était jugé trop faible et qui posaient des contraintes de duplication des données et des limites en termes de gouvernance.

Le cloud, l’outil idéal pour partager des données

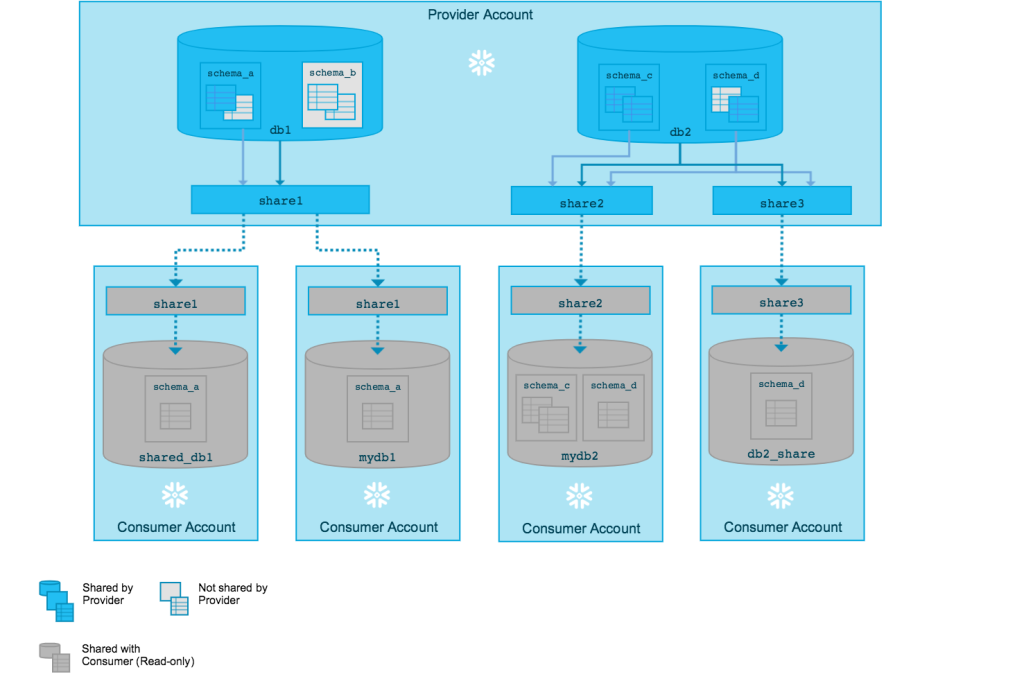

Un autre moyen d’introduire un peu plus de souplesse au modèle data lake est apporté par les solutions de nouvelle génération dans le cloud. Disposer d’une solution de Data-Lake-as-a-Service permet de créer très rapidement des environnements, mais aussi d’accorder des accès à des domaines métiers bien plus simplement. Ridha Nabli, IT head of data chez TotalEnergies, souligne l’atout de la base de données Snowflake : « La solution n’est pas silotée : il ne s’agit pas de baies de stockage installées dans le Cloud, mais d’un stockage centralisé. Nous avons la capacité de requêter entre plusieurs domaines sans les contraintes liées à un silotage des données. » Autre atout de poids pour Snowflake, sa fonction de data sharing. « Il s’agit certainement de l’un des points les plus importants de la solution : on peut partager de la donnée sans la déplacer : nos partenaires ou d’autres filiales du groupe peuvent accéder à nos données une fois qu’on leur a donné l’autorisation. C’est un élément important car on passe notre temps à faire des extractions, mettre en place des API, le data sharing est une alternative. »

La fonction de data sharing poussée par Snowflake doit faciliter la collaboration sur les données sans devoir les transférer auprès des métiers ou de partenaires de l’entreprise.

Autre entreprise à avoir fait le choix de cette solution de nouvelle génération, Emeria (anciennement Foncia Group). Florent Seine, chief data officer, explique la stratégie data du groupe : « Notre futur ERP sera une source de données parmi d’autres, au même titre que les applicatifs support, RH ou finance, ou encore des données externes collectées auprès de nos différents prestataires (marketing ou autres…). Dans un premier temps, les données sont chargées dans une zone Snowflake où elles sont stockées au format brut, puis elles arrivent dans une seconde zone où elles sont traitées et agrégées de manière limitée. Cette zone est ouverte aux utilisateurs métiers chevronnés. Enfin, une troisième zone ne contient que des données affinées : elle est accessible aux utilisateurs métiers via leur outil de dataviz Tableau. » Toutes ces données sont soigneusement référencées dans Talend Data Catalog, une fonction de catalogue de données qui joue un rôle-clé pour faciliter l’accès aux données par les métiers.

Avec l’arrivée de solutions de type data fabric incluant la gestion de multiples sources de données et du stockage, des capacités de gouvernance et de mise en qualité des données et enfin, la mise à disposition des données via des API, les architectures de données se veulent de plus en plus souples et agiles. Pour autant, c’est une révolution bien plus profonde à laquelle doivent se préparer les entreprises : celle du data mesh.

SAMIA BOUJATIOUI, head of data processing de Coface

Transformer les univers business objects en “business views”

« Un data lake virtuel, c’est un data lake logique qui comprend plusieurs systèmes de livraison de données. Une approche qui évite d’avoir à gérer divers systèmes de livraison. L’architecture est hybride ; on ne peut pas faire du 100 % virtuel. Nous faisons cohabiter des data warehouses classiques, les ETL des systèmes décisionnels, mais en parallèle nous avons créé des virtual data warehouses qui s’appuient sur la technologie Denodo. Cela permet d’avoir une meilleure vision sur les données décisionnelles sans devoir faire de réplications de données. Nous comptons à ce jour une douzaine de cas d’usage sur notre virtual data lake, dont certains sont hybrides. À partir de 2023, nous entamerons certaines refontes, notamment certains dashboards qui sont particulièrement complexes. Nous allons reprendre les univers business objects afin de les transformer en “business views” au sens Denodo du terme. »

TÉMOIN – FLORENT SEINE, chief data officer d’Emeria (anciennement Foncia Group)

Rendre les métiers de plus en plus autonomes sur leurs données

« Notre nouvelle stratégie data est clairement orientée vers les métiers et, pour porter cette stratégie, nous avons opté pour une plateforme de données de technologies modernisées. Celle-ci se base sur la solution cloud Snowflake alimentée par une plateforme de change data capture de Fivetran qui vient connecter nos applicatifs à la plateforme data. Parmi les atouts de la solution Snowflake figurait sa capacité de bien cloisonner les données, afin que chaque métier ait la visibilité sur ses propres données. Actuellement, toutes les requêtes issues des métiers concernant les données sont traitées par mon équipe, mais notre objectif à terme est de rendre les métiers autonomes sur leurs données. L’équipe data pourra alors de plus en plus se concentrer sur les volets techniques d’intégration et de traitement des données, mais aussi sur les algorithmes d’IA qui commencent déjà à générer de la valeur pour le groupe. »