Data / IA

Anthropic lance Claude 3 et AWS prend les devants !

Par Laurent Delattre, publié le 05 mars 2024

Anthropic a lancé sa nouvelle famille de LLM « Claude 3 » aux performances annoncées comme supérieures à Google Gemini et GPT-4 d’OpenAI. AWS est le premier des grands clouds à les proposer via son API Bedrock et le fait savoir.

Qu’on le veuille ou non, que ça fasse plaisir aux politiciens européens ou non, que ça rassure Elon Musk ou non, l’IA générative est une affaire de gros bras, de gros biscotos technologiques et financiers. Et Mistral AI l’a bien compris. Il ne suffit pas d’avoir un bon, voire le meilleur modèle, il faut aussi avoir les gros bras pour l’entraîner, l’exécuter, le commercialiser. D’où l’accord de Mistral AI avec Microsoft, qui semble énerver tant de monde sur les réseaux sociaux et dans les sphères politiques, mais qui est avant tout très bien joué de la part de la jeune pousse française. Quel meilleur partenaire pour adresser les entreprises partout en Europe et dans le monde pouvait-elle vraiment trouver (d’autant que, rappelons-le, les accords avec Azure n’ont rien d’exclusif) ?

Et pour ceux qui doutent encore de cette guerre de gros bras, rappelons que AWS a investi l’an dernier 4 milliards de dollars dans Anthropic (jeune pousse américaine en vogue) juste pour pouvoir, en ce mois de mars, claironner avant tout le monde disposer du « meilleur LLM » avec Claude 3.

AWS en quête de visibilité

Car Anthropic, qui a reçu plus de 7 milliards de dollars de ses multiples investisseurs depuis 2021, vient d’officialiser la troisième génération de son LLM « Claude ». Un lancement réalisé en grande pompe sur le site d’Anthropic bien sûr mais aussi sur AWS (via le service API Bedrock) trop heureux d’enfin disposer d’une arme lui permettant de vraiment exister dans l’univers de l’IA générative.

Même si, finalement, cette disponibilité AWS est loin d’être exclusive ! La nouvelle famille de modèles « Claude 3 » est en effet disponible dès aujourd’hui via la plateforme API d’Anthropic mais aussi sur le cloud de Google via Vertex AI, même si cette disponibilité est pour l’instant restreinte aux partenaires de confiance de Google Cloud.

3 modèles pour des besoins différents

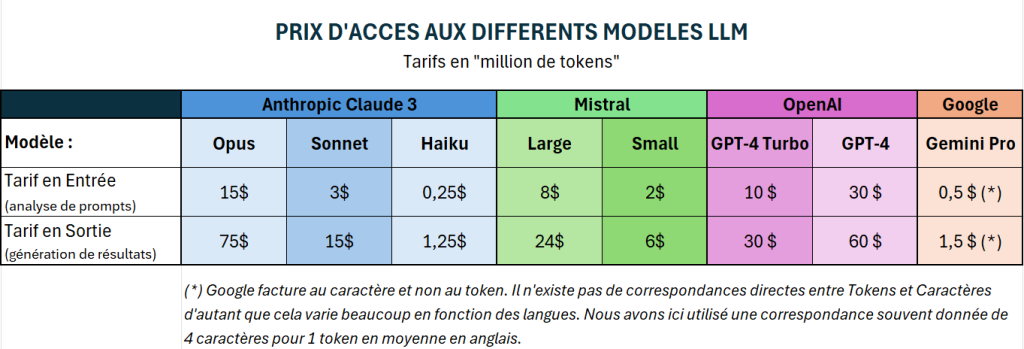

Ici, on parle bien de famille de modèles. Car, à l’instar de Mistral AI qui décline son dernier modèle en versions « Large », « Small » et « Next » ou Google Cloud qui décline Gemini en versions Ultra, Pro et Nano, Anthropic décline Claude 3 en version Opus (la plus avancée, multimodale et la plus onéreuse), Sonnet (accessible gratuitement via son chat Claude.AI) et Haiku (pour des besoins définis nécessitant un LLM peu onéreux et ultra rapide).

Selon Anthropic, Opus est particulièrement adapté à l’analyse avancée, aux besoins stratégiques, à l’automatisation de tâches, au développement intéractif, à l’analyse visuelle, à la R&D, aux usages scientifiques.

Sonnet de son côté est idéal pour tout ce qui est recherche d’informations, RAG, recommandations, usages marketing et ventes, génération de code, contrôle qualité.

Enfin, Haiku, serait pensé pour toute interaction nécessitant une réponse immédiate, la traduction en temps réel, les interactions Live, la modération de contenus automatisée, l’optimisation des coûts des tâches IA.

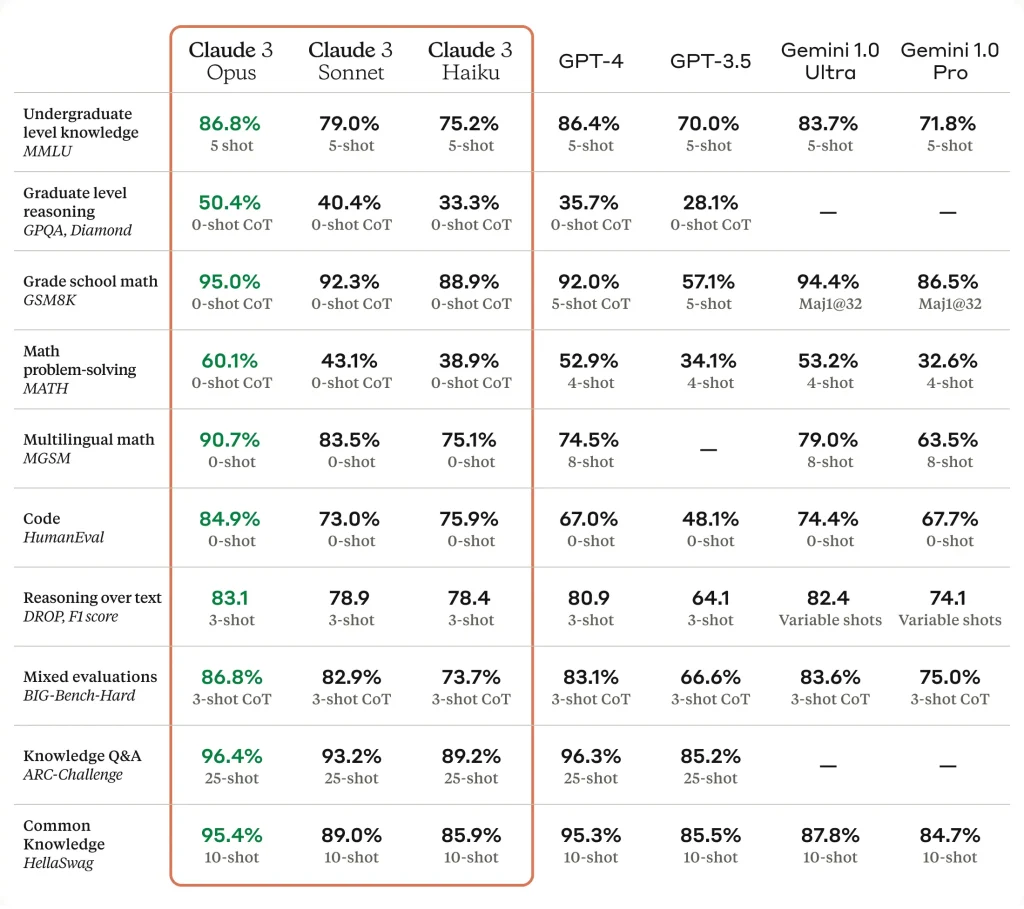

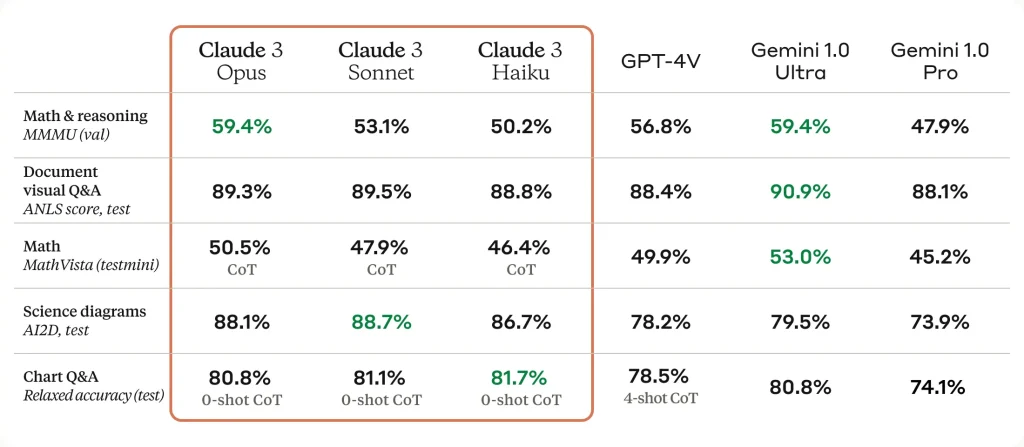

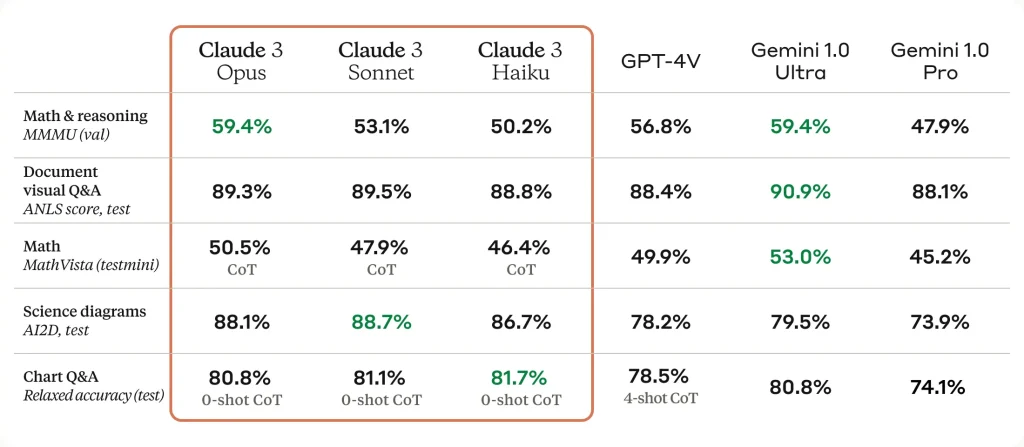

Opus domine les benchmarks

Si « Claude 3 » fait tant parler de lui cette semaine, c’est parce que – si l’on se fie aux résultats communiqués par Anthropic – Claude 3 Opus se montrent supérieur à GPT-4V et Gemini Ultra sur de nombreux benchmarks.

« Opus, notre modèle le plus intelligent, surpasse ses pairs sur la plupart des critères d’évaluation courants pour les systèmes d’intelligence artificielle, y compris les connaissances d’expert de premier cycle (MMLU), le raisonnement d’expert de deuxième cycle (GPQA), les mathématiques de base (GSM8K), et bien plus encore. Il présente des niveaux de compréhension et de fluidité proches de ceux de l’homme pour des tâches complexes, ce qui le place à la pointe de l’intelligence générale » écrit Anthropic dans son blog d’annonce. « Tous les modèles Claude 3 présentent des capacités accrues en matière d’analyse et de prévision, de création de contenu nuancé, de génération de code et de conversation dans des langues autres que l’anglais, comme l’espagnol, le japonais et le français ».

Bien sûr, le problème de ce genre de Benchmarks, c’est qu’à partir d’un certain moment ces tests sont si importants pour le marketing et pour prouver la valeur des produits – que les modèles (et la façon de les interroger) finissent par être optimisés pour bien figurer dans ces tests sans pour autant se montrer supérieurs sur les cas d’usage bien réels. Ce n’est pas forcément ici le cas, mais les prompts ont au moins été optimisés pour tirer le meilleur des Claude 3.

L’un des freins actuels pour évaluer Claude 3, c’est que le service conversationnel d’Anthropic, « Claude.ai », n’est pas accessible aux membres de l’Union Européenne. Le respect du RGPD et du DSA imposent la prudence aux acteurs américains. Du peu que l’on a pu évaluer « Claude 3 » en Français (et uniquement sur Sonnet), via un VPN, le modèle s’est montré très convaincant. Sur certains prompts de reformulation et d’écriture, il nous a même semblé un peu meilleur que GPT-4 Turbo et Mistral Large aussi bien en termes de concision de la réponse, de pertinence de la réponse que de rapidité de la réponse. Il faudra voir à l’usage, sur le long terme et dans des cas très concrets et variés, ce qu’il en est vraiment.

D’autant que Claude 3 n’en est évidemment pas parfait. Comme ses congénères, il peut se tromper et peut être victime d’hallucinations. Si l’on en croit les benchs d’Anthropic, le modèle le plus évolué est même plus enclin à l’hallucination que les deux autres versions.

Mais Claude 3 est aussi amené à s’améliorer. Anthropic précise que « nous ne pensons pas que l’intelligence actuelle du modèle soit proche de ses limites, et nous prévoyons de publier des mises à jour fréquentes de la famille de modèles Claude 3 au cours des prochains mois. Nous sommes également impatients de lancer une série de fonctionnalités pour améliorer les capacités de nos modèles, en particulier pour les cas d’utilisation en entreprise et les déploiements à grande échelle. Ces nouvelles fonctionnalités incluront l’utilisation d’outils (appel de fonction), le codage interactif (REPL) et des capacités d’animation d’agents plus avancées ».

Avec la sortie de Mistral Large la semaine dernière et celle de Claude 3 Opus cette semaine, la guerre des IA génératives connaît une nouvelle phase. Une guerre qui se joue aussi et même de plus en plus aussi sur le terrain des coûts. Google l’a d’ailleurs bien compris.

Clairement, les nouveaux venus font de l’ombre à ceux de Google et d’OpenAI notamment sur la manipulation de la langue française. Aujourd’hui la pression est en train de changer de camp. Face à ces nouveaux venus très pertinents et moins onéreux, comment OpenAI va réagir ? Est-ce que son GPT-5 sera significativement supérieur à GPT-4 et quand sera-t-il dévoilé ?

Si « ChatGPT Plus/Teams/Enterprise demeure » demeure un service plus évolué pour les utilisateurs en quête d’un chatbot pour accompagner leur quotidien, les modèles de Mistral et d’Anthropic sont clairement à expérimenter très sérieusement pour toutes entreprises en quête de modèles génératifs pour insuffler plus d’intelligence dans leurs processus et leurs applications métiers.

À LIRE AUSSI :