Secu

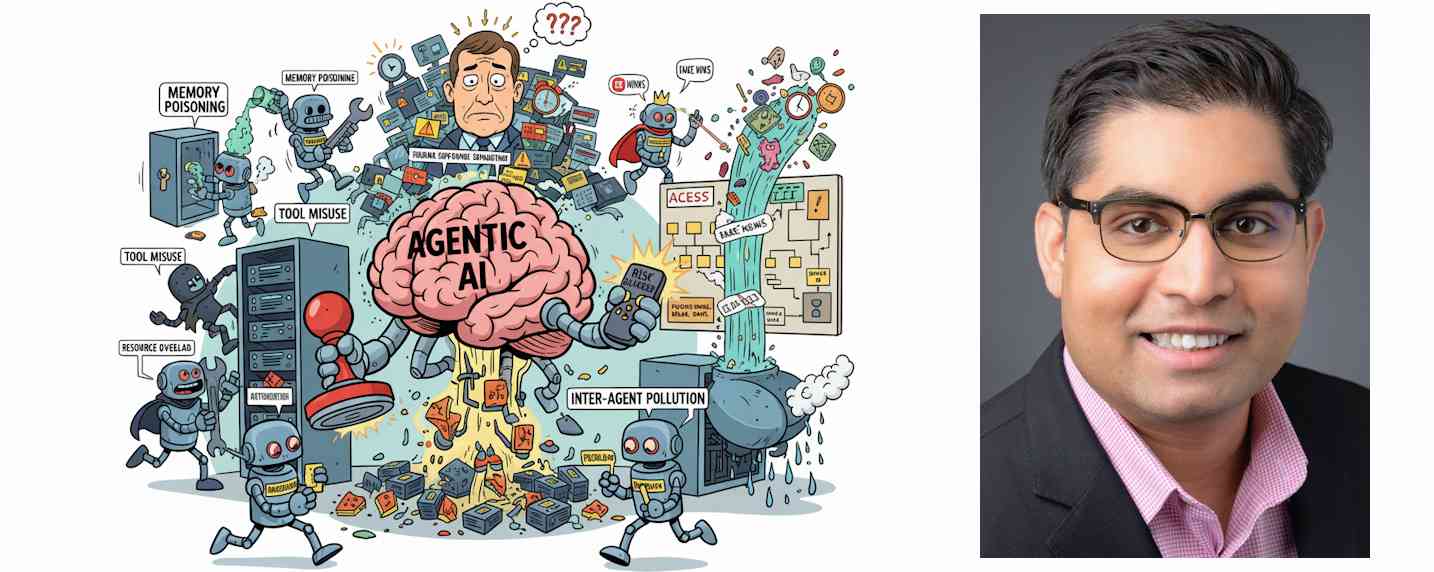

IA Agentique: comment se prémunir des 10 principaux risques cyber

Par Laurent Delattre, publié le 01 octobre 2025

La montée en puissance des systèmes agentiques place les entreprises face à des menaces inédites, où la prise de décision autonome devient elle-même un vecteur de risques. Anticiper ces dérives devient stratégique. Quand l’IA cesse de discuter pour commencer à décider et à agir, le terrain du risque s’élargit brutalement.

Par Saugat Sindhhu, Sr. Partner Global Head, Advisory Services Cybersecurity & Risk Services, Wipro

À l’approche des Assises de la cybersécurité, un enjeu gagne en importance au sein de l’industrie : la sécurisation de l’intelligence artificielle. Après avoir transformé les usages grâce aux grands modèles de langage (LLM), l’IA entre dans une nouvelle ère avec l’avènement d’agents autonomes capables de planifier, raisonner et agir sans intervention humaine directe.

Ces systèmes agentiques, porteurs d’un formidable potentiel d’innovation et de productivité, déplacent en profondeur le curseur du risque. Ils ne se contentent plus d’exécuter des instructions ou de traiter des données : ils prennent des initiatives, interagissent entre eux et s’adaptent à des environnements mouvants.

Cette autonomie, si elle ouvre la voie à des gains d’efficacité inédits, introduit aussi des vulnérabilités nouvelles que les cadres de gouvernance traditionnels ne suffisent plus à encadrer.

Les entreprises doivent désormais se préparer à affronter un spectre élargi de menaces, qui dépasse la seule protection des données ou la correction des biais, pour inclure les risques liés à la capacité même de ces agents à décider et à s’adapter.

L’IA agentique : le nouveau front des cybermenaces

Face à cette mutation rapide, les entreprises doivent apprendre à identifier les nouveaux vecteurs de risque liés à l’IA agentique. Au-delà des cyberattaques traditionnelles, ces systèmes introduisent des vulnérabilités inédites qui exigent des stratégies de défense adaptées. Voici 10 menaces critiques auxquelles se préparer dès aujourd’hui, ainsi que les leviers de protection pour y répondre :

1 – Empoisonnement de la mémoire :

Des données malveillantes peuvent être injectées dans la mémoire court ou long terme d’un agent afin d’altérer son contexte et ses décisions.

Défense : valider le contenu des mémoires, isoler les sessions, contrôler l’accès par authentification forte, détecter les anomalies et procéder à un nettoyage régulier.

2 – Usage malveillant des outils :

Des acteurs malveillants peuvent manipuler un agent pour détourner ses outils intégrés via des commandes trompeuses, tout en restant dans ses autorisations.

Défense : vérifier strictement l’accès aux outils, surveiller leur usage, fixer des limites d’opération et valider systématiquement les instructions données à l’agent.

3 – Compromission des privilèges :

Des failles dans la gestion des permissions peuvent permettre des actions non autorisées, notamment par héritage de rôles mal configurés.

Défense : instaurer des contrôles stricts des droits d’accès, valider les permissions à l’usage, surveiller les changements de rôles et auditer régulièrement les privilèges.

4 – Surcharge des ressources :

Les attaquants peuvent saturer les capacités de calcul, de mémoire ou de service d’un système, entraînant ralentissements et défaillances.

Défense : appliquer une gestion stricte des ressources, des mécanismes de mise à l’échelle adaptative, des quotas et une surveillance en temps réel, complétée par des politiques de limitation de fréquence.

5 – Attaques par hallucination en cascade :

En exploitant la propension d’une IA à générer des informations plausibles mais fausses, des erreurs peuvent se propager et fausser les décisions.

Défense : valider les sorties, appliquer des contraintes comportementales, croiser plusieurs sources et corriger en continu via des boucles de rétroaction, avec validation secondaire pour toute décision critique.

6 – Manipulation des intentions et objectifs :

Un hacker peut détourner la planification et la fixation d’objectifs d’un agent pour orienter ses actions.

Défense : recourir à des cadres de validation des plans, limiter les processus de réflexion, protéger dynamiquement l’alignement des objectifs et auditer les comportements pour repérer les déviations.

7 – Saturation des superviseurs humains :

Les systèmes reposant sur une validation humaine peuvent être submergés, exploitant les limites cognitives des opérateurs.

Défense : mettre en place des cadres avancés d’interaction humain-IA et ajuster le niveau de supervision en fonction du risque, du contexte et du degré de confiance.

8 – Pollution des communications inter-agents :

La manipulation des échanges entre agents peut propager de fausses informations ou perturber les flux de travail.

Défense : authentifier cryptographiquement les messages, appliquer des politiques de validation, surveiller les échanges et imposer un consensus multi-agents pour les décisions critiques.

9 – Agents compromis dans un système multi-agents :

Un agent compromis peut agir hors surveillance, exécuter des actions non autorisées ou exfiltrer des données.

Défense : limiter l’autonomie par des politiques contraignantes, surveiller en continu les comportements, tester régulièrement via du red teaming et contrôler les flux d’entrées/sorties.

10 – Vie privée :

L’accès massif aux données personnelles (emails, calendriers, activités en ligne, comptes tiers) accroît le risque de fuites en cas de compromission.

Défense : définir des politiques claires d’usage des données et des mécanismes de consentement robustes, garantir la transparence sur la prise de décision des agents et offrir aux utilisateurs des moyens d’intervention en cas d’erreur.

Ces menaces ne constituent qu’un aperçu des défis à venir. L’IA agentique ouvre des perspectives immenses pour les entreprises, tous secteurs et régions confondus, mais son déploiement doit être abordé avec rigueur et anticipation. Seule une gouvernance solide, conjuguant expertise technique, prudence et transparence, permettra d’en tirer pleinement parti tout en limitant les risques.

À LIRE AUSSI :

À LIRE AUSSI :