Opinions

Quand big data rime avec cloud computing

Par Stéphane Demazure, publié le 01 mai 2014

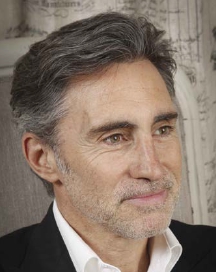

Régis Castagné

Directeur d’Interoute pour la France et la Suisse

Quand on lit la presse informatique, il est difficile d’échapper au concept de big data. Le big data est un concept à la mode qui puise son essence dans le traitement ultra rapide d’une grande quantité de données, extrêmement variées, créées chaque jour sur un nombre croissant de médias. La réalité est que nous assistons à une explosion de la production de contenus, les mobinautes en générant en temps réel avec les appareils photo de leurs téléphones et leurs accès internet. Pour les propriétaires des datacenters et des réseaux, il s’agit de gérer la quantité de données à stocker, à un rythme qui s’accélère. C’est un défi permanent quant à la rapidité à stocker, à traiter et à faire circuler les informations aussi diverses soient-elles (photos, vidéos, documents, etc.) entre les datacenters.

Le stockage et la génération de contenus ne coûtent pas cher de nos jours et nous avons tendance à ne rien vouloir supprimer, ce qui nécessite d’avoir une bonne capacité d’analyse de l’ensemble des données stockées dans le cloud pour donner son utilité à chacune. Concrètement, un grand « cluster » est construit pour traiter l’information, et sa taille change aussi rapidement qu’il est généré. Il faut donc une grande capacité de calcul pour l’analyser, et seule la répartition dans plusieurs datacenters pour des calculs parallèles le permet, d’où l’importance du cloud computing, autre thème à la mode.

Le Gartner prévoit que les particuliers hébergeront 36% de leurs données dans le cloud d’ici 2016, alors que le taux était de 7% en 2011. La pénurie de disques durs due aux inondations en Thaïlande aurait accéléré la tendance à l’hébergement dans le cloud au premier semestre 2012, selon le cabinet d’études, qui annonce que le contenu stocké dans le cloud devrait passer de 464 Go en 2011 à 3,3 To en 2016.

L’ arrivée du cloud computing, qui abaisse le coût du stockage, a créé une plateforme sur laquelle on peut contrôler le prix de base et créer un équivalent moderne du Grid Computing.

Pareillement, une analyse qualifiée de grandes quantités de données réparties entre plusieurs sites doit être proposée à des tarifs accessibles. Ce qui implique un accès à l’information à un coût raisonnable. Or, être propriétaire de son infrastructure permet à un opérateur de proposer la gratuité pour le trafic des données, alors que c’est ce qui alourdit d’habitude le prix du cloud.

En allégeant ainsi le coût de l’analyse qualifiée, on augmente l’impulsion actuelle vers le big data. Et l’on est alors en bonne position en regard des affirmations des analystes qui estiment que le big data est ce qui stimulera l’économie dans le futur…