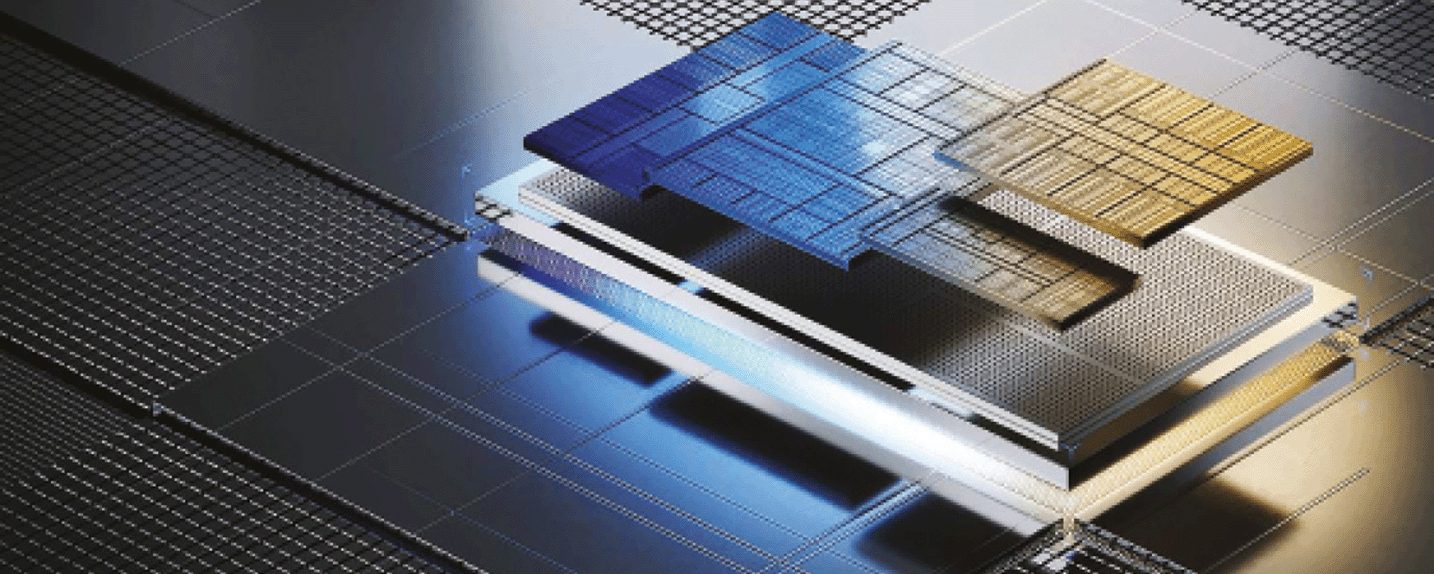

L’intelligence artificielle transforme radicalement le paysage technologique. Nécessitant des solutions de calcul intensif pour former et exécuter des modèles toujours plus complexes, elle est en passe de métamorphoser les architectures en multipliant les GPU et NPU. Un univers encore bien trop bouillonnant d’innovation pour faire preuve de maturité.

Selon Yann Le Cun, le célèbre patron français de l’IA chez Meta, « Il y a une guerre de l’IA, et Nvidia en fournit les armes ». De fait, en un an, portés par l’IA générative, le chiffre d’affaires de Nvidia a bondi de plus de 57 % et sa valorisation boursière de +450 % pour dépasser les 2.200 Md$. C’est plus de trois fois celles d’Intel et AMD réunies. Des chiffres qui illustrent à eux seuls l’actuel besoin en GPU et tout autre moyen d’accélérer l’IA. Aujourd’hui, il n’y a pas d’IA générative, de LLM, d’IA multimodale, sans une tonne de temps GPU pour entraîner les modèles, et des centaines de milliers de GPU pour répondre en quelques secondes à des prompts de millions d’utilisateurs. Une course à l’accélération de l’IA que Nvidia a su anticiper et gérer mieux que la concurrence et qui éclaire sous un jour nouveau non seulement l’importance des GPU au cœur des serveurs, des datacenters et des infrastructures cloud, mais aussi le besoin de développer d’autres pistes moins onéreuses et plus économes en énergie. Intel, AMD, et les acteurs du cloud, se sont lancés dans cette quête et développent des accélérateurs IA pour couvrir les...

CET ARTICLE EST RÉSERVÉ AUX ABONNÉS

Abonnez-vous dès maintenant

- ✓ Tous les articles d’IT for Business

- ✓ Le magazine mensuel en version numérique ou en version papier

- ✓ Les newsletters exclusives

Dans l'actualité

-

-

La cyberattaque sur Notepad++ : 5 leçons à en tirer pour DSI et RSSI

Laurent Delattre

3 Fév

-

Unyc renforce son offre channel autour de l’IoT et de l’EDR

Frédéric Bergonzoli

3 Fév

-

Infinigate face aux attentes des MSP en cybersécurité managée.

Frédéric Bergonzoli

3 Fév

-

La nouvelle mouture de Data Safe Restore relance l’offre de sauvegarde de Beemo

Frédéric Bergonzoli

3 Fév

-

-

-

ielo, opérateur d’infrastructures à l’épreuve des migrations de la fibre

Frédéric Bergonzoli

2 Fév

-

SAP : le coût de la confiance

Thierry Derouet

2 Fév

-

Exclusif : Téléchargez gratuitement le Guide de Visite d’IT Partners 2026

Vincent Verhaeghe

2 Fév