Data / IA

Gemini 3 est disponible… et marque la fin de l’ère du chatbot IA…

Par Laurent Delattre, publié le 19 novembre 2025

Avec Gemini 3, lancé cette nuit, Google fait bien plus que prendre la première place dans la course au Chatbot. Avec Generative UI et Google Antigravity, Gemini 3 inaugure une ère où les bavardages importent moins que les opérations concrètes sur le code, les écrans, les workflows métier. Benchmarks, fenêtres de contexte géantes et orchestration multi-agents dessinent une nouvelle génération d’outils capables selon Google de tenir la distance en production.

C’est l’annonce IT de la semaine. N’en déplaise à Microsoft et son Ignite 2025 truffé de nouveautés. Google a lancé dans la nuit Gemini 3. Et la sphère médiatique s’enflamme déjà pour les scores de performance brute du nouveau modèle.

Certes, Gemini 3 marque une notable avancée sur Gemini 2.5 et permet à Google de revendiquer bien des couronnes. Mais, la véritable révolution pour les DSI et les architectes de solutions se trouve en réalité ailleurs. Une lecture attentive du Model Card technique et des spécifications d’infrastructure révèle non pas simplement un modèle « plus intelligent », mais un basculement stratégique de l’IA générative vers l’IA opérante agentique.

Loin de la course aux chatbots, Google semble bien plus adresser avec Gemini 3 les freins structurels qui empêchaient jusqu’alors le déploiement massif des LLM en entreprise : la fiabilité sur les tâches longues, la nuance contextuelle et l’intégration dans les environnements de développement réels via une autre annonce important du jour : Google Antigravity.

Des benchmarks spectaculaires… mais ce ne sont que des benchs

Sur le papier, Gemini 3 représente un saut aussi important que celui qui séparait Gemini 2.5 de Gemini 2. Le modèle progresse dans tous les domaines, mais on n’en attendait pas moins. Toutefois, L’examen approfondi du Model Card révèle que la supériorité de Gemini 3 Pro n’est pas uniforme, mais qu’elle marque une rupture nette sur les capacités cognitives abstraites et l’autonomie.

Car Gemini 3 excelle en effet sur les benchmarks nécessitant un raisonnement abstrait et visuel, une compréhension étendue ou un raisonnement de longue durée. Typiquement, sur le benchmark Humanity’s Last Exam, Gemini 3 Pro atteint 37.5% (45.8% avec outils), écrasant littéralement GPT-5.1 (26.5%) et Claude Sonnet 4.5 (13.7%). Plus impressionnant encore, sur ARC-AGI-2 (puzzles visuels), où il obtient 31,1%, il double presque le score de GPT-5.1 et triple presque celui de Claude. Alors, oui, bien sûr, ces scores très éloignés des 100% reflètent autant le saut réalisé que le chemin qui reste encore à accomplir vers une IA plus « AGI ». Mais quand même.

Autre progression remarquable, celle de la compréhension d’écran très utile aux usages agentiques et RPA intelligente. Sa suprématie sur le bench ScreenSpot-Pro est sans appel : 72.7% pour Gemini, contre un minuscule 3.5% pour GPT-5.1. Cela confère à Gemini une capacité quasi-humaine à « voir » et comprendre les interfaces logicielles, essentielle pour l’automatisation.

Autre progression essentielle, celle sur la performance agentique longue durée où l’architecture particulière de Gemini 3 et sa gigantesque fenêtre contextuelle (plus de 2 millions de tokens) font clairement la différence. Ainsi Vending-Bench 2, qui mesure la réussite de tâches complexes dans la durée, Gemini 3 ne se contente pas de réussir le benchmark, il génère de la valeur avec un bénéfice net virtuel de 5 478 $ contre 1 473$ pour GPT-5.1.

Si Gemini 3, tel que le présente les benchmarks, paraît désormais un choix évident pour les agents autonomes, la recherche complexe et l’analyse visuelle, la bataille avec Claude Sonnet et GPT 5.1 paraît en revanche plus serrée sur l’assistance au codage et l’ingénierie logicielle assistée par IA. Si Gemini 3 excelle en algorithmique pure (LiveCodeBench), il ne domine pas le marché sur la résolution pratique de tickets d’ingénierie. Sur SWE-Bench Verified, il affiche 76.2%, ce qui le place statistiquement à égalité avec GPT-5.1 (76.3%) et même légèrement derrière Claude Sonnet 4.5 (77.2%).

Comme nous le rappelons régulièrement, les benchmarks n’offrent que des vérités partielles. Ils sont plus pertinents pour comparer l’évolution d’un modèle entre deux versions que pour refléter une capacité à résoudre des problèmes du quotidien en entreprise. Il revient aux DSI de confronter Gemini 3 à leurs problématiques métiers pour juger de la pertinence réelle du modèle à satisfaire leurs besoins et usages.

L’Architecture de la Nuance : La fin des réponses binaires

La promesse la plus intrigante de Gemini 3 réside dans ce que Google qualifie de « profondeur et nuance ». Contrairement aux itérations précédentes focalisées sur la créativité ou la vitesse, Gemini 3 Pro semble avoir été optimisé pour la « justesse » interactionnelle.

L’analyse du Model Card montre un progrès technique subtil mais critique : une amélioration de 7.9% sur la tonalité objective et de 3.7% sur la réduction des refus injustifiés. Pour une entreprise, cela se traduit par une IA moins « capricieuse », capable de naviguer dans des zones grises (conformité, RH, juridique) sans se bloquer par excès de prudence, tout en restant sécurisée.

Cette nuance est soutenue par une architecture Mixture-of-Experts (MoE) dynamique. Le modèle n’est pas monolithique : il évalue la complexité de la requête avant de générer une réponse, activant des voies neuronales de « réflexion profonde » uniquement lorsque nécessaire. C’est cette architecture qui permet le mode « Thinking » ou même le futur mode « Deep Think » (encore bloqué en évaluation interne), offrant une auto-correction avant la réponse finale, essentielle pour des tâches où l’erreur n’est pas permise.

Des réponses visuelles et interactives

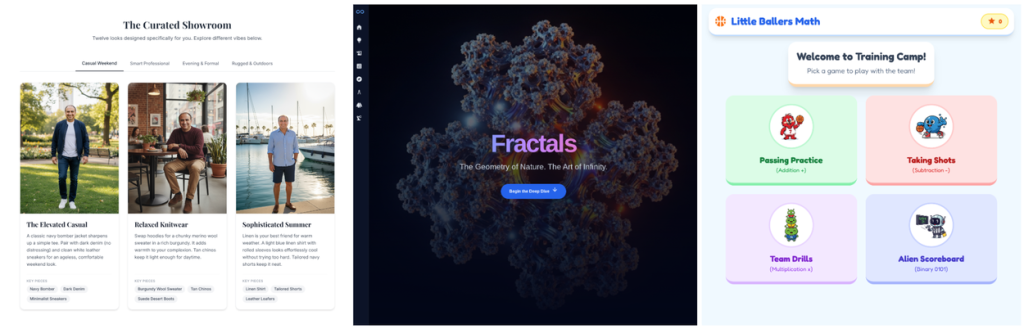

Gemini 3 met en œuvre une nouvelle technologie de Google Research dénommée « Generative UI », notamment mise en œuvre dans l’AI Mode de Google Search et dans Gemini App. L’objectif est de dépasser la simple génération de texte pour offrir des expériences interactives entièrement conçues par l’IA. Chaque requête peut ainsi se transformer en interface dynamique : une page, un outil, un jeu ou une simulation, adaptés au contexte et aux besoins de l’utilisateur. Contrairement aux formats textuels figés, ces interfaces se construisent sur mesure par Gemini 3, qu’il s’agisse d’expliquer un concept scientifique à un enfant, de planifier un voyage ou de créer une galerie artistique.

Cette technologie indépendante de Gemini 3 repose néanmoins intégralement sur les capacités multimodales et de codage agentique du modèle Gemini 3 Pro. Elle permet de générer en temps réel des environnements visuels et interactifs optimisés pour la compréhension et l’action. Les premiers retours récoltés par Google montrent une nette préférence des utilisateurs pour ces expériences par rapport aux sorties classiques des modèles de langage, même si la vitesse de génération reste un défi.

Au-delà de l’innovation technique, Google semble convaincu que cette approche ouvre la voie à une nouvelle génération d’interfaces, façonnées directement par l’IA et évolutives selon les usages. Encore une autre façon de totalement réinventé les Apps et les outils SAAS par ou à cause de l’IA! Les perspectives incluent une personnalisation accrue, l’intégration de nouveaux services et une adaptation continue grâce aux retours humains. Generative UI apparaît ainsi comme un jalon vers des expériences numériques où l’utilisateur ne se contente plus de recevoir du contenu, mais interagit avec des environnements créés instantanément pour lui. Ce n’est qu’un début, mais les démonstrations de Google sont suffisamment parlantes pour inspirer n’importe quel DSI et les convaincre qu’une révolution est en train de naître.

Le virage Agentique : Du « Chat » à la « Planification Longue Durée »

Néanmoins, le changement de paradigme le plus radical apporté par Gemini 3 concerne la capacité du modèle à maintenir une cohérence sur des horizons temporels longs. Jusqu’ici, les LLM « oubliaient » ou hallucinaient dès que la chaîne d’actions dépassait quelques étapes.

Les données de benchmark de Gemini 3 Pro sur le test Vending-Bench 2 (qui mesure la capacité à gérer des tâches agentiques sur le long terme) sont éloquentes. Le modèle a généré un bénéfice net de 5 478$ contre seulement 573$ pour Gemini 2.5 Pro.

Ce différentiel x10 n’est pas juste une amélioration incrémentale : il valide la viabilité des agents autonomes pour des processus métiers complexes.

Et Google a soumis Gemini 3 à des cas d’usage métier bien identifiés pour prouver son potentiel agentique. Trois scénarios sont particulièrement parlants :

* La migration de code hérité : Grâce à une fenêtre de contexte allant jusqu’à 2 millions de tokens (et testée bien au-delà en interne), Gemini 3 peut ingérer un dépôt entier. Il ne se contente plus de suggérer des bouts de code ou de simples fonctions. Les expériences de Google montrent qu’il peut, par exemple, orchestrer en toute autonomie la migration intégrale d’un projet Python 2.7 vers Python 3.12 en gérant les dépendances croisées entre fichiers sans jamais « perdre le fil ».

* Analyse Juridique et « Grounding » : L’intégration native de la recherche (Google Search/Scholar) dans le fonctionnement même du modèle permet une vérification factuelle en temps réel, transformant Gemini 3 Pro en un auditeur capable de valider la jurisprudence actuelle plutôt que d’halluciner des précédents, comme on a pu le voir précédemment (les anecdotes ne manquent pas).

* Analyse de vidéos : Désormais, Gemini se montre aussi précis et attentif sur l’image animée que sur l’image fixe. Il peut dès lors être utilisé sur des cas d’usage comme la détection automatique d’évènements critiques notamment dans les secteurs de la vidéosurveillance ou des médias. Si on lui demande de repérer un évènement précis (une personne avec un sac rouge entrant dans un véhicule bleu par exemple), le modèle retournera le Timecode exact de la séquence. De quoi transformer l’IA en un agent de sécurité capable de filtrer des téraoctets de données pour isoler une anomalie.

Google Antigravity : L’infrastructure de l’autonomie

Avec de telles capacités agentiques, Google se devait de délivrer un peu plus qu’un modèle. Et c’est justement ce que le géant a fait en dévoilant simultanément une nouvelle carte très stratégique à destination des développeurs : Google Antigravity.

Si Gemini 3 est le « moteur », Google Antigravity est le nouveau châssis conçu pour supporter cette puissance.

Google Antigravity est un nouvel environnement de développement intégré (IDE) conçu pour inaugurer une ère dite “agent-first”, où des intelligences artificielles autonomes collaborent directement avec les développeurs. Il ne s’agit pas d’une simple extension d’éditeur de code façon plugin VS Code, mais d’une vraie plateforme où les agents IA peuvent accéder simultanément à l’éditeur, au terminal et au navigateur afin de planifier, exécuter et tester des projets logiciels de bout en bout. L’approche n’est évidemment pas sans rappeler Cursor, AWS Kiro, GitHub Copilot (qui par ailleurs accueille déjà de son côté le modèle Gemini 3 Pro).

Contrairement à bien des IDE traditionnels dopés à l’IA qui se contentent d’assister ponctuellement le développeur, Antigravity organise le travail comme une véritable orchestration multi-agents. Les IA ne sont plus de simples copilotes : elles deviennent des opérateurs capables de générer du code, de le tester automatiquement, de corriger les erreurs et de documenter leurs actions. Les agents ne se limitent donc pas à écrire du code : ils ont accès au terminal et au navigateur. Ils peuvent écrire le code, lancer le serveur de test, observer l’erreur dans le navigateur, et revenir corriger le code de manière autonome.

Et ces agents peuvent aller jusqu’à réaliser une application entière en toute autonomie.

Pour rendre cette autonomie transparente, Google a introduit les “Artifacts” (artéfacts), des objets qui regroupent les plans d’exécution, les captures d’écran ou encore les enregistrements du navigateur. Ces Artifacts permettent au développeur de visualiser ce que l’agent a accompli et de commenter directement son travail, sans interrompre le processus.

Antigravity propose deux modes complémentaires. L’Editor View ressemble à un IDE classique, proche de VS Code, mais enrichi d’un agent latéral qui peut intervenir à la demande. La Manager View, plus ambitieuse, agit comme une tour de contrôle où l’on supervise plusieurs agents en parallèle, répartis dans différents espaces de travail, avec une logique proche des workflows DevOps mais pilotée par l’IA. Autre innovation majeure, les agents disposent d’une mémoire appliquée au développement : ils peuvent retenir des fragments de code ou des procédures déjà utilisées, évitant ainsi de repartir de zéro à chaque tâche.

Dans les démonstrations, Antigravity démontre une réelle capacité à générer une application complète, à la tester automatiquement et à fournir un rapport visuel des résultats. Cette autonomie opérationnelle illustre la volonté de Google de dépasser le paradigme du simple “copilote” pour instaurer une collaboration où l’IA agit comme un véritable partenaire de développement. Compatible avec Gemini 3 Pro mais aussi avec d’autres modèles comme Claude Sonnet ou GPT-OSS, Antigravity se présente comme un écosystème hybride, ouvert et pensé pour maximiser la productivité des développeurs.

Sécurité et Gouvernance

Pour les DSI, la performance ne vaut rien sans contrôle. Le déploiement de Gemini 3 est encadré par le Frontier Safety Framework de Google DeepMind.

Les évaluations montrent que Gemini 3 Pro n’a atteint aucun « Niveau de Capacité Critique » (CCL) sur les domaines sensibles comme la cybersécurité ou la manipulation, malgré ses capacités accrues. Par exemple, sur les défis de cybersécurité, bien qu’il résolve 11/12 des challenges de niveau 1, il échoue encore sur les chaînes d’exploitation complexes de bout en bout (0/13 résolus).

C’est une bonne nouvelle pour la sécurité défensive : le modèle est un excellent assistant pour le Blue Teaming (défense, patch, analyse de logs) sans être encore une menace autonome capable de mener des cyberattaques sophistiquées sans supervision humaine.

Pour autant, Google précise que malgré tous ses progrès, Gemini 3 n’est pas imperméables aux hallucinations. Nos propres tests nous l’ont d’ailleurs montré, et Gemini 3 Pro nous semble même plus enclin aux hallucinations que GPT-5.1. Ce défaut ne pourra pas être éliminé des LLM, on le sait (leur architecture fait que la moindre petite erreur au départ se répercute sur toute la réflexion). Mais la prudence doit donc toujours être de mise.

Au final, Gemini 3 marque effectivement un nouveau saut pour l’IA générative mais ne change pas fondamentalement la donne. C’est un progrès majeur pour l’écosystème Google et clairement un redoutable concurrent pour GPT-5.1, Claude 4.5 ou Grok-4. Cette sortie démontre que contrairement aux craintes de certains experts, les LLM frontières ont encore d’importantes marges de progression même si les hallucinations demeurent encore et toujours leur talon d’Achille.

Surtout, Gemini 3 marque un énorme « Push » de Google pour imposer son modèle partout et maintenant. Il est disponible dès aujourd’hui sur les apps Web et mobiles Gemini, sur Google Workspace, sur Vertex AI, sur Google AI Studio, sur Gemini AI Enterprise, sur Google Antigravity, et même chez le grand concurrent GitHub Copilot ! Il est même directement disponible sur Google Search (c’est la première fois que Google intègre directement un nouveau modèle dans Search) via l’AI Mode. Un vrai raz de marée…

À LIRE AUSSI :