Eco

Du cloud à l’entreprise : comment Nvidia prépare son prochain coup

Par Laurent Delattre, publié le 02 juin 2025

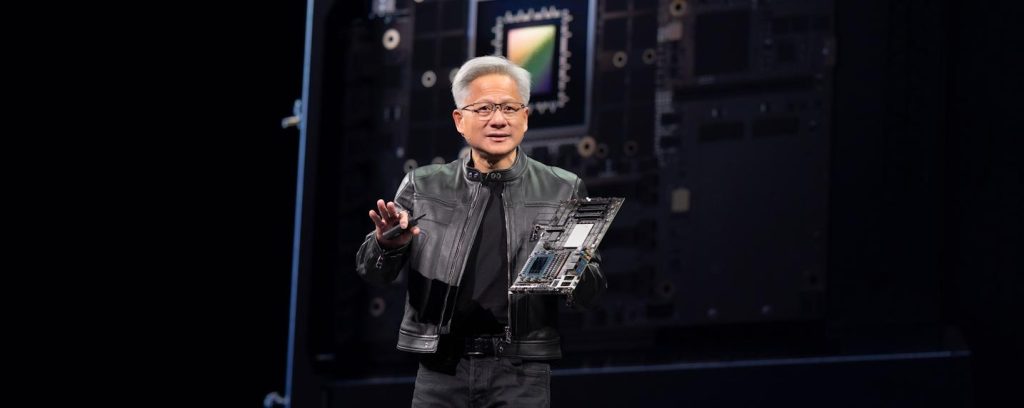

Records à la pelle pour Nvidia, mais nuages à l’horizon : GPU invendables en Chine, hyperscalers qui recherchent plus d’autonomie, et un discours qui jongle avec les lignes politiques. La riposte de Jensen Huang ? Recentrer la stratégie sur les entreprises et faire de chaque GPU une brique logicielle dans les datacenters « on-prem » et les workstations IA.

Malgré la crise économique, malgré les incertitudes engendrées par les taxes fluctuantes de l’administration Trump, malgré une concurrence qui se réveille, la santé de Nvidia reste resplendissante. La firme vient d’annoncer les résultats financiers pour ce qui est vaguement le second trimestre calendaire 2025 mais plus précisément son premier trimestre fiscal de l’exercice 2026. Et le groupe affiche un nouveau record avec un chiffre d’affaires trimestriel de 44,1 milliards de dollars, en hausse de 69% par rapport à l’an dernier avec une marge brute ajustée qui tutoie toujours les 70 % ! Le bénéfice net trimestriel s’élève à 18,8 milliards de dollars.

Sans surprise, le moteur de cette performance demeure la division « Datacenter » et son CA trimestriel de 39,1 milliards de dollars (en croissance de 73% en un an) porté par les superchips GB300 et les nouveaux racks NVL72 pour l’IA. La division « Gaming & AI PC » est portée par le gaming et affiche un CA trimestriel de 3,8 milliards (en croissance de 42% sur un an). La division des cartes graphiques professionnelles « Pro Visualization » paraît désormais infinitésimale avec ses 509 millions de dollars de CA trimestriel qui sont désormais inférieurs aux résultats de la division « Automotive & Robotics » qui affiche 567 millions de dollars de CA trimestriel avec 72% de croissance en un an.

La géopolitique impacte lourdement Nvidia

Si Wall Street a d’abord immédiatement réagi à la hausse, elle a ensuite largement réorienté le titre à la baisse, ce qui est forcément très surprenant vu la performance économique affichée. Un détail est en effet venu jeter un coup de froid sur l’enthousiasme de départ.

Les bons résultats de Nvidia masquent en effet une dépréciation des stocks de GPU « H20 » jusqu’ici dédiés au marché chinois et désormais invendables en Chine, le gouvernement américain ayant récemment durci ses critères de filtrage des technologies accessibles à la Chine. Une dépréciation qui s’est élevée au premier trimestre à 4,5 milliards de dollars mais qui devrait amputer les résultats du second trimestre d’environ 8 milliards de dollars supplémentaires ! Les marges brutes, amputées par cette dépréciation, tombent à 61 % (non-GAAP) alors qu’elles auraient frôlé les 71,3 % sans cet effet ponctuel.

Et si les Clouds arrêtaient de se goinfrer de GPU ?

Mais cette dépréciation n’est pas l’unique point d’inquiétude de Wall Street. La nervosité des investisseurs tient aussi à la valorisation stratosphérique du titre, plus de quarante fois les bénéfices futurs, alors que pointe à l’horizon la crainte d’un « pic capex » chez les hyperscalers. Ces derniers ont installé en moyenne 72.000 GPU Blackwell par semaine (à 40.000 dollars pièce) durant ce trimestre ! Et Microsoft devrait acquérir des centaines de milliers de GPU de génération « GB200 » dans les prochaines semaines, notamment pour satisfaire les besoins d’OpenAI si l’on en croit Nvidia.

Sauf que, parallèlement, les hyperscalers développent également leurs propres accélérateurs maison : Amazon arme sa seconde génération de puces Trainium, Google déploie à très large échelle sa nouvelle puce TPU « Ironwood » et en a fait une très forte promotion durant Google I/O 2025, Microsoft parle peu de son Maia-100 mais semble néanmoins beaucoup l’exploiter (tout comme sa puce Cobalt-100) pour ses propres services. Autant de filières « parallèles » susceptibles de rogner, à terme, les commandes de GPU Nvidia et par voie de conséquence de freiner l’incroyable élan qui propulse l’entreprise depuis deux ans.

Jensen Huang jongle avec les décisions de Trump…

Jensen Huang, le CEO de Nvidia, n’a pas mâché ses mots : les contrôles à l’export sont « un échec » des politiques de Biden et de Trump qui pousse Pékin à bâtir une filière souveraine et, corrélativement, fragilise la domination technologique américaine. Il redoute aussi une fragmentation des chaînes logistiques qui ferait exploser les coûts et allongerait les délais. Le CEO a rappelé au passage que « la question n’est pas de savoir si la Chine aura l’IA — elle l’a déjà ; la vraie question est de savoir si l’un des plus grands marchés mondiaux fonctionnera sur des plateformes américaines. Nous voulons que le monde se construise sur des piles IT américaines et c’est la plus importante raison stratégique d’être présent en Chine ». Et d’ajouter, lors d’un call aux investisseurs, « la Chine est l’un des plus grands marchés de l’IA au monde et un tremplin vers le succès mondial », a déclaré M. Huang. « Aujourd’hui, cependant, le marché chinois de 50 milliards de dollars est effectivement fermé à l’industrie américaine. Nous explorons des moyens limités de rivaliser, mais (une puce à base de l’architecture) Hopper n’est plus une option ».

Deux jours plus tard, Jensen Huang rétropédalait quelque peu dans une interview à Bloomberg pour caresser davantage l’administration Trump dans le sens du poil. Pas à un paradoxe près, il y qualifie les taxes douanières de Donald Trump de « tout à fait visionnaire » : « L’idée que les tarifs douaniers soient un pilier d’une vision audacieuse pour réindustrialiser les USA et motiver le monde à investir aux États-Unis est tout simplement une vision incroyable. Je pense que ce sera pour nous une idée transformatrice pour le siècle prochain. Nous sommes ‘all in’ avec cette idée. Nous installons des usines et encourageons nos partenaires du monde entier à investir aux États-Unis, et nous avons beaucoup de choses en cours. Je suis donc très enthousiaste à ce sujet. »

Pour rappel, les restrictions US envers la Chine visent à limiter l’accès de la Chine à des technologies avancées pour des raisons de sécurité nationale. Décision qui n’a fait qu’accélérer la volonté de la Chine (et de son plan ‘Made in China 2025’ né en 2015) de se rendre indépendante des USA en matière de puces, les restrictions américaines étant en fait une réponse à cette volonté.

Pour les politiciens républicains américains, Nvidia doit faire sans le marché chinois et exploiter son succès mondial actuel pour accélérer ses innovations et distancer la Tech chinoise, d’autant que c’est beaucoup sous l’influence de Jensen Huang que Donald Trump a aboli « la règle de diffusion de l’IA (AI Diffusion Rule) » de l’administration Biden, jugée trop bureaucratique et nuisible à l’économie américaine.

Jensen Huang a d’ailleurs, dans l’interview accordée à Bloomberg, salué la décision de Donald Trump : « La deuxième idée majeure de Donald Trump (après celle des taxes douanières) est d’avoir annulé la AI Diffusion Rule en reconnaissant qu’il ne s’agit pas de limiter la technologie américaine, mais au contraire d’accélérer leur diffusion dans le monde entier pour s’assurer que, avant qu’il ne soit trop tard, le monde s’appuie effectivement sur les piles américaines pendant cette période extraordinaire qu’est l’ère de l’IA ».

… et focalise désormais son discours sur l’IT des entreprises

Commençant à entrapercevoir des limites à son expansion démesurée auprès des hyperscalers, Jensen Huang a opéré ces derniers jours, dans sa communication, un pivot stratégique vers le marché « entreprise » et les équipements des centres de données « on premises » : « Il est vraiment difficile de déplacer toutes les données des entreprises vers le cloud, donc nous allons déplacer l’IA vers l’entreprise. Nous allons voir l’IA aller dans l’entreprise, on-premises, car une grande partie des données est toujours on-premises ».

Nvidia ajuste donc son jeu et opère de nouvelles manœuvres selon quatre axes complémentaires pour maintenir sa suprématie à « l’ère de l’IA » :

– La première manœuvre est ironiquement davantage destinée aux hyperscalers : Nvidia ouvre l’architecture NVLink avec son annonce « Fusion » qui permet aux grands opérateurs de clouds de greffer leurs propres ASIC, CPU ou NPU tout en restant dans l’écosystème CUDA. En clair, Nvidia tend la main à tous ceux qui développent des accélérateurs « maison » pour simplifier leur interconnexion native à ses GPU, préférant partager le gâteau plutôt que de voir l’hyperscaler (et ses clients) entièrement sortir de son giron.

– La seconde manœuvre, qui s’inscrit sur le long terme et prendra du temps, est de relocaliser une partie de la production. Des chaînes d’assemblage de supercalculateurs Blackwell verront le jour au Texas, tandis qu’un back-end avancé s’installe en Arizona.

– Le troisième pivot, sans doute le plus stratégique, est de transformer un modèle essentiellement matériel en flux récurrents en jouant à fond la suprématie de sa plateforme « AI Enterprise ». Celle-ci est au cœur de toutes les solutions « IA clé en main » des partenaires des entreprises, qu’il s’agisse de Nutanix (avec GPT-In-A-Box et Nutanix Enterprise AI), de Dell (avec Dell AI Factory), de HPE (avec Private Cloud AI) pour ne citer qu’eux. Chaque GPU haut de gamme embarque désormais une licence de cinq ans d’Nvidia AI Enterprise, les partenaires cloud indépendants, comme CoreWeave, exposent les puces Blackwell via le nouveau guichet DGX Cloud Lepton, et la grille tarifaire logicielle se décline par niveau de service. Pour les Directions IT, cela signifie que le TCO ne se calcule plus seulement à l’achat d’un serveur : il faut intégrer l’abonnement logiciel, les crédits cloud et les frais de transfert de modèle.

– Le dernier virage est technologique : soigner plus encore l’efficacité énergétique de ses architectures et imposer les super-puces « Grace-Blackwell » pour permettre aux entreprises d’adopter plus largement les GPU « IA » dans leurs propres datacenters mais aussi sur les workstations des développeurs et data-scientists. À Computex 2025 la semaine dernière, Nvidia a lancé et démontré une gamme de machines PC (sous Nvidia DGX OS basé sur Linux) animées par ses processeurs GB10 (plateforme DGX Spark comme le Gigabyte AI TOP ATOM ou le MSI EdgeXpert MS-C931) ou GB300 (ASUS ExpertCenter Pro ET900N G3).

Dit autrement, Nvidia parie sur le fait que les entreprises américaines et européennes, désormais de plus en plus contraintes par la localisation de leurs données et leurs infrastructures existantes, représentent le prochain relais de croissance majeur pour ses technologies IA après les hyperscalers. La feuille de route technique de la firme progresse sans ralentir, dopée par l’adoption d’architectures optimisées pour l’inférence et la personnalisation des « petits » modèles.

Ainsi, pour son deuxième trimestre fiscal 2026, Nvidia table sur 45 milliards de dollars de revenus (±2 %) et sur un retour de la marge brute autour de 72 %. Les dépenses opérationnelles devraient néanmoins s’alourdir (5,7 milliards en GAAP), la société poursuivant ses investissements dans de nouvelles usines américaines et des partenariats au Moyen-Orient et à Taïwan. Jensen Huang se montre donc très positif et convaincu que la demande en calcul intensif accélèrera encore sur la seconde partie de l’année 2026 rappelant que « tous les pays considèrent désormais l’IA comme une infrastructure essentielle, au même titre que l’électricité ou Internet ».

À LIRE AUSSI :

À LIRE AUSSI :