Data / IA

L’adoption de l’IA en entreprise accélère encore et toujours

Par Laurent Delattre, publié le 12 décembre 2025

Deux études, une signée OpenAI, l’autre Menlo Ventures, éclaire assez différemment le paysage de l’IA en entreprise mais confirme une montée en puissance rapide et à grande échelle. Elles tracent un portrait de l’IA en 2025 et donnent d’utiles billes aux DSI sur les tendances et défis à venir en 2026.

En 2025, le marketing de l’IA nous a beaucoup parlé d’agents IA. Mais ces derniers sont encore peu implémentés à large échelle, sauf peut-être auprès des équipes de développements qui ont vu en Manus, OpenAI Codex, Claude Code ou GitHub Copilot Agent une opportunité de simplifier et paralléliser bien de leurs processus quotidiens et pour lesquelles les IA actuelles semblent particulièrement bien calibrées.

En pratique toutefois, en 2025, la réalité de terrain s’est souvent traduite par une réelle adoption de l’IA générative telle qu’on nous la vendait il y a deux ans. Car c’est finalement bien, en cette année 2025, que l’on a vu les IA Copilot 365, ChatGPT, Gemini ou Claude réellement délivrer au quotidien les capacités de rédaction, de résumé, d’analyse de textes et de données, voire de génération d’images qui devaient transformer bien de nos tâches quotidiennes. Et personne ne nie que les derniers modèles GPT 5.1, Claude 4.5 Opus ou Gemini 3 représentent d’importants sauts qualitatifs quant à la pertinence des réponses fournies.

Deux nouvelles études, deux regards bien différents publiés ces derniers jours, viennent mettre des chiffres sur cette nouvelle réalité de l’adoption de l’IA générative dans les organisations. La première est signée OpenAI et s’appuie sur les statistiques d’usage réel de ChatGPT (et des API GPT d’OpenAI). La seconde, signée Menlo Ventures, est plus générale et s’intéresse davantage aux architectures que les entreprises mettent réellement en production et aux flux d’investissement. De quoi non seulement avoir une image plus claire de l’adoption de l’IA en 2025 mais aussi guider les DSI sur les priorités à considérer pour 2026.

OpenAI : du chat ponctuel aux workflows structurés

Côté OpenAI, le constat est d’abord quantitatif. OpenAI part de ses propres données d’usage : ChatGPT revendique plus de 800 millions d’utilisateurs hebdomadaires, et cette base grand public sert de tremplin à l’adoption dans les environnements professionnels.

Son rapport “The state of enterprise AI” exploite les données d’entreprises clientes de ChatGPT Enterprise et de l’API, complétées par une enquête auprès de 9 000 salariés dans près de 100 grandes organisations.

La première conclusion, quantitative, est simple : l’adoption s’accélère et s’approfondit. En un an, le volume de messages hebdomadaires dans ChatGPT Enterprise a été multiplié par huit, et le salarié moyen envoie environ 30 % de messages en plus qu’un an auparavant.

Dans le même temps, l’usage de workflows structurés – fonctions Projects, Custom GPTs et intégrations plus “processées” – a été multiplié par 19, et la consommation de “reasoning tokens” par organisation a été multipliée par… 320. Une façon de démontrer que les utilisateurs trouvent clairement les réponses des modèles « Thinking » plus pertinentes que celles des modèles qui ne le sont pas.

L’étude montre également que les entreprises ne se contentent plus de poser des questions ponctuelles à des Chatbots : elles ont réellement commencé à brancher l’IA sur des chaînes de traitement plus complexes, de plus en plus rapprochées des processus métiers et produits.

Le ressenti des utilisateurs converge avec ces chiffres. OpenAI indique que 75 % des salariés interrogés jugent que l’IA a amélioré soit la rapidité, soit la qualité de leur travail, avec des gains de 40 à 60 minutes par jour en moyenne, et plus de 10 heures par semaine pour les “power users”.

Au-delà du simple accélérateur, 75 % déclarent accomplir désormais des tâches qu’ils n’auraient pas su réaliser seuls auparavant.

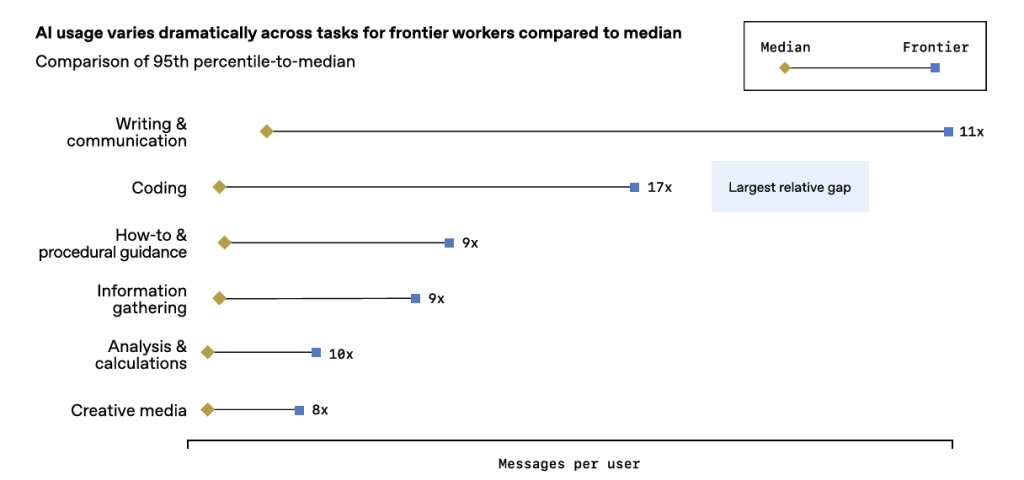

L’étude montre aussi que le développement logiciel sort de la seule sphère IT : les messages “d’aide au codage” ont augmenté de 36 % chez les utilisateurs non techniques.

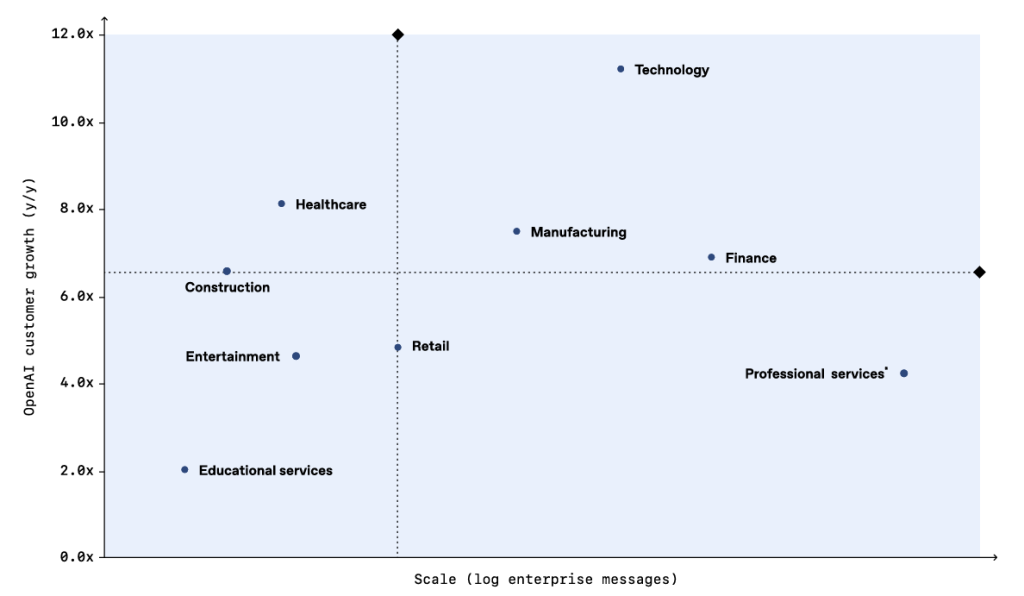

Toutefois, l’élément le plus éclairant de cette étude pour un DSI est que l’écart se creuse entre les “frontier workers” et le reste. Les 5 % d’utilisateurs les plus avancés envoient six fois plus de messages aux IA que la médiane, et les “frontier firms” (les entreprises qui explorent le potentiel de l’IA avant les autres) affichent deux fois plus de messages par siège, avec des intégrations plus profondes à travers les équipes.

Autrement dit, une minorité d’organisations est en train de transformer structurellement ses modes opératoires pendant que le gros du peloton en est encore à la phase d’adoption opportuniste.

Le rapport souligne par ailleurs que les freins ne sont plus techniques. OpenAI rappelle ajouter une nouvelle fonctionnalité ou capacité tous les trois jours en moyenne. Selon la startup, les limites se sont aujourd’hui clairement déplacées vers l’organisationnel : gouvernance, sécurité, refonte des processus, montée en compétences, conduite du changement. C’est là que le gros des défis et des efforts se concentre. Notamment en France, où l’adoption a très soudainement accéléré : la France fait partie des quelques pays affichant une croissance annuelle d’adoption de ChatGPT au-delà des +140 % !

L’ère des PoCs est révolue selon Menlo Ventures

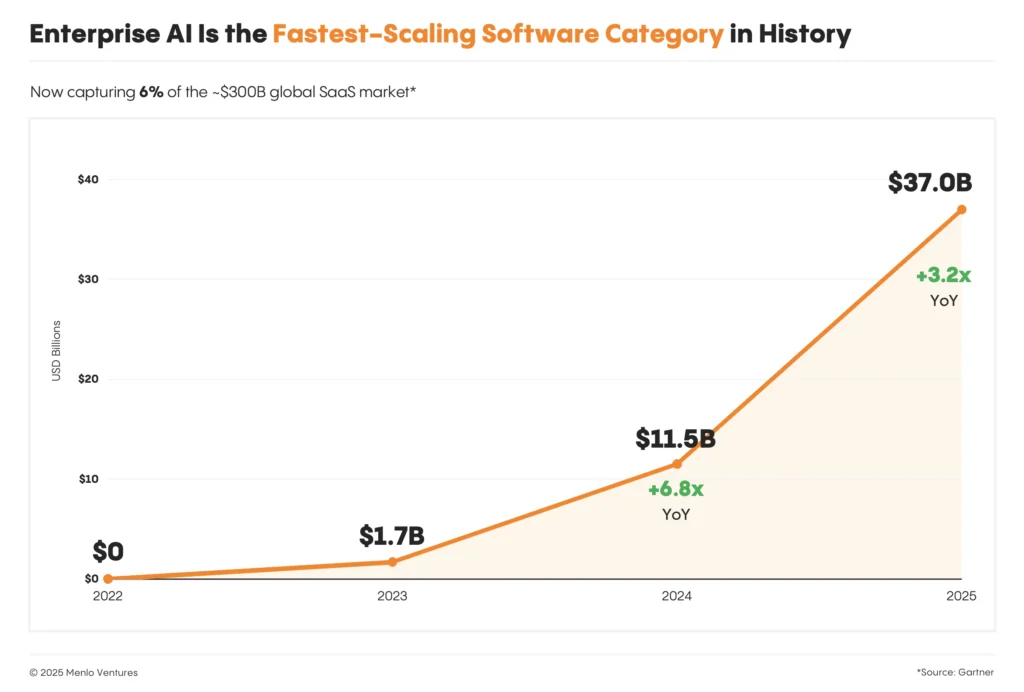

Le rapport de Menlo Ventures « 2025: The State of Generative AI in the Enterprise » complète cette photographie par une perspective marché. Selon leurs analyses, la dépense des entreprises en IA générative aurait quasiment triplé en un an pour atteindre plusieurs dizaines de milliards de dollars (37 milliards de dollars), soit une part désormais significative du marché SaaS global (plus de 6%). On ne parle plus d’un épiphénomène, mais d’une nouvelle catégorie logicielle à part entière.

Surtout, on n’est plus face à un marché dominé par quelques POC géants. Menlo recense au moins dix produits générant chacun plus de 1 milliard de dollars de revenu récurrent annuel, et une cinquantaine au-delà de 100 millions, de l’API des grands modèles aux solutions IA de département (dev, support, sales, RH…) en passant par des offres verticales sectorielles.

Le chemin vers la production s’est au passage clarifié. En 2024, les entreprises étaient encore partagées à peu près à égalité entre solutions construites en interne (47 %) et solutions achetées (53 %). En 2025, Menlo observe que 76 % des cas d’usage IA en production sont désormais basés sur des solutions achetées plutôt que construites, signe que le marché des produits prêts à l’emploi a pris une longueur d’avance sur les développements “from scratch”.

Les projets IA se convertissent par ailleurs en production à un rythme sensiblement plus élevé que le SaaS traditionnel : 47 % des deals IA vont jusqu’en production, contre 25 % pour les logiciels classiques.

Autre information utile, mais les DSI s’en doutaient probablement, l’adoption de l’IA est tirée par les utilisateurs finaux plutôt que par des cycles d’achat top-down. D’après Menlo, près d’un euro sur trois dépensé dans les applis d’IA l’est pour des outils que les utilisateurs ont d’abord adoptés eux-mêmes (en self-service), avant même un vrai achat structuré par l’IT ou les achats. Cela représente 27% des dépenses, un ratio près de quatre fois supérieur à celui du SaaS traditionnel. Si l’on ajoute la “shadow IA” (salariés utilisant des outils comme ChatGPT Plus sur leurs cartes bancaires personnelles avec un usage en partie professionnel), cette part pourrait approcher 40 % des dépenses applicatives.

Dit autrement, et sans que cela soit une surprise, l’IA ne suit pas le cycle de vie traditionnel d’un grand projet IT ; elle entre par la porte des utilisateurs, puis oblige l’IT à reprendre le contrôle a posteriori. Une autre façon de rappeler qu’en 2026 la question « comment canaliser, sécuriser et industrialiser un foisonnement d’usages IA déjà bien engagé dans les métiers ? » restera très actuelle.

Une dépense IA dominée par les copilotes et outils de coding

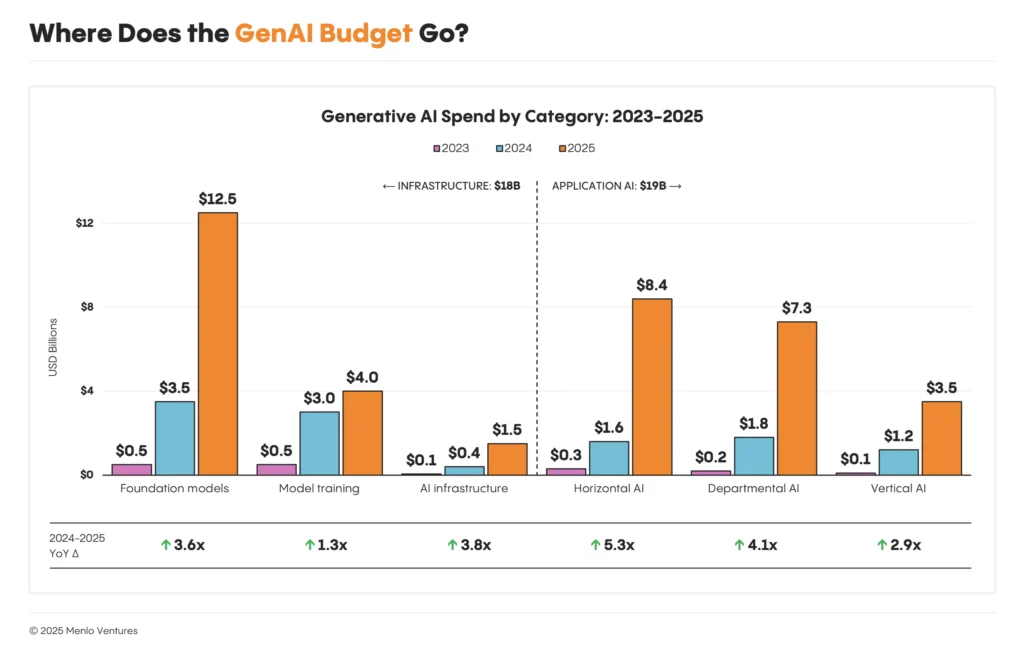

La structure de la dépense IA (ces 37 milliards de dollars évoqués plus haut) est instructive. Un peu plus de la moitié (19 milliards) va aux applications visibles par les utilisateurs – copilotes, assistants métiers, outils de coding – le reste allant aux briques modèles, data, infrastructure et observabilité.

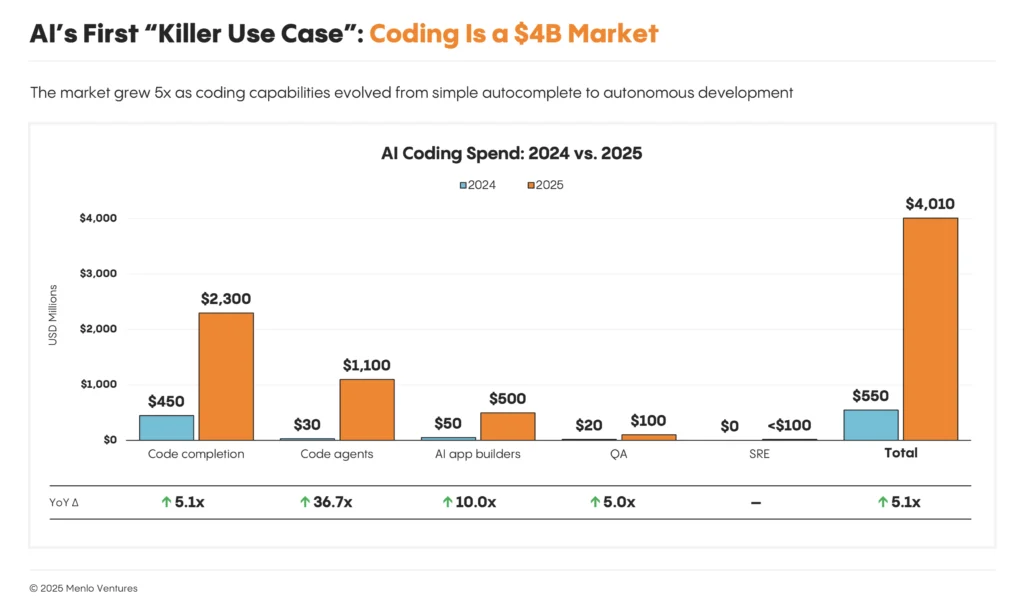

Trois grands blocs émergent. D’abord, les applications dites de département (7,3 milliards de dollars) ciblant des rôles précis, comme les développeurs, les commerciaux ou les équipes de support. À elles seules, les solutions de coding pèsent 4 milliards, soit 55 % de cette catégorie et le plus gros sous-segment de tout le marché applicatif.

La moitié des développeurs utiliseraient désormais quotidiennement des outils de coding IA, un taux qui monte à 65 % dans le quartile supérieur des organisations, avec des gains de vélocité rapportés de plus de 15 % sur l’ensemble du cycle de vie logiciel.

Pour Menlo, c’est clairement là que l’IA a trouvé son premier “killer use case” : des workflows structurés, un output mesurable, un rapport signal/bruit très favorable. Ce qui explique l’euphorie actuelle pour les purs modèles de codage (GPT-5.1-Codex-Max, Mistral Devstral 2, …) et les outils agentiques (OpenAI Codex, Gemini Code Assist, Claude Code, Mistral Code et Vibe CLI, AWS Kiro Autonomous Agent, GitHub Copilot Agent…).

Ensuite viennent les applications verticales par secteur (3,5 milliards), avec une domination écrasante de la santé qui capterait 1,5 milliard, soit 43 % de cette dépense, tirée notamment par les “scribes” médicaux qui allègent drastiquement la charge de documentation.

Enfin, les applications horizontales, essentiellement des copilotes généralistes, concentrent 8,4 milliards de dollars, dont 86 % sur des copilotes de productivité comme ChatGPT Enterprise, Claude for Work ou Microsoft Copilot 365, et seulement 10 % pour de véritables plateformes d’agents, le reste allant à des outils de productivité personnelle.

Autrement dit, en 2025, l’investissement a massivement suivi les cas d’usage où la valeur est immédiate, mesurable et industrialisable : le code, la résolution d’incidents, le support, la vente, la documentation, les tâches répétitives de back-office. Les grands discours sur “l’IA partout” masquent en réalité un cœur de portefeuille encore très concentré.

L’infrastructure de l’IA s’industrialise

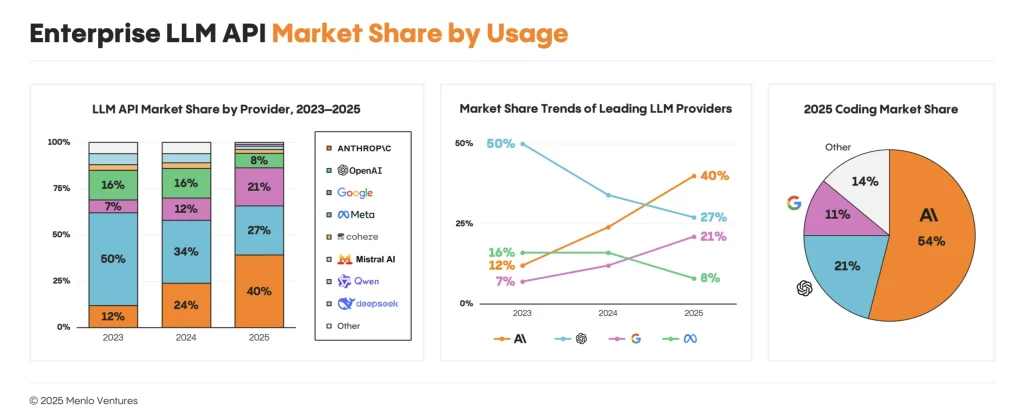

Dans son rapport, Menlo propose aussi un état des lieux des modèles et des architectures. Le marché des LLM d’entreprise est aujourd’hui dominé par un petit nombre d’acteurs hyperscale, avec une part significative pour quelques grands fournisseurs et un rôle encore minoritaire, mais croissant, des modèles open source. Dans les faits, la plupart des entreprises s’appuient sur un portefeuille limité de modèles, complété à la marge par de l’open source pour certains cas d’usage spécifiques.

Menlo estime qu’Anthropic détient désormais environ 40 % de la dépense en API LLM en entreprise, contre 27 % pour OpenAI et 21 % pour Google, ces trois acteurs totalisant 88 % du marché.

L’open source, malgré un rôle central dans l’écosystème au sens large, ne représenterait qu’environ 11 % de l’usage LLM en entreprise, la part du lion revenant à Llama. Les modèles chinois, très dynamiques dans la communauté développeurs, ne pèseraient pour l’instant qu’environ 1 % de l’usage API en contexte entreprise. L’étude porte toutefois bien trop sur le marché américain pour refléter une réalité mondiale ou européenne.

Plus instructif, du côté des architectures, le rapport Menlo éclaire à quel point le discours marketing de l’ère agentique est encore très loin d’être une réalité de terrain. Seulement 16 % des déploiements entreprises (et 27 % côté startups US) correspondent à de “vrais agents”, capables de planifier, exécuter, observer et adapter leurs actions.

La majorité des systèmes OA en production restent basés sur des workflows séquentiels ou de routage autour d’un appel de modèle unique. Les techniques dominantes sont le prompt engineering et le RAG. Le fine-tuning, le « tool calling » avancé, l’ingénierie de contexte ou le RL restent l’apanage d’équipes de pointe.

Cette analyse fait écho aux constats d’OpenAI sur la montée en puissance des workflows structurés et de l’usage “raisonné” des modèles, sans pour autant que l’architecture globale des SI ait basculé dans un paradigme entièrement nouveau. En 2025, l’IA s’empile davantage sur l’existant qu’elle ne remplace la stack traditionnelle.

Dit autrement, la réalité de 2025 est moins celle de “systèmes autonomes magiques” que celle d’un empilement d’outils IA sur une stack de données et d’observabilité très classique, avec un enjeu majeur de qualité de données, de gouvernance, de sécurité et de monitoring runtime. Toutefois, le dernier rapport Capgemini (cf notre article) sur les tendances 2026 alerte déjà les DSI sur le fait que pour aller plus loin dans l’IA il faudra impérativement adapter les infrastructures matérielles et logicielles pour ne pas dire les repenser en grande partie.

2025 sans filtre : un boom réel, beaucoup à faire

Mis bout à bout, les deux rapports racontent une histoire assez cohérente de 2025. Nous ne sommes plus dans une phase de POC isolés. Les chiffres d’OpenAI sur l’usage massif, les gains de temps perçus, et ceux de Menlo sur les 37 milliards de dollars dépensés, la dizaine de produits à plus d’un milliard de revenus et les taux de conversion vers la production nettement supérieurs au SaaS traditionnel, montrent qu’il existe un noyau dur de ROI qui convainc les directions générales et financières. Ils confirment aussi que le centre de gravité de l’IA en entreprise se situe aujourd’hui sur des cas d’usage où la valeur est immédiate, mesurable et industrialisable. Les belles narrations sur « l’IA qui réinvente tout » masquent une réalité beaucoup plus ciblée : les cas d’école sont là où l’on peut mesurer concrètement des gains de temps, de qualité, de revenus ou de coûts. Enfin, ils montrent que l’IA avance selon une logique très différente des grands programmes IT classiques : tirée par les utilisateurs, fortement concentrée sur quelques plateformes, avec un décalage permanent entre la facilité d’expérimentation et la complexité de mise en conformité et de sécurisation.

Mais alors, vers quoi on tend en 2026 à la lumière de ces deux rapports ?

D’abord vers une normalisation de certains usages. Le copilote de développement va devenir le standard de facto de la chaîne de production logicielle. Ne pas en déployer à grande échelle, ce sera accepter un handicap de productivité structurel. Même logique, progressivement, sur certains métiers à forte charge rédactionnelle ou documentaire.

Ensuite, vers un basculement de l’effort, du “faire quelque chose en IA” vers “maîtriser ce que l’IA fait chez nous”. Industrialisation des cas d’usage, gouvernance des modèles et des données, maîtrise des coûts d’inférence, gestion de la dépendance à quelques fournisseurs, articulation avec les contraintes réglementaires : ce sont ces sujets qui vont occuper les DSI, plus que la question de savoir quel nouveau POC lancer comme le souligne d’ailleurs très bien le dernier « CIO Compass » de Sopra Steria Next (dont nous avons parlé ici).

Enfin, vers une recomposition silencieuse des SI : l’IA s’infiltre partout, mais elle repose sur une base très classique de plateformes data, d’observabilité et de sécurité. En 2025, la réalité de l’IA, ce n’a pas été la rupture brutale, mais l’extension rapide du périmètre de ce que l’on attend de la stack existante. En 2026, les DSI qui feront la différence seront ceux qui auront traité l’IA non comme un projet à part, mais comme une nouvelle couche transverse de leur architecture, avec des choix assumés en matière de modèles, de fournisseurs, de gouvernance et de compétences (cf TechnoVision 2026).

Au final, 2025 a marqué un vrai tournant : L’IA n’est plus un sujet expérimental, c’est une nouvelle couche d’infrastructure et d’applications. Les entreprises qui ont pris de l’avance sur cette perception vont rapidement distancer les autres. Mais au-delà de la technique et des chiffres, une inconnue demeure alors que les agents IA vont commencer à infiltrer l’entreprise : jusqu’à quel point l’IA en 2026 affectera le marché de l’emploi. Les premiers signes apparus en 2025 sont en réalité plutôt inquiétants.

Microsoft examine son IA grand public

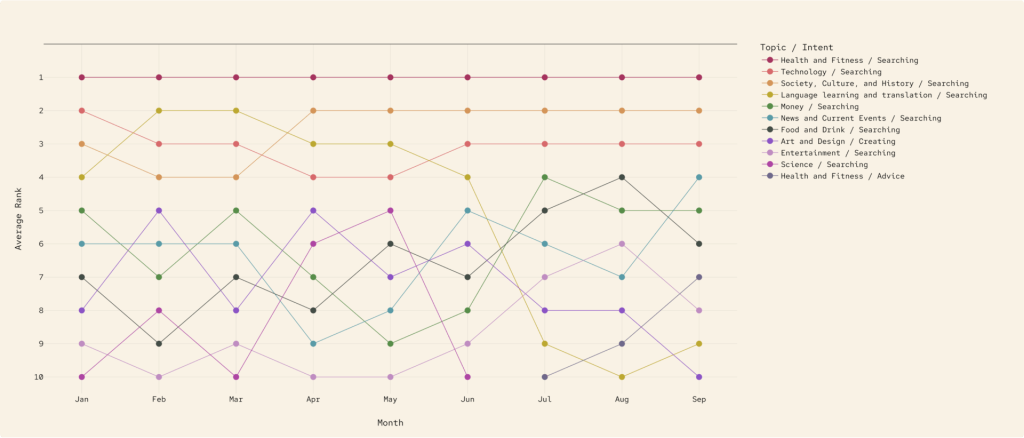

Microsoft vient aussi de dévoiler ses propres chiffres d’adoption de l’IA dans un rapport « It’s About Time: The Copilot Usage Report 2025 » très focalisé sur les usages grand public. L’éditeur a analysé 37,5 millions de conversations Copilot entre janvier et septembre 2025 pour comprendre quand et pour quoi les utilisateurs font appel à l’IA. Microsoft y observe 30 grands thèmes et 11 types d’intentions, qui dessinent une cartographie fine des usages.

Côté thèmes, concrètement, la majorité des échanges se concentre d’abord sur la technologie, qu’il s’agisse de comprendre des concepts, de résoudre des problèmes techniques ou de s’informer sur les dernières nouveautés. Viennent ensuite le travail et la carrière, avec des demandes liées à la rédaction de contenus professionnels, à l’optimisation de CV, à la préparation d’entretiens ou à l’organisation du quotidien. La santé et la forme occupent une place étonnamment centrale, avec des questions sur l’alimentation, le sport, le sommeil ou l’hygiène de vie au sens large. L’apprentissage des langues apparaît comme un usage récurrent, Copilot servant de tuteur pour traduire, reformuler, s’entraîner à écrire ou mieux maîtriser une langue étrangère. Enfin, les thématiques de société, de culture et d’histoire montrent que l’IA est aussi sollicitée pour prendre du recul, contextualiser l’actualité ou nourrir la curiosité générale.

Côté « intentions », dans la plupart des cas, Copilot sert d’abord à clarifier un sujet ou à obtenir des faits, comme on le ferait avec un moteur de recherche, mais en langage naturel. Les utilisateurs l’emploient aussi massivement pour demander des conseils, qu’il s’agisse de prises de décision, de choix personnels ou de stratégies à adopter dans une situation donnée. La création de contenu reste un pilier important, qu’il s’agisse de rédiger des textes, de structurer des idées, de générer du code ou de produire des éléments visuels. L’IA est en parallèle utilisée comme outil d’apprentissage, pour expliquer, vulgariser, entraîner la mémoire ou accompagner la montée en compétence sur un sujet. Enfin, une part significative des interactions concerne le support technique, Copilot jouant le rôle d’assistant de dépannage capable d’expliquer une erreur, de suggérer une solution ou de guider étape par étape.

L’étude met aussi en lumière un contraste net entre appareils. Sur ordinateur, Copilot est surtout mobilisé pour la technologie et le travail, particulièrement en journée. Sur mobile, il devient un compagnon du quotidien centré sur la santé, le bien-être, la vie personnelle et les relations.

Enfin, la comparaison entre le début et la fin de période montre une évolution des usages : très orientés programmation au départ, ils glissent progressivement vers des thèmes plus sociaux et culturels, signe d’un passage d’un public d’early adopters technophiles à une audience beaucoup plus large.

À LIRE AUSSI :

À LIRE AUSSI :