Data / IA

OpenAI DevDay 2023 : Les 11 annonces qu’il ne fallait pas manquer

Par Laurent Delattre, publié le 09 novembre 2023

OpenAI, la startup qui a popularisé l’IA générative et pas la même occasion révolutionné le monde du travail, tenait cette semaine sa première grande conférence. Voilà ce que les DSI doivent en retenir.

Le « DevDay 2023 », première conférence de la startup phare de 2023, promettait des annonces plutôt orientées développeurs. Si l’on a bien parlé SDK et API, la conférence a surtout démontré qu’OpenAI n’avait aucune intention de se reposer sur ses lauriers. Bien au contraire, la conférence a été le théâtre d’une multitude d’annonces audacieuses, marquant ainsi son territoire et creusant l’écart avec ses rivaux, qu’ils se nomment Cohere, Anthropic, Amazon, Meta ou Google !

Voici ce que les DSI doivent retenir de cette conférence en 10 annoncés clés :

1/ Des IA OpenAI solidement ancrées dans le paysage

Commençons par quelques chiffres qui montrent à quel point OpenAI est en moins d’un an devenu un acteur majeur de l’univers de l’IA :

>> Chaque semaine, plus de 100 millions d’utilisateurs exploitent ChatGPT !

>> 2 millions de développeurs dans le monde construisent des solutions appelant les API d’OpenAI.

2/ GPT-4 enclenche le Turbo

Tout comme OpenAI l’avait fait avec GPT-3.5, la startup n’a cessé d’améliorer et optimiser son modèle GPT-4 ces derniers mois. Ces efforts d’optimisation aboutissent à l’apparition d’une variante accélérée de son célèbre modèle LLM : GPT-4 Turbo !

GPT4-Turbo se différencie de GPT-4 sur plusieurs points :

>> GPT-4 Turbo dispose d’une fenêtre contextuelle de 128 000 tokens (soit 300 pages de texte par prompt). Et ça, ça change complètement la donne dans sa capacité à analyser de longs documents ou à générer de vrais rapports. 128K, c’est 16 fois la taille de la fenêtre contextuelle de la version preview de GPT-4 et 4 fois celle de la version actuelle. Même Claude 2 d’Anthropic (et sa fenêtre 100k) est surpassé.

>> GPT-4 Turbo a été entraîné à l’aide d’une base d’informations datée Avril 2023 (contre GPT-4 et ses données arrêtées à Octobre 2021).

>> GPT-4 Turbo est plus optimisé que GPT-4, son utilisation en API revient deux fois moins cher.

>> GPT-4 Turbo est plus discipliné et se montre plus capable de suivre une succession d’instructions. Il est aussi, par voie de conséquences, plus à même d’exécuter une succession d’appels de fonctions (les Functions Calls permettent de connecter le modèle au monde réel) à partir d’un même prompt. Typiquement, le prompt « Ouvre les fenêtres de la voiture et coupe la climatisation », se traduirait effectivement par un appel successif à la fonction API pour ouvrir les fenêtres, puis à une autre pour désactiver la climatisation.

>> GPT-4 Turbo cause JSON couramment. Dit autrement, les développeurs peuvent désormais (via le paramètre response_format) s’assurer que le modèle réponde dans un format objet JSON syntaxiquement correct.

>> GPT-4 Turbo sait répéter grâce à un nouveau paramètre « seed ». Contrairement aux précédents modèles qui à un même prompt répondent différemment, les développeurs peuvent contraindre GPT-4 Turbo à fournir des résultats reproductibles.

À LIRE AUSSI :

3/ Deux API GPT-4 Turbo pour vos applications

Le nouveau LLM est en réalité décliné en deux versions : une version « GPT-4 » exclusivement « texte », et une version multimodale « GPT-4 Turbo with Vision » capable de comprendre et d’analyser textes et images.

Ces modèles « Turbo » seront accessibles via les API d’OpenAI et peuvent être expérimentés via l’interface Playground de l’éditeur. On notera que si « GPT-4 Vision » était intégré depuis quelques semaines à ChatGPT Plus (et Bing Chat), OpenAI n’offrait pas d’API permettant d’incorporer les capacités dans les applications tierces. L’arrivée de « GPT-4 Turbo with Vision » officialise donc la première API multimodale d’OpenAI.

Ces modèles « Turbo » sont facturés ainsi : 0,01$ par 1000 tokens d’entrée (1000 tokens représentent approximativement un prompt de 750 mots) et 0,03$ par 1000 tokens en sortie. L’analyse d’images de 1080×1080 pixels est facturée 0,00765 $.

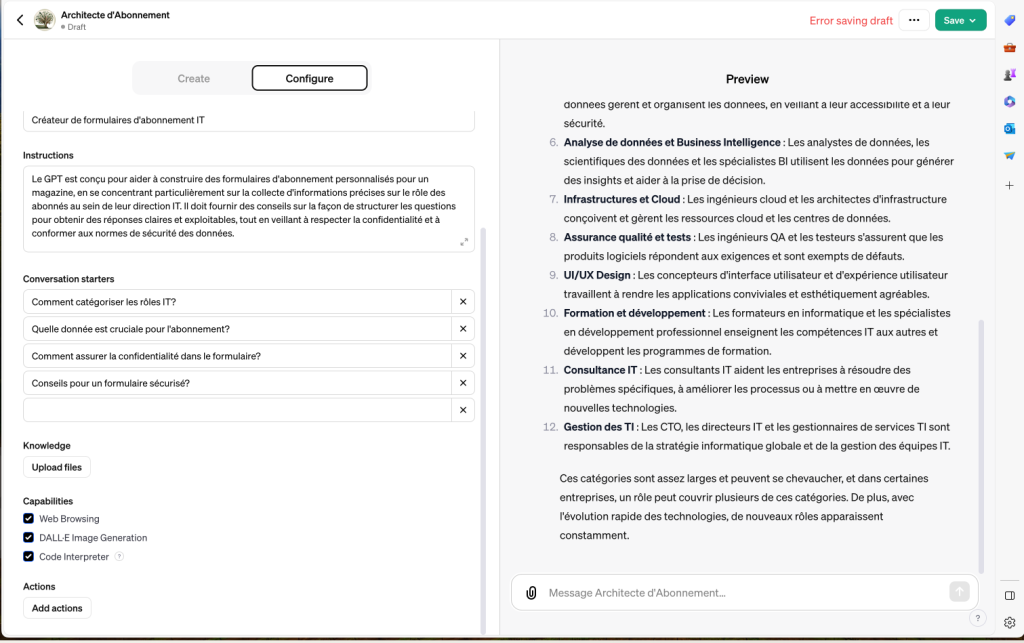

4/ Les GPTs : des versions personnalisées de ChatGPT

C’est la GROSSE annonce de la semaine. OpenAI lance les « GPTs ». Ces derniers révolutionnent la personnalisation de l’intelligence artificielle conversationnelle. Ils permettent à tout un chacun de créer facilement des versions de ChatGPT adaptées à ses besoins quotidiens ou professionnels. Les utilisateurs peuvent configurer ces assistants virtuels pour qu’ils exécutent des tâches spécifiques et interagissent avec des sources de données externes.

Le plus beau ? Aucune connaissance en programmation n’est nécessaire. Prolongement des « Custom Instructions » lancées cet été, les « GPTs » se personnalisent très simplement à l’aide de Prompts. Pour façonner un de ces GPTs, il suffit de débuter une discussion, de donner des directives qui seront retenues par le système, d’enrichir sa base de connaissances avec vos données propres et de définir ses capacités, telles que naviguer sur internet, générer des images, analyser des données ou utiliser des plugins.

Et ces GPTs sont bien plus puissants que cette brève description ne le laisse entrevoir. Un GPT personnalisé peut se voir intégrer des données de sources externes, se connecter à des bases de données internes, accéder à des emails et autres sources d’information, et même utiliser des API externes pour effectuer des opérations et interagir avec le monde extérieur !

Du point de vue des entreprises, les GPTs peuvent être personnalisés pour se conformer à des besoins spécifiques et formuler leurs réponses en les alignant sur la culture de l’organisation et sur son domaine d’activité. OpenAI garantit que les conversations avec ces GPTs resteront confidentielles et ne seront pas utilisées pour améliorer ses actuels et futurs modèles. Les GPTs élaborés par une entreprise peuvent être publiés dans un domaine sécurisé dédié : une interface d’administration permet de contrôler la manière dont chaque GPT est partagé et s’il peut être accessible par des personnes extérieures à l’entreprise.

À LIRE AUSSI :

5/ Un « GPT Store » pour commercialiser vos GPTs

Et ce n’est pas tout. Les GPTs peuvent aisément être partagés. Et pour aller plus loin, OpenAI prévoit de lancer un « GPT Store » fin novembre. Lorsqu’un GPT est publié sur ce magasin applicatif, il peut aisément être recherché, trouvé et utilisé par des internautes. Il sera même envisageable de monétiser l’accès à votre GPT, le transformant ainsi en un produit commercial. Une nouvelle source de revenus pour les clients d’OpenAI mais aussi pour OpenAI.

6/ Assistants API, l’API pour créer des agents intelligents

Au-delà des GPTs, OpenAI propose également un nouveau moyen pour les développeurs de créer leurs propres agents intelligents (pour le support client, l’aide à la vente, etc.) en appui sur les modèles LLM de l’éditeur. Dit autrement, OpenAI veut directement concurrencer les solutions de création de Chatbots « Next Gen » telles que Microsoft Power Virtual Agents (voire Azure AI Studio) ou Google Cloud Gen App Builder. Cette API permet d’enrichir les services et applications des entreprises d’agents conversationnels spécialisés dans un objectif donné. Elle simplifie le processus de création d’agents IA qui utilisent le langage naturel pour aider les utilisateurs.

7/ L’API DALL-E 3 est disponible

DALL-E 3, dernière itération du modèle de génération d’images d’OpenAI, marque un bond assez spectaculaire dans le rendu des images. Déjà intégré dans ChatGPT Plus, Bing Chat, Bing Image Creator et Microsoft Designer, ce modèle n’était jusqu’ici pas accessible en mode API pour les développeurs. C’est chose faite depuis la conférence.

En sélectionnant le modèle « dall-e-3 », les développeurs peuvent directement intégrer le générateur d’images dans leurs applications. Comme avec la version précédente de DALL-E, l’API intègre des filtres de modération pour aider les développeurs à protéger leurs applications contre les abus (et les attaques de type Prompt Injection). Grande nouveauté, Dall-E 3 ne se limite plus à la génération d’images 1024×1024 pixels mais propose au contraire différentes options de format et de qualité, avec des prix commençant à 0,04$ par image générée. L’API peut générer jusqu’à 10 variantes par prompt. Toutefois, l’API « dall-e-3 » ne dispose pas encore des fonctions de masquage et de variations disponibles dans « dall-e-2 » qui reste dès lors disponible.

À LIRE AUSSI :

8/ OpenAI lance de nouveaux modèles Text-To-Speech (TTS)

On sait OpenAI en avance sur la concurrence en termes de LLM et d’IA génératives d’analyse et de génération d’images. La suprématie de l’éditeur sur les traitements audios est en revanche moins connue. Alors que Google et Microsoft ont chacun récemment lancé de nouveaux modèles de synthèse vocale « Text-To-Speech » au rendu très réaliste, OpenAI se mêle à la bagarre avec ses propres IA d’imitation de la voix humaine et de lecture à voix haute. Et le rendu est une nouvelle fois assez bluffant. Six voix sont disponibles mais attention, l’API ne semble prendre en compte que l’anglais pour l’instant. Pour des voix françaises de qualité, mieux vaut pour l’instant se tourner vers les solutions d’Azure, Google Cloud et AWS.

9/ Whisper (Speech-To-Text) arrive en version 3

OpenAI propose également une API pour convertir la voix humaine en texte. Le modèle « Whisper » (qui est en open source) est actuellement le plus performant du marché sur la reconnaissance en français.

OpenAI promet des améliorations notables dans la retranscription des voix sur nombre de langage, dont le français.

Pour l’instant, le modèle a été publié sur GitHub mais n’est pas encore hébergé sous forme d’API par OpenAI.

10/ ChatGPT Plus se simplifie

Certains ont déjà pu découvrir la nouvelle version de ChatGPT Plus. D’autres devront attendre qu’elle se généralise sur tous les serveurs de l’éditeur, son déploiement étant progressif.

ChatGPT Plus permet depuis quelques jours d’importer une grande variété de fichiers (Word, Excel, PowerPoint, PDF, etc.) pour les faire analyser par l’IA et converser sur leurs contenus. L’IA conversationnelle est également désormais connectée au Web (via Bing Search) et capable de générer des images (grâce à l’intégration de Dall-E 3). Elle est aussi capable d’analyser les images que vous lui envoyez.

Mais jusqu’à présent, il fallait manuellement sélectionner les capacités que l’on souhaitait utiliser. Désormais, ChatGPT Plus devient véritablement multimodal et sait utiliser simultanément l’analyse de documents, la recherche Web et la génération d’images sans avoir à spécifier quoi que ce soit.

En outre, ChatGPT Plus s’enrichit d’un nouveau menu « GPTs » pour créer ses propres versions personnalisées de ChatGPT et les partager.

11/ OpenAI va défendre les entreprises accusées de violation de copyright

Comme Microsoft, Adobe et Google avant lui, OpenAI annonce son « Copyright Shield » et s’engage à accompagner et défendre ses clients « ChatGPT Entreprise » (ainsi que ceux de ses API) qui seraient poursuivis pour violation de copyright après avoir utilisé les textes générés par son IA conversationnelle. OpenAI s’engage à payer les frais et les éventuelles amendes de telles poursuites.

L’éditeur dit avoir confiance dans les filtres et procédures intégrés à ses IA et systèmes IA pour éviter toute violation de copyright.

On le voit, OpenAI avait beaucoup de choses à raconter à l’occasion de sa première conférence. La startup reprend les devants et démontre une nouvelle fois son avance sur les IA génératives. Par la même occasion, elle démontre aussi que tout reste à inventer en matière d’IA générative et ouvre pour cela de nouveaux horizons notamment avec les GPTs qui nous transforment tous en créateurs d’IA et en partenaires d’OpenAI. C’est malin…

À LIRE AUSSI :