Data / IA

Rendre l’IA moins énergivore

Par Xavier Biseul, publié le 05 juillet 2023

L’expansion de l’usage de l’IA présente un risque élevé sur le plan environnemental. Il est impératif de la rendre moins énergivore et plus « green ». Une équipe associant des laboratoires du CNRS et du CEA et la start-up HawAI.tech a conçu un prototype de machine d’intelligence artificielle particulièrement frugale.

Les IA génératives de type ChatGPT, Google Bard, Dall-E ou Midjourney, ne posent pas seulement des questions d’ordre éthique ou sociétal. Elles présentent un risque élevé de provoquer un véritable gouffre environnemental. Nécessitant un entraînement important, les grands modèles de langage (LLM) sont particulièrement énergivores.

Le cabinet d’études Tirias Research a calculé que, si la trajectoire actuelle se poursuit, les coûts d’exploitation des datacenters hébergeant ces IA exploseront pour représenter 76 Md$ par an d’ici 2028. Mécaniquement, leur consommation électrique va aussi s’envoler pour atteindre 4 250 MW à cet horizon, soit 212 fois plus que ce qui est prévu pour l’année 2023 !

Les travaux publiés par des chercheurs français dans la revue Nature Electronics donnent quelques espoirs de ne pas arriver à cette perspective. Ils ont réussi à concevoir un prototype de machine qui réalise une tâche d’intelligence artificielle – en l’occurrence reconnaître un geste humain – en utilisant 5 000 fois moins d’énergie qu’une solution conventionnelle.

Au-delà de l’enjeu environnemental, il s’agissait de répondre aux contraintes de ressources des IA « embarquées », notamment dans le domaine médical ou industriel. L’équipe associe trois laboratoires du CNRS – le Centre de nanosciences et de nanotechnologies (C2N), l’Institut matériaux microélectronique nanosciences de Provence (IM2NP) et l’Institut des systèmes intelligents et de robotique (ISIR) –, le Laboratoire d’électronique des technologies de l’information (Leti) du CEA et HawAI.tech, une start-up qui conçoit des processeurs pour une IA dite de troisième génération, explicable et frugale.

À LIRE AUSSI :

Les chercheurs sont partis du constat que la consommation d’énergie par les algorithmes d’IA dans un ordinateur traditionnel est principalement liée aux mouvements de données entre la mémoire et l’unité de calcul, deux composants séparés.

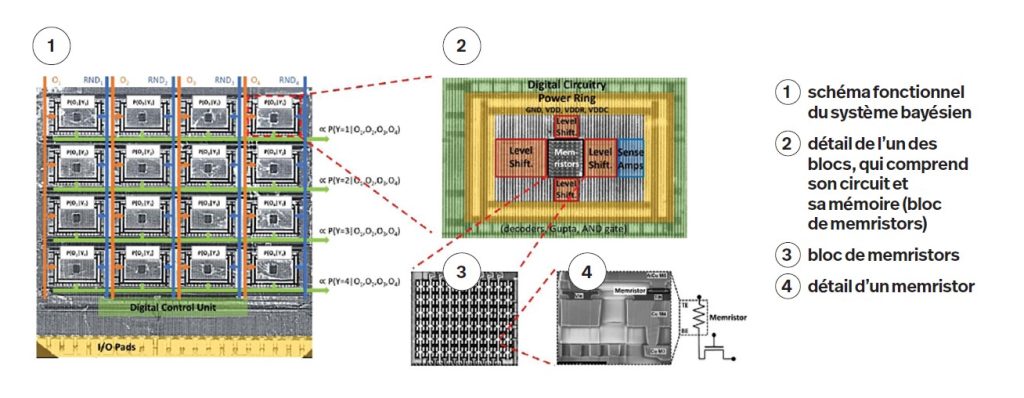

Ils ont donc conçu un prototype basé sur une nouvelle technologie de nano-composants, les memristors, qui intègrent les fonctions de calcul et de mémoire. Mot-valise formé des termes « memory » et « resistor », un memristor est un composant électronique passif qui stocke de l’information, la valeur de sa résistance électrique changeant (en 1 ou 0) lorsque qu’on lui applique un courant.

Un modèle frugal et explicable

La machine de nos chercheurs est composée de 2 048 memristors en oxyde d’hafnium et 30 080 transistors en silicium. Ils ont dû intégrer des technologies électroniques très différentes, mais aussi, explique le CNRS, « inventer des techniques permettant d’éliminer les erreurs inhérentes aux memristors, sans augmenter la consommation d’énergie [du prototype] ».

Plutôt que de partir sur un réseau de neurones, nécessitant un grand volume de données et présentant un effet « boîte noire », l’équipe a opté pour un modèle bayésien. Cette approche probabiliste permet de prendre des décisions à partir d’informations incomplètes. Le raisonnement bayésien est, par ailleurs, entièrement explicable.

Le CNRS indique que le laboratoire C2N continuera les recherches sur cette machine bayésienne à memristors avec un prototype à plus grande échelle permettant de tester « des applications réalistes ».

Un transfert de la technologie vers la start-up HawAI.tech est également envisagé.