Dev

Google I/O ’25 (2/2) : Des agents à la réalité mixte…

Par Laurent Delattre, publié le 22 mai 2025

Au-delà des annonces grand public très centrées sur un Gemini de plus en plus universel et infusé dans la quasi-totalité de l’écosystème Google, la conférence développeurs Google I/O 2025 a aussi permis à l’éditeur américain de présenter de nouveaux outils de développement dopés à l’IA tout en donnant un aperçu des évolutions à venir de ses plateformes Android, WearOS et surtout Android XR moteur d’un retour très attendu du concept « Google Glasses », métamorphosé par le potentiel de l’IA. Des annonces qui préfigurent des tendances et transformations à même d’impacter les feuilles de route technologiques de bien des DSI.

Au-delà du volume des annonces, chaque conférence d’un GAFAM s’accompagnant nécessairement d’un tsunami de nouveaux produits et services orchestré par leur marketing, ce sont les thèmes centraux de ce Google I/O 2025 qui interpellent le plus : l’avènement d’une ère agentique avec des outils capables d’agir de manière autonome, le retour stratégique dans la réalité étendue (XR) via Android XR et des lunettes intelligentes repensées, ainsi que des mises à jour significatives des plateformes Android et Wear OS. Car ces avancées, finalement peu surprenantes, promettent néanmoins de profondément remodeler l’interaction utilisateur, la productivité des développeurs et les usages en entreprise.

Après avoir vu comment Gemini métamorphosait la recherche Internet, le travail collaboratif et la créativité en entreprise (cf. Google I/O 2025 (1/2) : une armée d’IA multimodales pour réinventer le monde numérique), nous allons ici nous attarder sur les annonces qui ont le plus d’impacts sur les développeurs, la DSI et les cas d’usage en entreprise.

L’ère agentique vue par Google

Tout comme Microsoft et sa Build 2025 (qui avait lieu simultanément), Google a profité de sa conférence développeur pour étoffer sa vision agentique, déjà bien dressée à l’occasion de Google Cloud Next 2025, avec un focus sur l’aide aux développeurs.

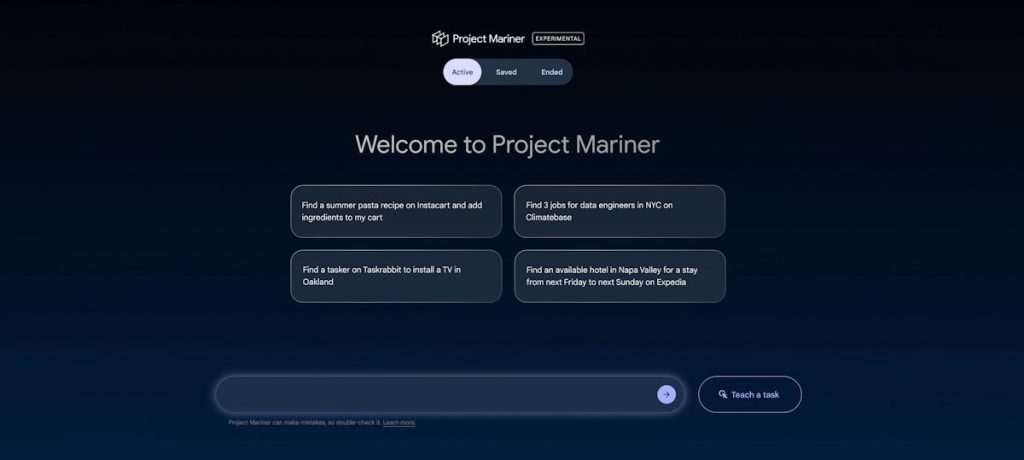

Project Mariner : le super agent qui pilote le Web

Au cœur de cette vision, Project Mariner se présente comme une « première avancée dans le domaine des agents dotés de capacités d’utilisation de l’ordinateur pour interagir avec le Web et accomplir des tâches pour vous ». Réponse de Google aux solutions OpenAI Operator, Claude Computer Use et Microsoft Copilot Computer Use, Mariner agit comme un assistant numérique autonome capable d’exécuter des tâches complexes sur le WEB sans intervention humaine directe.

Fonctionnant via des machines virtuelles dans le cloud, Mariner peut gérer jusqu’à dix tâches simultanément, telles que la recherche d’informations, la planification ou la saisie de données. Il interprète les objectifs de l’utilisateur, élabore un plan d’action, observe les éléments affichés dans le navigateur, et interagit en toute autonomie avec les sites WEB pour mener à bien les tâches nécessaires à la concrétisation des objectifs.

Sa grande trouvaille, qui le différencie de la concurrence, est l’intégration d’une fascinante méthode d’apprentissage par démonstration, « enseigner et répéter » , permettant à l’utilisateur de montrer une tâche une fois pour que l’agent apprenne et reproduise ensuite des actions similaires avec un minimum d’intervention humaine. Cette capacité « enseigner et répéter » est particulièrement notable, car elle démocratise l’automatisation en permettant à des non-programmeurs d’automatiser des interactions Web complexes, ouvrant la voie à une vague de « citoyens automatiseurs » au sein des entreprises.

Project Mariner sert de moteur technologique au futur « Mode Agent » de Gemini, mode qui combine une navigation Web entièrement automatisée, une compréhension multimodale avancée, une orchestration de tâches complexes et une intégration avancée aux services Google (Gmail, Calendar, Docs, etc.).

Pour les DSI, Project Mariner préfigure une nouvelle génération d’outils d’automatisation intelligente qui peuvent servir bien des processus métiers s’appuyant sur le Web et ses services. En déléguant des tâches répétitives à un agent IA capable d’interagir avec des interfaces Web, les entreprises peuvent améliorer leur efficacité opérationnelle, réduire les erreurs humaines et libérer du temps pour des activités à plus forte valeur ajoutée. Project Mariner s’inscrit dans cette mouvance « IPA 2.0 » (Intelligent Process Automation, réinvention de la RPA par l’IA).

Mariner, ou plus exactement « Mode Agent », est en Preview sur Gemini aux USA pour les abonnés au nouveau forfait Google AI Ultra et débarquera prochainement dans l’API Gemini et la plateforme Vertex AI.

Jules : l’agent de codage de Google

Si Project Mariner est la réponse de Google à l’Operator d’OpenAI, Jules est la réponse du géant américain au Codex de la startup et au GitHub Copilot Coding Agent de Microsoft sans oublier Cursor (d’Anysphere), Cognition et Windsurf.

S’inscrivant pleinement dans la tendance « Vibe Coding », Jules est, selon l’éditeur, un « assistant de codage agentique asynchrone qui s’intègre directement à vos référentiels existants ». Tout comme ces concurrents directs, cet agent pour développeurs n’est pas un simple outil de complétion de code. Il étend ses activités à toutes les tâches chronophages et répétitives de l’univers du développement. Typiquement il sait cloner votre dépôt GitHub dans une machine virtuelle sécurisée sur Google Cloud, comprendre le contexte global du projet et peut réaliser des tâches telles que la rédaction de tests, la création de nouvelles fonctionnalités, la correction de bugs ou la mise à jour de dépendances, pour ensuite soumettre des « pull requests ».

Sur le papier, une telle autonomie promet d’accélérer les cycles de développement et d’améliorer la qualité du code. Il libère également le développeur qui peut vaquer à d’autres occupations pendant que Jules travaille pour lui (d’où le terme d’agent asynchrone utilisé par Google). Reste désormais à vérifier si l’exécution et l’usage au quotidien tiennent les promesses. Pour cela, Jules est disponible en bêta gratuite via jules.google.com. Il nécessite un compte Google et une connexion GitHub.

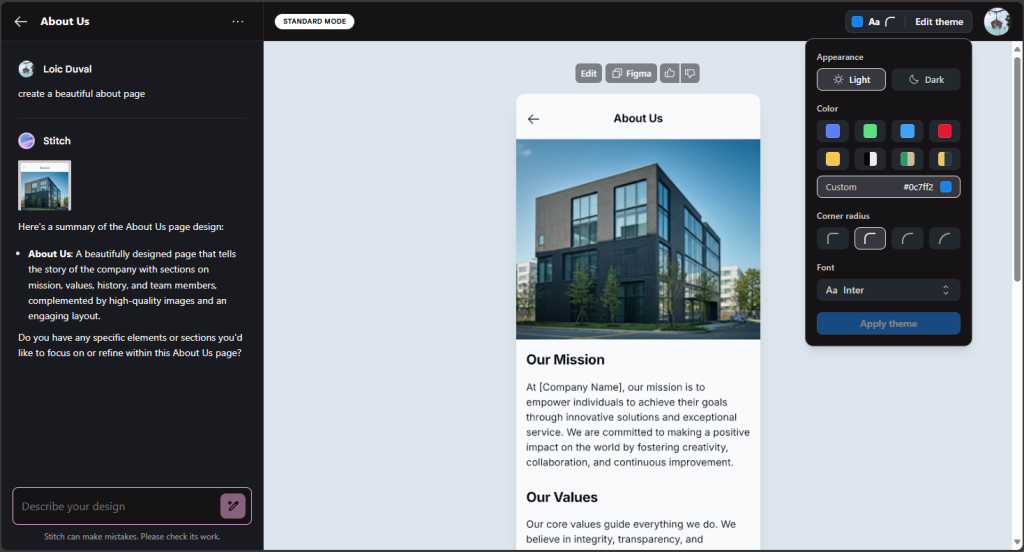

Stitch : l’IA génératrice d’UI

Stitch est le complément de Jules pour les développements Front Office ». Google le définit comme un « outil dopé à l’IA pour aider à concevoir des interfaces utilisateur Web et mobiles en générant les éléments d’interface utilisateur et le code nécessaires » à partir de descriptions en langage naturel ou d’images.

Capable d’exporter vers Figma ou en HTML/CSS (et exposant le code généré pour permettre des améliorations et modifications manuelles), Stitch accélère le prototypage et le développement front-end, démocratisant certains aspects du design. De quoi réduire la dépendance envers des ressources UI/UX spécialisées et faire un peu plus grincer les dents des « designers », bien qu’une supervision humaine reste indispensable pour la qualité et la cohérence de marque.

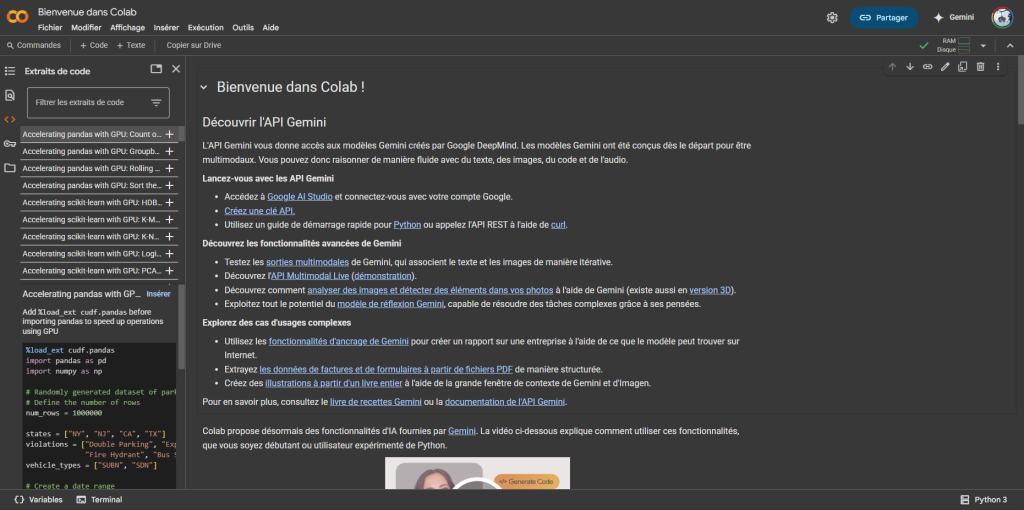

Colab passe à l’ère agentique

Service gratuit proposé par Google pour écrire et exécuter du code Python dans un environnement cloud, Google Colab est très prisé pour la science des données et l’apprentissage machine. Et le service se voit aujourd’hui réinventé avec des « capacités agentiques basées sur le langage naturel qui prendront des mesures dans vos notebooks, corrigeront les erreurs et transformeront le code ». Un « agent de science des données » peut désormais analyser des jeux de données de manière autonome, augmentant la productivité des équipes et accélérant l’extraction d’informations.

Firebase Studio : l’Access de l’IA ?

Firebase Studio est un environnement de développement intégré (IDE) cloud, lancé par Google en avril 2025 et conçu pour accélérer la création d’applications WEB et mobiles complètes en intégrant des fonctionnalités d’intelligence artificielle avancées. Il vise à simplifier la création d’applications IA en intégrant design, front-end et back-end avec une assistance IA. Accessible directement depuis un navigateur, il permet aux développeurs de concevoir, coder, tester et déployer des applications sans nécessiter d’installation locale complexe. Propulsé par le modèle d’IA Gemini 2.5, Firebase Studio offre une assistance contextuelle pour la génération de code, le débogage, la documentation et la création de tests unitaires. Les utilisateurs peuvent importer des projets existants depuis des référentiels, tels que GitHub, GitLab ou Bitbucket, ou démarrer de nouveaux projets à partir de modèles prédéfinis couvrant divers langages et frameworks populaires, notamment React, Angular, Vue.js, Flutter et Next.js.

Une des fonctionnalités notables est l’intégration avec Figma via le plugin Builder.io, permettant de transformer des maquettes en applications fonctionnelles. De plus, l’agent de prototypage d’applications peut détecter les besoins en backend, suggérant et configurant automatiquement des services tels que Firebase Authentication et Cloud Firestore.

En outre, Firebase Studio intègre des outils de test et d’émulation, offrant des aperçus en temps réel des applications Web et Android directement dans le navigateur. Le déploiement est simplifié grâce à Firebase App Hosting, permettant une mise en production rapide et sécurisée.

Actuellement en phase de prévisualisation, Firebase Studio est disponible gratuitement avec une limite de trois espaces de travail par utilisateur. Les membres du programme Google Developer peuvent bénéficier de jusqu’à 30 espaces de travail.

Objectif : abaisser la barrière à l’entrée pour le développement et le déploiement d’applications IA.

Le retour déguisé des Google Glasses grâce à Android XR

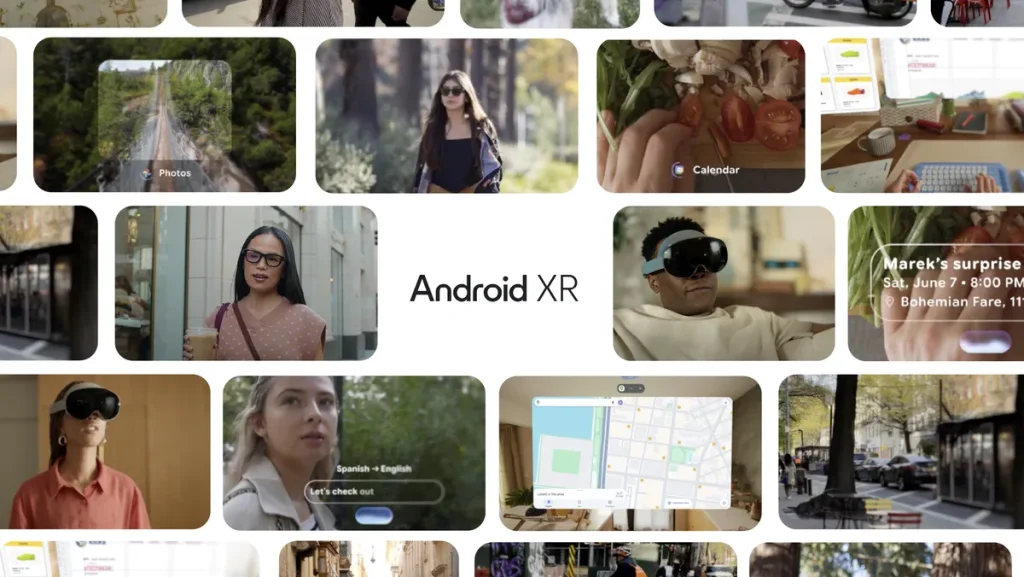

Google a officialisé son retour stratégique dans la réalité étendue avec Android XR, sa plateforme pour casques et lunettes, développée en partenariat avec Samsung et Qualcomm. Présentée comme « la première plateforme Android construite à l’ère Gemini », Android XR marque l’intention de Google de devenir un acteur majeur des prochaines interfaces numériques, avec une IA mature à son cœur.

Et si nous en parlons ici, c’est parce que nous pensons que les DSI vont devoir surveiller attentivement son développement, car Android XR pourrait devenir une plateforme significative pour des applications d’entreprise dans des domaines tels que la formation, l’assistance à distance ou la visualisation de données. « La XR sera la prochaine frontière pour Gemini, et pour l’IA » affirme ainsi Shahram Izadi, responsable d’Android XR chez Google.

Reste qu’Android XR n’est rien sans les dispositifs qu’il est censé animer. Et cette fois, contrairement à l’aventure avortée des « Google Glasses », l’éditeur a préféré jouer les partenariats. La stratégie matérielle de Google s’articule ainsi autour de deux axes :

* D’une part des casques immersifs, comme le « Project Moohan » développé en partenariat avec Samsung et attendu plus tard cette année ;

* Et des lunettes intelligentes, discrètes et élégantes, affichant des données pseudo holographiques et contextualisées par-dessus la vision normale. Et là aussi, Google s’associe à Xreal pour les lunettes connectées « Project Aura » mais aussi à des marques de lunetterie comme « Gentle Monster », « Warby Parker » et Kering Eyewear. De plus, Samsung et Google collaboreraient aussi sur un design de référence pour des lunettes AR de nouvelle génération.

Ces projets évoquent bien évidemment l’ancien projet « Google Glass ». Et pour Sergey Brin, cofondateur de Google, qui reconnaît avoir « fait beaucoup d’erreurs avec Google Glass », la situation a bien changé. Il estime que l’IA avancée, incarnée par Gemini, rend désormais les lunettes plus capables et moins distrayantes. Gemini, intégré au cœur de ces appareils, « peut vous comprendre et comprendre votre environnement de manière plus riche », offrant une assistance contextuelle mains libres à laquelle les smartphones ne peuvent aujourd’hui répondre.

Quoi qu’il en soit, ceci nous promet une belle bagarre entre Google et sa plateforme Android XR, Meta et son projet « Orion », ainsi qu’Apple dont la rumeur veut que la R&D prépare également des lunettes de réalité mixte après le semi échec du Vision Pro.

Mais pourquoi la XR attire-t-elle tant les géants de l’IA ? Simple : ces appareils captent une richesse de données contextuelles inégalée. Chaque geste, chaque regard, chaque interaction devient une source d’information précieuse pour alimenter l’intelligence artificielle.

Er sur le marché des entreprises, de tels dispositifs offrent de nouvelles opportunités pour imposer leurs IA et l’écosystème agentique qui les accompagne. Quitte , au passage, à faire exploser les enjeux de confidentialité et de sécurité des données. La prolifération de dispositifs portables équipés de caméras et de microphones soulève en effet d’importantes questions de confidentialité, de respect de la sphère privée et de sécurité des données.

Android & Wear OS relookés

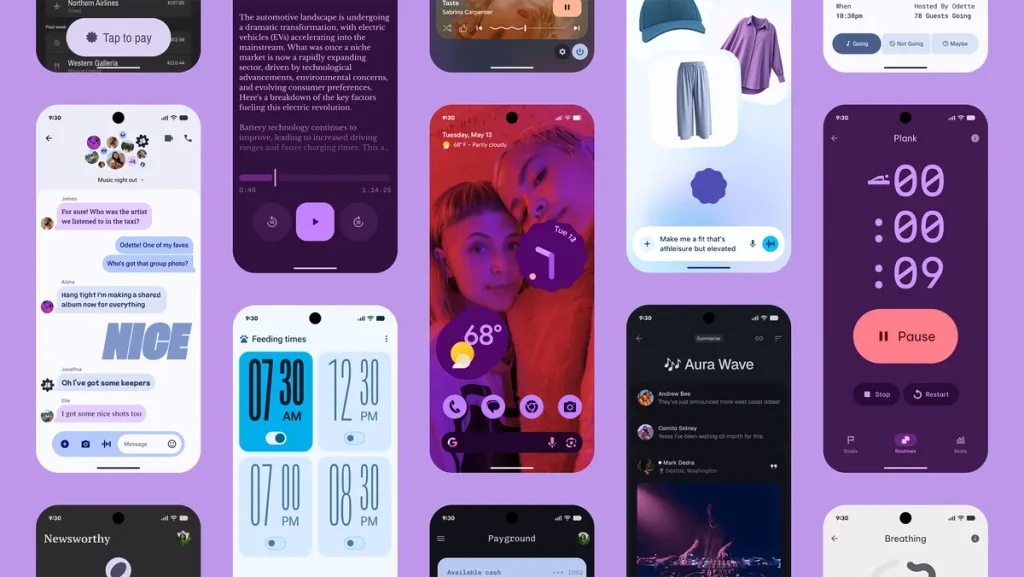

Avant de devenir la grande messe « Google I/A » qu’elle est aujourd’hui, Google I/O était le grand rendez-vous de la mobilité et d’Android. Alors, l’éditeur en a aussi profité pour dévoiler « l’une de nos plus grandes mises à jour depuis des années » avec l’arrivée d’Android 16 et Wear OS 6.

Et la partie la plus visible de cette mise à jour réside dans l’arrivée d’un nouveau design UX dénommé Material 3 Expressive. Cette évolution de l’actuel design « Material You » transforme l’expérience utilisateur en profondeur. Les animations deviennent plus naturelles et « élastiques », l’arrière-plan joue subtilement avec le flou pour créer de la profondeur, et les thèmes de couleurs s’adaptent dynamiquement. La typographie gagne en caractère, les composants réagissent mieux aux interactions. Objectif ? Réduire la charge cognitive tout en rendant chaque geste plus intuitif.

Sous Android 16, les paramètres rapides deviennent enfin personnalisables, et les « Live Updates » révolutionnent le suivi des notifications. Fini de chercher où en est votre commande Uber Eats : l’information arrive en temps réel, directement accessible.

Sous Wear OS 6, l’affichage s’optimise pour les écrans circulaires, le système centrant intelligemment l’interface. Google promet également des défilements plus fluides et des éléments qui s’adaptent dynamiquement et naturellement à la forme de l’écran.

Au final, force est de constater que Google I/O 2025 (tout comme la BUILD 2025 de Microsoft) démontre clairement une nouvelle accélération des stratégies IA à l’ère des agents. Chez Google, Gemini s’impose comme la pierre angulaire d’une nouvelle génération d’expériences numériques plus agentiques, contextuelles et immersives.

Cette intégration omniprésente de Gemini n’est pas qu’un exercice de style de la part de Google : elle témoigne d’un changement stratégique fondamental où une interface IA centrale fournit une couche d’intelligence cohérente à toute une ribambelle de services, d’agents, et de dispositifs. Simultanément, l’évolution vers une IA agentique et une XR contextualisée marque une révolution des usages où l’utilisateur perd en activité et en autonomie au profit d’intelligences artificielles qui l’assistent à tout moment et agissent proactivement en son nom, soulevant au passage des questions inédites en matière de workflows, de formation, d’éthique et de contrôle pour lesquelles il faudra vite trouver des réponses sous peine de voir les IA elles-mêmes nous les imposer pour contrecarrer notre inaction.