@Work

Google I/O 2025 (1/2) : une armée d’IA multimodales pour réinventer le monde numérique

Par Laurent Delattre, publié le 21 mai 2025

L’intelligence artificielle redessine les frontières des services Google, de la recherche à la création multimédia, en passant par l’assistance à la productivité quotidienne. À l’occasion de Google I/O 2025, qui se tient cette semaine, l’éditeur américain s’est efforcé de donner corps à cette transition à travers de multiples annonces et notamment de multiples agents autonomes s’appuyant sur des modèles toujours plus puissants. Voici ce que les DSI doivent retenir des grandes annonces IA de cet événement.

Grand rendez-vous annuel des développeurs Web et Android, Google I/O se tient cette semaine dans un contexte de surcharge de grandes conférences, puisque Microsoft, Dell, Red Hat et Computex notamment tiennent aussi leurs grandes manifestations en parallèle. Si l’événement sert de vitrine aux nouveautés pour l’ensemble de l’écosystème Google, allant d’Android à Chrome en passant par Search et Workspace, il se distingue de Google Cloud Next par une orientation forcément plus grand public des principales annonces.

Cette édition 2025 n’a pas dérogé à la règle, baignant dans une atmosphère dominée par l’intelligence artificielle, véritable fil rouge de la quasi-totalité des présentations. Et comment pourrait-il en être autrement ? L’IA est partout et change tout, pour chacun d’entre nous. Sundar Pichai, le CEO du groupe américain, a d’ailleurs ouvert les débats en expliquant que Google traite désormais 480 000 milliards de tokens par mois dans ses produits et API, cinquante fois plus qu’il y a un an, signe d’un basculement à grande échelle vers l’IA générative.

Voici un tour d’horizon des principales annonces IA « non-développeurs » de ce Google I/O que les DSI doivent connaître pour comprendre l’évolution des tendances en matière d’IA, de recherche, d’applications mobiles. Nous reviendrons demain sur les annonces plus destinées aux équipes IT et aux développeurs.

À LIRE AUSSI :

Des modèles toujours en progression

Google mène la guerre de l’IA sur tous les fronts à commencer par celui des modèles qui servent de fondation aux applications, aux assistants et aux agents IA. Et l’éditeur a profité de ce Google I/O pour officiellement introduire une mise à jour de sa famille de modèles hybrides (à raisonnement intégré) Gemini 2.5. Et c’est justement sur les techniques de raisonnement que les progrès se focalisent.

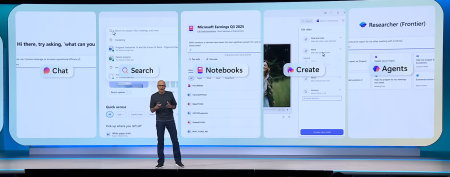

Le mode Deep Think (encore expérimental) de Gemini 2.5 Pro applique désormais une recherche d’hypothèses en parallèle. Dit autrement, Deep Think permet au modèle d’envisager de multiples hypothèses avant de formuler une réponse, s’appuyant sur des techniques de recherche avancées. Et les résultats sont apparemment plus que probants. « Je suis particulièrement enthousiasmé par la progression fulgurante des modèles : leur score Elo a gagné plus de 300 points depuis le tout premier Gemini Pro, et aujourd’hui Gemini 2.5 Pro domine le classement LMArena dans toutes les catégories » s’est ainsi enthousiasmé Sundar Pichai en ouverture de conférence. Selon Google, Deep Think permet à Gemini 2.5 Pro d’établir de nouveaux records : 49,4 % au benchmark USAMO 2025, 80,4 % à LiveCodeBench et 84 % à MMMU, plaçant ainsi le modèle vedette de Google devant les modèles o3 et o4 d’OpenAI. Ce mode « Deep Think » n’est pour l’instant accessible qu’aux « trusted testers » via l’API, le temps de finaliser les audits de sûreté. La variante « Hypothesis Mode », présentée comme la déclinaison interactive de Deep Think, devrait apparaître dans l’interface de l’assistant Gemini dans les prochaines semaines.

Optimisé pour la vitesse et l’efficacité, le modèle Gemini 2.5 Flash a encore été amélioré. Sa dernière itération réduit de 20 à 30 % la consommation de tokens et progresse en raisonnement multimodal, codage et contexte long. Il est disponible en pré-version dans AI Studio et Vertex AI, la GA étant annoncée pour juin.

Côté modèles embarqués, la famille des modèles ouverts Gemma s’agrandit : Gemma 3n est un modèle multimodal qui peut s’exécuter en local et hors-ligne sur des terminaux dotés de moins de 2 Go de RA. Google en profite pour annoncer des variantes spécialisées : MedGemma pour la santé et SignGemma pour la traduction de la langue des signes.

Un assistant qui fait de la résistance… et bien plus

On croyait l’assistant Gemini très à la traine en termes d’audience sur ChatGPT et Claude AI. Et bien, il n’en est rien. Selon Google, l’assistant Gemini revendique désormais 400 millions d’utilisateurs mensuels et une hausse de 45 % de l’usage depuis le passage à la série 2.5 des modèles. L’adoption semble s’être grandement accélérée depuis l’introduction de la fonction agentique « Deep Research ». Cette dernière permet désormais de générer des rapports de recherche personnalisés, avec la possibilité d’intégrer des documents PDF et des images privées, et prochainement des contenus issus de Google Drive et Gmail.

Autre nouveauté, l’espace créatif « Canvas » s’enrichit. Ce dernier offre un espace de travail interactif conçu pour la création, l’édition et le prototypage, que ce soit en texte ou en code. Il permet aux utilisateurs, en discutant avec l’IA, de rédiger des documents, de générer du code, de concevoir des prototypes interactifs ou encore de visualiser des algorithmes, le tout dans une interface fluide et collaborative. Et désormais, Canvas s’ouvre à plus d’interactions en facilitant la création d’infographies interactives, de podcasts en 45 langues et même le « vibe coding » pour prototyper des applications à partir de descriptions textuelles. Autre nouveauté, une fonction Quiz transforme en un clic n’importe quel contenu Canvas en séries de questions interactives : Gemini génère automatiquement QCM, vrai-faux ou cartes mémoire, ajuste la difficulté d’après le profil des participants et suit la progression dans un tableau de bord partagé. De quoi passer du brainstorming à la validation des acquis sans friction, au sein d’une même interface collaborative.

Parallèlement, et tout comme Copilot chez Microsoft, Gemini s’impose désormais de plus comme l’interface de collaboration avec les agents IA. Typiquement, l’application mobile Gemini inaugure un Agent Mode, réservé pour l’instant aux abonnés américains de la nouvelle formule AI Ultra (voir à la fin de l’article), qui accepte une simple instruction (« trouve-moi un deux-pièces à Paris à moins de 1 500 € par mois ») puis lance des sessions de navigation virtualisées, applique filtres et formulaires, et remonte un résultat prêt à l’emploi. Cette délégation agentique s’appuie sur Project Mariner, démontré l’an dernier, désormais capable de répliquer une action démontrée et de conduire jusqu’à dix tâches Web en parallèle grâce à la nouvelle fonction « Teach & Repeat ». Dit autrement, Google semble sur le point de transformer son assistant Gemini en couche d’orchestration universelle personnelle : l’utilisateur formule une intention, l’IA planifie, agit et rend compte, tout en préservant la validation finale.

Enfin, Google planche sérieusement sur la réinvention des interactions avec l’IA grâce à la voix et à la vision. On en parlera demain, ces technologies sont clés pour des projets futurs, comme les lunettes de réalité mixte. Ainsi, la fonctionnalité « Gemini Live » se transforme en véritable copilote visuel. Gratuite sur Android et iOS, elle autorise désormais des interactions qui vont au-delà des échanges vocaux en ajoutant les informations de la caméra ou le partage de l’écran (donc de ce qui y est affiché) : l’utilisateur pointe un objet ou une appli, l’IA répond presque instantanément, et les conversations sont déjà cinq fois plus longues que par texte selon Google. Dans les prochaines semaines, Gemini Live ira plus loin : création d’événements Calendar, itinéraires Maps ou tâches dans Google Tasks, le tout sans quitter la session. En coulisse, ces nouvelles interactions en temps réel sont gérées et animées par le projet IA « Project Astra » démontré l’an dernier. Ce moteur assure la latence ultraréduite qui fait la fluidité des interactions Live. Ce moteur multimodal viendra d’ailleurs prochainement enrichir les interactions du moteur de recherche de Google avec une fonction « Search Live » : un simple tap sur « Live » permettra d’interroger Google Search sur ce que voit la caméra du téléphone en direct. Au final, on retiendra que Gemini Live et Project Astra inaugurent une génération d’assistants capables de voir, comprendre et agir dans notre environnement numérique comme physique.

Google soigne l’IA multimédia

La création de contenu multimédia assistée par IA progresse dans toutes les dimensions.

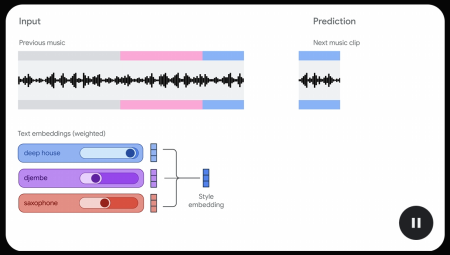

Lyria 2 : de la musique unique à volonté

Google a un outil méconnu d’aide à la composition musicale assistée par l’IA ( le service est en preview privée depuis 2023 !) et destiné aux musiciens professionnels. Ce service est depuis avril dernier animé par un nouveau modèle Google dénommé « Lyria 2 » développé par DeepMind. À Google I/O, le géant américain a annoncé une variante de son modèle dénommée « Lyria 2 RealTime » prête à quitter les laboratoires du groupe pour s’exposer sous forme d’API. Lyria 2 RealTime se distingue en permettant la génération musicale interactive en temps réel, offrant ainsi une flexibilité accrue dans le processus de composition. Conçu pour produire des compositions audio de haute-fidélité (48 kHz stéréo), il permet aux utilisateurs de créer de la musique à partir de simples descriptions textuelles, avec un contrôle précis sur des paramètres tels que le tempo, la tonalité et le style musical. Lyria 2 RealTime est au cœur d’un nouveau service musical à accès restreint « MusicFX DJ » et de la génération musicale proposée dans AI Studio (avec la possibilité désormais de mixer en temps réel les styles musicaux, à essayer ici, c’est très fun). Sur le fond, Lyria 2 est la réponse directe de Google aux startups Suno ou Udio mais le modèle se veut à la fois plus respectueux des ayants droit, et plus orienté usages professionnels. Lyria 2 est en effet désormais accessible aux créateurs de YouTube Shorts mais aussi et surtout aux entreprises via Vertex AI. Les entreprises peuvent via cette API générer des contenus musicaux personnalisés et réduire leur dépendance aux bibliothèques musicales traditionnelles et aux coûts associés. Toutes les productions de Lyria 2 sont marquées par la protection SynthID de Google, garantissant une identification claire des contenus générés par IA.

VEO 3 : une révolution multimédia

Autre sujet sur lequel Google investit massivement (YouTube oblige), la génération de vidéos par l’IA. Le modèle Google VEO a été lancé en mai 2024 pour concurrencer le modèle SORA d’OpenAI. Depuis, il n’a cessé d’évoluer avec l’introduction notamment de VEO 2 en décembre dernier, offrant la possibilité de générer des séquences 4K. Et Google enfonce le clou. Dévoilé en grande pompe à Google I/O 2025, VEO 3 inaugure une nouvelle génération d’IA vidéo : le modèle couple pour la première fois image et son, générant de façon native bruitages d’ambiance, dialogues et musique à partir d’un simple prompt. « Nous sortons enfin de l’ère du cinéma muet », s’est réjoui Demis Hassabis, le DG de DeepMind, soulignant la capacité de VEO 3 à caler automatiquement l’audio sur les pixels qu’il produit. Sur le plan visuel, VEO 3 surpasse VEO 2 dans tous les domaines : rendu plus détaillé, meilleure compréhension des lois physiques, synchronisation labiale et aptitude à suivre une mini-narration décrite en langage naturel. L’utilisateur peut enrichir la requête d’images de référence pour conserver personnages et décors d’une scène à l’autre. Le modèle est disponible via Vertex AI pour les entreprises.

L’arrivée de VEO 3 ne signe pas pour autant la mort de VEO 2. Google enrichit en effet les capacités de son ancien modèle avec des fonctions issues des retours de cinéastes : Possibilité de fournir au modèle une vidéo de référence pour la cohérence artistique, contrôle plus précis de la caméra (rotation, travelling, zoom), fonction « outpainting » pour élargir un cadre et ajout ou suppression d’objets dans une séquence.

VEO 3 est disponible dès aujourd’hui dans l’application Gemini pour les abonnés Google AI Ultra (USA uniquement, cf. plus loin), alors que VEO 2 est accessible aux abonnés Google AI Pro (ex abonnement Premium).

Pour les studios comme pour les équipes marketing, la promesse est claire : passer du storyboard textuel à un clip audiovisuel cohérent en quelques minutes, sans quitter l’écosystème Google. Une réalité qui aura forcément un impact sur l’écosystème de la création, comme la génération d’images fixes commence déjà à en avoir. Certains observateurs anticipent déjà que cette automatisation vidéo par l’IA pourrait bouleverser jusqu’à 100 000 emplois du secteur audiovisuel américain d’ici 2026.

Imagen 4 : des progrès notables

Et puisque l’on parle d’images fixes, Google a aussi présenté une nouvelle évolution de son modèle de création d’images. Imagen 4 pousse la résolution à 2K, restitue les textures complexes (tissus, gouttes d’eau, pelage) et maîtrise enfin la typographie, de quoi composer directement affiches ou slides sans retouches externes. Et si Imagen 4 se révèle déjà plus rapide que ces prédécesseurs (et que son concurrent GPT-4o Image), il bénéficiera bientôt d’une déclinaison « Fast » annoncée comme dix fois plus rapide !

Google Flow : un outil de réalisation vidéo

Ces briques IA animent également un tout nouvel outil multimédia annoncé par Google : Flow. Cet outil de « filmmaking » combine Veo, Imagen et Gemini pour aider à la réalisation de clips vidéos et de scènes 3D. Tout se commande en langage naturel : vous décrivez un plan, précisez le décor ou le style, et Flow génère le clip correspondant, puis enchaîne automatiquement les scènes pour créer une trame cohérente. L’interface utilisateur regroupe les fonctions classiques Scene Builder, Asset Manager et Camera Control. Elle permet d’importer personnages et décors, régler travelling, rotation ou zoom, étendre un plan par out-painting et même ajouter ou retirer des objets, le tout en quelques glisser-déposer. Initialement limité aux États-Unis, l’outil doit s’ouvrir à d’autres marchés dans les mois qui viennent.

Google Beam : le futur de la visio est là

Enfin, pour conclure ce volet multimédia, Google ressort des cartons son projet « Starline » dévoilé en 2021, une technologie de visioconférence en 3D très prometteuse. Rebaptisé « Google Beam », le projet bénéficie des innovations IA actuelles pour évoluer d’expérimentation à future plateforme de visioconférence 3D pour l’entreprise. Son secret : Grâce à un ensemble de 6 caméras, un modèle IA vidéo volumétrique convertit des flux 2D classiques en rendus 3D réalistes, puis les projette sur un écran « Light Field » (à champ lumineux), un dispositif de projection d’images en 3D sans lunettes ni casque. Le système assure un suivi de tête à la précision millimétrique et diffuse le tout en 60 images par seconde, recréant le contact visuel et les micro-expressions. Des premiers dispositifs Google Beam conçus en partenariat avec HP sont attendus d’ici la fin de l’année !

La recherche Google se réinvente

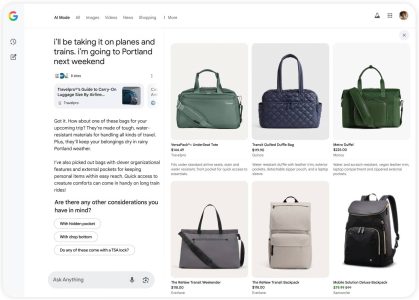

Google a compris dès la sortie de ChatGPT il y a deux qu’elle devrait réinventer son cœur de métier. Depuis l’extension massive des AI Overviews (1,5 milliard d’utilisateurs dans 200 pays), Google constate que les internautes posent des questions plus longues, plus complexes et plus visuelles. Pour accompagner cette évolution, l’entreprise dévoile une refonte radicale de Search bâtie sur ses modèles Gemini 2.5 et sur trois grands piliers : un nouveau AI Mode, des capacités multimodales en temps réel et l’arrivée d’agents capables d’agir pour l’utilisateur.

Disponible dès à présent aux États-Unis dans un onglet dédié, AI Mode sort des Labs pour proposer une expérience de recherche intégralement gérée par l’IA. Ce nouveau moteur accepte des questions plus complexes et deux à trois fois plus longues qu’une requête classique, suggère des questions de suivi, « query fan-out » pour explorer de multiples sous-sujets simultanément. Il délivre des réponses synthétiques, enrichies de liens vers le Web, au rythme « le plus rapide de l’industrie » grâce à une version optimisée de Gemini 2.5. Google prend donc enfin le taureau par les cornes et compte bien couper l’herbe sous les pieds d’un Bing AI Search stagnant et surtout d’un ChatGPT « Web Search » qui commence vraiment à s’inscrire dans les habitudes des utilisateurs.

Pour les sujets qui exigent une exploration poussée, Google Search va également progressivement intégrer Deep Search, fonctionnalité exploratoire de Gemini (désormais dopée par Gemini 2.5 Pro) qui déclenche des centaines de requêtes parallèles, croise les résultats et produit en quelques minutes un rapport expert entièrement sourcé.

Parallèlement, en s’appuyant sur les avancées du projet Astra évoqué plus haut, Google Search intègrera prochainement « Search Live » lui permettant de pointer la caméra de son smartphone et dialoguer instantanément en vocal avec Search sur ce qu’il filme : explications de concepts, conseils ou ressources adaptées s’affichent en temps réel.

Enfin, l’IA va également révolutionner l’expérience Shopping au sein de Google Search avec l’arrivée d’un volet « Agentic Shopping » concrétisation du projet Mariner présenté l’an dernier. Désormais, Google Search analyse des centaines d’offres de billets, applique vos critères (prix, date, place) et préremplit les formulaires d’achat ou de réservation. À terme, une multitude d’agents viendront gérer restaurants, rendez-vous locaux ou tâches administratives sans quitter l’interface Google. Par ailleurs, un nouveau AI Shopping Partner combine le Graphe Shopping de Google et Gemini pour aider à la recherche de produits, et proposer un essayage virtuel de vêtements à partir d’une photo de l’utilisateur ainsi qu’un processus de paiement agentique pour acheter un produit lorsque son prix atteint un seuil défini par l’utilisateur.

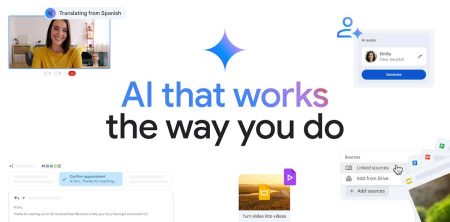

Workspace embarque toujours plus d’IA

Sans surprise, la suite Workspace continue d’intégrer toujours plus l’IA.

Ainsi, Gmail se dote d’une fonction « Personalized Smart Replies » (réponses intelligentes personnalisées) qui s’appuie sur les emails passés et les fichiers Drive pour suggérer des réponses adaptées au contexte et au ton de l’utilisateur tout en intégrant des pièces jointes et liens pertinents sans que vous ayez à les chercher.

Autre nouveauté, une fonction de nettoyage de la boîte de réception « Inbox Cleanup » permettra de supprimer ou archiver des emails via une simple instruction à Gemini (par exemple « Archive tous les courriels non lus du mois dernier »).

Enfin, l’assistance IA pourra aussi suggérer automatiquement des créneaux pour planifier des réunions quand un fil de discussion évoque un rendez-vous et préparera automatiquement l’invitation Calendar correspondante.

Google Docs permet désormais de lier des sources spécifiques pour que Gemini base son assistance rédactionnelle uniquement sur ces contenus. Dit autrement, vous pouvez désormais « ancrer » un Doc à des slides, tableurs ou rapports internes, Gemini se limitant alors à ces seules références pour ses suggestions d’écriture, garantissant ainsi des textes cohérents, contextualisés et sourcés.

Google Vids pourra prochainement transformer des présentations Slides en vidéos, générer des scripts et des voix off, et proposer des avatars IA pour présenter des messages. Des outils d’édition, comme la suppression des mots de remplissage et l’équilibrage du son sont aussi prévus.

Mais la nouveauté la plus spectaculaire est bien évidemment l’arrivée de la traduction vocale en temps réel dans Meet : l’IA traduit en vocal ce que disent vos correspondants en préservant leur voix, leur ton et leurs expressions. La fonctionnalité n’est pour l’instant disponible qu’en bêta pour les abonnés Pro et Ultra et initialement uniquement en anglais et espagnol.

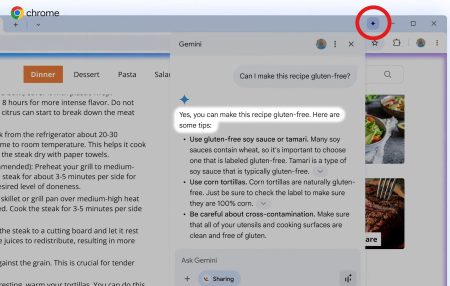

Gemini débarque en force dans Chrome

Microsoft a, dès le début, cherché à insuffler son IA Copilot au cœur du navigateur. Une adoption anticipée qui a conduit l’éditeur à maintes fois changer d’idées et d’interfaces mais qui a posé les bases de ce que l’IA peut apporter à nos navigations Web (la dernière idée géniale de Microsoft étant d’ailleurs le regroupement thématique de tous vos onglets ouverts d’un clic grâce à l’IA).

Google a pris le temps et regardé la concurrence. À Google I/O 2025, l’éditeur a ainsi dévoilé « Gemini in Chrome« .

Gemini in Chrome insuffle l’IA conversationnelle directement dans le navigateur. Son intégration démarrera sur Windows et macOS pour les abonnés Google AI Pro et AI Ultra aux États-Unis.

Dans cette première mouture, un simple clic dans la barre d’outils ouvre une sorte de panneau latéral où Gemini analyse la page courante (ou tous les onglets ouverts) pour en résumer le contenu ou éclaircir les passages complexes, en tenant compte du contexte visuel et textuel affiché à l’écran .

Google promet déjà la prochaine étape : l’assistant saura bientôt jongler entre plusieurs onglets, remplir des formulaires et même naviguer de manière autonome afin d’exécuter des flux de travail complets grâce à des capacités « agentiques » qui s’appuieront sur la technologie « Project Mariner » et resteront réservées aux plans Pro et Ultra dans un premier temps . À terme, Gemini in Chrome ambitionne de transformer le navigateur en véritable poste de pilotage, où l’utilisateur énonce une intention et laisse l’IA parcourir le Web, rassembler les informations utiles et accomplir les tâches sous son contrôle.

Google AI Ultra ou la folie des grandeurs

Pour terminer ce tout d’horizon, difficile de ne pas évoquer l’une des annonces les plus controversées de ce Google I/O. Après OpenAI et son abonnement ChatGPT Pro à 200$ par mois (lancé en Décembre 2024), Anthropic et son abonnement Claude MAX à 200$ par mois, Google aussi cède aux sirènes des « supers abonnements ». Sa nouvelle offre « VIP », Google AI Ultra, coûte 249,99 $ par mois (-50 % les trois premiers mois). L’offre est pour l’instant réservée aux États-Unis.

Google y voit un passe-accès pour créatifs, studios et équipes R&D, mais la note mensuelle soulève déjà la question du retour sur investissement dans des DSI plutôt soucieuses en ce moment de rationaliser leurs dépenses.

Pour ce tarif exorbitant, le forfait propose de relever significativement les limites d’utilisation des différents modèles, notamment vidéos et Deep Research, d’accéder en priorité à Gemini 2.5 Pro « Deep Think » et à Veo 3, de disposer du 1080p sous Google Flow, et d’un stockage de 30 To.

Au-delà de la profusion d’annonces, l’édition 2025 de Google I/O consacre au final un mouvement de fond que les DSI ne peuvent plus ignorer : l’IA générative ne se limite plus à des prouesses techniques ou à l’assistance ponctuelle. Gemini se transforme peu à peu en une couche d’orchestration transversale, pilotant agents autonomes, processus métiers et interactions utilisateurs dans tous les pans du numérique. L’essor des agents IA capables de planifier, agir et rendre compte sur commande préfigure une automatisation d’un nouveau genre, beaucoup plus fine et contextuelle, qui va imposer de repenser la gouvernance des systèmes d’information, la gestion des identités, la supervision et la sécurité.

En outre, la généralisation du multimodal (texte, image, son, vidéo) et l’intégration poussée dans les outils du quotidien font évoluer la promesse de l’IA : il ne s’agit plus simplement d’augmenter la productivité, mais d’hybrider les métiers, de réinventer les usages et de redistribuer les cartes entre fournisseurs, utilisateurs et créateurs de contenu. Les DSI sont désormais en première ligne pour orchestrer ces transformations : elles devront arbitrer entre innovation et maîtrise des risques, piloter la montée en charge des infrastructures IA et accompagner la bascule des compétences internes.

Bien évidemment, ces annonces utilisateurs ne sont que la partie la plus visible des transformations IA qui vont s’opérer dans tous les services et toutes les applications. Et en la matière, Google avait aussi beaucoup de choses à dire et à démontrer. Nous y reviendrons demain dans la seconde partie de notre analyse de ce Google I/O 2025 jusqu’ici très distrayant.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :