Data / IA

NetApp Insight 2025 : Ce qu’il faut en retenir…

Par Laurent Delattre, publié le 20 octobre 2025

Du matériel Flash à la gouvernance sémantique, NetApp fusionne puissance et intelligence. AFX, AIDE et intégrations cloud propulsent le stockage d’entreprise dans une ère où la donnée se prépare, s’entraîne et se protège toute seule.

NetApp Insight est la conférence annuelle de NetApp dédiée à l’infrastructure de données et au cloud. L’édition 2025 s’est tenue la semaine dernière à Las Vegas et a rassemblé clients, DSI, partenaires et experts autour des nouvelles orientations technologiques de NetApp et surtout de l’évolution de sa vision – et par voie de conséquences de ses offres – à l’ère de l’IA générative et agentique. NetApp se voit désormais comme une « entreprise de l’infrastructure de données intelligente ». Et l’éditeur-constructeur a voulu frapper fort en dévoilant des annonces majeures qui redéfinissent l’infrastructure de données pour l’ère de l’intelligence artificielle. Au cœur de ces annonces, le nouveau système AFX et l’AI Data Engine promettent de transformer radicalement la façon dont les entreprises gèrent et exploitent leurs données pour l’IA.

NetApp AFX : du stockage désagrégé pour l’IA

Le « stockage désagrégé » semble désormais s’installer durablement dans le paysage. Présentée comme l’architecture la plus adoptée aux défis de l’IA, l’approche désagrégée fait aussi son chemin chez NetApp. Contrairement aux baies traditionnelles où les contrôleurs de stockage et les disques forment un bloc indissociable, le principe du stockage désagrégé est de séparer les ressources de calcul (contrôleurs, traitement) des ressources de capacité (nœuds de stockage) et de les interconnecter via un réseau interne très rapide. Cette approche permet de faire évoluer indépendamment la performance et la capacité, offrant une échelle horizontale (scale-out) quasi-illimitée pour répondre aux besoins massifs des workloads de l’IA. Née chez des innovateurs comme VAST Data puis adopté par HPE, Pure Storage ou Qumulo, l’approche permet non seulement un accès parallèle aux données plus efficace mais offre également l’avantage de bien s’intégrer aux environnements hybrides. C’est d’autant plus vrai chez NetApp où les services ONTAP (SnapMirror, tiering, intégrations cloud) orchestrent déjà des données réparties sur site et dans le cloud.

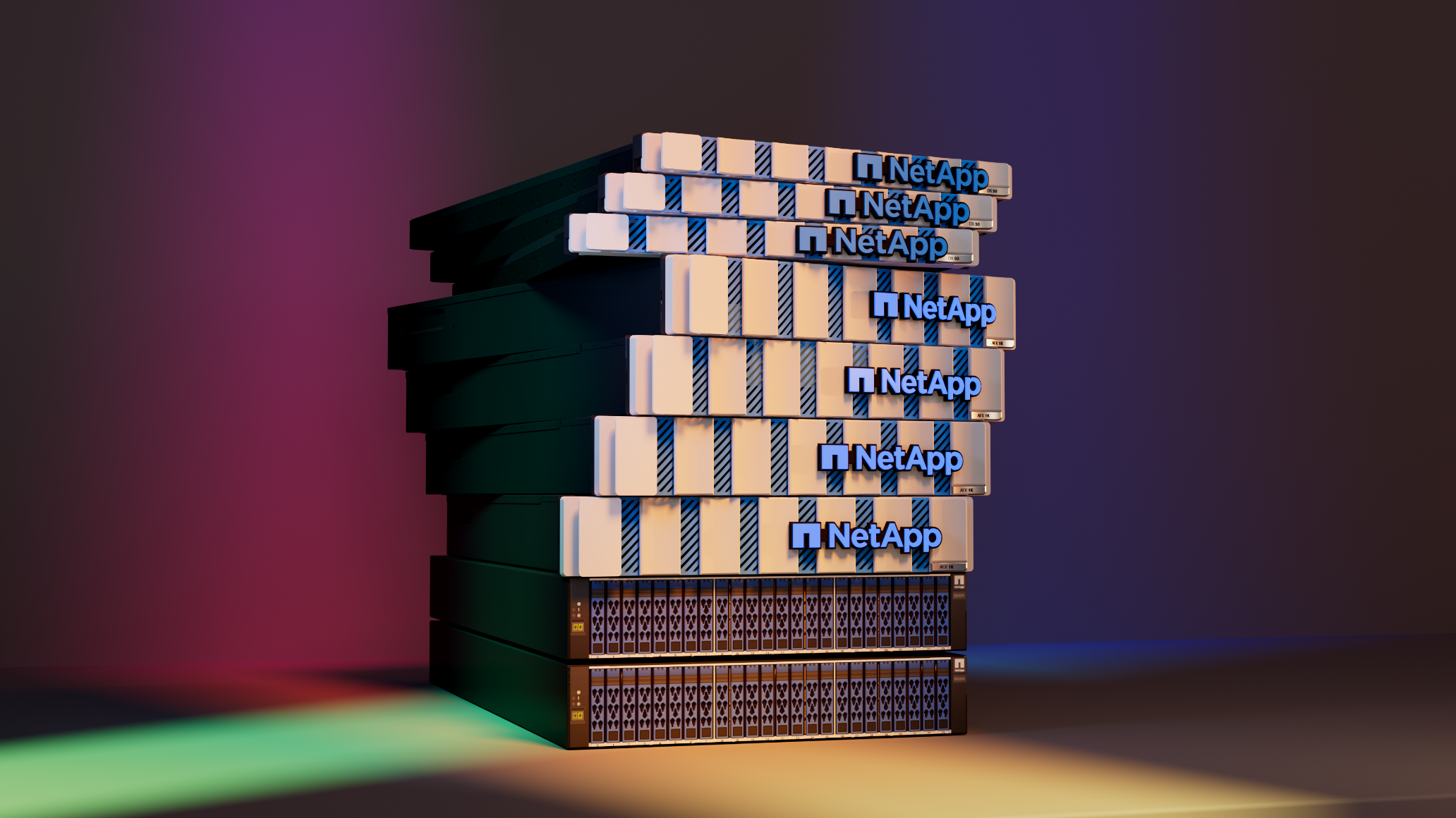

Pas étonnant dès lors de voir NetApp présenter le stockage désagrégé comme une architecture « modern AI-scale » alliant scalabilité et services de données d’entreprise que le constructeur concrétise aujourd’hui avec le lance d’une nouvelle gamme de baies désagrégées 100% Flash : NetApp AFX.

Conçues pour le stockage désagrégé à grande échelle, les baies NetApp AFX sont présentées comme de véritables « usines à IA ». Il s’agit d’un système entièrement nouveau (et non d’un rebranding d’une gamme existante), qui exploite le système d’exploitation de stockage ONTAP sur une infrastructure matérielle repensée pour l’exascale. AFX repose ainsi sur :

– Des contrôleurs de stockage AFX 1K : Ces châssis 2U embarquent un contrôleur ONTAP. Chaque AFX 1K dispose de 11 slots d’extension PCIe Gen5 pour intégrer des cartes additionnelles. C’est le “cerveau” qui gère le stockage et expose les données via les protocoles standards (NAS et SAN).

– Des nœud de calcul DX50 (optionnels) : Ces serveurs 1U sont équipés d’un processeur AMD Genoa 9554P et d’un GPU Nvidia L4. Ils n’hébergent pas de données mais fournissent de la puissance de traitement dédiée aux services avancés (nous y reviendrons plus loin avec l’AI Data Engine). Ils alimentent notamment le moteur de métadonnées AFX chargé d’indexer en continu les données stockées et d’exécuter des tâches de préparation de données sans impacter les performances des workloads principaux.

– Des boîtiers de stockage NX224 : des tiroirs NVMe 2U abritant jusqu’à 24 SSD NVMe (capacités de 7,6 To à 60 To chacun) pour constituer un pool de stockage flash unifié. Ces boîtiers apportent la capacité brute.

Un cluster AFX peut agréger jusqu’à 128 contrôleurs AFX 1K en réseau, associés à un maximum de 52 boîtiers NVMe (NX224) et 10 nœuds de calcul DX50, ce qui permet d’atteindre plus d’1 exaoctet de capacité effective. L’interconnexion interne s’appuie sur des switches Cisco Nexus 400 Gb/s assurant la bande passante nécessaire au trafic entre nœuds. À l’échelle maximale, NetApp évoque un débit de l’ordre de plusieurs téraoctets par seconde à travers le cluster, de quoi alimenter des supercalculateurs IA.

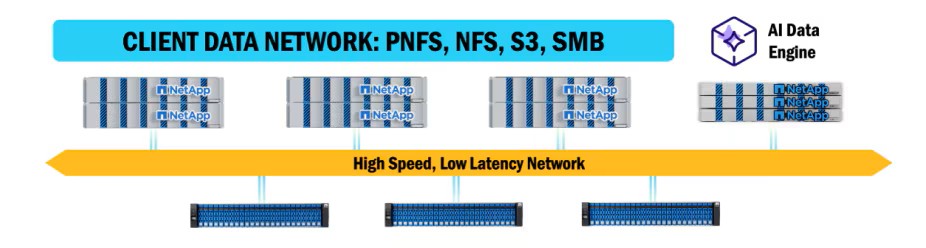

La grande force des systèmes NetApp AFX est qu’ils restent des systèmes ONTAP. Un cluster AFX hérite de toutes les fonctions d’entreprise de ONTAP, du support multiprotocole (NFS v3/v4, pNFS, NFS/RDMA, SMB et S3) à l’interopérabilité avec les autres baies NetApp AFF/FAS (via SnapMirror, SVM-DR, FlexCache, etc.) en passant par la sauvegarde, la réplication, la gestion multi-tenant, le clonage, les snapshots et bien évidemment l’intégration aux clouds (CloudSync, XCP).

De quoi permettre à NetApp de faire une entrée fracassante dans l’ère du stockage scale-out pour l’IA. Mais le matériel n’est qu’une partie de l’équation du stockage IA… Et NetApp a donc poussé sa réflexion au-delà.

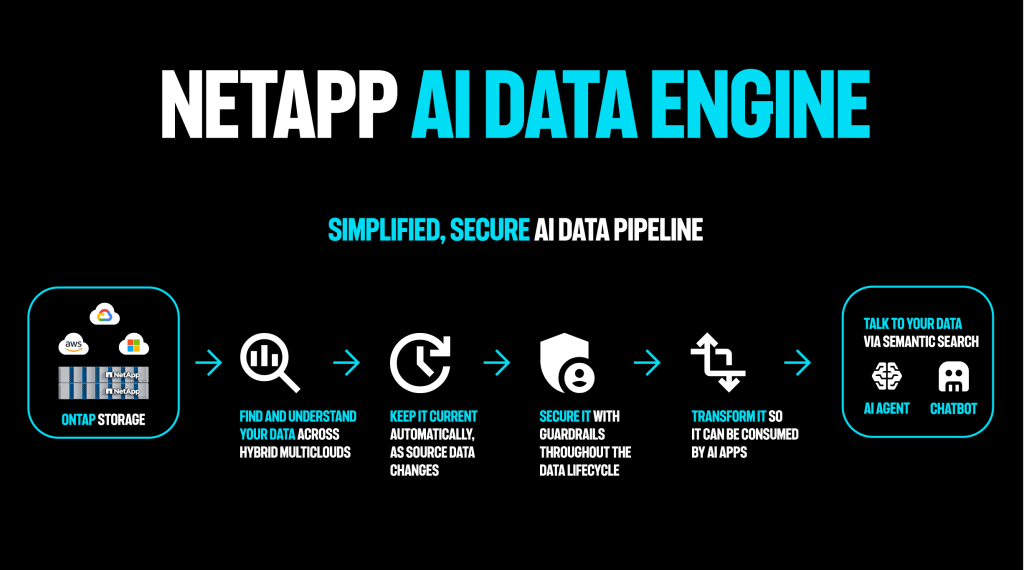

NetApp AI Data Engine : accélérer les pipelines de données pour l’IA

L’AI Data Engine (AIDE) de NetApp constitue ainsi le deuxième pilier de cette offensive IA. Présenté comme une extension unifiée et sécurisée d’ONTAP dédiée aux données d’IA, l’AI Data Engine regroupe un ensemble d’outils et services pour simplifier et automatiser les pipelines de données d’IA. « NetApp AIDE permet aux clients de connecter de manière transparente l’ensemble de leur patrimoine de données à travers des environnements multicloud hybrides pour construire une fondation de données unifiée », expliquent les responsables du projet.

On le sait tous, et Gartner comme NetApp nous le rappellent régulièrement, une part importante des projets d’IA échouent ou stagnent en raison de la difficulté à réunir des données « AI-ready » (propres, à jour, facilement exploitables par les modèles). NetApp AIDE a précisément pour mission de fournir une base de données unifiée pour l’IA, en prenant en charge l’ingestion des données, leur transformation, leur gouvernance et leur livraison aux modèles IA, via une seule interface de contrôle en tirant pleinement profit de l’architecture désagrégée du stockage NetApp AFX.

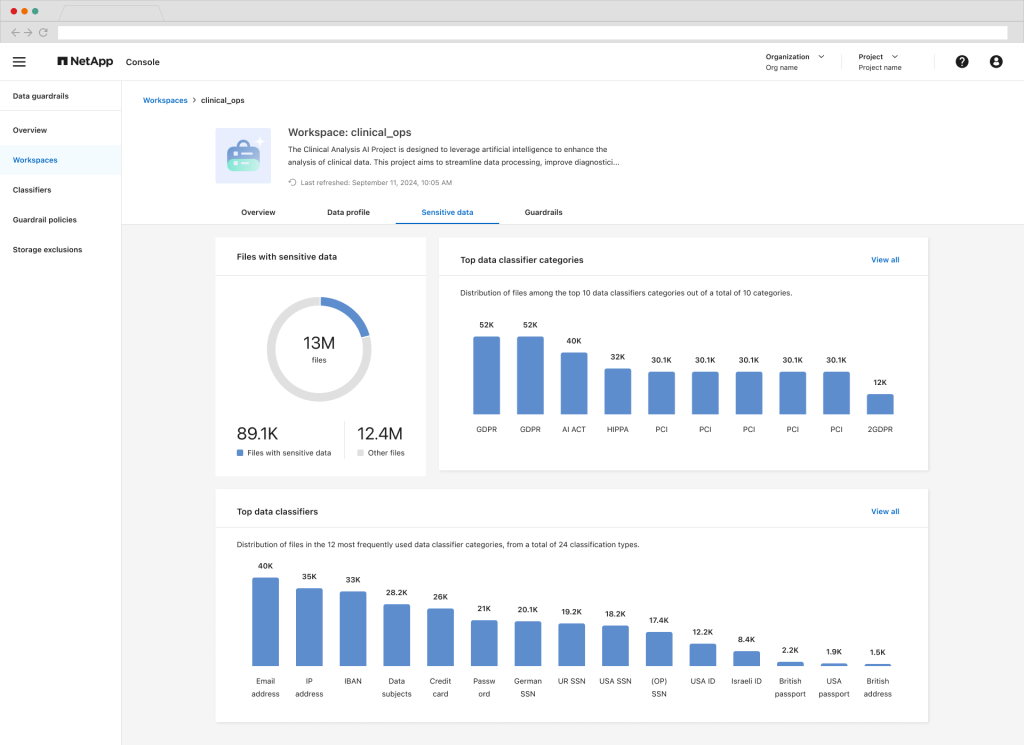

Concrètement, NetApp AI Data Engine est un pipeline ETL intelligent intégré au stockage (ONTAP/AFX) qui maintient un catalogue de métadonnées global couvrant on-prem et clouds publics. Il indexe en continu chaque fichier, base ou objet via un moteur distribué (exécuté sur les nœuds DX50) interrogeable en SQL. Côté préparation, AIDE convertit à la volée les documents en embeddings et les indexe dans sa base vectorielle intégrée, réduisant les pipelines externes et appliquant le principe « bring AI to the data ». L’ajout de graphes de connaissances est prévu pour les données structurées. Cette solution automatise la détection des changements de données et la synchronisation, éliminant les copies redondantes tout en garantissant que les données restent toujours à jour. La synchronisation s’appuie sur SnapMirror/SnapDiff pour propager automatiquement les mises à jour et éviter tout décalage entre production et analytique. Des garde-fous de gouvernance (classification, PII, politiques automatiques) préservent droits et permissions d’origine.

Il émerge de tout ceci une recherche sémantique unifiée à grande échelle et une grande simplification des cas d’usage RAG mais également une plus grande facilité pour entraîner, réentraîner ou fine-tuner des modèles directement alimentés par AIDE.

Techniquement, NetApp AIDE s’appuie sur la NVIDIA AI Data Platform (reference design) et sur un ensemble de bibliothèques et outils optimisés qui servent de fondation à l’offre NVIDIA AI Enterprsie. En particulier, AIDE utilise les microservices NVIDIA NIM pour la vectorisation et la recherche, et bénéficie de l’accélération matérielle GPU.

Actuellement, la plateforme NetApp AIDE tourne nativement au sein du cluster AFX, sur les nœuds DX50 optionnels (qui ne le sont plus lorsqu’on utilise AIDE), et pourra à l’avenir exploiter des serveurs d’appoint équipés des GPU NVIDIA RTX Pro 6000 (architecture Blackwell) pour encore plus de puissance IA.

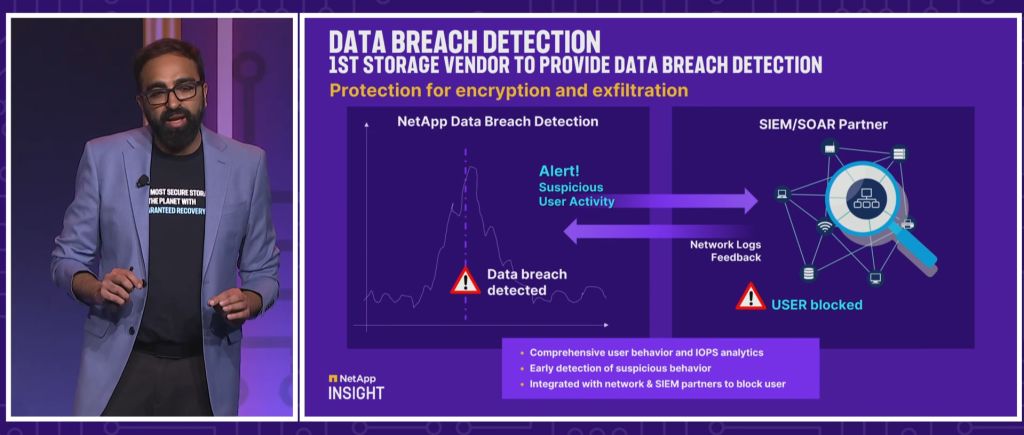

La cybersécurité au cœur de la stratégie

NetApp renforce également sa position sur le front de la cybersécurité avec l’évolution de son service de protection contre les ransomwares, désormais rebaptisé NetApp Ransomware Resilience. « Pour protéger efficacement vos données d’une cyberattaque, vous devez savoir qu’elle s’est produite le plus tôt possible pour agir », souligne Gagan Gulati, Senior Vice President et General Manager des Data Services chez NetApp. Outre la détection des chiffrements préexistante, La nouveauté majeure réside dans la capacité de détection des exfiltrations de données, une première dans l’industrie selon NetApp. Cette fonctionnalité « Data Breach Detection) alimentée par l’IA identifie les comportements anormaux qui pourraient indiquer des tentatives de violation et fuite de données, permettant aux entreprises de bloquer les transferts non autorisés avant qu’ils ne causent des dommages importants. Dès qu’une suspicion d’exfiltration apparaît, Ransomware Resilience envoie une alerte immédiate via les outils SIEM du client, avec les informations forensiques nécessaires.

Parallèlement, NetApp lance des Clean Rooms, autrement dit des environnements de récupération directement intégrés à sa solution de stockage. Si une attaque a réussi à chiffrer ou corrompre des données, NetApp propose désormais un mode de restauration sécurisé et guidé. Concrètement, Ransomware Resilience peut créer un environnement de quarantaine isolé où les données suspectes sont dupliquées sans risque de contaminer le reste du système. Dans cet espace isolé, des algorithmes analysent les données pour identifier précisément le point de compromission – c’est-à-dire quel fichier a été altéré et à quel moment – grâce à une analyse chronologique des modifications. L’outil guide ensuite les administrateurs pour restaurer les dernières copies saines des données impactées, pas à pas, en veillant à éliminer tout résidu du malware avant de réintégrer les données dans l’environnement de production. Cette approche facilite grandement la reprise après incident en offrant une sorte de bulle de désinfection où restaurer les données critiques en toute confiance.

GCNV : Google Cloud NetApp Volumes et l’intégration de l’IA

Parallèlement, NetApp continue ses efforts d’accompagnement des clients dans le Cloud. Et l’éditeur enrichit Google Cloud NetApp Volumes (GCNV), son service ONTAP managé par Google et exposé nativement dans GCP. Ce dernier devient aussi complet que son alternative sur Azure. Jusqu’ici l’implémentation Google Cloud fournissait des volumes de fichiers NFS v3/v4.1 et SMB avec l’arsenal classique d’ONTAP (snapshots, clones, réplication inter-régions, backup).

À Insight 2025, NetApp et Google l’ont étendu pour en faire un stockage véritablement unifié et orienté workloads d’entreprise et d’IA. GCNV prend désormais en charge le mode bloc via iSCSI, notamment avec le niveau de service Flex, ce qui simplifie la migration d’applications exigeant du SAN (bases de données, environnements VMware, etc.). Il s’intègre en outre nativement à l’IA de Google (Gemini) afin de consommer directement les données stockées dans NetApp Volumes comme base de connaissances, sans pipelines complexes ni RAG à coder, pour bâtir des agents génératifs adossés à des données d’entreprise contrôlées. Grâce à FlexCache, GCNV propose un namespace global unifié permettant de fédérer et mettre en cache à la demande des jeux de données ONTAP on-premises ou dans d’autres clouds, ouvrant la voie à des scénarios hybrides et multicloud tels que migration progressive, bursting, continuité d’activité et réversibilité, avec synchronisation SnapMirror en arrière-plan.

« Avec les améliorations apportées à Google Cloud NetApp Volumes, incluant l’ajout de capacités de stockage en bloc, nous donnons aux entreprises plus de flexibilité et de puissance, sans complexité ajoutée », annonce Pravjit Tiwana, Senior Vice President et General Manager du Cloud Storage chez NetApp. Cette évolution s’accompagne d’une intégration renforcée avec Google Cloud Vertex AI et Azure NetApp Files, permettant aux entreprises d’exploiter leurs données directement depuis ces services cloud pour leurs applications d’IA, sans avoir besoin de les déplacer ou de les copier.

Pour rester dans le Cloud, NetApp a également annoncé une nouveauté importante pour Azure NetApp Files (ANF), son service de fichiers managé sur Azure. Une nouvelle API de type objet (S3) est disponible en préversion pour accéder aux données ANF. Ainsi, les entreprises n’ont plus besoin de déplacer ou copier leurs données de fichiers vers un data lake pour les exploiter avec les services analytiques d’Azure. Désormais, un dataset NFS/SMB stocké dans ANF peut être exposé via l’API objet aux outils Azure tels que Microsoft Fabric, Azure OpenAI, Azure Databricks, Synapse, Cognitive Search, Azure Machine Learning, etc., sans duplications. Cette innovation supprime un frein majeur à l’adoption de services AI/analytics sur Azure, en rendant interopérables les mondes du fichier et de l’objet. Les clients peuvent ainsi analyser, entraîner des modèles IA ou faire de la recherche intelligente directement sur leurs données existantes dans ANF, tout en bénéficiant des performances et garanties de NetApp.

Autres annonces et partenariats

Si AFX, AI Data Engine, Ransomware Resilience et GCNV constituaient les grands piliers d’innovations de ce NetApp Insight 2025, d’autres annonces sont aussi venues animer les débats.

Ainsi, face aux bouleversements du marché de la virtualisation engendrés par le rachat de VMware et les changements de stratégie de Broadcomm, NetApp lance le Shift Toolkit, un outil qui promet de réduire drastiquement les temps de migration des machines virtuelles. Un client a pu réduire le temps d’arrêt de migration pour des milliers de VMs de 20 TB de 4 jours à seulement 5 minutes par VM, illustrant le potentiel transformateur de cette solution.

Par ailleurs, NetApp et Red Hat lancent de nouvelles solutions conjointes mêlant les technologies des deux éditeurs : par exemple, ils combinent OpenShift Virtualization avec Amazon FSx for NetApp ONTAP (stockage ONTAP managé sur AWS) ou encore intègrent Google Cloud NetApp Volumes à OpenShift Dedicated (offre OpenShift managée sur GCP). L’objectif est de faciliter la vie des clients communs qui souhaitent déployer des environnements Kubernetes/OpenShift avec un stockage NetApp de haut niveau, que ce soit sur AWS ou Google Cloud.

Parallèlement, NetApp a annoncé exploiter désormais Red Hat OpenShift Virtualization pour ses propres environnements de développement et test, ce qui améliore son agilité interne et montre sa confiance dans l’écosystème OpenShift.

Autre partenariat annoncé, celui avec Equinix visant les clients SAP migrants vers S/4HANA. Les deux entreprises combinent leur savoir-faire pour proposer une solution d’hébergement des environnements SAP dans des centres Equinix, en s’appuyant sur une infrastructure virtualisée VMware Cloud Foundation (VCF) associée au stockage NetApp ONTAP. Cette approche “colocation + cloud privé” prétend permettre optimiser les coûts, la performance et la sécurité pour les clients SAP, en tirant parti de l’expertise d’Equinix et de NetApp pour cette transition critique.

Cet Insight 2025 aura, au final, illustré un nouveau changement de cap de l’éditeur et une nouvelle vision visant à faire de NetApp la plateforme de données unifiée, intelligente et solide de l’ère IA. Avec AFX et AI Data Engine, l’intelligence descend au plus près des données (indexation globale, vectorisation, accélération GPU intégrées) pour éviter les usines à gaz et transformer plus vite les volumes dispersés en actifs exploitables et gouvernés.

Cette vision ambitieuse, conjuguée au scale-out désagrégé et aux fondamentaux ONTAP, cherche à sécuriser les paris IA et accélérer le time-to-value, deux indispensables qui font aujourd’hui souvent défaut lors du passage des PoC IA en production. Dans le même mouvement, NetApp muscle la cyber-résilience et l’hybridation multi-cloud (Google Cloud, Azure, Red Hat) afin que les données soient toujours prêtes : prêtes à être protégées, prêtes à alimenter les modèles IA, prêtes à propulser les usages métiers où qu’elles résident.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :