Data / IA

18 % seulement : la confiance des développeurs dans l’IA reste faible

Par Laurent Delattre, publié le 26 novembre 2025

Voilà une étude pleine de contraste. Elle montre que si l’IA est très fortement adoptée et que si les gains de productivité sont indéniables, les développeurs restent hyper méfiants face aux résultats promis. Malgré ses progrès récents, l’IA continue de ne pas inspirer confiance…

À peine 18 % ! C’est la part de développeurs et de responsables techniques qui déclarent « faire pleinement confiance » aux réponses de l’IA générative appliquée au code. Ce résultat, mis en lumière par une nouvelle étude Techreviewer, contraste avec l’enthousiasme opérationnel rencontré sur le terrain et qui traverse les équipes de l’ingénierie logicielle. Car ces mêmes répondants plébiscitent l’apport de l’IA: 85 % jugent leur productivité en hausse et 78 % se disent satisfaits des outils mis à disposition. La promesse d’un « pair programmer » s’impose, mais sous surveillance. Plus étonnant encore, ils sont 64% à expliquer que l’IA a effectivement permis d’améliorer la qualité du code.

Résultat de ce manque de confiance, la plupart des entreprises considèrent tout code généré par IA comme un brouillon et près de 78% des entreprises procèdent à une vérification quasi systématique par des développeurs humains du code généré.

Des bénéfices indéniables pour la productivité

Le paradoxe, c’est que malgré cette faible confiance, l’adoption de l’IA dans le cycle de développement des logiciels est massive : 64 % des répondants utilisent un assistant IA chaque jour et seulement 2 % déclarent ne jamais y recourir.

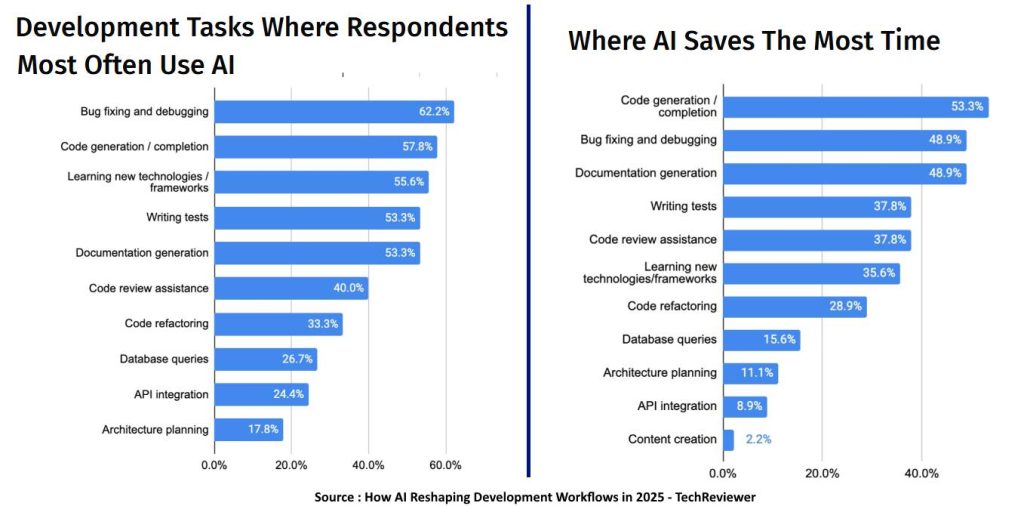

Les cas d’usage les plus cités confirment une logique d’assistance ciblée : débogage (62%), génération ou complétion de code (58%), apprentissage de nouvelles technologies de dev (56%) ; écriture de tests (53%), génération automatique de documentation (53%), revue de code (40%)… Autant de tâches où les gains de temps sont immédiats et mesurables. Reste que le classement diffère un peu sur les usages où l’IA fait gagner le plus de temps. La génération de code arrive en tête, devant le debugging et la génération de documentation. Les pans plus créatifs ou contextuels, comme la conception d’architecture ou certaines intégrations d’API, demeurent majoritairement pilotés par les humains.

Des outils encore dominés par ChatGPT

L’étude ne s’intéresse pas uniquement aux usages et dirige aussi son projecteur sur les outils. En la matière, l’écosystème reste largement dominé par ChatGPT (84 % d’usage), tandis que Claude Code refait son retard pour atteindre 64 %, GitHub Copilot se contente d’une étonnante troisième position à 56 % (on l’attendait plus haut) suivi, et c’est moins surprenant, par Cursor à 53 %. Cette omniprésence de ChatGPT étonne encore alors que la plupart des environnements de développement incorporent désormais de l’IA générative évitant aux développeurs de basculer sans cesse entre leur IDE et ChatGPT. Il sera intéressant de voir comment ces chiffres évoluent dans les prochains mois alors que les outils se multiplient sur le marché avec l’arrivée récente de Visual Studio 2026, OpenAI Codex, Gemini Code Assist, Junie, Google Jules, etc.

Des erreurs fréquentes et des risques à surveiller

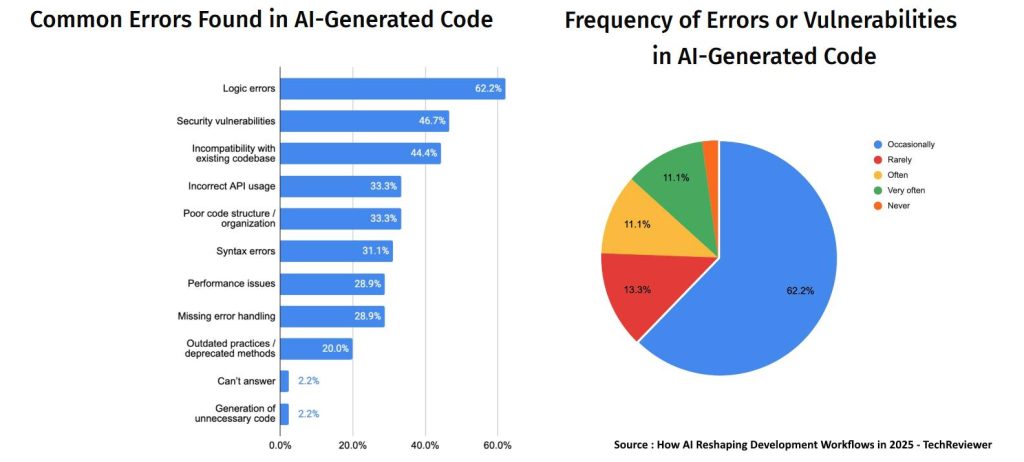

Mais au juste, pourquoi la confiance dans le code généré par IA est-elle si faible ? L’étude Techreviewer s’est notamment intéressée aux erreurs fréquemment rencontrées dans les codes générés. Preuve du manque encore flagrant de raisonnement des IA, 62% des erreurs sont des erreurs de logique. Et près de 47% des erreurs repérées sont des vulnérabilités présentes dans le code généré. En l’occurrence seuls 2,2% des développeurs interrogés n’ont jamais rencontré de bugs ou vulnérabilités dans les codes générés par les IA.

Des enjeux éthiques et réglementaires majeurs

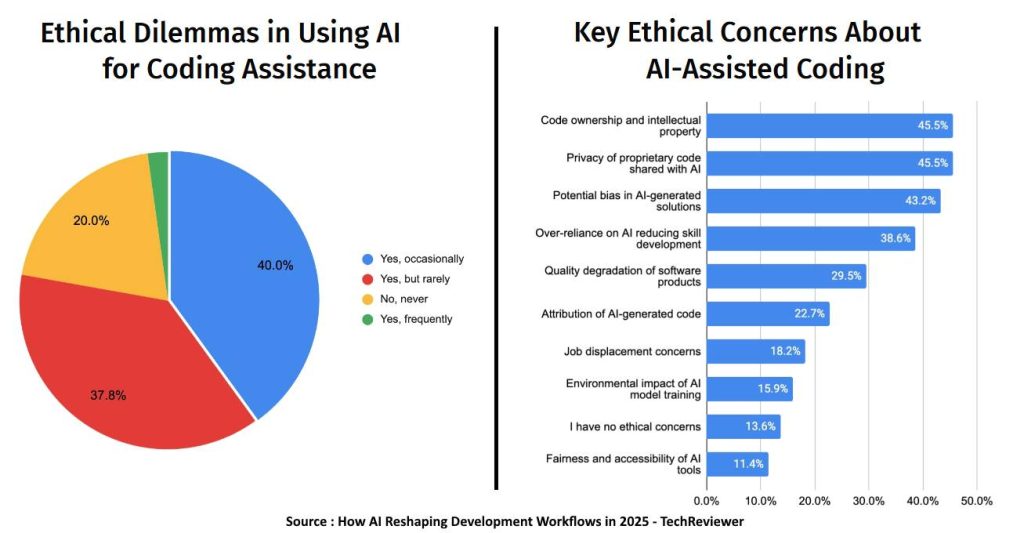

Pour les DSI, l’enjeu se déplace de l’expérimentation vers l’industrialisation responsable. L’étude pointe un angle mort : quatre répondants sur cinq disent avoir été confrontés au moins une fois à un dilemme éthique lié au code assisté par IA.

Les préoccupations remontent à la surface : propriété intellectuelle et réutilisation de snippets, confidentialité des données engagées dans les prompts, biais potentiels dans les propositions de code.

Plus gênant : une équipe sur cinq ne révèle jamais aux clients son recours à l’IA. Autant de risques réputationnels, contractuels et réglementaires qui imposent de clarifier les règles du jeu.

Désormais, l’urgence consiste moins à « adopter » l’IA – c’est déjà fait – qu’à en cadrer son usage. Concrètement, trois chantiers structurants se dégagent pour les DSI. D’abord, formaliser une politique d’usage couvrant prompts, secrets et logs, avec des garde‑fous contractuels côté fournisseurs et intégrateurs. Ensuite, intégrer l’IA dans la fabrique logicielle sans casser les contrôles : définir des seuils d’acceptation, tracer les contributions machine, systématiser la revue de code et les tests. Enfin, instaurer la transparence vis‑à‑vis des clients et métiers, en explicitant quand et comment l’IA intervient dans le code livré. C’est à ce prix que les gains de vélocité se traduiront en fiabilité et en conformité. En attendant, les IA auront le temps de gagner en intensité de raisonnement et en qualité de réponses.

À LIRE AUSSI :

À LIRE AUSSI :