Cloud

AWS Re:Invent 2019 : le cloud ne fait que démarrer…

Par Laurent Delattre, publié le 06 décembre 2019

Aucun ralentissement n’est à prévoir dans la capacité à innover d’AWS. Le leader des hyperscalers l’a une nouvelle fois démontré lors de son événement « Re:invent 2019 ». Voici ce que les DSI doivent en retenir.

L’expression qui définit le mieux cette édition 2019 d’AWS « Re:Invent » est sans aucun doute « Feu d’artifice ». Il y régnait une agitation frénétique rythmée par un flot d’annonces partant dans tous les sens. Amazon y a parlé SaaS, PaaS, IaaS bien sûr, mais aussi edge, IoT, cloud hybride, HPC, intelligence artificielle, développement, containers, kubernetes, serverless, bases de données, musique, médecine, etc. Difficile dès lors de trouver dans tout cela une histoire cohérente, un axe fort. Voici donc, un peu en vrac, tel un feu d’artifice multicolore ce qu’il faut retenir de cet événement un peu fou…

L’expression qui définit le mieux cette édition 2019 d’AWS « Re:Invent » est sans aucun doute « Feu d’artifice ». Il y régnait une agitation frénétique rythmée par un flot d’annonces partant dans tous les sens. Amazon y a parlé SaaS, PaaS, IaaS bien sûr, mais aussi edge, IoT, cloud hybride, HPC, intelligence artificielle, développement, containers, kubernetes, serverless, bases de données, musique, médecine, etc. Difficile dès lors de trouver dans tout cela une histoire cohérente, un axe fort. Voici donc, un peu en vrac, tel un feu d’artifice multicolore ce qu’il faut retenir de cet événement un peu fou…

Les serveurs Outposts sont là

L’an dernier, AWS avait annoncé son projet Outposts, sa solution cloud hybride pour les datacenters d’entreprise. L’offre est désormais disponible avec une idée forte « offrir AWS on-premise ». Outposts, ce sont des serveurs AWS qu’Amazon installe dans vos datacenters et administre pour vous. Ils embarquent EC2 (Elastic Compute Cloud), EBS (Elastic Block Store), Virtual Private Cloud, ECS (Elastic Container Service), EKS (Elastic Kubernetes Service), EMR (Elastic MapReduce). Le stockage objet S3 n’est lui annoncé que pour 2020. Ces serveurs se comportent comme une « Availability Zone AWS » privée et placée dans votre datacenter pour obtenir une réactivité maximale. L’approche hybride d’Amazon est donc assez atypique, un peu à mi-chemin entre l’approche 100% logicielle de Google avec Anthos et celle plus matérielle de Microsoft avec ses appliances Azure Stack produites par ses partenaires du monde des serveurs. Avec cette différence majeure que sur Outposts, l’entreprise n’a aucun contrôle réel sur cette infrastructure installée chez elle. À termes, AWS compte déléguer les tâches d’installation à des intégrateurs.

L’an dernier, AWS avait annoncé son projet Outposts, sa solution cloud hybride pour les datacenters d’entreprise. L’offre est désormais disponible avec une idée forte « offrir AWS on-premise ». Outposts, ce sont des serveurs AWS qu’Amazon installe dans vos datacenters et administre pour vous. Ils embarquent EC2 (Elastic Compute Cloud), EBS (Elastic Block Store), Virtual Private Cloud, ECS (Elastic Container Service), EKS (Elastic Kubernetes Service), EMR (Elastic MapReduce). Le stockage objet S3 n’est lui annoncé que pour 2020. Ces serveurs se comportent comme une « Availability Zone AWS » privée et placée dans votre datacenter pour obtenir une réactivité maximale. L’approche hybride d’Amazon est donc assez atypique, un peu à mi-chemin entre l’approche 100% logicielle de Google avec Anthos et celle plus matérielle de Microsoft avec ses appliances Azure Stack produites par ses partenaires du monde des serveurs. Avec cette différence majeure que sur Outposts, l’entreprise n’a aucun contrôle réel sur cette infrastructure installée chez elle. À termes, AWS compte déléguer les tâches d’installation à des intégrateurs.

Des mini-datacenters locaux

AWS Local Zones s’inscrit plus largement dans le cadre du Edge et de proximité des ressources. Il s’agit de micro-datacenters, déployés et orchestrés par Amazon, qui ne proposent qu’une fraction des services d’AWS, ceux à même de servir des applications à besoin de faible latence. Amazon évoque le jeu en streaming, l’intelligence artificielle, les serveurs de publicité, etc. Chaque « Local Zone » est construite comme une extension d’une région AWS.

Lors de « Re:Invent 2019 », AWS a ouvert (en bêta) sa première « Local Zone » à Los Angeles.

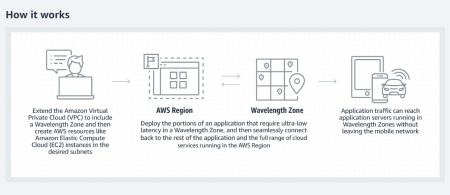

AWS s’infiltre chez les opérateurs 5G

Autre annonce qui s’inscrit dans la même philosophie que les deux précédentes, AWS Wavelength cherche à profiter des avantages de la 5G et s’inscrit dans une philosophie Edge Computing. L’idée est de permettre l’installation de serveurs AWS dans les datacenters des opérateurs de télécommunication à l’extrémité des réseaux 5G afin de permettre l’exécution d’applications qui ont besoin de latence extrêmement faible : flux de télévision, systèmes de surveillance vidéo automatisés, IA au plus proche des IoT, réalité virtuelle et augmentée (VR/AR). Le principe est donc d’avoir des « Wavelength Zones » autrement dit des « Availability Zones » d’Amazon à l’Edge, directement placées sur les réseaux des opérateurs et s’appuyant sur des connexions locales en 5G.

Autre annonce qui s’inscrit dans la même philosophie que les deux précédentes, AWS Wavelength cherche à profiter des avantages de la 5G et s’inscrit dans une philosophie Edge Computing. L’idée est de permettre l’installation de serveurs AWS dans les datacenters des opérateurs de télécommunication à l’extrémité des réseaux 5G afin de permettre l’exécution d’applications qui ont besoin de latence extrêmement faible : flux de télévision, systèmes de surveillance vidéo automatisés, IA au plus proche des IoT, réalité virtuelle et augmentée (VR/AR). Le principe est donc d’avoir des « Wavelength Zones » autrement dit des « Availability Zones » d’Amazon à l’Edge, directement placées sur les réseaux des opérateurs et s’appuyant sur des connexions locales en 5G.

On retrouve ici cette volonté de multiplier les « Availability Zone » d’AWS sans pour autant qu’Amazon n’ait à déployer de nouveaux datacenters complets.

Le Serverless se peaufine

Chez AWS, comme chez ses concurrents, le « serverless » prend plusieurs formes. Celui des bases de données totalement élastiques (ce qu’Oracle qualifie d’autonomous databases) d’abord, celui des « serverless functions » ensuite, celui des « containers as a service » enfin.

Côté Serverless Functions, AWS a annoncé une innovation : Provisioned Concurrency for Lambda Functions. Cette fonctionnalité offre davantage de contrôle sur l’exécution de fonctions nécessitant plus de réactivité : elle garde les fonctions pré-initialisées et dans un état d’éveil permettant une réponse en quelques millisecondes.

Côté « Container as a Service », Amazon lance « EKS on AWS Fargate ». Fargate est la plateforme CaaS d’AWS. Les développeurs déposent simplement leurs containers sur AWS sans se soucier d’infrastructure, de serveurs ou de clusters. Avec cette nouvelle annonce, les développeurs ont désormais la même souplesse sous Kubernetes : ils n’ont qu’à déposer leurs Pods sans se soucier de provisionnement et de gestion d’infrastructure. Une souplesse qui est celle également recherchée par Knative par exemple ou son adaptation GCP/Anthos « Google Cloud Run » mais aussi par AKS sur Azure.

AWS épouse Cassandra

Côté bases données « as a service », AWS dispose déjà d’une offre bien fournie avec Aurora, RDS (Managed PostgreSQL), Redshift, DynamoDB, Elasticache, Neptune, TimeStream, QLDB, DocumentDB (compatible MongoDB).

AWS a annoncé ajouter Cassandra à cette longue liste avec « Amazon Managed Apache Cassandra Service ». Avec AMACS, les développeurs peuvent exécuter leurs applications Cassandra sur AWS sans rien changer à leur code et en utilisant les mêmes outils de développement que ceux qu’ils utilisent en interne. Mais ils n’ont rien à provisionner, pas de serveurs à gérer, pas d’installation à réaliser et à maintenir. C’est un pur service « serverless » où l’entreprise ne paye que les ressources utilisées et qui adapte automatiquement les tables (à la hausse comme à la baisse) en fonction des besoins.

Du nouveau pour les fans de VMs

Il n’y a pas que Kubernetes et les containers dans la vie… Les VMs sont toujours là et ne disparaîtront pas de sitôt… EC2 Image Builder, introduit en preview, est un nouveau service qui accélère et simplifie la création, la maintenance, la validation, le partage et le déploiement sur Amazon EC2 des images Amazon Linux 2 et Windows Server grâce à des pipelines automatisés pré-construits qui vous évite d’avoir à bâtir les votre. Bien sûr Image Builder fournit aussi des mécanismes de mises à jour automatique des images.

Il n’y a pas que Kubernetes et les containers dans la vie… Les VMs sont toujours là et ne disparaîtront pas de sitôt… EC2 Image Builder, introduit en preview, est un nouveau service qui accélère et simplifie la création, la maintenance, la validation, le partage et le déploiement sur Amazon EC2 des images Amazon Linux 2 et Windows Server grâce à des pipelines automatisés pré-construits qui vous évite d’avoir à bâtir les votre. Bien sûr Image Builder fournit aussi des mécanismes de mises à jour automatique des images.

Dans un même ordre d’idées, AWS lance également une nouvelle expérience BYOL (Bring Your Own License » pour Windows Server et SQL Server. Les entreprises peuvent exécuter les workloads Windows Server et SQL Server sur AWS en apportant leurs propres licences, AWS offrant une interface de gestion et de suivi afin d‘assurer la conformité avec les contrats que l’entreprise cliente a signés avec Microsoft.

Une application industrielle de IoT

L’IoT était aussi à l’honneur avec une mise à niveau d’AWS IoT SiteWise, un service à notre connaissance toujours en Preview et destiné aux équipements industriels (IIoT). De nouvelles fonctions font leur apparition comme la possibilité de créer une représentation virtuelle de votre usine. Une nouvelle application SaaS dénommée AWS IoT SiteWise Monitor vous permet de suivre, visualiser et même interagir avec les données collectées par SiteWise et les différentes métriques de performance de production.

Le Machine Learning gagne en puissance

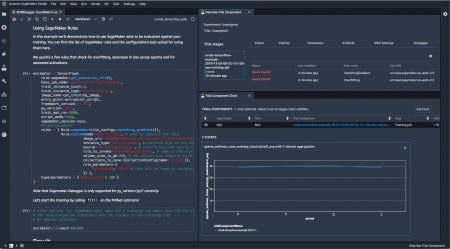

Avec SageMaker, AWS possède une solide offre PaaS en matière de Machine Learning mais la concurrence en ce domaine est assez féroce. L’hyperscaler a donc veillé à étoffer son offre pour reprendre l’avantage. SageMaker Studio est un IDE dédié aux data scientists et aux développeurs pour fluidifier le dialogue mais aussi permettre de construire, entraîner, tester, ajuster et déployer les modèles depuis une seule et même interface. L’IDE simplifie l’accès aux différents outils comme le débugger, l’outil de monitoring de SageMaker, etc. L’IDE propose tout ce qu’il faut pour un travail collaboratif avec des outils pour organiser et partager les notebooks, les jeux de données, les codes, les modèles, etc.

Avec SageMaker, AWS possède une solide offre PaaS en matière de Machine Learning mais la concurrence en ce domaine est assez féroce. L’hyperscaler a donc veillé à étoffer son offre pour reprendre l’avantage. SageMaker Studio est un IDE dédié aux data scientists et aux développeurs pour fluidifier le dialogue mais aussi permettre de construire, entraîner, tester, ajuster et déployer les modèles depuis une seule et même interface. L’IDE simplifie l’accès aux différents outils comme le débugger, l’outil de monitoring de SageMaker, etc. L’IDE propose tout ce qu’il faut pour un travail collaboratif avec des outils pour organiser et partager les notebooks, les jeux de données, les codes, les modèles, etc.

En complément, AWS a introduit SageMaker Operators for Kubernetes pour permettre aux développeurs et datascientists, une fois qu’ils ont entraîné et optimisé leurs modèles sous SageMaker de les déployer sur n’importe quel cluster Kubernetes à commencer par ceux instanciés sous AWS mais aussi ceux internes à l’entreprise. Au passage, signalons également que la bibliothèque open source Deep Graph Library, de plus en plus populaire pour simplifier l’implémentation de réseaux de neurones GNN (Graph Neural Networks) notamment utilisés en cybersécurité et en chimie, est désormais disponible sous Sage.

Autre innovation, assez bluffante, SageMaker Autopilot explore automatiquement les jeux de données, en déduit les algorithmes qui pourraient s’y adapter, et essayent différentes combinaisons d’algorithmes et de paramètres pour automatiquement générés les meilleurs modèles (tout en offrant une totale visibilité sur ses prises de décision et leur pourquoi puisque le code Python généré est également accessible et éditable). Il suffit d’un seul appel d’API (depuis SageMaker Studio par exemple) pour déclencher tout ce processus.

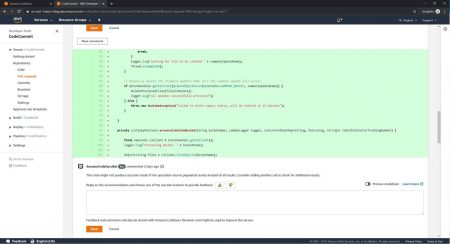

Un Guru du Code en assistant

D e Machine Learning il est aussi question avec Amazon CodeGuru, un nouveau service dopé à l’intelligence artificielle qui effectue de la revue de code automatisée et fournit toutes sortes de recommandations pour obtenir un code plus fiable, plus sécurisé et plus performant. Notamment, CodeGuru identifie les lignes de codes les plus consommatrices en temps CPU mais également les mauvaises pratiques, les erreurs fréquentes, ainsi que les coquilles qui peuvent conduire à des attaques de type SQL injection ou DDOS par exemple. Il pointe à chaque fois les lignes en cause et suggère des modifications ou donne des recommandations. L’IA, qui ne sait pour l’instant qu’analyser du code Java (mais d’autres langages seront proposés à l’avenir) a été entraîné avec les centaines de milliers de projets internes à Amazon et à partir de 10 000 projets open-source disponibles sous GitHub.

e Machine Learning il est aussi question avec Amazon CodeGuru, un nouveau service dopé à l’intelligence artificielle qui effectue de la revue de code automatisée et fournit toutes sortes de recommandations pour obtenir un code plus fiable, plus sécurisé et plus performant. Notamment, CodeGuru identifie les lignes de codes les plus consommatrices en temps CPU mais également les mauvaises pratiques, les erreurs fréquentes, ainsi que les coquilles qui peuvent conduire à des attaques de type SQL injection ou DDOS par exemple. Il pointe à chaque fois les lignes en cause et suggère des modifications ou donne des recommandations. L’IA, qui ne sait pour l’instant qu’analyser du code Java (mais d’autres langages seront proposés à l’avenir) a été entraîné avec les centaines de milliers de projets internes à Amazon et à partir de 10 000 projets open-source disponibles sous GitHub.

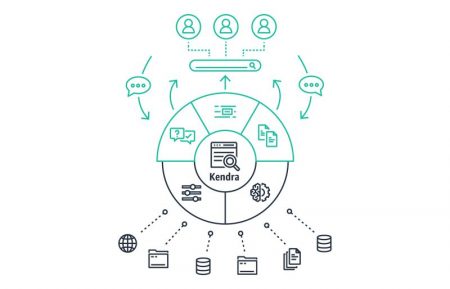

Un service de recherche pour l’entreprise

Amazon Kendra est sans doute l’annonce la plus inattendue de ce « Re:Invent 2020 ». Ce service n’est pas sans rappeler l’annonce de Microsoft autour de Cortex à MS Ignite au début du mois de novembre. Kendra est un service de recherche d’informations pour entreprises à base d’IA et d’interrogations en langage naturel. Kendra explore à peu près n’importe quel entrepôt d’information qu’il s’agisse de dossiers partagés, de Sharepoint, de sites intranet, de services de partage ou de stockage en ligne, etc.

Amazon Kendra est sans doute l’annonce la plus inattendue de ce « Re:Invent 2020 ». Ce service n’est pas sans rappeler l’annonce de Microsoft autour de Cortex à MS Ignite au début du mois de novembre. Kendra est un service de recherche d’informations pour entreprises à base d’IA et d’interrogations en langage naturel. Kendra explore à peu près n’importe quel entrepôt d’information qu’il s’agisse de dossiers partagés, de Sharepoint, de sites intranet, de services de partage ou de stockage en ligne, etc.

Amazon cède aux sirènes quantiques

La communication d’Amazon a beau prétendre qu’AWS est le cloud le plus innovant que les autres doivent se contenter de suivre, la réalité est bien différente. Et AWS joue aussi parfois les suiveurs cherchant à rattraper son retard. Il était ainsi le seul cloud à n’avoir aucun service de Quantum Computing !

AWS a remis ses pendules à l’heure quantique lors de « Re:Invent 2019 ». Il a lancé un programme « Amazon Quantum Solutions Lab » pour mettre en place une communauté autour des sujets et recherches sur l’informatique quantique mais il a surtout lancé Amazon Braket son propre service 100% managé pour créer, tester et exécuter des algorithmes quantiques. Pour l’exécution, son service cloud s’appuie sur des machines D-Wave, IonQ et Rigetti.

Encore un peu d’IA…

Enfin, deux autres annonces méritent l’attention des DSI.

Enfin, deux autres annonces méritent l’attention des DSI.

Amazon Transcribe Medical est une « personnalisation » du service de reconnaissance vocale d’Amazon spécialement paramétré et entraîné pour le jargon médical. Il permet aux médecins de rapidement dicter leurs comptes rendus cliniques pour en obtenir une transcription textuelle.

Enfin Amazon DeepComposer est le premier instrument de musique boosté à l’IA Générative. Ce synthé n’est pas simplement une curiosité. C’est d’abord un outil de création musicale sur lequel on compose quelques notes et on laisse l’IA générer tout un morceau et toute l’orchestration. C’est aussi un outil didactique pour apprendre le machine learning et les concepts de « Generative AI » grâce à la musique en créant ses propres modèles à l’aide des nombreux tutoriels, exemples et données livrés avec. Pour être tout à fait franc, l’aspect apprentissage de l’IA est, pour l’instant, plus pertinent que les réalisations musicales proposées par l’IA.

Au final, l’impression laissée est qu’AWS s’est évertué à démontrer que nous n’en étions encore qu’aux débuts du Cloud public et que tout restait à inventer alors même que certains anticipent un tassement en 2020 de la croissance des grands clouds. Si tassement il y a, cela se fera sur les ouvertures de nouveaux datacenters, pas sur la richesse et la diversité des services proposés.