Data / IA

Dell World 2025 : L’IA décentralisée redessine les architectures d’entreprise

Par Laurent Delattre, publié le 27 mai 2025

Exit le tout-cloud : l’IA ne suit plus le réseau, elle suit les données. Dell propulse le calcul au plus près de la création de valeur, du datacenter jusqu’au PC, avec une vision radicalement distribuée. Des racks Blackwell aux laptops dopés aux NPU, à Dell world 2025, le constructeur a tissé un écosystème IA prêt à détrôner les hyperscalers sur leur propre terrain. En ligne de mire : latence nulle, contrôle total, et agents IA partout.

L’intelligence artificielle transforme radicalement la donne de l’informatique d’entreprise, mais contrairement aux prédictions initiales, elle ne migrera pas massivement vers le cloud. Michael Dell l’affirme sans détour : « L’IA suivra les données, pas l’inverse. L’avenir de l’IA sera décentralisé, à faible latence et hyper-efficace ».

Cette conviction, martelée lors de Dell Technologies World 2025, repose sur une réalité technique (celle que les architectures Cloud de hier ne conviennent pas aux besoins IA d’aujourd’hui) et sur l’intuition que nombre de traitements migreront vers l’edge et jusque sur le PC, où la faible latence fera la différence.

John Roese, directeur technologique de Dell, explicite cette rupture : « Nous avions une infrastructure cloud et nous pensions pouvoir l’utiliser pour l’IA. Ce que nous avons appris ces deux dernières années, c’est qu’elles sont si différentes architecturalement, avec une relation aux données si distincte, qu’il est en réalité totalement insensé d’imaginer qu’une décision prise il y a cinq ans sans connaissance de l’IA puisse être parfaite pour une technologie émergente aussi transformatrice ».

Et pour Dell, cette révolution architecturale pousse inexorablement le traitement vers l’edge et jusque sur les postes de travail. Michael Dell anticipe un bouleversement majeur : « La productivité personnelle est réinventée par l’IA. Le parc installé d’un milliard et demi de PC vieillit et sera remplacé par l’innovation IA ». Pour le PDG de Dell, cette transition ne relève plus de l’option mais de la nécessité concurrentielle. « Nous entrons dans l’ère de l’intelligence ubiquitaire, où l’IA devient aussi essentielle que l’électricité », résume-t-il.

Toutes les annonces de ce Dell World découlent directement de cette vision et de ces convictions. Voici celles qu’il faut retenir…

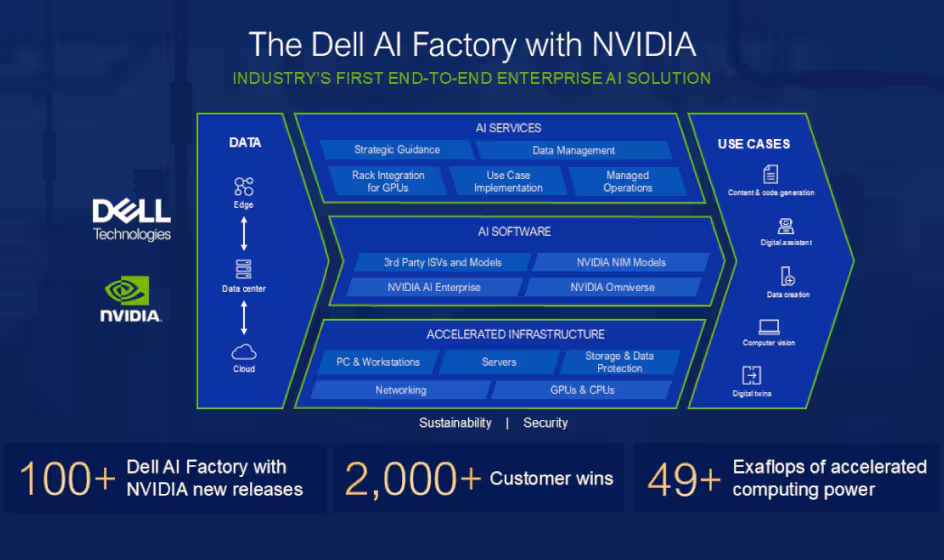

Dell peaufine son AI Factory

Lancée l’an dernier au Dell World 2024, la « Dell AI Factory » est une plateforme conçue pour aider les entreprises à adopter rapidement l’intelligence artificielle à grande échelle. Elle combine infrastructure matérielle, logiciels, services et partenariats avec des acteurs clés de l’IA pour permettre des déploiements flexibles, que ce soit dans le cloud, en data center ou à l’edge. Cette usine à IA peut être vue comme une chaîne industrielle complète – depuis l’ingestion de données jusqu’au déploiement de modèles et d’applications IA les exploitant – bâtie sur des configurations matérielles et logicielles validées, des services managés et une gouvernance de bout en bout. Conçue pour ramener l’IA « là où vivent les données », elle revendique déjà, selon Dell, plus de 3 000 clients et un coût d’inférence jusqu’à 62 % inférieur au cloud public grâce à l’optimisation fine des couches stockage, réseau et calcul.

En 2025, Dell accélère avec Nvidia…

Lors de Dell Technologies World 2025, la firme a présenté la deuxième génération de l’AI Factory with NVIDIA. Cette AI Factory 2.0 mise plus que jamais sur une architecture décentralisée qui traite les données directement sur site plutôt que dans le cloud. Objectif : répondre aux préoccupations croissantes des entreprises concernant la souveraineté des données, les performances et les coûts tout en leur offrant une usine à IA « clés en main ». Cette plateforme « 2.0 » développée avec Nvidia promet des améliorations spectaculaires avec une capacité de traitement multipliée par 100 et une latence réduite de 80%.

Ces gains de performance sont d’abord portés par des améliorations matérielles. Au cœur du dispositif, les serveurs PowerEdge XE9780/85 et leurs variantes à refroidissement liquide XE9780L/85L, capables d’accueillir huit GPU Blackwell HGX B300 chacun et d’atteindre jusqu’à 256 GPU par rack IR7000, quadruplant la vitesse d’entraînement des LLM par rapport à la précédente plateforme Hopper. Pour les déploiements hyperscale, le châssis XE9712 embarque 72 GPU NVL72 en fabriquant une « usine » clé en main à l’échelle du rack.

L’ensemble s’appuie sur des apports structurants : ObjectScale avec S3 over RDMA, qui divise la latence par cinq, et des commutateurs PowerSwitch SN5600/SN2201 ou Quantum-X800 InfiniBand à 800 Gb/s pour maintenir le débit entre nœuds GPU .

Mais la partie logicielle évolue également pour accompagner le virage vers l’IA agentique et renforcer la recherche sémantique au cœur de bien des usages en entreprise. L’AI Factory 2.0 embarque en la matière quelques innovations concrètes. Ainsi, Project Lightning est un nouveau système de fichiers ultra-rapide qui booste l’entraînement des modèles les plus complexes. Parallèlement, Dell Data Lakehouse est désormais optimisé pour fluidifier les workflows IA et accélérer le déploiement en production de cas d’usage bien réels comme les moteurs de recommandation et les scénarios nécessitant de la recherche sémantique intelligente.

La nouvelle AI Data Platform intègre nativement KV-Cache et les bibliothèques NIXL de NVIDIA pour accélérer l’inférence distribuée et les workflows RAG orientés agents.

Dell mise sur une stack logiciel calibrée pour les workflows agentiques : NVIDIA AI Enterprise (NIM, NeMo Retriever, modèles à raisonnement agentique LLama Nemotron, Blueprints) est pré-intégré, tandis que Red Hat OpenShift assure la portabilité des micro-services IA entre cloud privé et edge. S’y ajoute un écosystème élargi : Cohere North pour les workflows autonomes, Glean pour les agents de recherche on-prem, et le support de la LLama Stack de Meta pour bâtir des agents spécialisés, tous validés sur les plateformes Dell.

Et pour renforcer sa position en Europe, Dell s’associe aussi à Mistral AI. Ce partenariat intègre les modèles et outils de la startup française directement dans l’infrastructure Dell, permettant aux entreprises européennes de déployer des solutions d’IA conformes aux réglementations locales tout en conservant le contrôle de leurs données sensibles.

Enfin, Dell NativeEdge (la plateforme logicielle complète conçue pour simplifier, sécuriser et automatiser la gestion des infrastructures et applications à la périphérie) s’enrichit d’un volet « supervision d’agents IA » pour déployer et gérer l’IA agentique dans les sites industriels ou hospitaliers, confirmant l’extension du concept jusqu’à l’extrémité du réseau.

John Roese, CTO et responsable IA de Dell, résume parfaitement l’enjeu : « La première étape a permis de vectoriser les données des entreprises, mais les agents IA ouvrent la voie à l’exploitation des compétences internes ». Sa vision ? Des modèles spécialisés pour chaque tâche, soutenus par des architectures de données sophistiquées qui combinent connaissances et compétences.

… mais ouvre son AI Factory à d’autres accélérateurs

Dell confirme parallèlement l’élargissement du catalogue matériel et de l’approche « AI Factory » au-delà de Nvidia.

Les nouveaux PowerEdge XE9785/85L adopteront aussi les AMD Instinct MI350 (288 Go de HBM3E) et promettent jusqu’à 35 fois plus de performance d’inférence que la génération MI300X .

De leur côté, les plateformes Dell AI Factory with Intel intègrent désormais les accélérateurs Gaudi 3 associés à un stack logiciel open source pour offrir une alternative xPU complète aux clients cherchant à diversifier leurs chaînes d’approvisionnement . Le dispositif s’ouvre enfin à un écosystème logiciel élargi – Mistral, Cohere, Google Gemini, Red Hat OpenShift – afin de répondre aux exigences de portabilité et de souveraineté que formulent de plus en plus de DSI.

Avec cette stratégie plurielle, Dell affine son « AI Factory » : renforcer les performances avec Nvidia, tout en garantissant le choix des architectures pour sécuriser la disponibilité des GPU et adapter le ratio coût-rendement aux cas d’usage. Un virage qui place les équipes IT face à un éventail plus large de briques à intégrer, mais aussi à une plus grande latitude pour aligner puissance de calcul, contraintes énergétiques et gouvernance des données.

Dell joue la carte de l’infrastructure désagrégée

La « Disaggregated Infrastructure », ou infrastructure désagrégée, est une nouvelle approche de l’architecture IT – même si elle rappelle furieusement le ‘Best of Breed’ d’autrefois à certains égards – qui consiste à découpler calcul, stockage et réseau pour les transformer en ressources indépendantes, modulables et partageables à la demande, pilotées par une couche d’automatisation et de cybersécurité commune.

Contrairement aux architectures monolithiques ou hyperconvergées, cette désagrégation permet une flexibilité extrême : chaque ressource peut être dimensionnée, mise à jour ou remplacée indépendamment des autres, selon les besoins précis des charges de travail. Le concept, largement popularisé par Gartner ces dernières années, trouve ses racines dans les environnements hyperscale des géants du cloud qui ont cherché à optimiser l’utilisation de leurs ressources tout en réduisant les coûts et en augmentant l’agilité.

Pour Dell, la montée en puissance des modèles d’IA a mis en lumière les limites des architectures hyperconvergées traditionnelles. Le constructeur parie désormais sur l’infrastructure « désagrégée » qu’il estime mieux adaptée pour absorber des charges hétérogènes et fluctuantes modernes de l’IA. Cette approche « désagrégée » constitue désormais la pierre angulaire des annonces matérielles et stockage 2025 du constructeur.

Côté calcul, la 17ᵉ génération de serveurs PowerEdge sert de brique universelle : un même châssis peut être réalloué d’un cluster Hadoop à une grappe GPU haute densité, avec un ratio de remplacement de 7 pour 1 par rapport aux générations précédentes, tandis qu’OpenManage apporte une télémétrie fine pour libérer capacités et énergie au profit des workloads IA .

Pour alimenter ces nœuds, Dell déploie ses nouveaux modules Linear Pluggable Optics, capables de réduire latence et consommation sur les toiles Ethernet et InfiniBand des centres de calculs intensifs .

La maîtrise thermique suit la même logique de découplage. Le système PowerCool eRDHx – un échangeur arrière à eau tiède capturant 100 % de la chaleur IT – autorise jusqu’à 80 kW par rack, économise 60 % d’énergie de refroidissement et permet d’ajouter 16 % de baies supplémentaires sans accroître la puissance installée. L’Integrated Rack Controller IR7000 offre une supervision unifiée des risques de fuite et des paramètres thermiques, directement intégrée à OpenManage.

Le pilier stockage s’étend lui aussi en mode désagrégé. Les baies PowerProtect Data Domain All-Flash accélèrent les restaurations d’un facteur 4 et doublent la vitesse de réplication, tout en réduisant de 40 % l’emprise au sol et de 80 % la consommation face aux systèmes disque.

PowerScale renforce la résilience avec une Cybersecurity Suite et autorise désormais le cloud burst vers Amazon EC2 ou la sauvegarde vers ObjectScale et Wasabi .

ObjectScale, justement, gagne une version densifiée reposant sur les DPU BlueField-3 et les switchs Spectrum-4. Le support du S3 over RDMA multiplie le débit par 2,3 et divise la latence par cinq, tout en abaissant de 98 % la charge CPU, maximisant ainsi l’utilisation des GPU.

L’architecture désagrégée s’accompagne d’un moteur logiciel. Et chez Dell, ce moteur est composé du triptyque OpenManage, Dell Automation (DAP) et NativeEdge.

Aujourd’hui, la plateforme Dell Automation permet d’assembler une pile cloud privée Nutanix, Broadcom ou Red Hat en 90 % moins d’étapes, un cluster complet étant opérationnel en deux heures et demie sans intervention manuelle. NativeEdge applique la même philosophie au bout du réseau : snapshots, réplication et load-balancing protègent les VM en usine ou en succursale, y compris sur du matériel tiers.

« Nos solutions désagrégées reposent sur les meilleurs composants du secteur, elles libèrent espace et énergie pour ces charges IA gourmandes, tout en fournissant un retour sur investissement maximal », insiste Michael Dell. Pour les DSI, la promesse est triple : prolonger le cycle de vie des actifs en décorrélant calcul et stockage, absorber sans friction des pics d’IA grâce à un réseau optique ultra-bas latence, et renforcer la cyber-résilience via des briques de sauvegarde et d’object storage optimisées.

Dell croit au rôle du PC à l’ère de l’IA

Pour Michael Dell, l’extension de l’IA vers le Edge passe notamment par le PC ! Dell Technologies World 2025 a confirmé que l’avenir du PC n’est pas celui d’un simple terminal : il devient un nœud d’inférence à part entière, capable d’exécuter localement des modèles comptant jusqu’à 109 milliards de paramètres. Pour Michael Dell, l’intelligence doit descendre au plus près de la création de données, jusque « sous le bureau ».

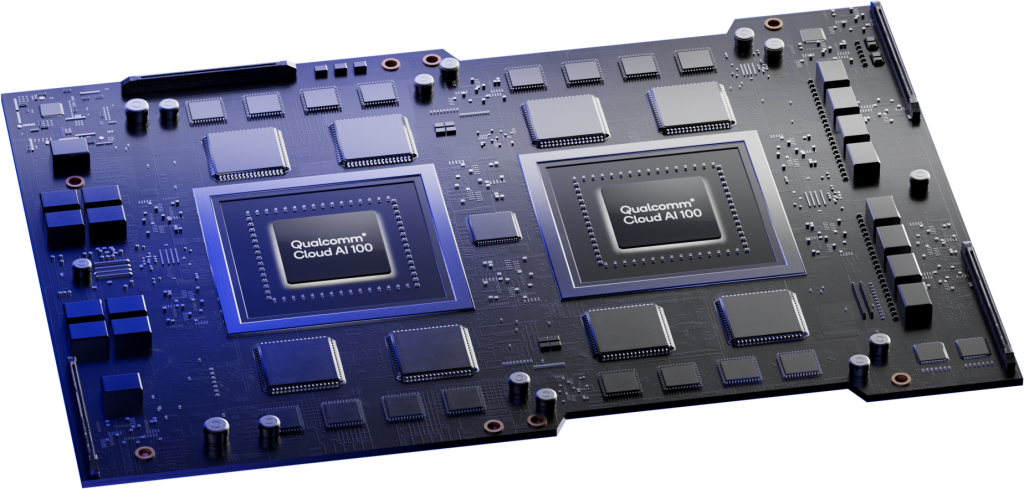

Et la grosse annonce PC de ce Dell World 2025 illustre bien cette vision. Le Dell Pro Max Plus est une workstation nomade d’un genre radicalement nouveau : la machine abandonne le GPU au profit de « Discrete NPU » (comprenez accélérateur IA NPU séparé du processeur) de classe « entreprise ». La machine s’appuie en effet sur une carte accélératrice d’IA (remplaçant la carte GPU normalement présente sur les stations Dell Pro Max) qui embarque deux NPU « Qualcomm AI 100 » au départ conçus pour les centres de données. Grâce à cette carte accélératrice, le Dell Pro Max Plus totalise 32 cœurs IA et une mémoire dédiée de 64 Go pour une performance de 450 TOPS (à comparer au 40 TOPS des NPU intégrés aux processeurs SnapDragon X des Copilot+ PC). La machine est sinon animée par un CPU Intel Arrow Lake de série « H » et peut embarquer jusqu’à 256 Go de RAM et 16 To de stockage SSD, de quoi soutenir l’entraînement léger et l’inférence continue sans passer par le cloud. Typiquement, la machine peut exécuter en local le modèle LLama 4 Scout qui est un modèle de 109 milliards de paramètres !

Pour Dell une telle station va bien au-delà de servir les seuls besoins des développeurs et des Data scientists. Certes, c’est une machine fantastique pour du « Vide Coding » déconnecté (avec l’aide de modèles de codage de 32 milliards de paramètres ou moins comme Codestral de Mistral AI) mais c’est aussi une fantastique machine pour la co-rédaction, la génération d’images (avec Stable Diffusion XL FP16 en local par exemple), les applications médicales mobiles et l’analyse d’images ou de vidéos dans des conditions de mobilité où la connectivité n’est pas assurée et où la confidentialité extrême interdit l’usage du cloud.

Signalons que Dell propose aussi des postes fixes « Pro Max » équipés du nouveau GPU Nvidia GB300 et qui affiche une puissance de 20 Pétaflops tout en accueillant 800 Go de RAM, de quoi, selon Michael Dell, « entraîner un modèle de 1000 milliards de paramètres directement au pied du bureau » .

Au-delà du silicium, Dell livre l’outillage de gouvernance de cette IA embarquée avec « Dell Pro AI Studio ». Cette plateforme développée par Dell est une extension locale de l’AI Factory. Elle vise à gérer l’intégralité du cycle de vie des modèles IA directement sur le PC. Dit autrement, elle permet aux entreprises et aux développeurs de créer, tester et déployer des applications d’intelligence artificielle directement sur leurs PC équipés d’accélérateurs IA. Elle facilite l’utilisation de modèles d’IA optimisés pour le traitement local, ce qui améliore la confidentialité des données, réduit la dépendance au cloud et accélère les performances. Grâce à une intégration avec des outils comme Hugging Face et Microsoft Intune, elle permet une gestion centralisée et efficace des projets IA, tout en réduisant considérablement le temps de développement. Via cette solution, la DSI définit quels modèles sont autorisés, où ils s’exécutent et quelles données ils peuvent traiter, le tout assorti d’une couche de sécurité spécifique aux AI PC.

« Dell Pro AI Studio s’articule autour de trois grandes dimensions : le Dell Enterprise Hub, le Dell Management Portal et le Dell AI Framework » précise Charlie Walker (chef produit Dell Pro Max). « Enterprise Hub est notre espace d’hébergement de modèles d’AI Factory et il intègrera prochainement des modèles spécialement optimisés pour les PC Dell et une inférence en local. Dell Management Portal offre aux DSI un moyen sécurisé et fiable de déployer et gérer les modèles IA sur nos AI PC. Dell AI Framework est le composant local qui expose des API REST compatibles avec OpenAI, permettant aux développeurs d’intégrer facilement des fonctionnalités d’IA ‘texte, vision et voix’ dans leurs applications ».

La disponibilité commerciale du Pro Max Plus est annoncée pour la fin de l’année. Reste à convaincre des entreprises encore prudentes : Dell constate que la transition vers Windows 11 est en retard de trente points par rapport à celle vers Windows 10, nombre de clients ayant différé leurs achats en attendant ces nouvelles architectures IA. Pour les DSI et RSSI, l’enjeu consiste désormais à planifier un renouvellement accéléré du parc : arbitrer entre CPU, GPU et NPU selon les cas d’usage, mettre en place les politiques de contrôle des modèles et revisiter la défense du poste de travail (qui avec ces annonces Dell ressemble beaucoup à un micro-datacenter capable de manipuler des données critiques).

Au final, ce Dell World 2025 aura eu le mérite de démontrer comment, du rack Blackwell à l’ordinateur portable, Dell compte tisser un continuum « IA » matériel-logiciel, enrichi de services et d’un vaste réseau de partenaires, pour transformer l’engouement pour l’IA agentique en déploiements opérationnels et gouvernables. Il illustre bien comment les constructeurs comptent résister à l’IA cloudifiée des hyperscalers ainsi que les perspectives ouvertes par l’arrivée de l’IA au cœur des PC. Reste maintenant aux DSI à digérer toutes ces annonces qui s’ajoutent à celles de Google I/O 2025 (ici et là), à celles de la Microsoft Build 2025 (ici, ici, ici, et là) et à celles du Red Hat Summit 2025, qui ont tracé un paysage finalement très dispersé, très varié et en quête de maturité d’une IA conversationnelle désormais bien maîtrisée et qui veut embrasser une ère agentique très loin d’être mature et expérimentée à grande échelle. Il y a du pain sur la planche en attendant que les IA prennent le relai et nous permettent de partir en vacances.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :