@Work

Luc Julia : « Ce qui existe, ce sont des IA débiles qu’on rend utiles quand on les connecte bien »

Par Thierry Derouet, publié le 16 juin 2025

La promesse de l’IA ne tient plus dans un prompt. Pour qu’un agent conversationnel remplisse une fonction, il faut l’intégrer au SI, l’orchestrer, le faire dialoguer avec les applications métiers, et lui assigner un rôle intelligible. C’est tout l’enjeu qu’abordent Stéphane Roder, CEO d’AI Builders, et, en ouverture, Luc Julia, en posant les fondations techniques, économiques et méthodologiques d’une IA qui ne promet plus, mais qui délivre.

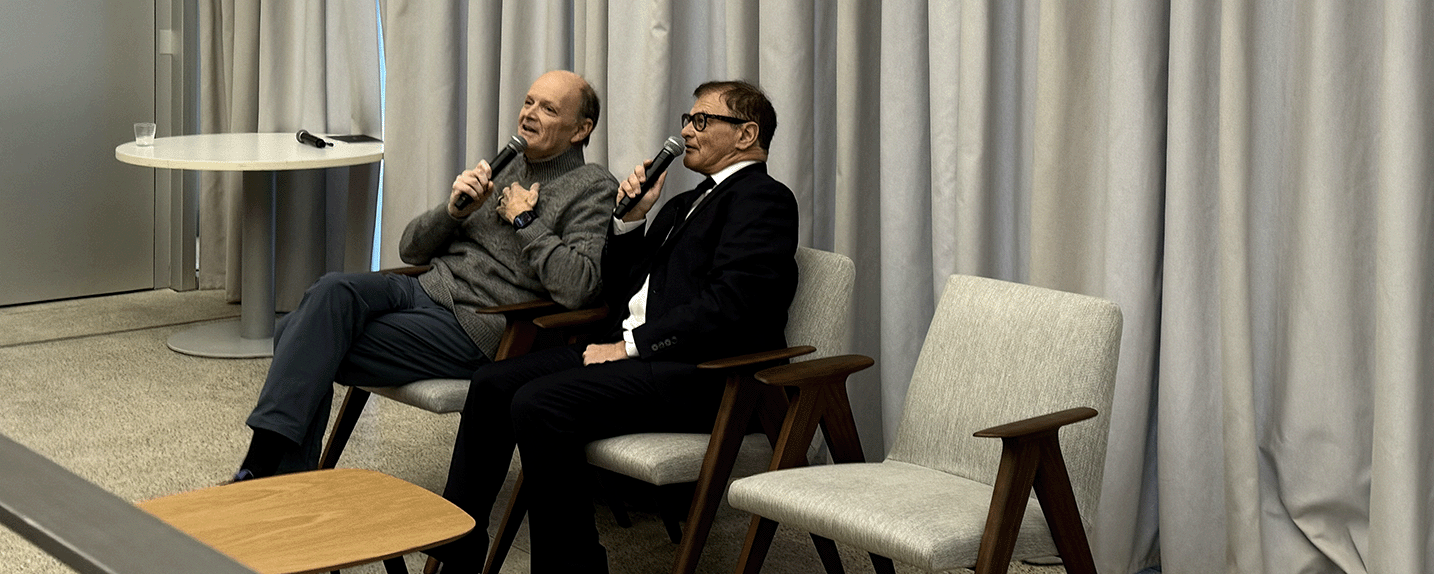

« L’intelligence artificielle n’existe pas. Ce qui existe, ce sont des IA débiles qu’on rend utiles quand on les connecte bien. » La formule est de Luc Julia, directeur scientifique de Renault Group et co-créateur de Siri (Apple), une formule choc prononcée en préambule d’une master classe donnée par AI Builders et son CEO, Stéphane Roder, sur l’intégration des agents IA. Cette phrase résume, à elle seule, le tournant que prennent aujourd’hui les entreprises face à la vague IA : fini le fantasme du génie tout-puissant, place à l’art d’assembler des briques utiles dans un système d’information cohérent, opérationnel, et… intelligent, justement, parce que connecté.

La promesse de l’IA ne tient plus dans un prompt. Pour qu’un agent conversationnel remplisse une fonction, il faut l’intégrer au SI, l’orchestrer, le faire dialoguer avec les applications métiers, et lui assigner un rôle intelligible. C’est tout l’enjeu qu’abordent Stéphane Roder, et, en ouverture, Luc Julia, en posant les fondations techniques, économiques et méthodologiques d’une IA qui ne promet plus, mais qui délivre.

Du fantasme des LLM à la logique des agents utiles

« Ce qu’on est en train de réinventer, c’est l’automatisation. » Stéphane Roder n’y va pas par quatre chemins. Les grands modèles de langage sont impressionnants, mais coûteux, peu fiables, et souvent sans ancrage fonctionnel. Ils hallucinent, ils devinent, ils génèrent. Mais dans une entreprise, il ne s’agit pas de briller en société. Il s’agit d’enchaîner des tâches, de réduire les coûts, de fiabiliser les flux.

La réponse ? Des modèles spécialisés, plus petits, préentraînés, et capables de tourner localement sur des machines déjà existantes. On parle ici de la famille des modèles Phi (1, 2, Silica), conçus pour embarquer des compétences ciblées dans une infrastructure existante. Et surtout, on parle d’agents : des instances IA opérationnelles, intégrées, affectées à des tâches précises.

L’agent, orchestrateur de la complexité métier

Chez un grand assureur, Stéphane Roder décrit une architecture où un agent IA dialogue avec trois systèmes pour réaliser le traitement d’une demande d’indemnisation : vérification du contrat, contrôle des justificatifs, application des règles d’indemnisation. Avant, c’était trois interfaces. Aujourd’hui, c’est un orchestrateur qui centralise les étapes, les automatise, et fournit au gestionnaire l’ensemble du raisonnement et une proposition de réponse.

La BNP et la logique des agents coopérants

Stéphane Roder cite également le cas d’une grande banque Française, où une architecture distribuée d’agents a été mise en place. Chaque application dispose de son propre agent, spécialisé, connecté à un orchestrateur central. Ce dernier reçoit une requête, la décompose, distribue les tâches et récupère les résultats.

« Une DSI qui expose ses applications via des agents peut révéler des cas d’usage inaccessibles auparavant. » L’idée clé : chaque application devient à la fois interlocutrice, actrice et exécutante dans une chaîne pilotée par l’intention.

MCP : faire parler les agents

Mais pour faire dialoguer agents et données/applications/services, il faut un langage commun. C’est ici qu’intervient le Model Context Protocol (MCP). Conçu pour normaliser les fonctionnalités d’une application, MCP permet à chaque logiciel d’indiquer ce qu’il est capable de faire, dans quels contextes et avec quelles données. Stéphane Roder rappelle qu’un serveur MCP peut être généré en moins d’une heure à partir d’une API REST bien documentée.

« Tous les outils SaaS vont devenir des outils pour agents », insiste-t-il. Là encore, Luc Julia, en introduction, soulignait combien l’IA ne vaut que si elle est contextuelle, interopérable, et alignée sur les processus réels. MCP, en cela, est bien plus qu’un protocole : c’est une grammaire pour l’automatisation distribuée.

Au-delà de MCP, vers une normalisation ouverte

Si MCP s’impose progressivement comme un protocole de dialogue entre agents et services, d’autres initiatives émergent pour structurer les flux d’intention : Open Agents Protocol (OAP), LangChain Expression Language (LCEL), voire certaines déclinaisons spécifiques développées en interne par de grands acteurs. L’enjeu ? Créer un langage d’échange à la fois lisible par la machine, gouvernable par l’humain, et réutilisable sur plusieurs couches applicatives. Cette normalisation pourrait à terme accélérer l’industrialisation des cas d’usage, à condition d’éviter la fragmentation concurrentielle.

40 micro-tâches pour redéfinir le métier

Dans l’assurance, AI Builders a identifié jusqu’à quarante micro-tâches récurrentes dans le traitement d’un sinistre. Chacune a été modélisée, testée, puis affectée à un agent. L’utilisateur, lui, formule une intention globale : ouvrir un dossier, analyser les justificatifs, proposer un remboursement. Le système d’information décortique, orchestre, exécute. Le gain de productivité est immédiat, la qualité de service augmente, et les savoir-faire se capitalisent.

Luc Julia, dès les premières minutes de son intervention, avait insisté sur ce point : si l’on ne sait pas ce que l’on fait, l’IA ne peut le deviner. Toute automatisation efficace commence donc par une documentation rigoureuse et une cartographie des processus.

Le retour à l’inférence locale

Autre point clé : le coût d’inférence. Les modèles d’orchestration locaux, embarqués sur des machines existantes, permettent une exécution à coût quasi nul. « Quelques centimes par mois », précise Stéphane Roder. Ce paradigme permet un déploiement massif, sans explosion budgétaire, tout en garantissant la souveraineté des données.

Dans cette logique, le modèle Phi Silica et Phi 4 incarnent une IA d’orchestration frugale, capable de fonctionner sur des processeurs ARM ou des GPU standards. Développé par Microsoft, dérivé du modèle open source ‘Phi 3.5 mini’ de Microsoft Research, Phi-Silica est un modèle génératif multilingues, de 3,3 milliards de paramètres, optimisé pour un fonctionnement en local sur les NPU des PC estampillés « Copilot+ PC ».

Intégré en standard dans Windows 11, il constitue aussi une opportunité, pour les DSI, d’échapper à la dépendance aux services IA Cloud des hyperscalers.

Comment évaluer le ROI d’un agent IA ?

Le retour sur investissement ne se mesure pas seulement en équivalents ETP. Il repose sur des gains marginaux multipliés par des volumétries importantes. Il faut observer la réduction du temps par tâche, la baisse des erreurs, l’amélioration de la traçabilité, la fluidité des enchaînements, la désaturation opérationnelle, ou encore la valorisation de la donnée issue de l’exécution.

Dans un cas traité, une tâche de deux minutes réalisée 8 000 fois par mois a été automatisée par un agent IA local, ramenant l’opération à trente secondes. La fiabilité s’est accrue de 20 %, le coût de fonctionnement s’est effondré. En quelques semaines, le seuil de rentabilité était franchi, et l’agent est devenu un maillon critique du back-office. « Ce n’est pas l’agent qui coûte cher, c’est de ne pas pouvoir déléguer intelligemment les tâches simples. »

L’humain n’est pas éjecté du process

Stéphane Roder insiste : l’IA ne remplace pas l’utilisateur. Elle transforme sa relation au SI. On ne navigue plus, on dialogue. L’utilisateur devient superviseur, délégateur, parfois arbitre. Une posture nouvelle, qui implique accompagnement, tests, retours d’expérience. L’agent, ici, n’est pas un gadget : c’est un levier de reconquête fonctionnelle. Luc Julia, dans ses propos liminaires, évoquait lui aussi une complémentarité assumée : « L’intelligence humaine est toujours requise. C’est l’organisation qu’on change, pas la pensée. »

Ultime alerte stratégique

La conclusion est moins une formule qu’un constat. À mesure que certains territoires ou grandes organisations – à l’image de Bank of New York– annoncent des gains de productivité de 40 % sur leur leurs traitements en backoffice, les écarts de compétitivité deviennent structurels. Pour Stéphane Roder, cette transformation silencieuse fait peser une menace sur les acteurs qui n’auraient pas encore entamé leur mutation. « Si un nouvel entrant dit : j’ai tout repensé, tout orchestré, et maintenant ça coûte dix fois moins, alors tout peut s’effondrer. Et ça ira plus vite que la précédente révolution. »

La rupture, en somme, n’est pas dans le modèle. Elle est dans l’architecture.

Ce que soulève la sécurité des serveurs MCP

Les serveurs MCP, parce qu’ils exposent les capacités opérationnelles d’une application, deviennent un point d’entrée stratégique dans l’architecture. Leur déploiement implique donc une vigilance accrue sur plusieurs aspects : l’authentification des agents appelants, la journalisation des échanges, la vérification des contextes d’exécution et l’isolation des environnements critiques. Stéphane Roder recommande une approche « zero trust » appliquée à l’ensemble des appels de fonction, avec chiffrement systématique des flux, et supervision active. Il ne s’agit pas seulement de sécuriser l’accès, mais de garantir que chaque instruction exécutée par un agent l’est dans un cadre maîtrisé et traçable.