@Work

Adobe MAX 2025 : l’IA s’invite partout, mais la créativité garde la main

Par Laurent Delattre, publié le 30 octobre 2025

Lors de sa conférence MAX 2025, Adobe n’a pas seulement dévoilé de nouveaux modèles IA, de nouvelles innovations étonnantes, de nouvelles fonctionnalités. L’éditeur a surtout dévoilé l’avenir des logiciels, des siens et des autres, à l’aune de l’ère agentique. Quand les agents IA prennent le contrôle de Photoshop, Premiere ou Lightroom, c’est toute la chaîne graphique qui se réinvente.

Chaque automne, la conférence Adobe MAX réunit des dizaines de milliers de créatifs autour des dernières innovations logicielles de la célèbre (et indispensable à leurs yeux) suite Creative Cloud. Mais depuis deux ans, l’événement est dominé par un acronyme : IA. Depuis deux ans, l’éditeur s’évertue à doper ses outils avec des modèles IA qui accélèrent le processus créatif et libère l’imagination tout en proposant (via le Web) de nouveaux outils simplifiés qui rendent les travaux graphiques accessibles au plus grand nombre.

Mais l’édition 2025 qui s’est tenue cette semaine est allé beaucoup plus loin. Elle a levé le voile sur un nouvel usage des logiciels où l’utilisateur n’a plus « à savoir comment utiliser le logiciel » mais simplement exprimer « ce qu’il veut faire » ou « ce qu’il veut obtenir », les agents IA se chargeant de manier outils et calques pour concrétiser l’idée.

Alors forcément, les craintes qui pointaient déjà lors des deux premières éditions se sont transformées en une inquiétude encore plus palpable, presque assourdissante malgré son silence. Que restera-t-il des métiers de créatifs si l’IA automatise toujours plus de tâches ? « L’avenir appartient à ceux qui créent. La technologie amplifie l’ingéniosité humaine, mais elle ne pourra jamais reproduire l’émotion et l’humanité que vous apportez à votre art » a martelé le CEO d’Adobe, Shantanu Narayen pour calmer les inquiétudes. Oui, surement. Sauf que « l’art » n’est pas franchement ce qui fait le gagne-pain de la très grande majorité des utilisateurs présents à sa conférence. Sur ces tâches gagne-pain, la réelle créativité sera de savoir ordonner l’IA avec expertise.

Ce qui est sûr, c’est qu’au-delà de la « création artistique », toute la chaîne graphique des entreprises, celle du marketing produit, de l’animation des réseaux sociaux, de la publicité, de la communication, est en pleine métamorphose. Et ce n’est qu’un début. Jusqu’ici l’IA était essentiellement utilisée pour générer des visuels dans des chaînes semi-automatisées. Désormais, elle prend le contrôle de la souris, du clavier, des logiciels pour réaliser ce que l’utilisateur ne sait pas faire ou ce qu’il ne veut plus faire (cas des tâches répétitives et chronophages).

L’arrivée des assistants agentiques au cœur de Creative Cloud

Comment ? Simplement en devenant un « copilot », un assistant agentique, totalement intégré aux outils de prédilections des créatifs. Ces assistants visent à automatiser les tâches les plus laborieuses, à simplifier les flux de travail complexes et à introduire de nouvelles formes d’interaction, tout simplement en prenant les commandes de l’outil dans lequel ils s’intègrent.

Dans Photoshop, un assistant conversationnel peut désormais renommer automatiquement les calques, ajuster la lumière ou supprimer des éléments d’une scène sur simple demande. Au lieu de maîtriser une myriade d’outils, de menus et de curseurs, l’utilisateur peut désormais formuler ses demandes en langage naturel. Des instructions comme « change la couleur du ciel pour un coucher de soleil et harmonise l’éclairage de la scène » sont interprétées et exécutées par l’IA, qui se charge d’effectuer la séquence d’opérations techniques correspondante.

Cette approche conversationnelle abaisse radicalement la barrière à l’entrée pour les nouveaux utilisateurs. Mais elle offre aussi aux professionnels un moyen d’accélérer considérablement les tâches répétitives en créant des prompts complexes enchaînant des opérations multiples afin d’automatiser les actions les plus chronophages.

Conscient que le contrôle granulaire reste primordial pour les experts, Adobe a conçu une interface hybride : l’utilisateur peut à tout moment basculer de la conversation avec l’IA aux outils manuels traditionnels pour affiner le résultat. C’est une stratégie qui cherche à démocratiser la puissance de Photoshop sans sacrifier la précision qui a fait sa réputation.

L’arrivée des assistants IA agentiques ne s’arrête pas à Photoshop. Il apparaît déjà dans Adobe Express pour proposer des modèles de communication visuelle prêts à l’emploi, et sera prochainement intégré à Premiere avant de s’étendre à tous les outils Creative Cloud.

Typiquement dans Adobe Express, l’assistant est capable d’interpréter des requêtes subjectives comme « donne-lui un air plus tropical » et d’ajuster dynamiquement les couleurs, les polices et les images pour correspondre à l’ambiance souhaitée. Sa nature conversationnelle change le processus : après avoir exécuté une commande, il peut poser des questions de suivi pertinentes, comme « Voulez-vous que j’adapte la police à la nouvelle palette de couleurs? », guidant ainsi l’utilisateur vers un design plus cohérent.

Ces assistants marquent une vraie révolution : celle de l’édition conversationnelle qui ne demande plus à l’utilisateur de connaître l’outil mais de savoir précisément ce qu’il veut obtenir. Quitte à brouiller la frontière entre amateur et professionnel.

Des supers IA plus ouvertes dans Photoshop, Premiere et Lightroom

Parallèlement aux assistants, Adobe continue d’implanter dans ses outils de nouvelles fonctionnalités explorant le potentiel de l’IA générative.

Sur Photoshop, la fonction apparue l’an dernier de Generative Fill (Remplissage Génératif) a été améliorée en adoptant une approche multi-modèles. Les utilisateurs peuvent désormais choisir entre le modèle Firefly d’Adobe, le modèle Gemini 2.5 Flash Image de Google (nom de code Nano Banana), ou encore le modèle FLUX.1 Kontext de Black Forest Labs. Cela permet de sélectionner le moteur d’IA le plus performant pour un type d’image ou de prompt donné.

Toujours sur Photoshop, la nouvelle fonction de Generative Upscale (agrandissement génératif) intègre la technologie de Topaz Labs pour sur-échantillonner des images de basse résolution jusqu’en 4K, préservant et recréant les détails avec une clarté impressionnante.

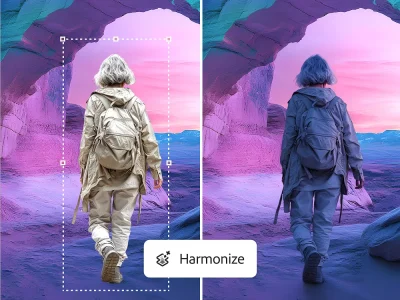

Autre nouveauté Photoshop, la fonction Harmonize automatise l’une des tâches les plus complexes de la composition d’images : l’intégration réaliste d’un objet ou d’une personne dans une nouvelle scène. L’outil analyse l’éclairage, la colorimétrie et le ton de l’image de fond et applique automatiquement les ajustements nécessaires à l’élément ajouté, réalisant en quelques secondes un travail qui nécessitait auparavant une expertise considérable.

De son côté Premiere s’enrichit également de fonctionnalités particulièrement révolutionnaires pour le quotidien des monteurs vidéos.

L’outil « Frame Forward » est capable d’appliquer une retouche effectuée sur une seule image à l’ensemble d’une séquence vidéo.

Plus important encore, l’outil « AI Object Mask » utilise l’IA pour détecter, isoler et suivre automatiquement des objets ou des personnes en mouvement tout au long d’un clip vidéo. Ele métamorphose le principe de rotoscoping (processus manuel et fastidieux de détourage image par image), goulot d’étranglement majeur en post-production, souvent réservé aux projets disposant de budgets et de délais conséquents. En automatisant cette tâche, AI Object Mask démocratise l’accès à des techniques avancées d’étalonnage sélectif, d’effets visuels et de masquage. Un monteur peut désormais, en quelques clics, changer la couleur de la veste d’un personnage, flouter un logo sur un objet en mouvement ou appliquer un effet uniquement sur l’arrière-plan, un travail qui aurait auparavant nécessité des heures, voire des jours, de travail méticuleux. Cette innovation ne se contente pas de faire gagner du temps : elle ouvre de nouvelles possibilités créatives en rendant l’expérimentation avec des effets complexes beaucoup plus accessible et immédiate.

Dans Lightroom, les photographes professionnels sont souvent confrontés à la tâche monumentale de trier des milliers de photos après une séance. Le nouvel outil Assisted Culling, disponible en bêta publique, s’attaque directement à ce problème. Il analyse un lot d’images et aide à identifier les meilleurs clichés en fonction de critères personnalisables comme la netteté de la mise au point, les yeux ouverts sur les portraits, ou la composition, permettant aux photographes de se concentrer plus rapidement sur l’édition des images les plus prometteuses.

Firefly Image 5, le nouveau moteur visuel

L’ouverture des fonctionnalités IA à d’autres modèles que ceux d’Adobe est plutôt bienvenue. Ils sont souvent plus pertinents et plus efficaces mais n’offrent pas les garanties de respect des copyrights des modèles d’Adobe.

Parallèlement, Adobe travaille aussi à améliorer ses propres modèles, comme en témoigne la sortie en preview de Firefly Image Model 5, présenté comme le modèle le plus avancé d’Adobe.

Cette nouvelle itération représente un saut qualitatif majeur, axé sur deux domaines critiques : la qualité d’image et le contrôle de l’édition. Capable de générer des images en résolution native 4 MP, il améliore le rendu photoréaliste, l’anatomie humaine et la gestion des lumières.

Surtout le modèle permet désormais (à la manière de Nano Banana et de GPT4-Image) d’éditer les images générées. « Avec Firefly 5, vous pouvez éditer une image comme si vous parliez à un collègue » résume Ely Greenfield, directeur technique d’Adobe.

La grande originalité de cette édition est qu’elle peut s’appliquer par calques (Layered Editing), une spécificité Adobe qui brouille la frontière entre la génération d’IA et la post-production traditionnelle. Chaque élément majeur d’une image générée par l’IA, comme le sujet principal, les objets d’arrière-plan, le décor, est traité comme un calque distinct et modifiable. Cela signifie qu’un utilisateur peut, par exemple, déplacer un personnage ou changer la couleur d’un objet en utilisant une simple instruction textuelle, et le modèle réajustera intelligemment les ombres et l’harmonie globale de l’image. Cette approche intègre les concepts fondamentaux de Photoshop directement au sein du processus de génération des images ! Une image générée n’est plus une sortie « plate » et finale, mais une structure de projet flexible, pré-préparée pour un flux de travail Adobe.

Firefly Custom Models

Les entreprises n’en sont plus à bêtement utiliser les modèles clés en main du marché. Beaucoup ont désormais acquis la maîtrise du fine-tuning et de la personnalisation des modèles afin de les plier, de les ancrer, dans leurs métiers, leurs jargons, leurs données, et limiter les hallucinations tout en améliorant la pertinence des réponses. Aujourd’hui, Adobe propose d’en faire autant avec ses modèles génératifs « Firefly ».

Pour répondre à l’une des critiques les plus fréquentes adressées à l’IA générative (comme son manque de style unique et sa tendance à produire des résultats génériques), Adobe a dévoilé Firefly Custom Models. Initialement réservée aux grandes entreprises, cette fonctionnalité est désormais accessible aux créateurs individuels en bêta privée. Elle permet à un artiste ou à une marque d’entraîner un modèle Firefly privé et sécurisé sur son propre corpus d’images. En téléchargeant simplement une poignée d’images de référence, l’utilisateur peut « enseigner » son style visuel unique à l’IA. Le modèle personnalisé peut alors générer de nouveaux contenus qui respectent parfaitement cette esthétique, garantissant une cohérence de marque ou artistique sur de grands volumes de production. Cette démocratisation de la personnalisation des modèles transforme l’IA d’un simple outil de création en un puissant levier pour imposer une identité visuelle à toutes les productions.

La révolution Firefly

Chez Adobe, Firefly est à la fois une marque pour toutes les technologies IA « maison » mais aussi un service Web qui permet aisément de mettre ces technologies en œuvre sans avoir à connaître les outils Adobe. Jusqu’ici, Firefly avait un côté très expérimental avec une approche « réaliser n’importe quoi avec l’IA en un clic ». Super efficace, super simple.

Mais Adobe a désormais d’autres ambitions pour son service. L’éditeur veut en faire une plateforme de production de contenu de bout en bout, animée par l’IA et centrée sur l’IA, aussi bien pour l’image, l’audio que la vidéo.

L’interface a donc été entièrement repensée pour en faire un véritable « Studio » de création qui gagne en fonctionnalité d’entreprise mais perd en convivialité immédiate. Et une pléthore de nouvelles fonctionnalités apparaissent :

* Firefly Boards introduit une dimension collaborative. Ces espaces d’idéation visuelle permettent aux équipes non seulement de partager des idées et de générer des concepts, mais aussi manipuler ces concepts de manière sophistiquée, notamment en faisant pivoter des objets 2D pour les visualiser en 3D, en téléchargeant des actifs en masse, et en exportant les planches d’inspiration au format PDF pour les partager plus facilement.

* Generate Soundtrack (en bêta publique) crée en quelques secondes des musiques libres de droits, adaptées à un texte ou directement synchronisées avec un clip vidéo.

* Generate Speech (en bêta publique) génère des « voix off » naturelles et multilingues, avec un contrôle précis sur le ton et l’émotion, grâce à un partenariat avec ElevenLabs.

* Firefly Video Editor (en bêta privée) implémente un éditeur vidéo en ligne simple, puissant, qui intègre toutes les fonctions génératives pour assembler images, musiques et voix sur une timeline.

En réunissant ces briques, Adobe ne se contente pas d’ajouter des options : elle propose un flux de production complet, pensé pour les créateurs de contenus rapides et efficaces (YouTube, TikTok). Firefly se positionne ainsi comme une alternative web intégrée face à Canva ou Descript, tout en s’appuyant sur la force de l’écosystème Adobe.

Vers une Chaîne d’Approvisionnement de Contenu Autonome

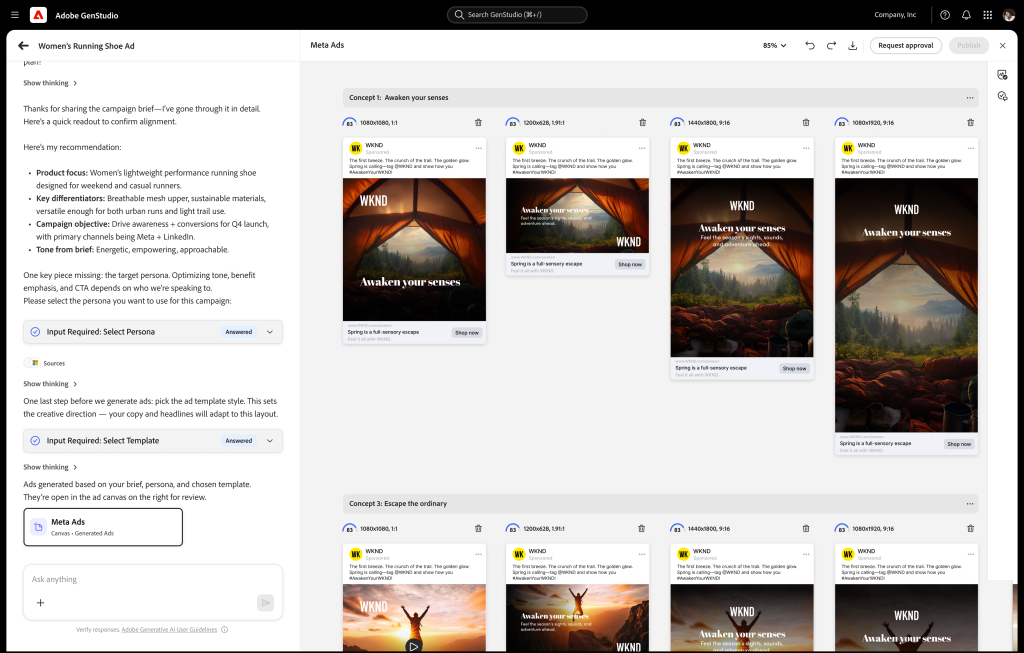

Au-delà de la création, les entreprises ont surtout besoin d’industrialiser la production des contenus. Et en la matière, la nouvelle pièce maîtresse de l’éditeur se nomme GenStudio, une solution de bout en bout conçue pour gérer la « Content Supply Chain » (chaîne d’approvisionnement de contenu). Face à la demande insatiable de contenu personnalisé sur une multitude de canaux, GenStudio utilise l’IA pour automatiser la production à grande échelle.

Au cœur de cette solution, le nouveau service Firefly Foundry permet aux entreprises de collaborer avec Adobe pour créer des modèles d’IA génératifs propriétaires. Ces modèles sont entraînés sur le catalogue complet de la propriété intellectuelle d’une marque (images, logos, produits, chartes graphiques) pour garantir que chaque contenu généré est parfaitement « on-brand » et commercialement sûr. Elles peuvent ainsi générer des campagnes entières en respectant leur identité graphique. « GenStudio rapproche créativité et marketing dans une même chaîne de valeur », insiste Varun Parmar, directeur général de la division GenStudio/Firefly Enterprise.

Cette personnalisation est poussée encore plus loin avec Firefly Design Intelligence, un outil inspiré d’une collaboration avec The Coca-Cola Company. Il va au-delà des chartes graphiques statiques en créant des « StyleIDs », des systèmes de design intelligents qui codifient les règles visuelles complexes d’une marque. Ces StyleIDs peuvent ensuite être utilisés dans les applications Creative Cloud pour générer automatiquement de nouvelles mises en page, des textes et des compositions qui respectent scrupuleusement l’identité de la marque.

Enfin, le Content Production Agent, disponible en bêta dans GenStudio, agit comme un chef de projet IA. Il peut interpréter un brief marketing (« Crée une campagne d’e-mails et de bannières publicitaires pour notre nouvelle collection d’été ») et produire de manière autonome les contenus pertinents pour chaque canal, en alignement avec les objectifs de la campagne et les directives de la marque.

Des fonctionnalités qui transforment peu à peu GenStudio en une usine à contenus, autonome et automatisée. Oui, ça fait un peu froid dans le dos.

Project Moonlight, l’IA qui se rêve directeur artistique

Dans ce même ordre d’idées, Adobe a présenté Project Moonlight. Cet agent conversationnel agentique est présenté par l’éditeur comme un « directeur créatif personnel ». L’idée est simple : vous décrivez en langage naturel une intention, et vous laissez l’IA orchestrer les étapes de production, du storyboard à la publication. Moonlight peut même analyser les réseaux sociaux d’un créateur pour suggérer des contenus adaptés à son audience.

« Nous entrons dans l’ère des workflows multi-étapes, où l’IA ne se contente plus d’exécuter une commande mais accompagne tout un projet », explique David Wadhwani, président d’Adobe Digital Media. Pour Adobe, c’est la promesse d’un avenir où la technologie deviendra si transparente qu’elle permettra à la créativité de s’exprimer, enfin, sans entraves.

Bien sûr cette vision peut séduire par sa fluidité et sa simplicité mais il ne faut pas atténuer les risques qu’elle engendre d’une dépendance accrue aux algorithmes dans la conception même des idées.

Alors, oui, Adobe a impressionné par la puissance de ses innovations. Mais la pertinence de ses démonstrations (qui ignorent volontairement les défauts, imprécisions et limites de ses modèles actuels en usage réel) a aussi cristallisé les doutes d’une communauté créative qui oscille entre fascination et inquiétude. Les métiers de la création graphique ne sont ni les premiers, ni les plus exposés à la révolution de l’IA. Mais ils sont très profondément transformés. Et ce n’est que le début. Il va falloir apprendre à s’adapter à ce nouveau monde.

À LIRE AUSSI :

À LIRE AUSSI :