Cloud

Microsoft Build 2023 : les 33 annonces qu’il ne fallait pas manquer…

Par Laurent Delattre, publié le 12 juin 2023

Il y a une dizaine de jours, la conférence Build 2023 de Microsoft fermait ses portes après un tsunami d’annonces et de nouveaux produits. Une conférence presque entièrement focalisée sur l’IA, qu’il s’agisse d’en créer des spécialisées pour vos données et vos métiers ou qu’il s’agisse d’utiliser celles de Microsoft pour augmenter les collaborateurs et améliorer les processus. Voici ce que les DSI doivent en retenir…

Chaque année la Build est un temps fort pour tout l’écosystème Microsoft. Conférence très orientée Développeurs, elle est traditionnellement marquée par une pluie d’annonces qui tracent les grandes priorités de l’éditeur pour les mois et années à venir sur tout l’écosystème. Mais, mis à part la Build 2000 centrée sur .NET, très peu d’autres Build ont été à ce point focalisées sur une seule technologie et thématique. La Build 2023 restera dans les Annales comme la Build de l’IA. L’éditeur est en train de réinventer toutes ses plateformes, tous ses logiciels, tous ses outils de développement et tous ses business à grands coups d’IA générative.

Où que l’on regarde dans la pléthore d’annonces de cette Build 2023, on retrouve de l’IA : dans Microsoft 365, dans Edge, dans Windows, dans Visual Studio, dans GitHub, dans Azure…

Pas facile, dès lors, d’obtenir une vue à 360° des annonces faites. Pour vous y aider, voici les grands axes et les principales annonces que les DSI doivent retenir de cette édition 2023 de la Microsoft Build.

Une plateforme unificatrice pour l’IA et l’Analytique

Il n’y a pas d’IA sans données, ou plutôt sans données préparées, orchestrées, gouvernées, centralisées. Et des plateformes de données, Microsoft en propose déjà de très nombreuses à vocation diverse. Mais la Build 2023 a été marquée par l’introduction d’une nouvelle plateforme, assemblage de briques existantes et de nouvelles, conçue pour « l’ère de l’IA ».

Microsoft Fabric (01)

« Alimenter des expériences IA spécifiques à une organisation nécessite un approvisionnement constant en données propres provenant d’un système d’analyse hautement intégré. Mais les systèmes d’analyse de la plupart des organisations ressemblent à un labyrinthe de services spécialisés, déconnectés les uns des autres » estime Arun Ulagaratchagan, Corporate Vice President, Azure Data. « Aujourd’hui, nous annonçons Microsoft Fabric, une plateforme analytique unifiée de bout en bout qui rassemble tous les outils de données et d’analyse dont les entreprises ont besoin ».

Microsoft Fabric est l’ultime réalisation de la vision d’un Data Cloud managé chez Microsoft, la nouvelle itération de la vision « Microsoft Intelligent Data Platform » annoncée en 2022, une version enrichie et étendue de Microsoft Synapse. Une vision portée par une idée : « tirer le maximum de valeur d’une seule copie de données, sans déplacement ni duplication ».

Toute cette vision, toute cette plateforme, repose ainsi sur une nouvelle brique fondatrice : OneLake.

OneLake résulte d’une même tendance à vouloir unifier Lacs de données et Datawarehouse, en supportant données structurées et données non structurées, que l’on retrouve notamment chez Databricks Lakehoue Platform et Cloudera Data Platform.

Fondamentalement, OneLake est un système de stockage centralisé, unique, unifié et logique pour l’ensemble de l’organisation. Il unifie les données et simplifie leur découverte et leur partage tout en assurant un respect strict des paramètres de sécurité, de conformité et de gestion définis. Comme OneDrive, OneLake est livré automatiquement avec chaque « tenant » de Microsoft Fabric et est conçu pour être l’endroit unique pour toutes vos données analytiques. D’ailleurs la comparaison avec OneDrive ne s’arrête pas là puisque Microsoft fournit un « Explorateur OneLake for Windows » qui permet de naviguer dans les espaces de travail, les fichiers et les données (avec possibilité de charger, télécharger ou modifier) à la manière de l’explorateur de fichiers sous OneDrive.

OneLake est à la fois « un lac de données pour l’ensemble de l’organisation » et là où les données n’existent que sous forme unique mais utilisable par une grande diversité de moteurs analytiques.

« Toutes les briques de Microsoft Fabric et tous les workloads qui s’appuient dessus sont automatiquement connectés à Onelake, un peu comme toutes les briques et applications Microsoft 365 sont connectées à OneDrive. Les données sont organisées dans un Data Hub intuitif et sont automatiquement indexées pour favoriser leur découverte, leur partage, leur gouvernance et la conformité » détaille Arun Ulagaratchagan.

Au-dessus de OneLake, toute une collection de services et briques forment la « Microsoft Fabric » :

Data Factory (02) propose plus de 150 connecteurs vers des sources de données cloud et sur site, une interface utilisateur conviviale pour définir des transformations de sonnées par simple glisser-déposer et une véritable orchestration des pipelines de données.

Synapse Data Engineering (03) offre des expériences de création pour Spark, un démarrage immédiat avec des pools « live » et la possibilité de collaborer autour des données.

Synapse Data Science (04) fournit un flux de travail de bout en bout pour les scientifiques des données afin de construire des modèles IA sophistiqués, de collaborer facilement et de former, déployer et gérer des modèles d’apprentissage automatique.

Synapse Data Warehousing (05) offre « une expérience convergente de Lake House et d’entrepôt de données avec une performance SQL à la pointe de l’industrie sur des formats de données ouverts (Delta-parquet) » selon Microsoft. Elle est présentée comme la brique datawarehouse « next gen » de la fabrique.

Synapse Real-Time Analytics (06) permet aux développeurs de travailler avec des données provenant d’IoT, de télémétrie, de journaux et autres, et d’analyser des volumes massifs de données semi-structurées avec des performances élevées et une faible latence.

Power BI in Fabric (07) n’est autre que l’implantation directe de Power BI au cœur de la fabrique afin d’offrir à toutes les équipes de puissantes fonctions de visualisation des données mais aussi des analyses basées sur l’IA pour obtenir des informations pertinentes sur les données.

Data Activator (08) assure la détection et la surveillance des données en temps réel et peut déclencher des notifications et des actions lorsqu’il trouve des modèles spécifiques dans les données, le tout avec une expérience sans code (No-Code).

Bien évidemment, l’univers Microsoft Fabric intègre en standard tout ce qu’il faut pour tirer profit des données de l’univers Microsoft 365 comme celui de l’univers Dynamics 365.

Copilot in Microsoft Fabric (09)

D’un certain point de vue, Microsoft Fabric cherche à permettre à chacun dans l’entreprise de tirer de la valeur des données, qu’il soit un spécialiste de la data, un développeur ou un simple utilisateur. Et pour concrétiser cette vision, Microsoft a forcément dégainé son IA générative conversationnelle « Copilot ». De même qu’il y a un Copilot pour Microsoft 365, pour Dynamics 365 et pour la Sécurité, il y aura un Copilot pour Microsoft Fabric. Cette IA permet d’utiliser le langage naturel pour explorer les données, réaliser des requêtes complexes sous forme de discussion itérative, générer du code, trouver des corrélations, etc.

Permettre aux entreprises de créer leurs propres IA

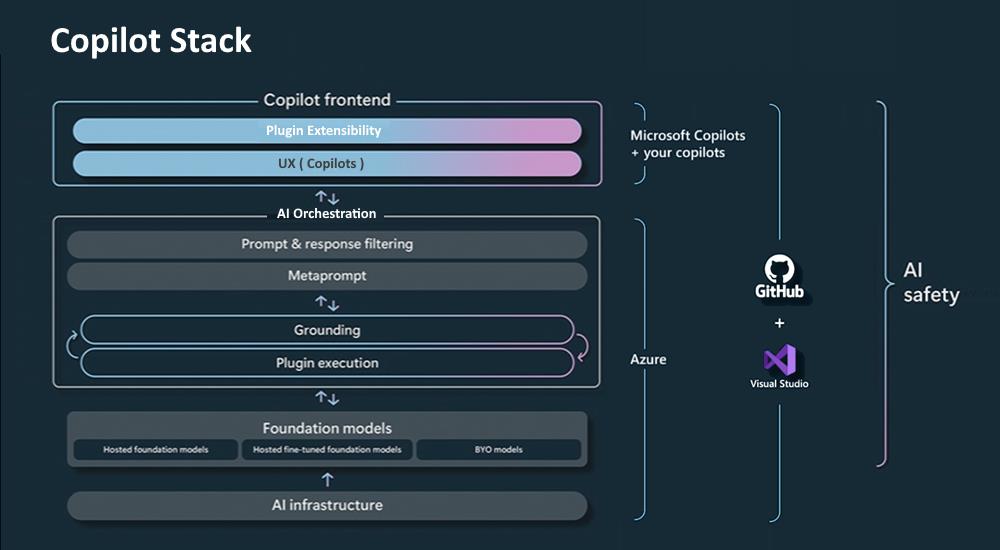

On l’a bien compris ces dernières semaines, Microsoft veut nous injecter du « Copilot » à toutes les sauces. Chez l’éditeur, derrière ce terme se cache l’idée d’une IA générative et conversationnelle, basée sur un LLM, permettant de dialoguer en langage naturel avec l’utilisateur.

Mais derrière ce label « Copilot » se dissimule également une pile logicielle, la « Copilot Stack » que Microsoft cherche à populariser pour permettre aux entreprises de créer leurs propres ChatGPT avec leurs propres contraintes métiers et de sécurité. « Il se peut qu’en regardant Bing Chat, vous pensiez qu’il s’agit d’une chose super magique et compliquée, mais Microsoft donne aux développeurs tout ce dont ils ont besoin pour commencer à créer leur propre ‘copilot’ », explique Kevin Scott, CTO de Microsoft. « Je pense que de telles interfaces homme-machine seront, dans les années à venir, intégrées au fonctionnement de tous les logiciels ».

Et Microsoft a donc commencé à Build à délivrer les premières briques permettant aux entreprises de monter leurs propres IA « Copilot »…

Azure AI Studio (10)

Et la pièce maîtresse de cette stratégie n’est autre que Azure AI Studio. « Avec Azure AI Studio, nous facilitons la tâche des entreprises pour leur permettre d’ancrer les modèles Azure OpenAI Service sur leurs propres données … et le faire en toute sécurité sans avoir à former un modèle sur les données » explique John Montgomery, responsable de la plateforme AI de Microsoft. « C’est un formidable accélérateur pour aider nos clients à construire leurs propres copilotes ».

Azure AI Studio est à la fois un service et une interface rattachée aux « Azure OpenAI Services ». Il simplifie fondamentalement l’usage des « Azure OpenAI Services » qui, rappelons-le, constituent une mise à disposition des grands modèles d’OpenAI (GPT 3.5, GPT 4, ChatGPT, Codex, Dall-E, Whisper) dans un « tenant » propre à votre entreprise.

Avec Azure AI Studio, il devient plus facile de connecter vos données aux grands modèles d’OpenAI, en toute sécurité (on reste dans le « tenant » de votre entreprise) et en toute confidentialité (vos données ne sont pas utilisées pour entraîner ou réentraîner les modèles).

Azure AI Studio introduit ainsi deux concepts complémentaires dont les DSI doivent avoir connaissance : les vecteurs via Azure Cognitive Search et le RAG.

Azure Cognitive Search (11) est un service qui permet d’implémenter des fonctions de recherches sur des contenus hétérogènes propres à l’entreprise pour les applications Web , mobiles et d’entreprise. Ce dernier sert de moteur aux « vecteurs » qui permettent, en appui sur Azure AI Studio d’implémenter de puissantes fonctions de recherches sémantiques en tenant compte de similarités entre les mots ou phrases.

RAG (12), acronyme de « Retreaval Augmented Generation », est une technique qui permet de combiner un LLM avec un extracteur de documents pour générer du texte sur la base d’informations pertinentes provenant des différentes sources internes ou externes de l’entreprise.

Ce sont ces technologies intégrées au cœur de Azure AI Studio qui permettent aux entreprises d’utiliser les LLM sur leurs propres savoirs informationnels sans avoir à réentraîner les modèles avec leurs propres données.

Azure AI Open Catalog (13)

Au-delà des modèles d’OpenAI, Microsoft veut aussi simplifier pour les entreprises l’accès à de nombreux autres modèles, ceux de Microsoft avec les Azure Cognitive Services, mais aussi et surtout ceux de l’univers open source avec Azure AI Open Catalog, un nouveau catalogue de modèles fondamentaux open source, intégré au cœur Azure ML. Ce catalogue comprend notamment les modèles de la communauté Hugging Face Hub. Azure AI Open Catalog dans AzureML est la réponse de Microsoft aux annonces récentes de Google (Vertex AI Generative AI Studio) et AWS (Amazon BedRock) en la matière.

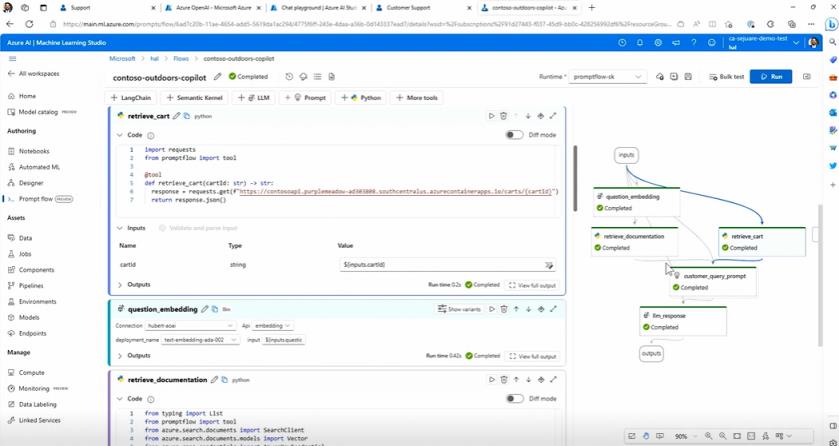

Azure Machine Learning prompt flow (14)

On parle de plus en plus de « prompt engeneering » ou encode de science d’interrogation des grands modèles linguistiques. AzureML Prompt Flow est le premier outil de data-science convivial focalisé sur cette problématique. Doté d’une interface visuelle, il permet aux « prompt engineers » et aux data scientists d’élaborer, tester, évaluer, améliorer de façon itérative des modèles d’interrogation des LLMs pour obtenir des rendus optimaux. L’outil s’interface aisément avec la bibliothèque open source LangChain et permet de récupérer les invites et flux déjà développés à l’aide de cette bibliothèque pour les évaluer, les optimiser et les passer en production plus aisément depuis l’interface Azure ML Prompt Flow.

Azure AI Content Safety (15)

Azure AI Content Safety est un nouveau service dopé à l’IA qui permet aux entreprises de proposer des IA plus sûres et notamment des « copilots » plus sûrs.

Le service permet d’évaluer et modérer aussi bien le contenu soumis dans les interrogations des utilisateurs (que ce soit du texte, des images ou une combinaison des deux) que le contenu généré par l’IA générative. Le service détecte et attribue des scores de gravité aux images et aux textes dangereux dans toutes les langues ce qui permet de bloquer ce qui est potentiellement dangereux ou de filtrer ce qui doit être soumis à des modérateurs. Il peut également être personnalisé pour répondre aux réglementations et politiques d’une organisation. Microsoft va d’ailleurs intégrer Azure AI Content Safety dans ses produits, à commencer par Azure OpenAI Service et AzureML.

Au passage, signalons que le Dashboard « Responsible AI » déjà présent dans AzureML accepte désormais les données textuelles et images pour mieux identifier les erreurs, les performances, les biais.

Copilot Stack (16)

L’ensemble des outils évoqués ci-dessus forme ce que Microsoft nomme sa « Copilot Stack », autrement dit une pile d’outils, de services et de couches de données permettant aux entreprises de produire des IA Copilot alimentées en toute sécurité par les données de l’entreprise et animées par des grands modèles linguistiques, qu’ils viennent d’OpenAI ou des communautés open source.

AzureML Model Monitoring (17)

Une fois un modèle IA entraîné, perfectionné, testé et mis en production à l’aide d’AzureML, il faut encore le surveiller et suivre ses performances d’autant que l’évolution des données ou du comportement des utilisateurs peut en affecter le fonctionnement. Grâce à AzureML Model Monitoring, vous pouvez surveiller sans effort l’état général de fonctionnement des modèles déployés mais aussi recevoir des alertes en temps voulu sur les problèmes critiques, analyser les résultats pour améliorer le modèle et minimiser les nombreux risques inhérents au déploiement de modèles de ML.

Microsoft Olive (18)

Microsoft Olive est un ensemble d’outils pour l’optimisation et la conversion des modèles PyTorch vers ONNX (format universel pour les inférences), permettant aux développeurs d’exploiter automatiquement l’accélération matérielle GPU telle que celles offertes par les RTX Tensor Cores des dernières cartes NVidia. Dit autrement, c’est un kit d’optimisation de modèles pour Windows (et WinML), pour WSL (Windows Subsystem for Linux) et les cartes GPU de NVidia. Les développeurs peuvent optimiser les modèles via Olive et ONNX, et déployer les modèles accélérés par les Tensor Cores sur PC ou dans le cloud. Microsoft continue d’investir pour que PyTorch et les outils et frameworks associés fonctionnent de manière transparente avec WSL.

À LIRE AUSSI :

Utiliser l’IA avec un minimum de développement

Avec Azure OpenAI Services, Azure Cognitive Services et Azure AI Open Catalog, Microsoft facilite l’accès aux modèles et à des services IA « clés en main » pour les entreprises qui n’ont pas besoin de compétences avancées en Machine Learning pour rendre leurs applications plus intelligentes et plus conversationnelles.

Mais l’éditeur insuffle également davantage d’IA dans d’autres outils de développement pour permettre aux entreprises de créer des applications intelligentes sans compétences IA particulières. Et ça commence par sa plateforme de développement Low-code « Power Platform » qui, sans surprise, se voit désormais affublée de toute une série de « copilots »…

« Nos nouvelles fonctionnalités pour Power Platform vont transformer la façon dont les développeurs travaillent en augmentant leur vitesse, leur agilité et leur capacité à fournir des solutions dans des environnements techniques complexes » explique Charles Lamanna, CVP Power Platform chez Microsoft. « Bien sûr, la plateforme fournit déjà des outils low-code complets qui augmentent la productivité des développeurs grâce à plus de 1 000 connecteurs de données intégrés, d’innombrables composants et des environnements de développement simples à utiliser. Mais avec l’IA Power Platform Copilot le développement low-code est encore accéléré d’une manière vraiment intéressante – le low-code permet aux développeurs d’aller plus vite, mais l’IA plus le low-code permettent aux développeurs d’aller encore plus vite. »

Copilot in Power Apps (19)

Microsoft avait déjà démontré comment son IA Copilot permettrait de créer une application, simplement, en appui sur Microsoft Dataverse et une description textuelle. Mais désormais le principe de création assisté par l’IA va beaucoup plus loin en proposant aux citizen devs de travailler en véritable collaboration avec l’IA pour créer des applications multi-écrans complexes en conversant.

Typiquement, il est possible de demander à l’IA : « Crée un nouvel écran d’authentification », « Ajoute un écran où les utilisateurs peuvent soumettre et classer leurs idées favorites en t’inspirant des écrans existants », « Ajouter un bouton à la page pour permettre de trier les données », « Changer la couleur de tous les boutons de mon application en bleu », « Centre tous les boutons dans leurs conteneurs et passe-les en Orange »…

Copilot in Power BI (20)

Power BI est l’outil de BI en Self Service et de visualisation des données de Microsoft. Avec Copilot, il est très facile de générer des graphiques, des diapositives ou de sélectionner et résumer des données simplement en conversant avec l’IA.

« Avec Copilot dans Power BI, nous insufflons la puissance des grands modèles de langage au cœur de la BI pour aider tous les collaborateurs de l’entreprise à passer plus rapidement des données aux ‘insights’. Vous pouvez simplement décrire les visuels et les informations que vous recherchez, et Copilot fera le reste », explique Charles Lamanna. Selon Microsoft, Copilot dans Power BI peut désormais aider chacun à délivrer des enseignements tirés des données avec plus d’impact.

Power Automate gagne un Copilot et un SDK (21)

Power Automate est la plateforme d’automatisation des processus. Elle comporte un outil RPA pour automatiser les applications Windows et un outil d’automatisation de Workflow (façon Zapier ou IFTTT). À Build 2023, Microsoft a annoncé un nouveau kit « Actions SDK » pour étendre les actions proposées en standard.

Mais Power Automate se voit également doté d’un copilote, qui permettra aux utilisateurs de créer des flux de travail (ou des éléments de flux de travail) en utilisant le langage naturel plutôt que l’interface visuelle par ‘drag and drop’.

Copilot dans Power Pages (22)

Power Pages est l’outil de création de sites Web de la Power Platform. En quelques clics, on peut concevoir, configurer et publier un site Web moderne. Même si le service dispose d’une interface très visuelle et conviviale, l’introduction de Copilot dans Power Pages permet de rapidement générer du texte, concevoir des formulaires, préparer une mise en page et au final créer des pages complètes en conversant avec l’IA.

Power Virtual Agents (23)

Avec l’arrivée des LLM et leur étonnante capacité à comprendre les requêtes et générer des réponses dans une langue irréprochable, il est temps de faire passer les chatbots des entreprises dans une nouvelle ère.

Power Virtual Agents permet désormais de créer des chatbots bien plus intelligents et doués pour la conversation, dotés de capacités de recherche étendues. Au passage, Microsoft unifie ses outils « Bot Framework Composer » et « Power Virtual Agents » au sein d’un même canevas.

Microsoft souligne que grâce à l’intégration de GPT-4 au cœur de Power Virtual Agents, les créateurs de Bots vont passer beaucoup moins de temps à construire des conversations nœud par nœud en partant de zéro et se concentrer davantage à la sélection des sources de connaissance et aux actions réalisables. Car l’introduction de l’IA générative dans Power Virtual Agents se traduit aussi par l’introduction de « generative actions »…

À LIRE AUSSI :

La naissance d’un écosystème « Copilot » !

C’est peut-être l’annonce la plus importante de cette Build 2023. Les « IA » Copilot, à commencer par Microsoft 365 Copilot, vont s’enrichir d’un mécanisme de plugins. Mieux encore, celui-ci adopte le même format de plugins que celui d’OpenAI pour ChatGPT…

Des plugins pour les IA « Copilot » (24)

Les plugins sont un atout clé pour ces IA conversationnelles. Ils permettent d’étendre le savoir de l’IA conversationnelle, de renforcer ses capacités (en calcul scientifique par exemple), de lui apprendre de nouvelles aptitudes (en l’interfaçant avec des API ou d’autres IA), etc.

Sur Microsoft 365 Copilot (et sur les autres IA Copilot de Microsoft), les plugins peuvent prendre trois formes différentes :

– Des extensions aux messages Teams,

– Des connecteurs vers la Power Platform,

– Des plugins au format OpenAI ChatGPT.

Cette compatibilité avec le format de plugins d’OpenAI va évidemment grandement simplifier le travail des développeurs mais aussi permettre aux IA de Microsoft d’acquérir immédiatement les nouvelles aptitudes développées par OpenTable, Zillow, WolframAlpha, Adobe, Atlassian et plus de 100 autres partenaires pour ChatGPT.

« Les développeurs vont ainsi pouvoir créer des expériences qui permettent aux utilisateurs d’interagir avec leurs applications et services en utilisant l’interface la plus naturelle au monde : le langage humain » explique l’éditeur. « Ces plugins peuvent être perçus comme des ponts entre le modèle de l’IA conversationnelle et un jeu de données, un service ou le Backoffice de l’entreprise ».

À LIRE AUSSI :

Transformer Windows et Edge par l’IA

La Build est la conférence des plateformes Microsoft et donc la grande messe en l’honneur de Windows et de Microsoft Edge. L’édition 2023 n’a évidemment pas dérogé à cette règle d’autant que l’occasion était trop belle d’y intégrer également de l’IA.

Windows Copilot (25)

C’est l’annonce la plus grand public de cette Build. Nous en avons déjà longuement parlé dans nos colonnes. L’éditeur a dévoilé l’arrivée dès Juin (en preview) de Windows Copilot, dernière déclinaison en date des IA « Copilot ».

Il s’agit ici d’implanter une IA au cœur de Windows pour converser avec le système, avec les documents et avec les applications. « Cette IA fait de chaque utilisateur un utilisateur avancé, en l’aidant à agir, à personnaliser ses paramètres et à se connecter de manière transparente à ses applications préférées », explique Panos Panay, le patron des divisions Windows et Surface chez Microsoft.

Il suffit de demander à Windows Copilot comment faire quelque chose pour que non seulement il vous explique comment le faire mais vous propose également de le faire à votre place en 1 clic. On peut aussi demander à l’IA de résumer des documents, de retranscrire un enregistrement audio, etc.

Windows Terminal + GitHub Copilot (26)

Windows Terminal se dote lui aussi d’une intelligence conversationnelle grâce à une intégration directe avec GitHub Copilot. Les administrateurs et développeurs peuvent désormais utiliser le chatbot directement dans Terminal pour effectuer diverses actions, découvrir des commandes, générer des scripts PowerShell, obtenir des recommandations de code et expliquer les erreurs. Microsoft voudrait d’ailleurs intégrer GitHub Copilot à d’autres outils tels que WinDBG.

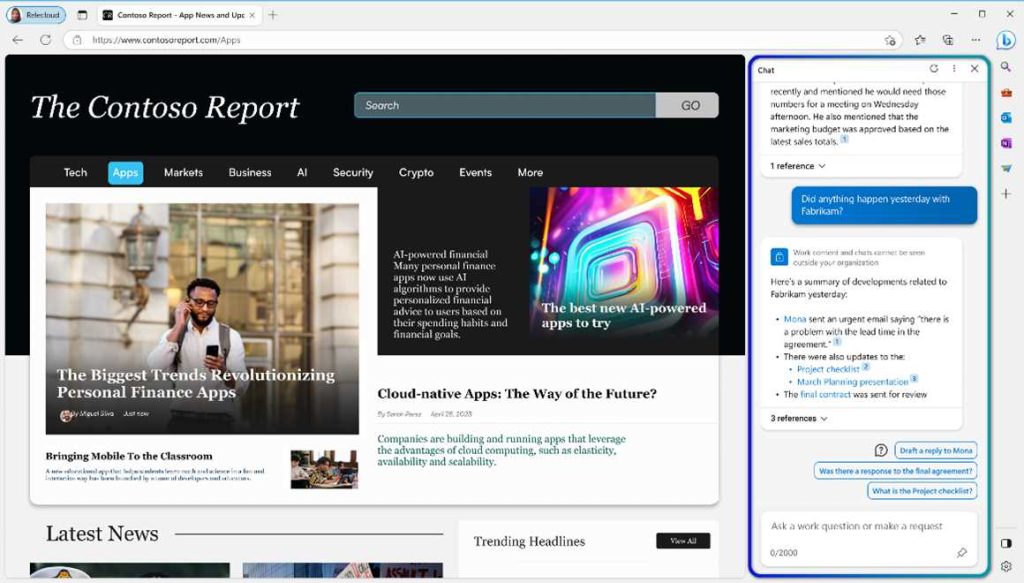

Intégration de « MS 365 Copilot » dans Edge (27)

Si Bing Chat (déjà très intégré dans Edge) est plutôt pensé pour des expériences Web et personnelles, Microsoft 365 Copilot est lui bien davantage orienté vers l’entreprise et les usages professionnels. Mais l’IA va bénéficier de la même intégration dans Edge que Bing Chat. Elle va en effet aussi rejoindre la barre latérale du navigateur pour simplifier les interactions avec les sites Web de l’entreprise, son intranet, les services « Office 365 », et d’une manière générale tous les services utilisés par l’entreprise via le navigateur Web.

Edge for Business (28)

Microsoft fait le forcing pour imposer son navigateur Web. Et notamment dans l’univers des entreprises ! L’éditeur le décline en version « Microsoft Edge for Business » spécialement forgée pour l’univers du travail. L’interface et certaines fonctionnalités ont été retravaillées pour offrir une nouvelle expérience alignée avec l’univers du travail et les usages professionnels du Web. « Pour mieux réaliser notre mission d’offrir le meilleur navigateur pour les entreprises, nous faisons évoluer Microsoft Edge pour qu’il offre une expérience de travail dédiée » explique ainsi Lindsay Kubasik, responsable produit Edge chez Microsoft dans un billet de blog. « Avec ses nombreux contrôles d’entreprise, ses sécurités et ses fonctionnalités de productivité, … Edge for Business est destiné à devenir l’expérience de navigation standard des organisations, en appui sur un login Azure Active Directory (AAD) conçu pour aider à répondre à l’évolution du paysage de la sécurité tout en permettant aux utilisateurs de travailler efficacement. »

Microsoft Edge for Business permet de mieux séparer activités professionnelles et activités personnelles, notamment lorsqu’on télétravaille à la maison. Le navigateur offre deux modes de navigation. Les sites « professionnels » s’ouvrent automatiquement dans une instance aux contrôles de confidentialité renforcés alors que les sites plus ludiques et grand public s’ouvrent dans une instance classique. Chacune des expériences, « travail » et « perso », utilise son propre cache, son propre stockage, son propre historique. De même, les identifiants de vos sites et services personnels ne sont pas synchronisés avec le compte entreprise.

Avec Microsoft Edge for Business, Microsoft veut proposer un navigateur à la fois plus administrable à distance (via une Intune et des politiques de sécurité par exemple) mais aussi qui sépare mieux les activités « perso » et « pro » alors que les utilisateurs pratiquent souvent un peu des deux.

Edge Workspaces (29)

En preview privée depuis de nombreux mois, Edge Wokspaces permet de partager au sein d’une même équipe de collaborateurs un ensemble d’onglets. « Avec les Workspaces de Microsoft Edge, tout le monde dans une même équipe peut consulter les mêmes sites Web liés à un projet et les derniers fichiers de travail relatifs en un seul endroit, sous la forme d’un ensemble partagé d’onglets » résume Lindsay Kubasik, responsable produit Edge. Le système est bien évidemment sécurisé : si des fichiers protégés ou des sites personnels (comme l’email) sont ouverts dans des onglets, seules les personnes qui y ont vraiment accès peuvent les consulter.

À LIRE AUSSI :

Du nouveau pour les développeurs d’entreprise

Microsoft continue d’avancer la plateforme Windows et de célébrer le développement sous Windows quelle que soit l’architecture des processeurs et que les besoins s’appliquent au Desktop ou dans le Cloud.

Microsoft poursuit ses efforts sur ARM

À Build, Microsoft a confirmé son engagement à imposer l’architecture ARM sous Windows. Même si les efforts déployés depuis cinq ans n’ont pas vraiment porté leurs fruits, l’éditeur ne désespère pas de voir l’écosystème Windows embrasser plus largement les processeurs ARM. Ce qui passe d’abord par la disponibilité des outils de développement. Microsoft a confirmé que Visual Studio 17.6 version native ARM sera désormais livré avec la version ARM du framework cross-plateforme MAUI, que LLVM 12 incorporera une option de compilation ARM, que Node 20.0 Windows intègre le support ARM natif, que Wix Installer supporte des installateurs ARM natifs, et que le player Unity si populaire dans l’univers des jeux vidéos sera disponible en Juin en version native Windows ARM.

Dev Home (31)

Autre grande surprise de cette Build 2023, Microsoft a lancé ce qu’il appelle une nouvelle « expérience » Windows pour développeur, une sorte de centre de contrôle pour favoriser la productivité des développeurs et fluidifier les workflows de développement : Dev Home.

« Dev Home est un nouveau centre de contrôle pour Windows qui permet de surveiller les projets dans un tableau de bord à l’aide de Widgets personnalisables, de configurer votre environnement de développement en téléchargeant des applications, des paquets ou des dépôts, de vous connecter à vos comptes et outils de développement (tels que GitHub)… Dev Home permet aux devs de configurer rapidement leurs machines, de se connecter à GitHub et de surveiller et gérer les flux de travail au sein d’un emplacement central. Dev Home est open source et extensible, ce qui permet aux utilisateurs d’améliorer leur expérience grâce à un tableau de bord personnalisable et aux outils dont ils ont besoin pour réussir.» explique Microsoft.

Plus concrètement, Dev Home se présente sous la forme d’un tableau de bord composé de Widgets pour, par exemple, surveiller la performance des GPU, lister les connexions SSH, surveiller l’occupation mémoire, réseau ou CPU, offrir une visibilité sur vos activités GitHub. Ce Dev Home est totalement personnalisable mais surtout très extensible puisque les développeurs peuvent créer leurs propres Widgets via les « Dev Home Extensions« .

Dev Drive (32)

Autre surprise et nouveauté, Dev Drive est une nouvelle technologie de volumes de stockage spécialisé dédié aux besoins des développeurs. Il se démarque par des performances bien supérieures et une fiabilité renforcée. Il s’appuie sur le système de fichiers résilient ReFS et tire profit du mode « performance » récemment introduit dans Microsoft Defender. Microsoft explique que ce nouveau type de volume de stockage peut améliorer les temps de compilation de 30% par rapport à un volume Windows 11 classique. « Avec Dev Drive, vous pouvez créer un volume séparé sur votre PC qui améliorera les performances pour les opérations sur disque telles que le clonage, la construction, la copie de fichiers et la restauration de paquets » explique Microsoft.

Des Dev Box musclées (33)

Lancé lors de la Build 2022, les Microsoft Dev Box est une solution DaaS (Desktop as a Service) spécialement pensée pour les besoins des développeurs. Ce sont des workstations dans le cloud préconfigurées pour immédiatement démarrer un développement. C’est un service en « self-service », similaire à Windows 365, mais orienté vers les besoins de développeurs. Désormais les Dev Box, qui seront officialisées en « GA » en juillet prochain peuvent accepter 16 vCPU et même 32 vCPU et embarquer jusqu’à 128 Go de RAM, des configurations qui n’existent pas sous Windows 365. Plusieurs images de démarrage sont proposées par Microsoft et désormais il est possible de coder des configurations via une fonctionnalité « Config as Code ».

Une vidéo plutôt instructive explique comment et pourquoi Microsoft est en train de migrer tous ses développeurs sur des Dev Box.

Cette Build 2023 aura finalement été une occasion de voir de près comment l’éditeur est en train de réinventer tout son portfolio de produits et tous ses Business à l’ère de l’IA. L’effort est assez impressionnant. Et il ne fait guère de doute que l’IA sera à nouveau le thème central des deux prochaines méga-conférence de Microsoft, la Microsoft Inspire 2023 (les 18 et 19 juillet) et la Microsoft Ignite 2023 (les 15 et 16 novembre).

À LIRE AUSSI :