Data / IA

Gouverner l’IA par les règles : comment décider sans halluciner selon IBM

Par Thierry Derouet, publié le 30 septembre 2025

Dans l’entreprise, décider ne se « devine » pas : il faut des règles, des preuves et des journaux d’audit. IBM Decision Intelligence illustre ce tournant en combinant extraction LLM, scores ML et moteur de règles pour appliquer — et expliquer — les politiques métier.

«Les LLM ne montrent pas, à ce stade, une capacité de raisonnement suffisamment fiable pour les décisions d’entreprise. » La mise en garde de Stéphane Méry, Distinguished Engineer et CTO Decision Intelligence chez IBM, sonne comme une entrée en matière. À l’heure où agents et modèles génératifs s’invitent partout, un rappel s’impose aux DSI : une décision n’a de valeur que si elle est exacte, traçable, explicable. IBM Decision Intelligence illustre ce virage : marier moteurs de règles et scores de machine learning, tout en réservant l’IA générative à l’amont — lecture et extraction — pour accélérer sans confier le verdict à un modèle probabiliste.

Dans la vraie vie des SI, l’approbation d’un crédit, le traitement d’une réclamation ou un contrôle antifraude ne tolèrent ni approximation ni improvisation. Les grands modèles génératifs lisent, résument, préremplissent ; ils restent, par nature, probabilistes : « Ils vont essayer de répondre, mais parfois la réponse est inventée », tranche Stéphane Méry. D’où le retour aux fondamentaux : extraire les règles des politiques internes, les formaliser en langage naturel contrôlé, les exécuter dans un moteur déterministe, et réserver les LLM là où ils excellent — compréhension de texte, extraction de champs, classification de pièces. « Fiabilité, exactement », insiste l’ingénieur. « On revient à une IA hybride : règles pour décider, ML pour scorer, LLM pour extraire. Et surtout, des règles que les métiers éditent en langage naturel contrôlé. »

Remettre des règles dans la décision

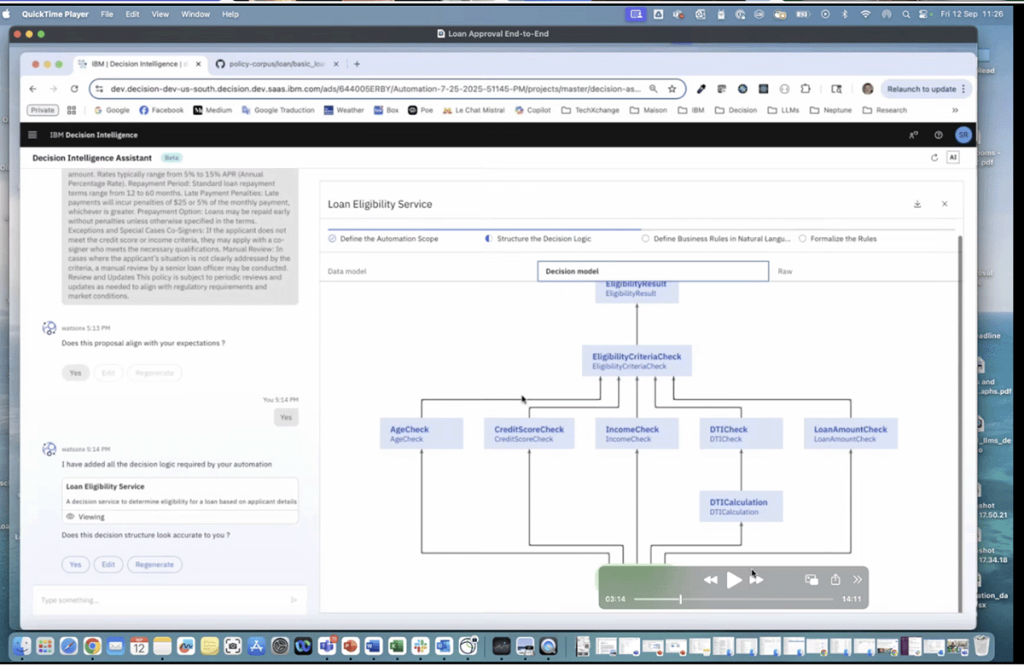

La proposition d’IBM se lit ainsi, au-delà du vernis marketing : raccourcir la distance entre une intention métier et son implémentation sûre dans le SI. Un « Decision Assistant » lit la politique d’entreprise, en extrait l’ontologie (concepts, données, contraintes), décompose la décision en sous-décisions et propose des règles en langage naturel contrôlé. L’utilisateur métier reste dans la boucle, valide, corrige, teste. Puis vient l’exécution : un moteur à base de règles, ouvert à des scores prédictifs, expose la décision sous forme d’API. Le tout est gouverné, versionné, journalisé — auditabilité de bout en bout. « Le succès de l’IA générative a mis en exergue un besoin simple : appliquer les règles et prouver qu’on les a appliquées », observe Stéphane Méry. Avec un bénéfice opérationnel que les équipes fraude connaissent bien : la capacité à faire évoluer la logique au rythme des attaques. « Pour lutter contre de nouveaux patterns de fraude, nos clients insèrent des règles plusieurs fois par jour. »

Ne pas se passer d’IA mais l’encadrer avec des règles

L’enjeu n’est pas de « se passer d’IA », mais de l’encadrer. Dans un front conversationnel, un agent peut parfaitement accueillir un client, collecter ses pièces, vérifier des champs, puis déléguer la décision à un service qui applique la politique — plutôt que de « deviner » la réponse. Les standards émergents du type Model Context Protocol (MCP) vont précisément dans ce sens : l’agent appelle un tool décisionnel, qui renvoie un verdict expliqué et journalisé. On garde les gains de productivité de l’IA générative sans sacrifier la rigueur décisionnelle.

On ne reprogramme plus, on règle

Cette rigueur paie aussi sur le terrain réglementaire. Pour des cas d’usage sensibles — crédit, assurance, lutte contre la fraude, recouvrement —, documenter la logique, tester avant déploiement, tracer chaque exécution et fournir l’explication associée n’est pas un confort d’architecte : c’est la voie la plus directe pour passer les audits et démontrer la conformité. « Les entreprises sont obligées, parfois par la loi, d’expliquer pourquoi une décision a été prise », rappelle Stéphane Méry. D’un point de vue industriel, extraire les règles du code applicatif pour les rendre éditables par le métier (no/low-code) change aussi l’économie des projets : on ne reprogramme plus, on règle — et on mesure l’effet des changements sur des KPI de churn, d’acceptation, de marge ou de sinistralité. IBM pousse d’ailleurs cette logique jusqu’au suivi opérationnel, en alignant le décisionnel sur des tableaux de bord qui rendent le feedback loop enfin actionnable.

« Avec les vieux pots, on fait les meilleures soupes »

Le plus intéressant, peut-être, tient à cette articulation entre modernité et tradition. « Avec les vieux pots, on fait les meilleures soupes », sourit Stéphane Méry, en assumant le retour en grâce d’une IA symbolique que l’on disait ringarde : systèmes experts, moteurs à base de règles, algorithmes d’optimisation. La modernité n’est pas de les remplacer, mais de les composer avec le meilleur des LLM et du ML — extraction ici, scoring là — pour livrer des décisions précises, explicables, rejouables en production. Et rapides, aussi : « On prend des décisions en quelques millisecondes sur CPU », rappelle-t-il, là où des inférences massives de LLM exigeraient des grappes de GPU pour des résultats… moins sûrs.

L’humain doit rester dans la boucle

Reste l’horizon. Tout le monde rêve d’un système qui ajuste sa logique en continu, en fonction du marché, de la pression concurrentielle ou de l’évolution des risques. Stéphane Méry tempère : la cible est crédible, mais l’humain doit rester dans la boucle — pour fixer les objectifs, contrôler, amender. La bonne démarche, côté DSI, est d’une simplicité désarmante : cartographier vos décisions critiques ; sortir les règles du code et les confier aux métiers dans un modèle gouverné et testable ; cantonner les LLM à ce qu’ils font de mieux ; instrumenter la boucle de retour avec des KPI acceptés par tous. « Le domaine de la decision intelligence, c’est remettre la décision au cœur du débat », dit-il encore. On ne « fait pas tourner un modèle » ; on conçoit un système de décision.

Que l’on parle crédit, litiges, remises ou fraude, la promesse est moins spectaculaire qu’un chatbot lyrique — mais infiniment plus utile pour des organisations qui n’ont plus le luxe de « débrancher » leurs expérimentations. Les LLM accélèrent. Les règles décident. Entre les deux, la chaîne RPA orchestre et documente. C’est peut-être cela, la véritable modernité : une IA qui ne cherche pas à briller, mais à tenir ses promesses.