Newtech

L’optique co-packagée optimise l’activité des GPU

Par Charlotte Mauger, publié le 07 mai 2025

À la place des fils en cuivre, la fibre optique suscite beaucoup d’espoirs dans la perspective de relier les processeurs au sein des datacenters. Elle permet en effet une communication plus rapide entre les puces et avec une plus large bande passante.

Lors de l’entraînement des modèles d’IA, les GPU ne sont pas sollicités en continu. En effet, puisque les tâches d’apprentissage sont distribuées, les processeurs graphiques peuvent rester inactifs plus de la moitié du temps en attendant la fin des calculs sur d’autres GPU ou la réception des données issues d’autres appareils. « Ce phénomène peut entraîner des dépenses d’énergie inutiles considérables. Et cela s’aggrave en raison des contraintes de vitesse et de bande passante [de l’ordre du Mb/s voire Gb/s au mieux, NDLR] des câbles électriques en cuivre actuellement utilisés », explique John Knickerbocker, ingénieur émérite chez IBM.

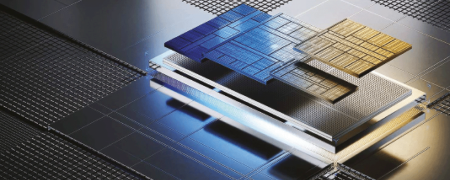

Avec ses performances qui vont jusqu’au Tb/s, la fibre optique offre la possibilité de passer outre ces limitations. Cette technologie est ainsi de plus en plus envisagée à la place des connexions en cuivre. Mais alors que la fibre optique est déjà largement adoptée par les datacenters pour leurs réseaux de communication externes, elle ne l’est pas encore pour les échanges à l’intérieur des racks et entre les racks. C’est justement l’objectif de l’optique co-packagée (CPO pour Co-Packaged Optics) ainsi nommée en référence à un co-package optoélectronique qui regroupe le moteur optique et la puce de commutation. Pour maximiser le rendement des GPU en activité, elle s’impose depuis deux ans comme une solution prometteuse. Le remplacement des connexions traditionnelles en cuivre par des liaisons optiques directement sur le bord des puces, permet un échange de données à très haute vitesse et une réduction du temps d’arrêt des GPU.

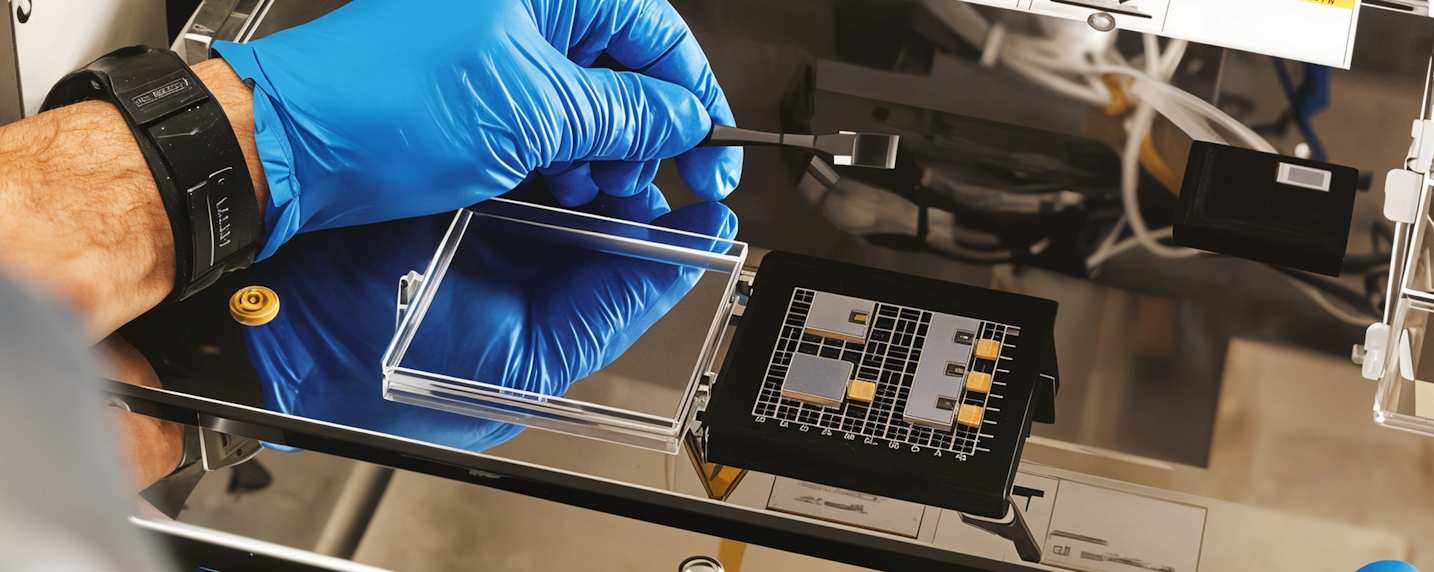

Test de la résistance du module d’optique co-packagée au laboratoire d’optique d’IBM à Yorktown Heights, aux États-Unis.

En décembre 2024, IBM a présenté un nouveau module CPO qui « a le potentiel d’augmenter encore la densité de bande passante entre les puces », soutient John Knickerbocker. Par rapport à une connexion en cuivre, la bande passante est multipliée par 80. Cet écart est permis notamment par la densité de bord de la technologie proposée : le nombre de fibres optiques pouvant être connectées à la périphérie d’une puce photonique en silicium est multiplié par six par rapport aux technologies CPO actuelles.

Cette avancée a un impact direct sur la consommation d’énergie à l’entraînement. « Sur des milliers de puces et des millions d’opérations, cela signifie des économies d’énergie massives – en fait, cela pourrait permettre d’économiser l’équivalent en énergie de la consommation annuelle de 5 000 foyers américains par modèle d’IA formé », estime l’ingénieur. Un calcul qui vaut pour les grands modèles de langage de l’envergure de GPT-4. Cette technologie CPO permet aussi un entraînement jusqu’à cinq fois plus rapide des modèles d’IA. Ainsi, selon IBM, celui d’un LLM de 70 milliards de paramètres ne prendrait plus que trois semaines au lieu de trois mois.

Avant son déploiement à grande échelle dans les datacenters, IBM poursuit ses travaux de validation et d’optimisation. Ses recherches continuent aussi afin d’augmenter encore la bande passante, d’optimiser l’efficacité énergétique et de miniaturiser les composants.

D’autres pistes pour optimiser l’activité des GPU

Outre l’optique packagée, d’autres solutions sont envisagées pour maximiser le temps d’activité des GPU. De nombreux chercheurs travaillent ainsi sur des architectures de calcul qui rapprocheraient les composants de mémoire et de calcul. Par ailleurs, « la distance entre les processeurs pourrait aussi être réduite pour que tous les modules nécessaires à l’apprentissage du modèle restent à moins d’un mètre », indique John Knickerbocker. Cela permettrait alors aux GPU de recevoir plus rapidement les données, même reliés entre eux par des fils en cuivre.

À LIRE AUSSI :

À LIRE AUSSI :