Cloud

Oracle AI World 2025 : Les 10 annonces clés à retenir…

Par Laurent Delattre, publié le 21 octobre 2025

À AI World 2025, Oracle redéfinit les codes : fini l’IA “boulonnée”, place à une pile “AI built-in” de bout en bout. La base parle vecteurs, l’infra monte en zettascale et les agents pilotent la donnée. Objectif : accélérer sans copier, gouverner sans freiner, innover sans re-platforming. Voici ce qu’il faut retenir des annonces majeures de cet Oracle AI World 2025, premier du nom…

En changeant le nom de son grand rendez-vous annuel d’Oracle CloudWorld (ces dernières années) à Oracle AI World 2025, l’éditeur acte une double bascule. D’une part que l’IA n’est plus un « service du cloud », mais devient le moteur d’une nouvelle transformation numérique-agentique des entreprises. D’autre part, qu’Oracle a définitivement pivoté vers une entreprise où l’intelligence artificielle n’est plus une fonctionnalité ajoutée, mais le fondement même de ses services, de son activité, de son architecture technologique. Un message, martelé tout au long des keynotes et des sessions techniques, au travers d’un même leitmotiv : l’avenir de l’entreprise repose sur une IA « intégrée, et non boulonnée » (« built-in, not bolted-on »)…

Oracle parie ainsi son avenir sur une pile technologique verticalement intégrée, où l’IA imprègne chaque couche, de l’infrastructure de supercalculateurs à l’échelle du zetta-octet jusqu’aux agents autonomes qui exécutent automatiquement les processus métier au sein de ses applications.

Lors de son Keynote d’ouverture, Lary Ellison s’est attaché à déchiffrer sa vision d’une IA appelée à devenir plus transformatrice que l’Internet lui‑même. Selon lui, la première phase de l’IA, fondée sur l’entraînement massif de modèles sur des données publiques, n’est qu’un prélude : la véritable révolution viendra de sa capacité à raisonner sur les données privées et sensibles des entreprises, à condition de garantir leur sécurité. C’est là qu’Oracle entend se distinguer, en combinant des centres de calcul colossaux – comme celui d’Abilene, équipé de centaines de milliers de GPU – avec une base de données et une plateforme capables de vectoriser l’information et de l’exploiter via des approches comme le RAG, sans fuite ni réentraînement complet. Ellison a illustré cette promesse par des exemples concrets, de la chirurgie robotisée à la détection précoce du cancer, en passant par la finance et l’agriculture, tout en martelant que l’avenir de l’IA se jouera dans l’intégration verticale : puissance de calcul, sécurité des données et applications sectorielles réunies dans un même écosystème. « La véritable opportunité n’est pas seulement de construire ces cerveaux électroniques extraordinaires, mais de les utiliser pour résoudre les problèmes les plus difficiles de l’humanité » a-t-il ainsi rappelé.

Et parce que l’on ne réinvente pas le monde d’un claquement doigt mais en s’appuyant sur les piliers que l’on maîtrise, Oracle s’est évertué à rappeler que la concrétisation de sa vision et d’une IA d’entreprise utile démarre de la couche où tout converge, à savoir la base de données, que l’éditeur, avec Database 26ai, érige en socle véritablement « AI-natif ».

« IA-native Database » : l’IA s’infiltre au cœur de la base de données

La couche de données est le système nerveux de l’intelligence artificielle. Et pour Oracle, l’IA doit habiter la base de données. Dit autrement, le SGBD devient un acteur actif et intelligent de l’IA, un moteur des workflows d’IA. L’annonce de l’Oracle AI Database 26ai est bien plus qu’une simple mise à jour de version. C’est un repositionnement fondamental du produit le plus emblématique de la firme ainsi qu’une importante refonte architecturale. L’entreprise insistant sur le fait que sa base de données n’est plus seulement « compatible avec l’IA », mais qu’elle est désormais « nativement IA ».

Oracle Database 26ai : une refonte majeure du plus célèbre SGBD

L’innovation clé de « 26ai » réside dans l’intégration des AI Vectors comme un type de données natif au sein du moteur de la base de données. Les vecteurs d’IA sont des représentations numériques du contenu sémantique d’objets complexes (texte, images, audio). En les gérant nativement, Oracle permet d’effectuer des recherches de similarité et des analyses sémantiques directement dans la base de données, à des vitesses extrêmement élevées. Cette intégration élimine le besoin pour les entreprises de déployer et de gérer des bases de données vectorielles spécialisées, distinctes de leurs systèmes principaux, simplifiant ainsi considérablement l’architecture pour les applications d’IA générative comme la recherche augmentée par génération (RAG). Cette intégration s’accompagne d’ailleurs d’une fonctionnalité AI Vector Search de nouvelle génération directement embarquée dans la base. Une façon de rappeler à tous les DSI que la recherche vectorielle n’est pas un marché distinct, mais une caractéristique essentielle d’une base de données moderne et convergée.

Autre innovation phare et d’avenir, la base de données 26ai intègre des agents IA pour sa propre gestion. Ces agents peuvent automatiser des tâches complexes de gestion et de sécurité, et exécuter des workflows en plusieurs étapes. La base de données devient ainsi elle-même « agentique », capable de s’auto-optimiser et de réagir de manière autonome aux événements, renforçant sa fiabilité et sa sécurité.

Mais ce n’est pas tout. Oracle Database 26ai intègre également une Agent Factory low-code pour créer et déployer des agents « maison », un Private AI Services Container pour exécuter des modèles LLM open-weights ou NER (Named Entity Recognition) sans exfiltrer les données, et des capacités de sécurité de plus en plus « by design », du SQL Firewall (qui apprend le profil d’exécution attendu et bloque les requêtes déviantes) à la crypto PQC (chiffrement Post-quantique).

La vision ne se limite pas à la fonctionnalité : elle associe Exadata for AI (vector offload, RDMA, Exascale) et Zero Data Loss Cloud Protect pour concilier performance, résilience et conformité. Au-delà de l’effet catalogue, le message aux DSI est pragmatique : accélérer les usages IA sans multiplier les copies, ni casser les patterns de gouvernance.

La vision d’Oracle s’étend au-delà des fonctionnalités de base. Côté performance, Exadata for AI déporte la recherche vectorielle vers le stockage intelligent, accélère les accès via RDMA et s’étire avec l’architecture Exascale pour absorber les pics sans re-platforming. Parallèlement, la solution Zero Data Loss Cloud Protect ajoute une restauration instantanée et une immunité accrue face aux ransomwares, afin d’aligner exigences IA et continuité d’activité.

L’ensemble de ces annonces raconte ainsi une même priorité : amener l’IA vers la donnée, préserver la gouvernance (masquage dynamique, contrôle au niveau ligne/colonne) et éviter les copies inutiles qui fragmentent coûts, risques et conformité.

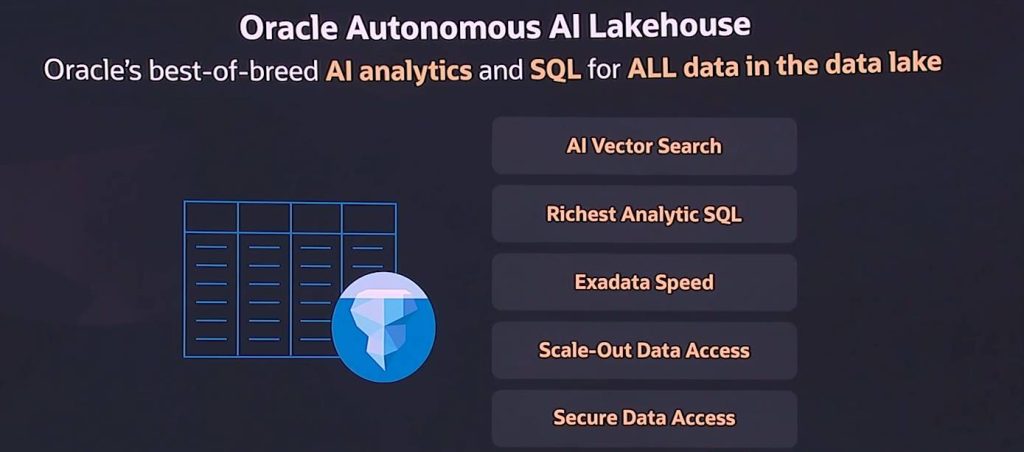

Lakehouse & Data Platform : Unifier le Paysage des Données

Cette « IA au cœur » se prolonge dans Autonomous AI Lakehouse. Cette plateforme est la réponse d’Oracle au besoin de combiner la flexibilité des lacs de données à Autonomous AI Database et au casse-tête actuel engendré par la multiplication des lacs hétérogènes, des catalogues, des copies de données, avec au final des équipes qui passent plus de temps à déplacer des datasets qu’à produire de la valeur. Concrètement, Oracle marie sa base Autonomous AI Database avec le standard Apache Iceberg pour que l’IA et l’analytique puissent travailler directement sur vos tables Iceberg, sans migrer les données. Avec l’idée de rendre plus « plug-and-play » l’accès aux données où qu’elles résident (sur OCI, AWS, Azure, Google Cloud ou Exadata Cloud@Customer) en s’appuyant sur la même couche de sécurité, de performance et de gouvernance. Le support d’Apache Iceberg permet à l’AI Lakehouse d’interroger et d’analyser des données qui résident dans des environnements multicloud sans avoir à effectuer de coûteux et lents processus de déplacement de données (ETL). La plateforme se branche aux catalogues existants (Databricks Unity, AWS Glue, Snowflake Polaris) et unifie la gouvernance via un « catalogue des catalogues » (Autonomous AI Database Catalog).

Concrètement, la plateforme déplace le calcul vers les données en fournissant tous les outils essentiels. Avec Select AI Agent, on pose une question en langage naturel et le système génère le SQL adéquat, peut chaîner des étapes « agentiques » et exécuter la requête sans copier les tables. Le Plug-and-Play SQL Access permet d’interroger immédiatement des jeux de données référencés dans les catalogues (Unity, Glue, Polaris), tandis que Exadata Table Cache garde en flash les fragments Iceberg les plus consultés pour retrouver des latences proches du natif. De son côté, GoldenGate for Iceberg alimente en temps réel vos tables analytiques depuis les applications opérationnelles, ce qui évite les batchs nocturnes et accélère les cas d’usage. Quand une requête est lourde, Data Lake Accelerator ajoute provisoirement réseau et compute, puis libère ces ressources : on paie à l’usage et on gagne du temps sans retoucher les pipelines. Un Data Science Agent doit prochainement s’ajouter à ces fonctions pour guider l’exploration et la préparation des données en langage naturel, dans le cadre de sécurité et de gouvernance de la base. Et pour partager un résultat, on peut générer un hyperlien de table temporaire plutôt qu’une nouvelle extraction, ce qui fluidifie les échanges tout en gardant le contrôle.

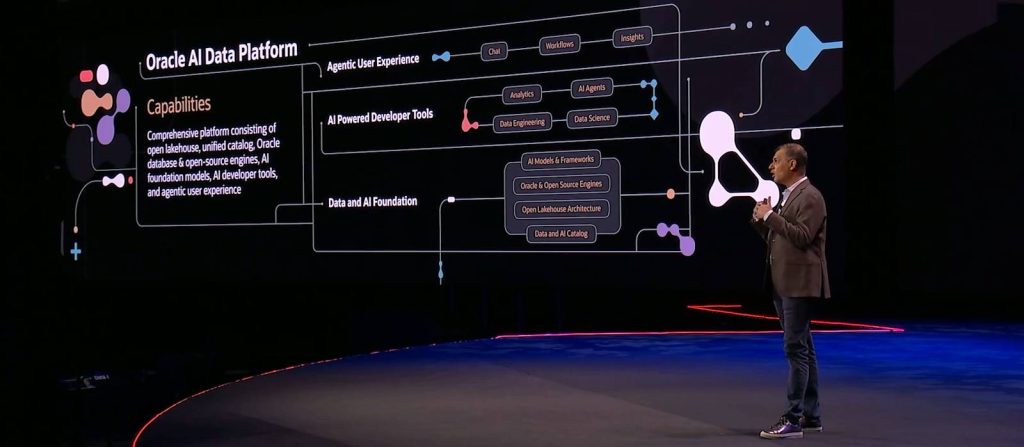

Autre innovation majeure, Oracle lance son « Oracle AI Data Platform » pour passer des données brutes à l’IA en production en unifiant et orchestrant l’ingestion, l’enrichissement sémantique, l’indexation vectorielle et les agents IA. Agissant comme une couche de contrôle unifiée, l’AI Data Platform rassemble les services de cloud (OCI), de base de données (Autonomous AI Database) et d’IA générative (OCI Generative AI) d’Oracle dans un environnement unique. Elle comprend un établi de développeur intégré (developer workbench) et, surtout, un « Agent Hub ». Cet Agent Hub est un centre de commande pour construire, orchestrer et gouverner les agents IA qui raisonnent sur ce paysage de données unifié, qu’il s’agisse de données structurées dans une base de données Oracle ou de données non structurées dans un lac de données sur un autre cloud.

Infrastructure hyperscale : des campus multi-GW aux régions « 3 racks »

Lors d’AI World 2025, l’entreprise a clairement indiqué qu’elle investissait massivement pour se positionner comme l’un des rares acteurs mondiaux capables de fournir une infrastructure de super-informatique dédiée à l’IA. Avec une stratégie qui fait le grand écart : d’un côté, repousser le plafond de performance pour l’entraînement et l’inférence des modèles géants, tout en, de l’autre côté, rapprochant le cloud des contraintes de souveraineté et de continuité d’activité des clients. Dit autrement, Oracle semble vouloir bâtir un continuum allant des campus multi-gigawatts aux régions dédiées “trois racks” opérées sur site.

OCI Zettascale 10 : les prémisses de Stargate

Au sommet de la pyramide, OCI Zettascale10 se présente comme « le plus grand superordinateur d’IA dans le cloud ». Cette initiative place Oracle dans la même catégorie que les hyperscalers les plus avancés en termes de puissance de calcul brute. Le cluster est « Zettascale10 » est conçu pour connecter des centaines de milliers de GPU NVIDIA avec une latence minimale. L’objectif initial de déploiement s’étend jusqu’à 800 000 GPU. Comme la performance d’un superordinateur d’IA ne dépend pas seulement du nombre de GPU, mais aussi de la vitesse à laquelle ils peuvent communiquer entre eux. Oracle met en avant son architecture réseau propriétaire de nouvelle génération, Oracle Acceleron RoCE, comme un différenciateur technique clé. Cette technologie est conçue pour offrir une latence ultra-faible entre les GPU, ce qui est crucial pour réduire les temps d’entraînement des modèles à grande échelle et maximiser l’utilisation des coûteux processeurs graphiques.

La configuration massive du Zettascale10 est ainsi capable de fournir une performance de pointe pouvant atteindre 16 zettaFLOPS (soit 16 trillions de milliards d’opérations en virgule flottante par seconde). Cette architecture alimente le site Stargate à Abilene (avec OpenAI) qui doit être pleinement opérationnel au second semestre 2026.

AMD : ne pas mettre tous ses œufs dans le même panier

Oracle complète ce premier axe par un second campus jouant ainsi la diversité et l’ouverture. Fruit d’un partenariat avec AMD, Oracle deviendra le premier hyperscaler à déployer un supercluster public alimenté par 50 000 GPU « next gen » d’AMD, la série Instinct MI450. Ce cluster utilisera l’architecture de rack « Helios » à refroidissement liquide d’AMD, incluant non seulement les GPU (72 par rack), mais aussi les CPU EPYC « Venice » et les solutions réseau DPU Pensando « Vulcano ». Ce premier cluster de 50.000 GPU sera opérationnel au troisième trimestre 2026 mais des extensions sont déjà en cours de discussion.

Ces infrastructures massives serviront d’une part à des clients géants comme OpenAI et Meta mais également à Oracle pour ses propres besoins et ceux de ses offres comme les solutions Fusion et les fonctionnalités IA de ses bases de données Cloud.

De l’hyperscale souverain façon Oracle

À l’autre extrémité du spectre, Oracle s’attaque aux contraintes d’implantation, de conformité et de résidence des données avec OCI Dedicated Region 25. La promesse : déployer, en quelques semaines, une région cloud publique complète avec plus de 200 services IA & cloud à parité avec OCI et ceci à partir de trois racks installés dans le datacenter du client, puis de la faire évoluer jusqu’à l’hyperscale par ajout modulaire. L’ensemble est opéré par Oracle comme un service managé, intègre une sécurité multicouche (racks à verrouillage biométrique, réseau SDN chiffré) et s’inscrit dans le portefeuille cloud distribué (public, dédié, hybride, multicloud). Pour les organisations soumises à des exigences strictes de souveraineté et de localisation, ou qui manquaient jusqu’ici d’espace, de temps ou de flexibilité réglementaire, cela ouvre la voie à une transformation cloud sans compromis sur la gouvernance et les contrôles. Tout au moins pour tous ceux qui peuvent évoluer en dehors des contraintes SecNumCloud.

IA métier & analytique : l’ère des agents au cœur des métiers

Au-delà des investissements colossaux dans l’infrastructure de l’IA et de la complète réarchitecture de sa pile de données pour l’IA, Oracle veut aussi traduire tous ces efforts en valeur métier tangible et donc en usages concrets. Sa stratégie consiste à opérationnaliser l’IA en l’intégrant directement au cœur des processus d’entreprise via une prolifération d’agents IA au sein de ses suites applicatives Fusion Cloud et de faire de l’IA un collaborateur silencieux au travers d’un nouvel Assistant IA agentique.

Un assistant pour dialoguer avec les données

Cet Assistant IA pour Oracle Analytics Cloud est une interface conversationnelle qui permet d’interroger ses données en langage naturel, dans le contexte métier de chaque application, et de produire des réponses qui vont au-delà du tableau de bord. « Le nouvel Assistant IA Oracle Analytics permet aux utilisateurs d’engager un dialogue avec leurs données et de solliciter un système qui comprend leur contexte métier spécifique, quel que soit l’environnement Fusion Data Intelligence utilisé » explique T.K. Anand, vice-président exécutif chez Oracle. On pose une question simple, l’outil traduit en requête analytique et renvoie directement un graphique, un tableau ou un résumé. Il s’appuie sur le modèle sémantique de l’entreprise, respecte les règles de sécurité et rend l’analyse accessible à tous, sans expertise technique. En somme, c’est un copilote qui transforme une conversation ordinaire en exploration visuelle et en prise de décision rapide.

Mettre en œuvre les cas d’usage de l’IA directement dans Fusion Cloud

Dans le même temps, Oracle annonce 50 nouveaux agents IA conçus pour automatiser des tâches et fournir des informations dans l’ensemble de la suite Fusion Cloud. Ces agents ne sont pas de simples chatbots, mais des programmes capables d’interagir avec les données, de raisonner et d’exécuter des actions.

Côté RH, de nouveaux agents apparaissent dans HCM pour aider à la mobilité interne en suggérant des postes aux employés, à la gestion de la performance en préparant des ébauches d’évaluations, et au développement des compétences en recommandant des formations pertinentes. Les benchmarks entre pairs aident à situer attrition, recrutement ou composition des équipes. Les agents Analytics des compétences éclairent où les expertises manquent, sont sous-utilisées ou menacées, pour piloter redéploiements et plans de montée en compétences.

Côté ERP et finance, des agents de workflow sont capables de simuler le traitement humain d’un document. Par exemple, ils peuvent lire une facture fournisseur, en extraire les données, vérifier leur exactitude (devise, conditions de paiement), et créer automatiquement la transaction correspondante dans le système financier, réduisant ainsi considérablement le travail manuel. Une nouvelle Workforce Investment App propose une vision unifiée des dépenses liées aux effectifs, avec scénarios what-if et recommandations par l’IA.

Côté gestion de la supply chain (SCM), des agents sont conçus pour surveiller la chaîne logistique, identifier les perturbations potentielles et recommander des actions correctives, ou encore pour optimiser les itinéraires de transport en temps réel.

Côté expérience client (CX) dans le domaine de la vente, des agents peuvent générer des résumés de devis pour les commerciaux. Pour le service client, des agents de triage analysent les demandes entrantes pour les prioriser, tandis que des agents de self-service guident les clients vers des solutions. En marketing, des agents aident à définir des segments d’audience plus précis pour les campagnes.

Conscient que la confiance est le principal obstacle à l’adoption de l’IA à grande échelle dans l’entreprise, Oracle a fortement insisté sur les outils de gouvernance intégrés à sa plateforme. Des fonctionnalités d’observabilité et d’évaluation permettent aux organisations de tester, de suivre et de noter la performance de leurs agents en termes de précision, de latence et de pertinence sémantique. Pour l’éditeur et plus encore pour les DSI, cette transparence est essentielle pour garantir que les agents se comportent de manière prévisible, sécurisée et responsable.

Un écosystème agentique avec Studio et Marketplace

Pour accélérer l’adoption et l’innovation, Oracle ne se contente pas de fournir des agents pré-construits, mais met aussi en place un véritable écosystème pour leur création et leur distribution.

Ainsi, AI Agent Studio prend du galon. Présenté comme un outil low-code/no-code, l’AI Agent Studio est conçu pour permettre aux clients et aux partenaires de construire, tester et déployer leurs propres agents IA personnalisés. Cette plateforme vise à démocratiser le développement de l’IA, en donnant aux experts métier, et pas seulement aux data scientists, les moyens de créer des automatisations intelligentes adaptées à leurs besoins spécifiques. À AI World 2025, Oracle a dévoilé une évolution majeure de son AI Agent Studion afin de prendre en charge une large gamme de LLM, y compris ceux de fournisseurs tiers comme OpenAI, Google, Meta et Anthropic, offrant une flexibilité maximale.

En parallèle, Oracle a annoncé le lancement d’une place de marché « Oracle Agent Marketplace » pour les agents IA. Il s’agit d’une initiative stratégique visant à créer un effet de réseau. Oracle fournit la plateforme (Fusion Applications et l’Agent Studio), tandis que son vaste écosystème de partenaires (incluant des géants du conseil comme PwC, IBM, Accenture, Deloitte et Infosys) est encouragé à construire et à monétiser des agents spécialisés par industrie ou par processus.Cette place de marché enrichit considérablement la valeur de la plateforme Fusion, offrant aux clients un accès à une bibliothèque croissante d’innovations.

Un Multicloud unifié

Terminons notre tour d’horizon de cet AI World 2025 par l’annonce la plus surprenante de cette conférence, une annonce qui n’a pas directement de lien avec l’IA mais tout à voir avec le cloud, ou plutôt le multicloud !

Avec son offre « Oracle Multicloud Universal Credits », l’éditeur introduit un modèle de consommation intercloud totalement unique en son genre. Il permet aux entreprises d’acheter et d’utiliser les services Oracle Database et Oracle Cloud Infrastructure (OCI) sur le cloud de leur choix (AWS, Azure, Google Cloud ou OCI) avec un seul contrat et une facturation unifiée. Oracle a conçu ce système pour lever un frein majeur à l’adoption du multicloud : la complexité des contrats, de la gouvernance et de la facturation. Avec ces crédits universels, une entreprise n’a plus besoin de négocier séparément avec chaque fournisseur ni de gérer des conditions différentes selon les plateformes. Elle dispose d’un modèle de consommation unique, valable sur plusieurs clouds, qui simplifie l’administration et accélère le déploiement de projets. Concrètement, une organisation peut acheter un volume de crédits Oracle et les dépenser indifféremment pour exécuter Oracle Database@AWS, @Azure ou @Google Cloud ; consommer des services OCI natifs ; ou encore déployer ses workloads dans la région cloud qui lui convient le mieux, en fonction de la proximité géographique, de la souveraineté des données ou des performances recherchées. Cette approche apporte aussi une portabilité accrue des charges de travail : les bases de données et applications Oracle peuvent être déplacées d’un cloud à l’autre sans rupture de contrat ni changement de modèle de gestion.

L’originalité est technique autant que politique : Oracle assume un multicloud pragmatique (ce que l’éditeur a d’ailleurs toujours poursuivi depuis le lancement d’OCI) mais également « multi-IA ». En agissant ainsi, l’éditeur cherche à ancrer un peu plus sa base IA et ses services là où les clients veulent travailler, sans déplacer les données. En proposant le premier modèle de crédits véritablement cross‑cloud, Oracle se positionne comme un facilitateur de la modernisation applicative et des migrations vers le cloud. Un seul portefeuille de crédits, utilisable partout, pour simplifier la vie des DSI et donner plus de liberté dans le choix des environnements cloud, voilà qui est plutôt bien vu.

Une incroyable métamorphose

Au final, cet « AI World 2025 » nous aura livré une vision cohérente de bout en bout de la stratégie d’Oracle : une vision à la fois IA-native au niveau de la base, hyperscale & souveraine côté infra, conversationnelle & métier dans l’analyse, contractualisée à l’échelle du multicloud.

Les DSI en retiendront une volonté marquée de l’éditeur de réduire la gravité des données (Zero-Copy, Zero-ETL) pour accélérer l’IA sans duplication, d’industrialiser la gouvernance et la sécurité in-database de l’IA agentique pour passer du POC à la production sans angle mort, de contractualiser le multicloud pour garder la liberté d’exécution, tout en maîtrisant coûts et responsabilité, d’aligner l’IA sur les métiers avec des agents et des assistants contextualisés.

Reste que l’IA ne deviendra réellement créatrice de valeur que lorsque les organisations sauront réellement et en pratique assembler toutes ces pièces de façon optimale. Ce qui ne se fera pas en un jour.

Au-delà de ces réalités, force est de reconnaître qu’à cet AI World 2025, Oracle a semblé réellement être en passe de réussir son pari et de se révéler un partenaire pertinent des entreprises à l’ère du cloud et de l’IA. Dans un véritable quitte ou double, l’éditeur historique est en train de redéfinir son identité et sa place sur le marché technologique pour la décennie à venir. Oracle se métamorphose de suiveur à leader de cette nouvelle ère de l’IA et du Cloud de l’IA. La vision est convaincante, les investissements sont colossaux, les produits et services semblent parfaitement alignés, mais le chemin vers une exécution rentable reste encore semé d’embûches. Les deux ou trois prochaines années s’annoncent décisives…

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :