Secu

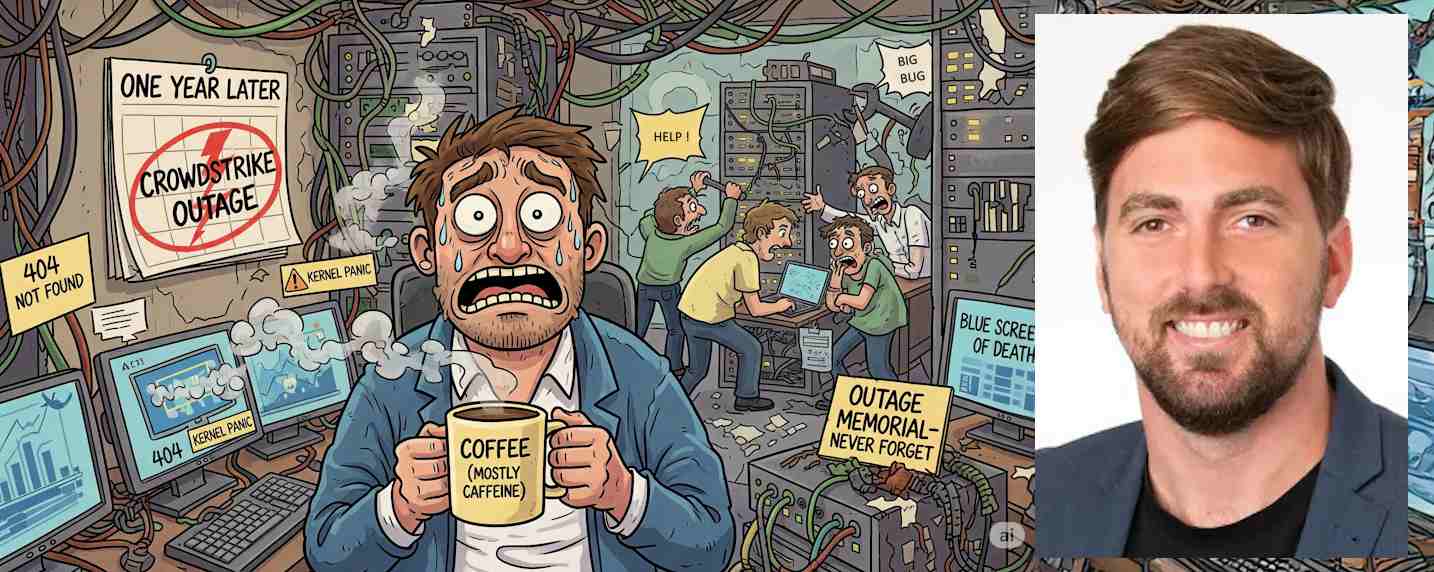

Un an après la panne de CrowdStrike : quelles leçons tirer pour mieux sécuriser nos systèmes ?

Par La rédaction, publié le 29 juillet 2025

Il y a un an, une mise à jour défaillante de CrowdStrike a mis hors ligne des milliers de systèmes critiques dans le monde, provoquant une panne colossale estimée à 5,4 milliards de dollars. Véritable cas d’école, cet incident illustre un dilemme toujours plus pressant : comment concilier l’application des correctifs de sécurité et la continuité opérationnelle ? Pour éviter le chaos, des pratiques solides s’imposent : déploiements progressifs des correctifs sur un périmètre restreint, tests en environnement isolé, gestion rigoureuse des changements pour prévenir les incidents liés à des modifications non maîtrisées ou mal coordonnées, automatisation des retours arrière et enfin contrôle des dépendances tiers. Autant de leviers indispensables pour booster la résilience.

Par Nadir Izrael, CTO et Co-Fondateur d’Armis

Face à la tension entre correctifs de sécurité et continuité d’activité, il serait risqué de voir dans cet incident une raison de suspendre les mises à jour. Au contraire, l’augmentation constante des vulnérabilités et des cybermenaces impose aux organisations de renforcer leur résilience, voire de devenir anti fragiles : capables non seulement d’encaisser les chocs, mais d’en sortir plus fortes grâce à des mécanismes d’adaptation et d’amélioration continue. Car une erreur logicielle n’est réellement dangereuse que lorsqu’elle devient une faille exploitable. Difficile, dans ce contexte, de ne pas imaginer l’attention que cet incident a pu susciter chez certains États ou groupes APT. Une simple mise à jour mal sécurisée peut être détournée en vecteur d’attaque, comme en témoignent la multiplication des compromissions dans les chaînes d’approvisionnement.

Une gestion de crise exemplaire… mais pas sans leçons

CrowdStrike a réagi à cet incident avec une célérité remarquable : le correctif a été déployé en seulement 78 minutes, démontrant une capacité d’intervention agile. Mais la restauration complète a été entravée par des procédures manuelles de redémarrage des machines Windows particulièrement chronophages surtout dans les environnements à grande échelle.

L’analyse des causes racines a mis en évidence un enchaînement d’erreurs de validation logicielle, des tests incomplets qui n’ont pas détecté ces erreurs, et un modèle de déploiement qui a fait tomber tous les clients simultanément. Depuis, l’entreprise a revu ses pratiques et adopté des approches plus robustes, qui peuvent faire figure de modèle : déploiements progressifs, tests “canary” sur un périmètre réduit, renforcement des phases de validation logicielle… Autant de mesures conçues pour détecter les problèmes en amont et éviter qu’ils ne se propagent à grande échelle.

Ces bonnes pratiques doivent aujourd’hui être généralisées. Il est essentiel que les organisations adoptent une approche « shift-left » en matière de développement sécurisé, qui consiste à tester les logiciels dès les phases de développement ou en environnement de test, avant qu’ils n’atteignent la production. En parallèle, un patch management rigoureux s’impose, aussi bien en IT qu’en OT. Même les détails pouvant sembler mineurs comme vérifier la provenance d’un correctif sont en réalité des réflexes indispensables pour protéger les infrastructures critiques.

Des cadres de référence pour structurer la sécurité

De nombreuses bonnes pratiques évoquées ici sont déjà formalisées dans des référentiels comme ISO 27001 et ISA 62443, ce dernier étant plus spécifiquement dédié à la sécurisation des environnements industriels, où la moindre interruption peut avoir des conséquences majeures.

Ces normes proposent des approches concrètes pour limiter les risques liés aux erreurs logicielles : cycle de développement sécurisé (SDLC), gestion des changements, ou encore évaluation des risques liés aux tiers. Même si le SDLC ne s’applique pas partout de manière identique, toutes les entreprises sont aujourd’hui confrontées aux enjeux liés au logiciel. Parmi les pratiques les plus efficaces figurent l’automatisation des tests, la sécurisation des étapes de déploiement et la détection précoce des erreurs, dès les premières phases du cycle de développement. Il est tout aussi important de suivre des processus rigoureux pour la gestion des correctifs : tester chaque mise à jour dans un environnement dédié, valider son bon fonctionnement, et ne la déployer que de manière contrôlée. Il est également recommandé de définir des bases de référence de configurations et de prévoir des mécanismes de restauration automatique en cas de défaillance.

La panne de CrowdStrike a ravivé les inquiétudes autour des risques liés aux fournisseurs, déjà mises en lumière par l’affaire SolarWinds et le décret américain de 2021 sur la cybersécurité. Une fois encore, les référentiels de sécurité insistent sur l’importance d’évaluer en continu les prestataires et de surveiller de près les comportements logiciels inhabituels.

Car la sécurité et la disponibilité ne reposent pas sur un seul acteur : elles sont l’affaire de tous, fournisseurs comme clients. Dans ce contexte, les contrats deviennent un outil clé pour encadrer les responsabilités et limiter les risques. De plus en plus d’organisations exigent désormais de leurs partenaires qu’ils respectent des référentiels de sécurité reconnus, afin de prévenir les vulnérabilités systémiques et renforcer la confiance tout au long de la chaîne.

Cette dynamique a été renforcée en août 2024, lorsque la CISA a publié un guide d’acquisition de logiciels, encourageant les principes du « Secure by Design »,, une approche qui impose davantage de rigueur et de transparence à chaque étape du cycle de vie logiciel — du développement au déploiement, en passant par la gestion des vulnérabilités et les risques liés à la chaîne d’approvisionnement.

Cybersécurité et productivité reposent sur un équilibre délicat, tout comme la répartition des responsabilités entre fournisseurs et clients. Il en va de même pour l’essor de l’IA et de l’automatisation : ces outils offrent de réels gains d’efficacité, à condition d’être encadrés par une supervision humaine avisée. Trouver le bon dosage entre technologie, rigueur opérationnelle et pilotage humain est devenu essentiel car les bénéfices d’une approche équilibrée surpassent largement les risques liés à une gestion hasardeuse. C’est en cultivant cette maturité que les organisations pourront réellement renforcer leur résilience face aux pannes comme aux cyberattaques.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :