Cloud

BUILD 2025 (2/4) : Des usines à agents IA

Par Laurent Delattre, publié le 21 mai 2025

Du catalogue de modèles à la gouvernance de bout en bout, Microsoft a profité de Build 2025 pour assembler toutes les pièces d’une véritable chaîne de production d’agents IA et muscler un peu plus sa stratégie de plateformes IA autour des agents. Voici un tour d’horizon des principales annonces à retenir en matière de plateformes.

Depuis 50 ans, Microsoft permet aux développeurs de transformer leurs idées en réalité grâce à des outils et des plateformes qui accélèrent l’innovation à chaque étape…

C’est ce que Frank X. Shaw CCO de Microsoft a rappelé en marge de la conférence. Et l’éditeur compte bien continuer ainsi dans la nouvelle ère de l’IA agentique qui s’ouvre.

La conférence Build est d’abord une conférence « développeurs ». On y parle donc forcément beaucoup de plateformes, de frameworks, de protocoles, de codes informatiques. Ces fondations sont essentielles pour concrétiser la nouvelle génération d’applications et d’agents IA, les nouvelles « expériences agentiques » dont Microsoft a largement fait état durant sa keynote d’ouverture et que nous avons longuement exploré dans notre première partie du compte rendu de cette édition 2025 de la Microsoft Build : BUILD 2025 (1/4) : L’agentification du travail selon Microsoft.

Dans cette seconde partie, nous allons justement explorer les usines à agents, à modèles et, par voie de conséquences, à données que Microsoft mijote. C’est son cœur de métier, ne l’oublions pas. Un univers de développement qui est tout autant affecté par l’arrivée de l’IA que tous les autres métiers des entreprises. Parfois même plus. Selon Microsoft, il ne faut plus des mois pour construire des solutions. Désormais, « une nouvelle génération d’outils IA permet de transformer les idées en prototypes en quelques heures et de disposer de solutions en production en quelques jours ». De quoi faire sourire bien des DSI, une solution n’étant jamais qu’une question d’outils. Néanmoins, de vraies transformations sont en train de s’opérer et Microsoft veille à les outiller.

Microsoft Azure AI Foundry : le socle agentique d’entreprise

Pour Satya Nadella, tout l’enjeu IA du moment est de « passer des piles technologiques à une véritable plateforme » afin « d’élargir les couches sur lesquelles les développeurs peuvent construire ».

Et cette plateforme porte un nom : Azure AI Foundry.

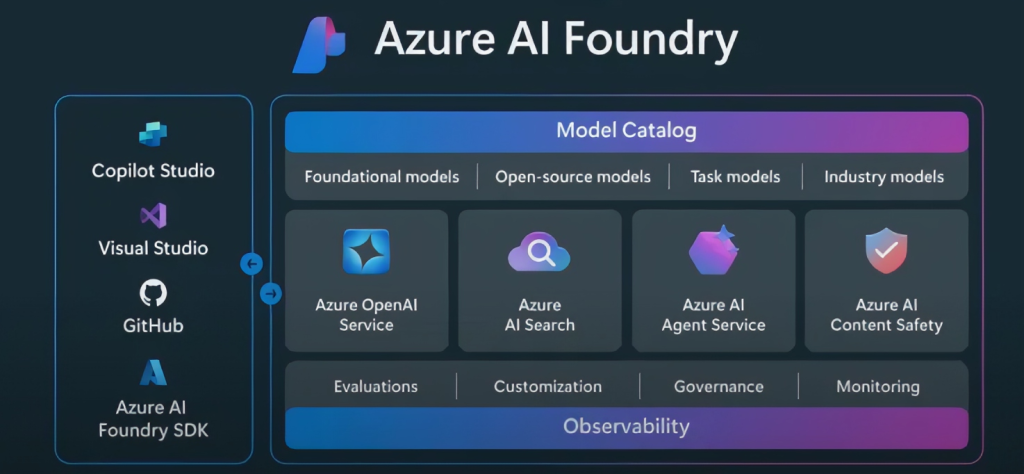

Annoncée à Ignite en Novembre dernier, Azure AI Foundry est bien plus qu’une réponse au très populaire Vertex AI de Google ou au Sagemaker unifié et réinventé d’AWS. Longtemps en préversion et désormais en « GA », Azure AI Foundry a été pensée comme une expérience de développement profondément intégrée aux outils phares de Microsoft, Visual Studio Code, GitHub et Azure, afin d’offrir un environnement fluide et cohérent pour toutes les équipes IT. C’est une plateforme IA « full stack », de la donnée jusqu’aux agents, intégrant sécurité et confiance, et intégrant tout ce dont les entreprises ont besoin « pour construire et exécuter des apps et des agents dopés à l’IA du cloud à l’edge ».

« Ce qui a commencé comme une couche applicative est maintenant devenu une plateforme full-stack pour créer des agents intelligents qui apportent une réelle valeur commerciale » résume ainsi Satya Nadella. Et l’importance pour Microsoft comme pour les entreprises se résument déjà en quelques chiffres parlants : Azure AI Foundry supporte déjà les opérations de plus de 70.000 entreprises clientes, traitent plus de 100.000 milliards de tokens par trimestre, et anime plus de 2 milliards de requêtes IA chaque jour !

Pas surprenant dès lors que l’essentiel des annonces de cette Build 2025 se concentre sur Azure AI Foundry.

1. Un catalogue de modèles qui explose

Azure AI Foundry Models accueille désormais plus de 1 900 modèles – vérifiés, packagés et optimisés par Microsoft – dont Grok 3 et Grok 3 mini, hébergés et facturés par Microsoft avec SLA et confidentialité à la clé. Et Azure devrait aussi l’un des premiers hébergeurs du futur Grok 3.5 annoncé par Elon Musk en vidéo durant la Build 2025. Et encore, ce catalogue de 1900 modèles n’intègre pas les dizaines de milliers de modèles spécialisés proposés via le partenariat avec Hugging Face !

Dit autrement, les DSI, développeurs et équipes IT/IA disposent ainsi, dans un même portail, d’un vivier multi-éditeurs couvrant à la fois les besoins de modèles généralistes et de modèles spécialisés. De quoi accélérer les POC tout en choisissant le meilleur compromis coût/performance. Reste à gouverner la prolifération des modèles (cf. ci-dessous) et établir une grille d’évaluation interne commune avec les métiers.

2. Foundry Agent Service en disponibilité générale

Conçu pour permettre aux développeurs de créer, déployer et faire évoluer facilement leurs agents IA en production, sans avoir à gérer l’infrastructure sous-jacente, le service Foundry Agent Service passe en « GA » avec orchestration multi-agents, runtime unifié Semantic Kernel + AutoGen et stockage de conversations “BYO” dans Cosmos DB.

Ce service marque une évolution majeure : il concrétise le passage d’une univers de chatbots et assistants conversationnels à des écosystèmes d’agents spécialisés, capables de gérer des processus métiers complexes avec peu d’intervention humaine. Il facilite aussi l’intégration de sources de données variées (avec plus de 1400 connecteurs pré-configurés), la gestion de workflows persistants, et le respect des normes de sécurité d’entreprise.

Il assure la coordination de plusieurs agents IA dans un même environnement. Grâce au protocole A2A, officiellement soutenu par Microsoft, ces agents peuvent collaborer, partager du contexte, se répartir des tâches et s’adapter dynamiquement à des scénarios complexes.

L’arrivée de Foundry Agent Service concrétise la fusion de deux technologies clés : « Semantic Kernel » (un framework modulaire pour créer des agents IA avec des fonctions, des mémoires et des plugins) et « AutoGen » (une bibliothèque orientée orchestration dynamique d’agents). Il en résulte un runtime unifié qui combine la robustesse de l’un et la flexibilité de l’autre, exposant une API unique pour définir, exécuter et orchestrer des agents.

Enfin, Foundry Agent Service adopte une approche « BYO » (Bring Your Own) permettant aux développeurs de choisir et configurer leurs propres instances Cosmos DB pour stocker les conversations, les états d’agents ou les historiques d’interactions afin d’offrir un contrôle total sur la persistance des données, la conformité, la sécurité et l’optimisation des performances.

Pour les DSI, Foundry Agent Service s’impose comme la brique qui transforme les POC d’agents en “workforce” numérique et permet de traiter les agents IA comme des applications à part entière (versioning, supervision, coûts de run).

3. Foundry Observability : une nouvelle tour de contrôle pour agents UA

Nouveauté attendue, le service Foundry Observability, actuellement en préversion, ajoute une essentielle couche d’observabilité au cœur de la plateforme IA de Microsoft. Sa console trace performance, coûts, qualité et sécurité sur l’ensemble du pipeline agentique.

Les DSI gagnent ainsi une visibilité continue, condition sine qua non pour leur permettre de mieux négocier leurs budgets cloud mais aussi prouver la conformité aux réglementations (IA Act, ISO 42001, etc.).

4. Model Router et AI Templates : l’automatisation par défaut

Microsoft annonce l’arrivée de deux modules supplémentaires d’industrialisation de l’IA :

– Model Router est un système intelligent intégré à Azure AI Foundry qui sélectionne automatiquement le modèle d’IA le plus adapté à chaque tâche ou requête. Plutôt que de forcer les développeurs à choisir manuellement un modèle parmi des dizaines (comme GPT-4, Mistral, DeepSeek, Meta, xAI, etc.), le Model Router analyse le prompt et oriente dynamiquement la requête vers le modèle optimal. Cela permet d’améliorer la qualité des réponses tout en réduisant les coûts

Les AI Templates sont des modèles de démarrage rapides conçus pour accélérer le développement d’applications et d’agents IA. Microsoft a créé ces templates à partir de plus de 1 000 retours clients, afin de couvrir les cas d’usage les plus courants : chatbots, automatisation de workflows multi-agents, analyse de données, génération de documents, assistance RH, traduction, etc. Chaque template est hautement personnalisable, supporte MCP et s’accompagne d’une architecture de référence, d’un dépôt GitHub prêt à l’emploi, et de guides pour passer rapidement du prototype à la production.

Dit autrement, la chasse au “bon” LLM devient un service managé. Aux équipes IT de définir des garde-fous (latence, coûts maxi) et de superviser l’algorithme de routage.

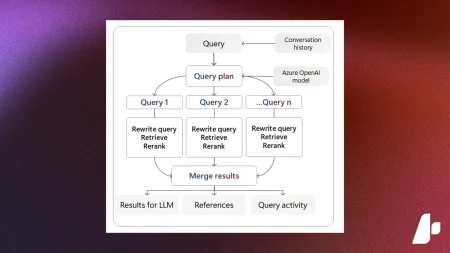

5. Agentic Retrieval Engine dans Azure AI Search

Le RAG, c’est dépassé… et pas forcément bien adapté à l’ère agentique. La recherche agentique dans Azure AI Search révolutionne la manière dont les requêtes complexes sont traitées. Plutôt que de s’appuyer sur une seule recherche, ce moteur intelligent décompose la question de l’utilisateur en sous-requêtes, exécute plusieurs recherches en parallèle, puis compile une réponse complète avec des citations. Cette approche améliore considérablement la pertinence des réponses, avec des tests préliminaires montrant jusqu’à 40 % d’amélioration sur des questions multi-parties.

En pratique, elle doit permettre aux agents IA de se connecter plus efficacement aux données d’entreprise en fournissant des réponses précises et bien fondées.

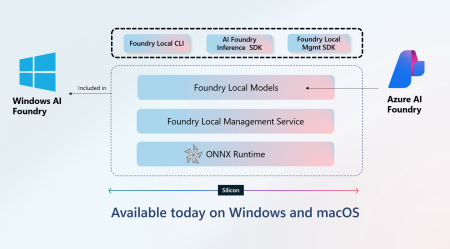

6. Foundry Local et Windows AI Foundry : l’IA passe hors cloud

Parce que toutes les IA n’ont pas vocation à s’exécuter dans le Cloud et que certaines n’ont même pas d’autres alternatives que de s’exécuter à l’Edge, Microsoft annonce un tout nouveau runtime qui dérive directement du runtime « Foundry Agent Service » et conçu pour exécuter des modèles et agents IA directement sur un PC, un Mac ou un serveur local. Cela permet aux applications IA de fonctionner hors ligne, de garder les données sensibles localement et de réduire les coûts de bande passante, idéal pour des cas comme la fabrication industrielle avec une connexion instable ou les services sur le terrain dans des zones éloignées.

La gestion de ce runtime sera également bientôt intégrée à Azure Arc afin d’industrialiser sa gestion et ses mises à jour.

En pratique, Foundry Local apporte inférence et playground sur Windows 11 et macOS via ONNX Runtime.Microsoft a également prévu d’étendre un peu plus la chaîne côté client sous Windows et a annoncé « Windows AI Foundry » sur lequel nous reviendrons plus longuement Vendredi dans la quatrième partie dédiée à la Build 2025.

Pour les DSI, cette nouveauté ouvre de nouveaux scénarios déconnectés ou sensibles.

Vers un Web agentique

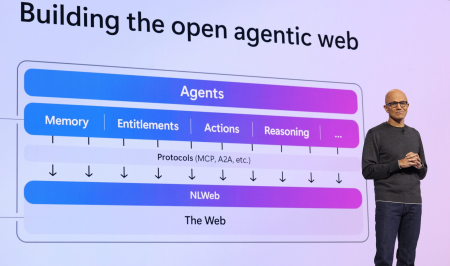

Avant il y avait les programmes… Le Web a introduit l’idée de services… L’IA agentique impose à nouveau de repenser les concepts : les agents IA sont les applications de demain en appuie sur des services spécialement repensés pour eux.

De cette vision émerge l’idée d’un « open agentic Web » où des agents d’IA, plutôt que des navigateurs ou des applis, dialoguent entre eux pour exécuter des tâches complexes à la demande des utilisateurs. Dans cette vision, l’internaute confie une intention (« réserve-moi un hôtel », « mets à jour mon ERP ») et laisse des agents opérer et coopérer en son nom : certains interrogent des bases de données, d’autres déclenchent des paiements ou orchestrent une chaîne logistique.

Satya Nadella en est convaincu, dans cet univers, « les grands gagnants seront ceux qui construiront des agents, pas seulement des plates-formes ».

Le Web agentique est une vision d’un Internet où les agents IA ne se contentent plus de répondre à des requêtes, mais agissent de manière proactive, avec mémoire, raisonnement et autonomie. Elle ne se concrétisera pas sans protocoles et sans standards ouverts.

Pour Satya Nadella, « tout l’écosystème IA est en train de construire cet agentic web, couche après couche ».

Microsoft a ainsi salué et adopté le protocole MCP (Model Context Protocol), standard ouvert créé par Anthropic et déjà soutenu par Google et OpenAI. Kevin Scott, CTO de Microsoft, y voit « l’équivalent d’HTTP pour l’Agentic Web ». Sa simplicité, peu de champs, aucun avis sur la charge utile, doit encourager une adoption horizontale, condition sine qua non pour que les agents « parlent » à tout : sites, API, devices et autres agents.

Le protocole A2A créé par Google et adoubé par Anthropic et par Microsoft vient standardiser les échanges entre agents pour qu’ils se synchronisent dans l’exécution des tâches complexes qu’ils doivent ensemble concrétiser.

7. NLWeb, le HTML du Web agentique

Mais il manque encore à l’Agentic Web une couche supérieur permettant d’uniformiser comment les sites et services Web se rendront « compatibles avec les agents ». En d’autres termes, il manque à ce Web agentique l’équivalent agentique du HTML du Web classique.

Et Microsoft a une petite idée sur la question. Lors de la Build, l’éditeur a ainsi proposé une nouvelle couche applicative standardisée et ouverte répondant au nom de NLWeb.

Conçu par R. V. Guha (RSS, Schema.org), cette nouvelle couche fournit à la fois un micro-serveur qui expose automatiquement le contenu existant (au format Schema.org, RSS, JSONL) sous forme de requêtes en langage naturel et un connecteur MCP natif, afin que le même endpoint puisse répondre aux agents.

Avec NLWeb, quelques lignes de code seulement suffisent pour greffer une interface conversationnelle à un site et, simultanément, pour que des agents puissent l’interroger ou déclencher une action.

Des acteurs comme Tripadvisor ou Shopify ont ainsi participé au projet et pu intégrer NLWeb en moins d’une semaine, preuve de la faible barrière technique du projet.

L’objectif affiché est de rendre MCP et NLWeb (publié en open source) omniprésents, sans verrou propriétaire, afin de reproduire l’effet réseau du Web originel, mais pour la prochaine interface : l’agent IA.

Microsoft place donc une pièce stratégique : si le Web de demain s’articule autour d’agents, Redmond veut fournir le protocole (MCP) et le langage (NLWeb) qui relieront ces intelligences distribuées. Reste aux éditeurs et aux régulateurs à décider si, vingt-cinq ans après HTTP, ils signeront pour ce nouveau protocole social entre machines.

Réimaginer les cycles de développement logiciel

Sans surprise, cette Build 2025 a également confirmé et probablement même pour beaucoup de participants accéléré la mue du développement logiciel. De la conception jusqu’au déploiement, tout change dopé par les capacités d’analyse et de génération des IA.

Tous les outils tendent vers un même objectif : automatiser les tâches répétitives et sécuriser l’industrialisation à l’échelle.

8. GitHub Copilot Coding Agent

Le symbole le plus parlant est l’arrivée du GitHub Copilot Coding Agent, premier agent asynchrone directement hébergé sur la plateforme.

Son annonce s’inscrit dans la mouvance de celle d’OpenAI qui avait annoncé son agent Codex juste avant l’ouverture de la Build 2025.

Ce « Coding Agent » ne se contente plus de générer du code. Il prétend automatiser des tâches de développement logiciel de manière proactive et sécurisée. L’agent peut prendre en charge les tickets GitHub (il suffit d’assigner une issue à Copilot, et l’agent démarre automatiquement son travail), configurer intégralement un environnement de développement (VM, clone du dépôt, configuration sécurisée de l’environnement, analyse de code), effectuer des tâches (comme l’ajout de fonctions, la correction de bugs, la refactorisation, l’extension de tests), exploiter les GitHub Actions, etc.

GitHub Copilot Coding Agent agit comme un collaborateur virtuel qui automatise les tâches répétitives ou fastidieuses, tout en s’intégrant parfaitement dans les workflows DevOps existants. Il est particulièrement utile pour les tâches de complexité faible à moyenne dans des bases de code bien structurées.

Héberger la data pour l’ère agentique

Enfin, terminons cette exploration des annonces Build par un petit tour du côté des bases de données et de la gestion des données. Microsoft avait une multitude d’annonces dont la plupart tournait autour d’une plus forte intégration des SGBD d’Azure au sein d’Azure AI Foundry et Microsoft Fabric (annonce de l’arrivée de Cosmos DB dans Microsoft Fabric, connecteur Databricks pour Azure AI Foundry, capacités PostgreSQL dans GitHub Copilot et VS Code, etc.).

Mais deux annonces ont retenu notre attention…

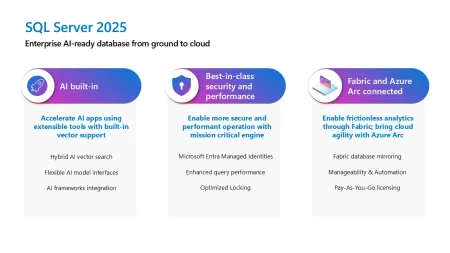

9. SQL Server 2025 se dévoile en Preview

Microsoft a présenté SQL Server 2025 comme la plus importante évolution du moteur depuis une décennie. La version, actuellement en préversion, se veut « AI-ready » : elle embarque un nouveau moteur de recherche sémantique qui complète la recherche plein-texte classique et permet d’interroger ses propres données avec des modèles génératifs, tout en offrant un support JSON et une API REST natives pour simplifier l’exposition de services. Les flux de données peuvent désormais être diffusés en temps réel grâce au Change Event Streaming, et l’intégration à GitHub Copilot promet une génération de code SQL et des suggestions de schéma directement dans les workflows de développement.

Côté plateforme, SQL Server 2025 renforce la sécurité en autorisant l’authentification via des identités gérées Microsoft Entra ID (Arc), améliore la concurrence et la tolérance aux pannes avec de nouvelles optimisations de verrouillage et de bascule, et ouvre la voie à l’analytique temps réel en répliquant les données vers OneLake sans aucun ETL.

Ces capacités s’accompagnent d’un outil remanié : SQL Server Management Studio 21, désormais disponible en version finale. Basé sur Visual Studio 2022 en 64 bits, SSMS 21 propose un éditeur de requêtes modernisé, une meilleure organisation des onglets, l’intégration Git native et un assistant Always Encrypted pour identifier plus rapidement les colonnes à chiffrer. En préversion dans SSMS 21, Copilot fournit enfin des recommandations en temps réel, aide au diagnostic des requêtes et rappelle les bonnes pratiques, accélérant ainsi le cycle de développement SQL .

10. « Chat with your Data »

Microsoft veut aider développeurs, data scientists, analystes et utilisateurs à discuter avec les données de l’entreprise.

Pour cela, Satya Nadella a évoqué une initiative appelée « Chat with your Data » qui se traduit par différentes implémentations.

Typiquement, dans Power BI, une nouvelle expérience Copilot plein écran, accessible depuis le menu de gauche de Fabric, permet de rechercher des rapports, d’interroger plusieurs modèles sémantiques ou data agents et de générer instantanément graphiques, résumés et calculs ad-hoc en langage naturel, bien au-delà du simple rapport ouvert jusqu’ici.

Cette initiative s’appuie techniquement sur les Fabric Data Agents : ces assistants IA comprennent la structure et le contexte des jeux de données stockés dans OneLake, orchestrent la meilleure combinaison de sources et affinent les réponses selon les consignes propres à chaque organisation. Les utilisateurs peuvent les joindre à leurs conversations Teams d’un clic pour enrichir l’analyse. Les développeurs, eux, peuvent intégrer ces mêmes agents dans Copilot Studio afin que leurs chatbots déclenchent des actions (envoi d’e-mails, workflows Power Automate, etc.) ou récupèrent des insights sécurisés sans quitter Teams ou Microsoft 365 Copilot Chat.

L’ensemble est disponible en préversion dès aujourd’hui dans Power BI Service et sera déployé « dans les prochaines semaines » dans Copilot Studio. Microsoft prévoit aussi d’exposer ces capacités directement dans Microsoft 365 Copilot, de façon à poser des questions sur ses données Power BI sans changer d’outil.