Data / IA

Kimi K2 : le modèle ouvert chinois qui bouscule GPT-5 et l’écosystème IA

Par Laurent Delattre, publié le 10 novembre 2025

DeepSeek avait fait trembler Wall Street et la Tech US. Mais, à la manière d’une réplique, un nouveau modèle IA chinois vient secouer la supériorité américaine et rappeler qu’aujourd’hui l’innovation dans les IA ouvertes est aussi vivace et avant-gardiste que celle des IA propriétaires américaines.

Lorsque DeepSeek R1 est apparu en début d’année, l’écosystème IA a vécu un véritable tsunami. Ce modèle chinois démontrait (essentiellement à tous ceux qui ne s’étaient pas intéressés au Français Mistral AI avant) qu’il était possible de rivaliser avec les géants américains en proposant des performances de pointe à un coût d’entraînement bien inférieur. DeepSeek a prouvé à Wall Street que l’intelligence artificielle n’était plus l’apanage des laboratoires fermés de la Silicon Valley. Un « moment » qui a tourné l’attention vers une Tech chinoise sous-estimée et ouvert la voie à une nouvelle génération de modèles ouverts capables de défier les standards établis.

La Chine se rappelle au bon souvenir de tous en cette fin d’année. Comme une piqure de rappel alors que les investissements IA de la Tech américaine atteignent des sommets qui n’ont plus aucun sens, alimentant une bulle boursière très artificielle, une nouvelle startup chinoise fait de nouveau parler d’elle. Fondée en 2023 et soutenue par des investisseurs majeurs, Moonshot AI, tout comme DeepSeek a choisi la transparence et l’efficacité comme armes principales, des armes à la fois géopolitiques et technologiques.

Kimi K2 Thinking, héritier de DeepSeek R1

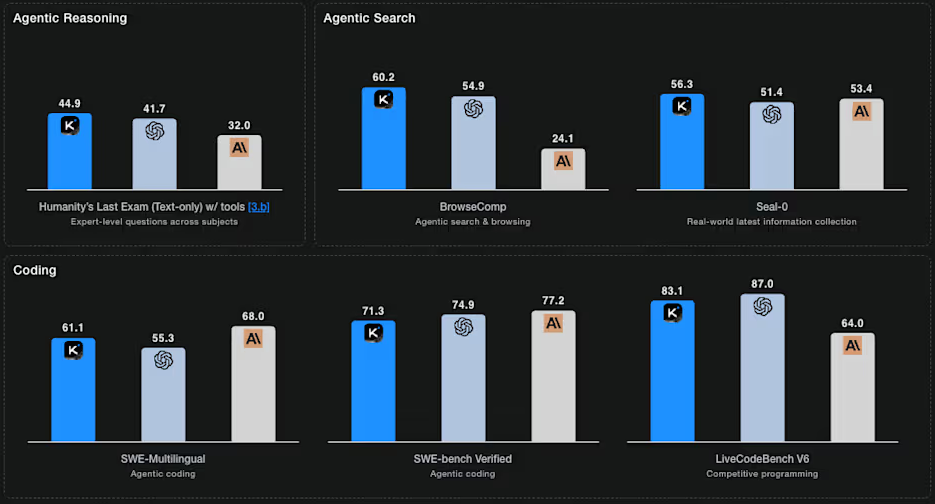

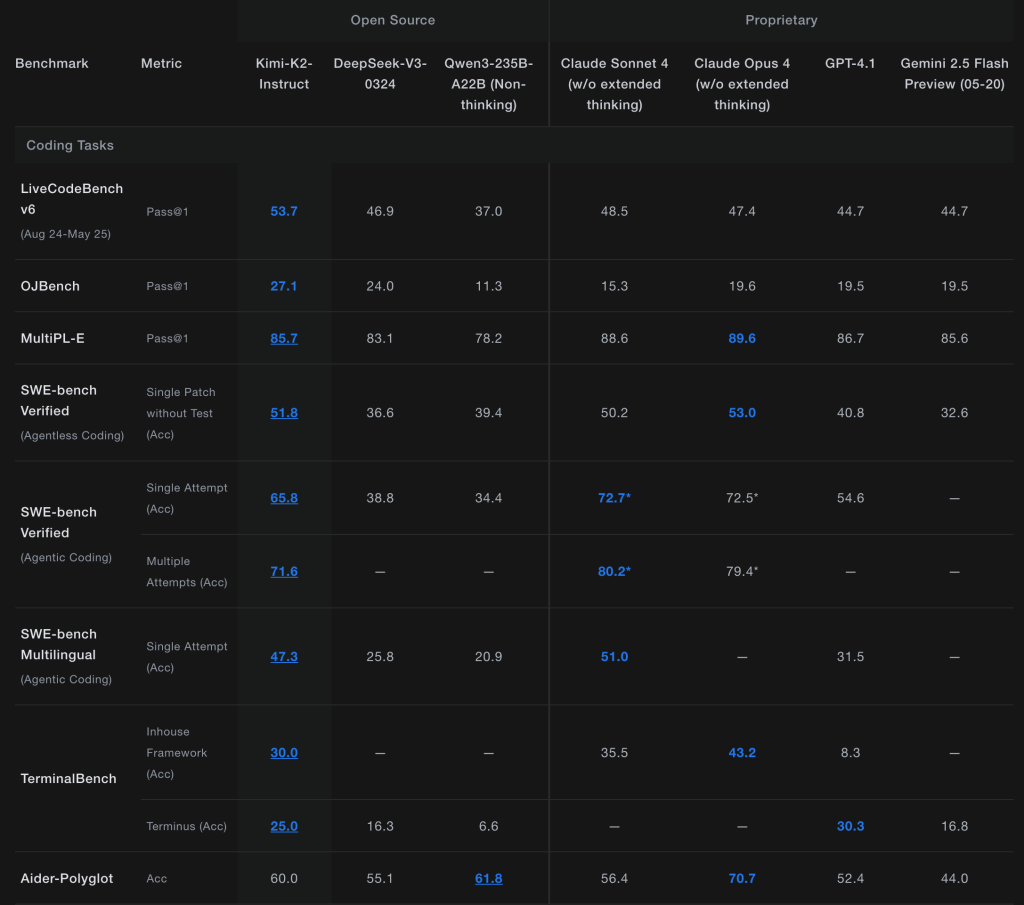

Son nouveau modèle Kimi K2 Thinking fit déjà couler beaucoup d’encre. Ce modèle « open weight » à raisonnement fait de l’ombre à GPT-5 et Claude Sonnet 4.5 les surpassant sur certains benchmarks ! Il atteint 44,9 % sur Humanity’s Last Exam, 60,2 % sur BrowseComp, 71,3 % sur SWE-Bench Verified et 83,1 % sur LiveCodeBench v6. C’est mieux que les meilleurs modèles propriétaires américains.

Pour montrer ses compétences en codage, Moonshot a diffusé une vidéo où Kimi K2 Thinking génère une application complète, un éditeur de documents de style Word, entièrement fonctionnelle à partir d’une seule invite. La société affirme que le modèle donne d’excellents résultats sur HTML, React et d’autres tâches « front-end », transformant les invites en applications réactives et prêtes à l’usage.

Pour démontrer les capacités de raisonnement étape par étape de K2 Thinking, MoonShot illustre dans une démonstration comment son modèle a résolu un problème de mathématiques de niveau doctorat, en effectuant 23 appels de raisonnement et d’outils imbriqués. Il a en toute autonomie recherché la littérature pertinente, effectué des calculs et trouvé la bonne réponse, une façon de montrer que le modèle peut gérer la résolution de problèmes structurés sur une réflexion à long terme.

Construit sur une architecture Mixture-of-Experts d’un trillion de paramètres, le modèle active 32 milliards de paramètres par inférence, ce qui lui permet d’allier puissance et efficacité. Sa fenêtre de contexte atteint 256 000 tokens, et il peut exécuter jusqu’à 300 appels d’outils consécutifs sans intervention humaine.

Surtout, Moonshot a choisi une licence ouverte inspirée du MIT, avec une clause légère d’attribution pour les très grands déploiements (au-delà de 100 millions d’utilisateurs actifs par mois, le logo Kimi K2 doit être affiché en évidence). En clair, pour la majorité des entreprises et chercheurs, Kimi K2 est librement exploitable, y compris dans des projets commerciaux.

Et si l’on en croit les déclarations de Moonshot, à prendre avec des pincettes comme on l’a déjà vu avec DeepSeek, l’entraînement du modèle n’aurait coûté « que » 4,6 millions de dollars là où OpenAI investit des dizaines de milliards par trimestre.

À l’inférence, Moonshot facture le modèle sur sa plateforme API environ 0,60 dollar par million de tokens en entrée et 2,5 dollars par millions de tokens en sortie. C’est 10 fois moins que les tarifs d’OpenAI sur GPT-5.

Bien évidemment, il faudra attendre des retours plus opérationnels. Les benchmarks ne donnent qu’une certaine vision parfois un peu « trafiquée » de la performance réelle d’un modèle. Par ailleurs, les sources et contraintes d’apprentissage appliquées pour aligner le modèle sur les doctrines Chinoises ne rendent pas forcément le modèle très exploitable pour les entreprises européennes à moins d’un « fine-tuning » postérieur soigné.

L’IA open source en pleine accélération

L’arrivée de Kimi K2 démontre néanmoins une nouvelle fois que la Chine sait décidément se montrer ingénieuse en matière de développements de modèles et que l’écart entre modèles IA fermés et modèles IA ouverts continue de s’effondrer. À chaque sortie, les grands modèles frontières propriétaires conservent de moins en moins longtemps leur avance sur les modèles ouverts qui cherchent à les concurrencer.

En outre, et c’est une leçon pour les européens, DeepSeek, Qwen, GLM, Minimax et Moonshot démontrent que l’innovation IA ne dépend plus uniquement de budgets colossaux. De quoi faire de nouveau trembler Wall Street, qui voient peu à peu les modèles ouverts chinois rattraper et pourquoi pas bientôt dépasser les modèles fermés américains à une fraction du coût, et cela à très grande vitesse.

Un dynamisme aux multiples impacts. L’IA n’est plus seulement une course à la puissance brute, mais une bataille pour l’efficacité, l’accessibilité et la transparence. Et l’approche ouverte adoptée par la Chine et par l’Europe contribue – bien plus que les Américains ne veulent l’admettre – à combler les retards technologiques en limitant les investissements. Elle est aussi, pour les DSI, une opportunité stratégique permettant de réduire les coûts, garder la maîtrise des données et éviter une dépendance excessive aux grands fournisseurs américains.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :