Data / IA

GPT-5.2-Codex : le nouveau cœur vibrant des agents d’ingénierie logicielle

Par Laurent Delattre, publié le 22 décembre 2025

Avec GPT-5.2-Codex, OpenAI pousse l’ingénierie logicielle vers des agents capables d’itérer des heures sur un dépôt, de piloter les tests/CI et d’absorber des refactorisations massives. Le modèle met aussi l’accent sur Windows et surtout sur la cybersécurité, un sujet sur lequel l’IA progresse trop vite et impose un déploiement et des accès encadrés.

L’utilisation de l’IA dans le développement ne date pas de ChatGPT. Depuis une décennie, l’intelligence artificielle s’est imposée comme un levier majeur de transformation du développement logiciel. D’abord cantonnée à l’automatisation de tests ou à l’analyse statique de code, elle est progressivement devenue, avec l’arrivée de l’IA générative puis de l’IA agentique, un copilote de conception, capable de générer, corriger et maintenir des bases de code complexes. Et des pas très significatifs ont été faits en 2025 avec l’arrivée de modèles combinant « raisonnement » et « comportement agentique ».

L’IA s’est ainsi imposée en composant structurel de l’ingénierie logicielle dans presque toutes les entreprises. Elle s’est installée dans la chaîne de valeur du logiciel, de la clarification d’un besoin jusqu’à la maintenance corrective, du backlog jusqu’au run : génération de tests, refactoring, migrations, durcissement de configurations, analyse de vulnérabilités, automatisation de PR, analyse de régressions, revue de code, documentation vivante.

Alors, oui, c’est sûr, l’IA s’est simultanément révélée être un levier de productivité, un accélérateur de modernisation, et une nouvelle surface de risque : dépendance à un fournisseur, coût variable, exposition des données, conformité des licences, sécurité du code généré.

Reste que ce basculement massif constaté vers une ingénierie logicielle basée sur l’IA a favorisé l’émergence de modèles « orientés codage ». Les modèles généralistes restent polyvalents, mais les workflows d’ingénierie exigent des compétences très spécifiques : compréhension de dépôts volumineux, respect de conventions locales, navigation entre fichiers, appels d’outils (tests, build, lint, CI), et gestion d’un horizon long où la cohérence compte davantage que la brillance ponctuelle. D’où l’apparition de variantes spécialisées, entraînées et alignées pour des tâches de développement réalistes, avec des mécanismes adaptés (par exemple le fill-in-the-middle, l’agentic coding, ou la compaction de contexte). OpenAI avait ainsi produit un modèle « Code-davinci » dès 2021 avant d’en produire des versions dérivant de GPT-3 puis d’introduire « codex-1 » en 2025 (toute en lançant son environnement agentique Codex) et ses successeurs « GPT-5-Codex » et « GPT-5.1-Codex-Max ».

Toujours en mode « code rouge » suite au lancement de Gemini 3 et au push médiatique et technologique opéré par Google, OpenAI annonce son « GPT‑5.2‑Codex », un mois après le lancement de « GPT-5.1-Codex-Max » et quelques jours après la sortie de « GPT-5.2 Thinking », « GPT-5.2 Pro » et « GPT-Image 1.5 ».

Présenté comme « the most advanced agentic coding model yet » pour l’ingénierie logicielle “real-world”, le modèle se prétend taillé pour travailler sur la durée (des heures voire des jours durant), piloter des outils avec fiabilité, exécuter des commandes et produire des changements significatifs dans un dépôt logiciel.

GPT-5.2-Codex : un GPT-5.2 “optimisé Codex”

OpenAI décrit GPT-5.2-Codex comme une version de GPT-5.2 « bénéficiant d’optimisations spécifiques dédiées au codage agentique au sein de Codex », avec des améliorations ciblées : un travail sur la durée via un compactage des contextes (context compaction, technologie introduite sur GPT-5.1-Codex-Max), une meilleure gestion des gros changements (refactorisation de codes, migrations de projets), des progrès spécifiques en environnements Windows (parce qu’on ne développe pas que sous Linux), et une montée en puissance marquée sur les sujets cybersécurité.

Autrement dit, GPT-5.2-Codex n’est pas là pour mener des conversations universelles mais bien pour assumer l’exécution d’objectifs d’ingénierie dans un environnement de développement outillé.

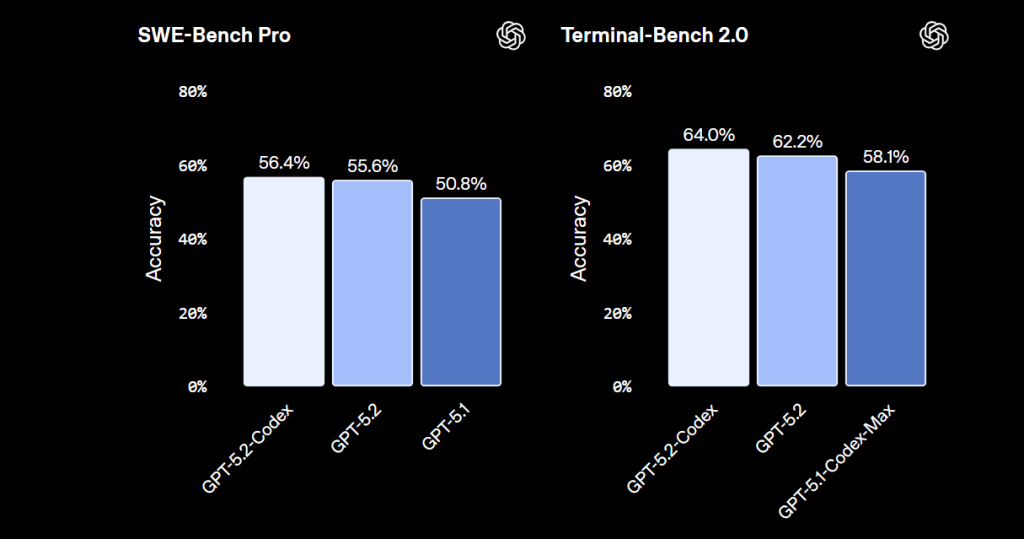

OpenAI revendique d’ailleurs un niveau state-of-the-art sur des benchmarks conçus pour cette réalité (SWE-Bench Pro, Terminal-Bench 2.0), précisément orientés “patch dans un repo” et “tâches en terminal”.

Horizon étendu, Windows, et agentic coding « crédible »

Pour les DSI, les apports les plus structurants sont moins “la génération de code” que la capacité à rester cohérent sur des sessions longues, dans de grands dépôts, en itérant sans perdre les contraintes initiales. OpenAI insiste sur la « native compaction » et la « token-efficiency », deux points directement corrélés à la soutenabilité économique d’un agent de dev sur des travaux longs. Dit autrement, le valeur de ce nouveau modèle émerge notamment sur la modernisation des applications : passer d’un framework à un autre, migrer une API interne, découpler un monolithe, ou faire évoluer une base de tests.

Il est par ailleurs notable de voir qu’OpenAI fait de l’amélioration “native Windows” un axe explicite d’amélioration. Dans de nombreuses organisations, une part significative des environnements de dev, de build, voire d’outillage interne reste centrée sur Windows.

Enfin, GPT-5.2-Codex met en avant de meilleures capacités de vision pour interpréter captures d’écran, schémas techniques, UI, et maquettes, avec la promesse de réduire la friction entre intention (design/mock) et implémentation (prototype puis production).

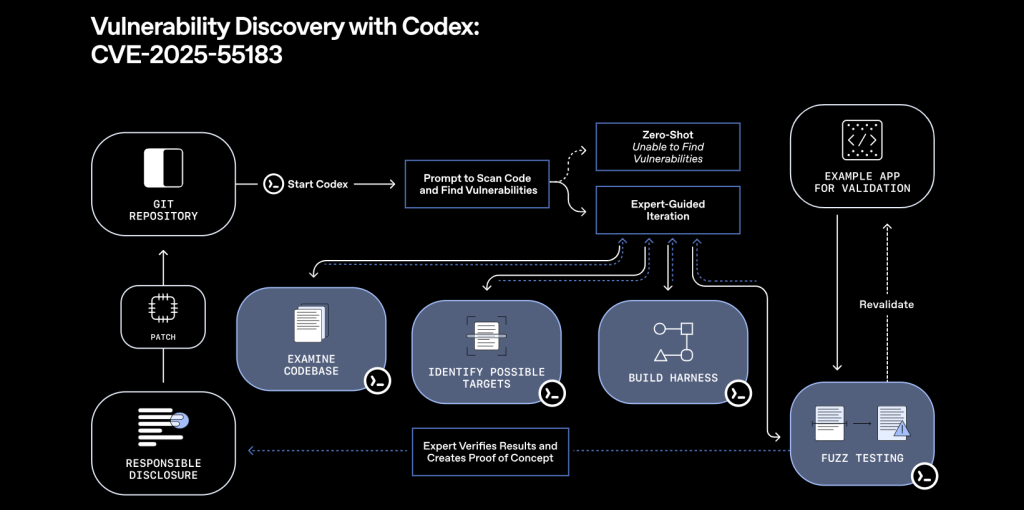

Une cyber-performance à double tranchant

Mais ce nouveau modèle ne sert pas que les scénarios de développement. Il constitue également un progrès notable sur toutes les tâches liées à la cybersécurité défensive.

Les progrès sont d’ailleurs si significatifs, qu’OpenAI a dû prendre des mesures. Même si son nouveau modèle ne franchit pas le niveau “High” de son Preparedness Framework (leur grille interne d’évaluation des risques), l’éditeur précise qu’il « soulève de nouveaux risques à double usage » autrement dit qu’il dispose de capacités utiles pour les développeurs, mais aussi potentiellement exploitables pour des usages malveillants.

Déploiements et résultantes

Conséquence : OpenAI annonce un déploiement progressif, et la mise en place de programmes de « trusted access » pour des acteurs de la cyberdéfense.

OpenAI annonce une disponibilité immédiate pour les utilisateurs payants de ChatGPT utilisant son environnement Codex (que ce soit sur le Web, via Codex CLI ou via l’extension IDE).

En revanche, l’accès à l’API est prévu dans les semaines à venir et sera soumis à conditions.

Pour les organisations qui automatisent leurs développements via des chaînes CI/CD, cette subtilité d’accès est loin d’être anodine. Les intégrations reposant d’abord sur l’API ne vont pas bénéficier immédiatement des nouveaux modèles contrairement aux utilisateurs de Codex.

Dès lors, OpenAI n’a pas encore dévoilé les coûts de son API « GPT-5.2-Codex ». On rappellera néanmoins que GPT-5.2 est affiché à 1,75 $ par million de tokens en entrée et 14 $ par million de tokens en sortie (standard), avec remise sur cache et que « GPT-5.1-Codex-Max » est facturé 1,25 $ par million de tokens en entrée et 10 $ par million de tokens en sortie.

Reste que cette sortie de « GPT-5.2-Codex » alors que l’année 2025 éclaire un peu plus les défis qui s’annoncent en 2026 pour les DSI. La question ne sera plus de savoir si l’IA peut contribuer à l’ingénierie logicielle, mais jusqu’où les organisations accepteront de lui déléguer des pans entiers de leur chaîne de production numérique.

Plus endurants, plus contextuels, plus intégrés aux environnements outillés, les modèles agentiques de nouvelle génération (comme Gemini 3 Flash, Claude Sonnet 4.5, GPT-5.2-Codex ou encore Devstral 2 de Mistral AI) annoncent une bascule où l’IA ne se contente plus d’assister : elle orchestre, coordonne, et garantit la cohérence d’écosystèmes logiciels complexes.

Pour un DSI, cela signifie deux choses. D’abord, la possibilité d’industrialiser enfin des chantiers longtemps considérés comme trop coûteux ou trop risqués : modernisation applicative, réduction de dette technique, sécurisation continue, harmonisation des pratiques.

Ensuite, la nécessité d’assumer un rôle plus stratégique dans la gouvernance de ces agents : choix des modèles, maîtrise des coûts, contrôle des risques, intégration dans les chaînes CI/CD, et définition d’un cadre d’usage responsable.

À LIRE AUSSI :

À LIRE AUSSI :