Data / IA

L’IA ne peut pas s’autofinancer : le rapport Bain révèle l’équation impossible de la révolution IA

Par Laurent Delattre, publié le 25 septembre 2025

Le sixième rapport technologique de Bain & Company dresse un constat vertigineux : au rythme actuel, l’IA ne peut mathématiquement pas s’autofinancer. Entre mur énergétique, fragmentation géopolitique et cannibalisation du SaaS par l’IA agentique, le rapport expose sans complaisance les défis colossaux qui attendent les DSI. Avec en fond un avertissement brutal : dans cette course où les besoins dépassent structurellement les moyens, seuls les plus agiles survivront.

L’Union européenne a dégainé une enveloppe de 200 milliards d’euros pour son initiative InvestAI, dont 20 milliards dédiés à la création d’« AI gigafactories », ces grands datacenters IA dotés d’au moins 100 000 GPU chacun. En soit, ces chiffres peuvent impressionner. Et pourtant, ils illustrent non seulement l’écart de capacité d’investissement qui séparent les USA et l’Europe mais aussi la difficulté pour l’Europe de saisir à leur juste mesure les défis de l’ère de l’IA.

Le 6ème et volumineux rapport annuel sur la technologie mondiale de Bain & Company éclaire sur 75 pages cette dure réalité et chiffre la course effrénée vers la domination de l’IA agentique à laquelle chacun doit aujourd’hui prendre part. « À mi-décennie, l’IA est la grande force de rupture de notre époque… Si vous en êtes encore à piloter, vous êtes dangereusement en retard », préviennent les rapporteurs dès l’introduction du rapport. Le message est limpide : l’ère des PoC sans passage à l’échelle est close. L’IA agentique pousse les entreprises à passer de l’expérimentation à une transformation profonde de leurs opérations et de leur architecture informatique.

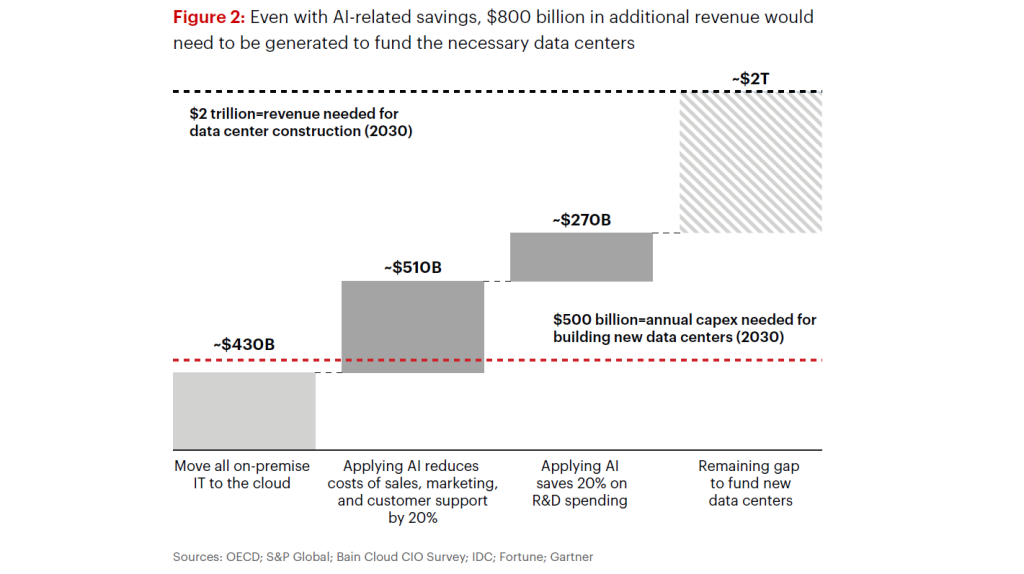

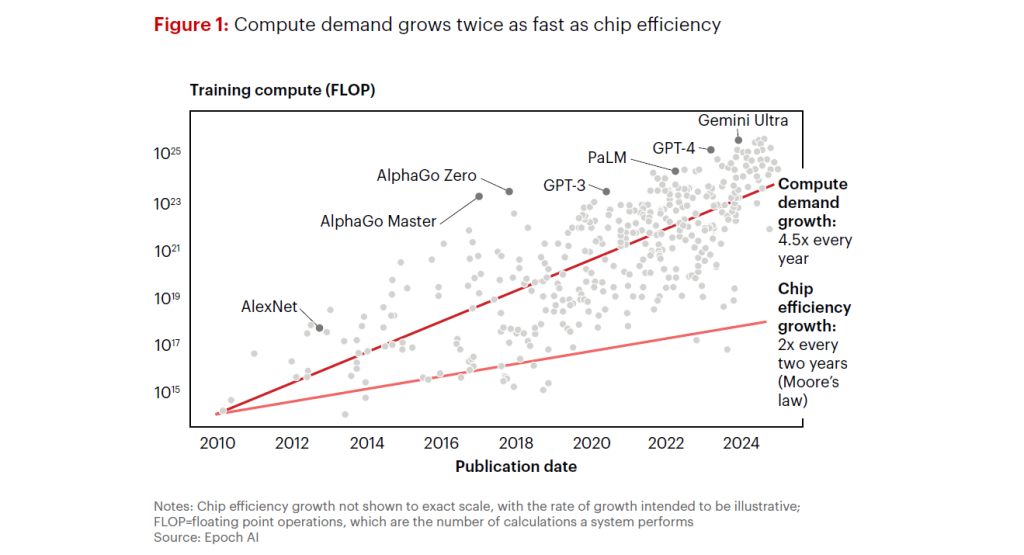

Le rapport pose d’emblée l’ampleur du défi qui attend les européens et le monde : la demande de calcul de l’IA croît à un rythme plus de deux fois supérieur à celui de la loi de Moore. Pour répondre à cette demande anticipée d’ici 2030, il faudrait générer deux mille milliards de dollars de revenus annuels supplémentaires afin de financer la puissance de calcul nécessaire.

Parallèlement, le rapport démontre que même en réinvestissant TOUTES les économies générées par l’IA (IT, ventes, R&D), il manquerait encore 800 milliards de dollars pour financer l’infrastructure nécessaire et suivre le rythme actuel !

C’est là un paradoxe rarement exposé : au rythme actuel, l’IA ne peut pas s’autofinancer à l’échelle requise ! Un phénomène que certains confondent, peut-être à tort (qui sait ?) avec la fameuse « bulle Internet » des années 2000 mais qui s’en démarque à la fois par la nature des investissements et au niveau déjà très élevé d’intégration de l’IA dans nos processus et usages. Ce qui ne met pas pour autant l’IA à l’abri d’une crise.

David Crawford, président de la pratique technologique mondiale de Bain, prévient que « si les lois d’échelle actuelles se maintiennent, l’IA exercera une pression croissante sur les chaînes d’approvisionnement mondiales ». Il ajoute que « les dirigeants technologiques seront confrontés au défi de déployer environ 500 milliards de dollars en dépenses d’investissement et de trouver environ 2 000 milliards de dollars de nouveaux revenus pour répondre à la demande de manière rentable ».

Les leaders creusent l’écart, mais la fenêtre de tir existe en Europe

Bain observe une hyper-concentration de valeur au sommet : les cinq plus grandes entreprises techno pèsent plus de 70 % de la capitalisation des 20 premières, Nvidia ayant bondi de +800 % depuis janvier 2023. Dans leur sillage, une nouvelle garde émerge, de OpenAI (~300 Md$) à Anthropic (>60 Md$), et l’européen Mistral figure parmi les acteurs modèles les plus valorisés. L’offre foisonnante mais la dépendance aux fournisseurs d’infrastructure s’en trouve accrue. D’où l’importance de soutenir les efforts pour davantage d’IA en open source.

La bonne nouvelle pour la France et l’Europe, c’est que tout espoir d’exister n’est pas perdu. Bien plus qu’un enjeu règlementaire, la dynamique « souveraine » européenne devient un moteur industriel à part entière. L’UE investit massivement dans des capacités locales d’IA, des centres de données géants (les IA gigafactories) et des infrastructures conformes à ses normes, afin de réduire la dépendance et permettre des usages sensibles sans contrainte juridique étrangère. L’écosystème européen s’organise avec le rapprochement d’ASML et Mistral AI ou l’alliance de Deutsche Telekom à Nvidia pour bâtir un cloud industriel d’IA.

En parallèle, États‑Unis et Chine verrouillent leurs chaînes technologiques : Washington durcit les contrôles à l’export vers Pékin et pousse la régionalisation, tandis que Pékin accélère la substitution domestique avec plus de 250 Md$ investis depuis 2019, une capacité portée à 3 millions de tranches par mois et des alternatives locales aux modèles (DeepSeek, Tencent, Alibaba) et accélérateurs IA (Huawei Ascend). Cette rivalité rend tangible la fragmentation des lieux où l’on entraîne et exécute l’IA, chaque bloc imposant ses propres standards politiques, culturels et techniques.

Dans ce contexte, Bain est explicite : les systèmes d’IA deviennent des « produits nationaux ou régionaux », façonnés par des normes politiques et culturelles différentes, et il est peu probable que des standards globaux émergent à court terme.

Opérationnellement, pour les entreprises internationales, cela va exiger des architectures capables de fonctionner en multi‑régions, multi‑modèles et multi‑clouds :

* héberger entraînement et inférence là où l’exigent les réglementations, répliquer pipelines et MLOps sur chaque zone pour éviter les transferts sensibles ;

* orchestrer, selon les contraintes locales, des modèles différents – ouverts ou propriétaires – éventuellement ré‑entraînés avec des corpus nationaux ;

* maintenir une flexibilité multi‑cloud pour sécuriser l’accès aux GPU, optimiser les coûts et rester conforme.

Bain souligne que dans un tel contexte l’interopérabilité et l’optionnalité seront clés pour absorber l’incertitude et la diversité des règles. Dans un monde où l’IA se façonne par blocs politiques et culturels distincts, la résilience passe par des systèmes localisables par conception, aptes à absorber la diversité des règles sans réécrire l’entreprise à chaque frontière.

Finalement, comme pour le Cloud, l’UE doit investir pour « niveler le terrain » et réduire la dépendance infrastructurelle, tandis que la rivalité sino-américaine rend la résilience indispensable. « La technologie se trouve à la ligne de faille », écrivent les auteurs. Dès lors, les DSI gagnants sont ceux qui bâtissent des systèmes localisables par conception, capables d’absorber la divergence des règles sans réécrire l’entreprise à chaque frontière.

Les DSI doivent passer à l’action en production

Justement… Le rapport ne fait pas dans la demi-mesure et rappelle aux DSI que l’attentisme n’est plus une option. Pour Bain, un fossé s’est déjà creusé entre les précurseurs qui engrangent déjà des bénéfices substantiels et les suiveurs, qui prennent un retard potentiellement fatal. Face à cette lame de fond, les entreprises les plus avancées, qui ont déjà dépassé le stade des projets pilotes pour tirer profit de l’IA, enregistrent des gains de 10 % à 25 % sur l’EBITDA en intégrant la technologie dans leurs principaux flux de travail. Le rapport note une augmentation de 30% des taux de conversion possibles dans les ventes grâce à l’IA. Et Bain a aussi calculé en étudiant les précurseurs que puisque les vendeurs ne passent que 25% de leur temps à vendre, l’IA permet de doubler ce temps.

Mais le rapport alerte aussi les DSI sur le piège de la « microproductivité ». Contrairement à l’enthousiasme général pour tout gain de productivité, le rapport critique les gains de « grab-a-coffee » (le temps de prendre un café). Selon Bain, ces petits gains de 10-15% ne créent pas de valeur réelle s’ils ne sont pas réinvestis stratégiquement. La plupart des entreprises célèbrent ces gains alors qu’ils ne bougent pas l’aiguille financièrement.

L’ère agentique transforme le monde et menace le SaaS

Il est d’autant plus essentiel de ne pas prendre de retard que l’innovation s’accélère avec l’émergence de l’IA agentique. Selon Bain, elle représente un changement structurel pour l’entreprise, bien au-delà d’une simple vague d’automatisation. Contrairement aux outils précédents qui optimisaient des tâches, les agents d’IA peuvent raisonner, coordonner et exécuter de manière autonome des processus complexes et non déterministes qui dépendaient jusqu’alors de l’intervention humaine. Cela va transformer bien des processus et promet de nouveaux gains de productivité.

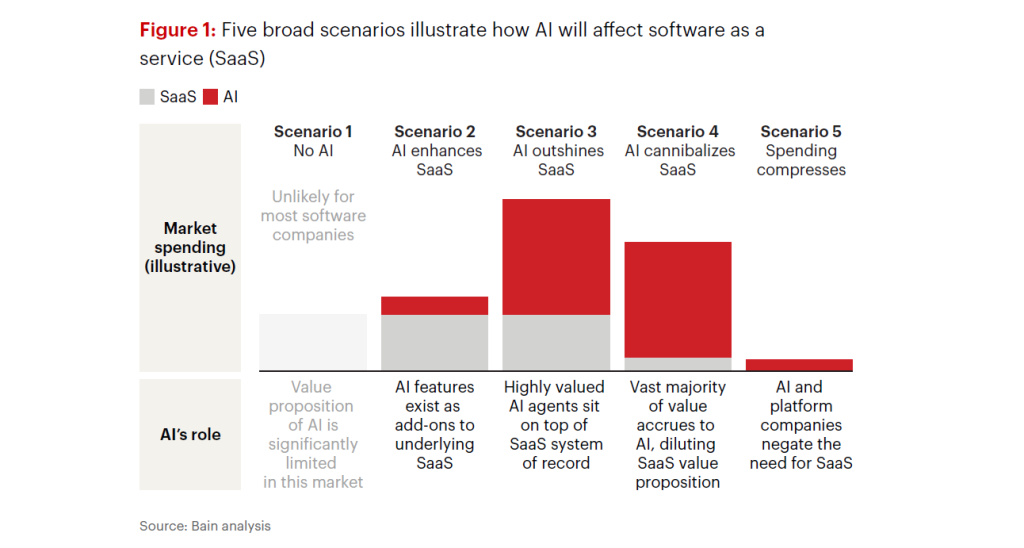

Et selon Bain, cette IA agentique va condamner en partie le SaaS. Alors que la plupart voient l’IA comme un complément au SaaS, le rapport identifie des scénarios où l’IA élimine complètement le besoin de certains logiciels. Les entreprises SaaS vont devoir activement « s’auto-disrupter » pour survivre. Certaines briques SaaS — support L1, rapprochements, contrôles de temps — sont hautement automatisables et donc exposées à la cannibalisation. Les éditeurs qui tiendront la corde seront ceux qui possèdent la donnée de référence, imposent le vocabulaire sémantique de leur secteur et basculent la tarification du siège vers l’issue (outcome-based).

Et ceci porte deux conséquences essentielles pour les DSI :

D’abord, Bain les invite à acheter des résultats, pas des licences, et à exiger la preuve d’impact dans les contrats. « La disruption est obligatoire ; l’obsolescence, optionnelle », résument les rapporteurs.

Ensuite, Bain les alerte sur l’indispensable transformation profonde de leurs infrastructures qui va en découler. « La plupart des architectures d’entreprise ne sont pas prêtes à gérer des milliers d’agents » constatent les rapporteurs. Il devient crucial de moderniser les plateformes fondamentales pour les rendre accessibles via des API en temps réel, d’assurer l’interopérabilité entre les agents, et de mettre en place une gouvernance et une sécurité capables de gérer des systèmes autonomes à grande échelle. Le succès dépendra de la capacité à distribuer la responsabilité de la création et de la surveillance des agents aux domaines métiers, tout en assurant une gouvernance et une sécurité centralisées.

Au passage, le rapport rejette les visions utopiques d’architectures IA parfaitement intégrées. Le rapport établit même un parallèle plutôt provocateur en associant les visions actuelles d’architectures IA interconnectées à celles promises par le Web 3.0 : « une vision logique de comment les choses devraient fonctionner si personne n’était cupide et si la gouvernance et la responsabilité n’étaient pas des questions épineuses« . Contrairement aux espoirs d’interopérabilité universelle, le rapport prédit que les jardins clos vont continuer de dominer le paysage. Les solutions sur mesure, adaptées spécifiquement aux besoins, prévaudront sur les architectures d’entreprise standardisées. Les constructions spécifiques à chaque domaine deviendront la norme, et les applications nécessitant une supervision humaine resteront la réalité pragmatique pour les années à venir. Pour Bain, le pragmatisme primera toujours sur la pureté architecturale.

Pour autant, les aspects les plus critiques de cette transformation ne sont pas purement technologiques. Le rapport révèle que « les aspects les plus importants de la transformation sont la refonte des processus et le nettoyage de l’environnement des données et des applications ». Il est donc inutile d’attendre que la technologie se stabilise pour agir. Chaque jour d’attente ne fait qu’accumuler de la dette technique et creuser l’écart.

Anticiper les bouleversements à venir

Au-delà de l’IA agentique, le rapport de Bain & Company met en lumière plusieurs bouleversements technologiques que les entreprises doivent anticiper, en commençant par le défi colossal de la puissance de calcul.

La demande de calcul pour l’IA croit au rythme vertigineux de x4,5 par an ! Le rapport chiffre ainsi la hausse des besoins de calcul : la demande mondiale pourrait atteindre 200 GW d’ici 2030, dont 100 GW rien qu’aux États-Unis. Il faudra plusieurs dizaines de centrales nucléaires supplémentaires pour la satisfaire.

Cette course à la puissance se heurte à des obstacles économiques et infrastructurels majeurs, notamment la difficulté de construire suffisamment de centres de données et d’alimenter des réseaux électriques déjà sous tension. Et Bain de rappeler que l’infrastructure électrique, hautement régulée, nécessite quatre ans minimum pour être mise en ligne, créant un goulot d’étranglement physique insurmontable à court terme.

Pour Bain, les DSI européens ne doivent pas négliger les risques opérationnels induits par la latence d’accès à des GPU et la capacité énergétique réellement disponible. Ils sont à planifier au même titre que la cybersécurité.

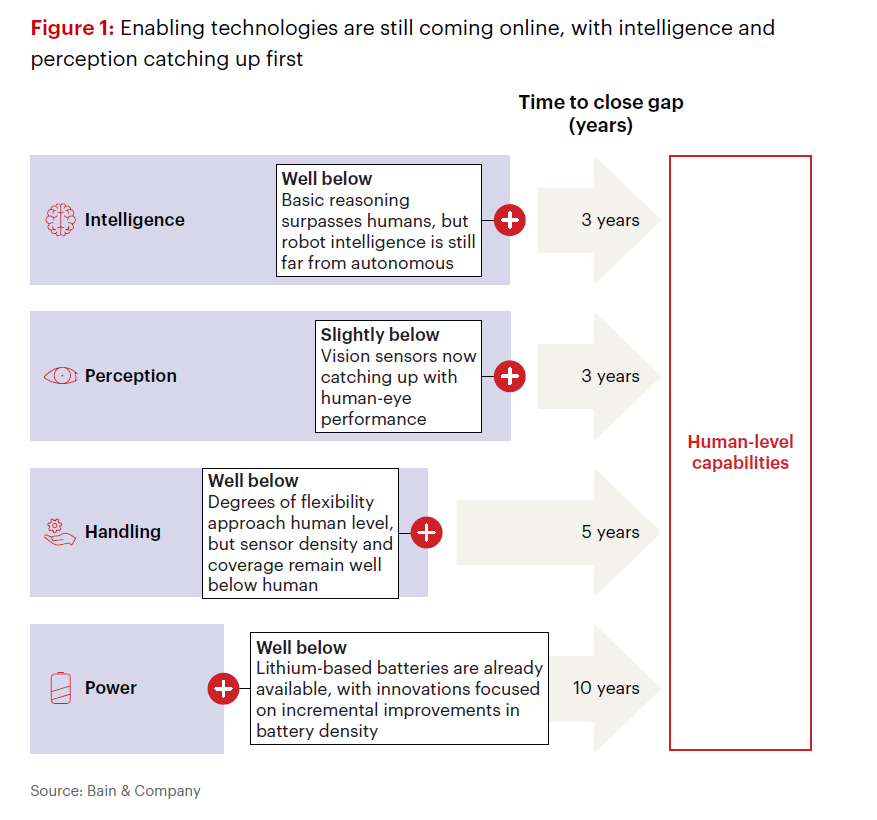

Parallèlement, si les robots humanoïdes suscitent l’enthousiasme, Bain tempère les attentes en soulignant les freins importants à leur déploiement à grande échelle : la plupart des systèmes en sont encore au stade de pilote, souffrent d’un « déficit d’autonomie » qui les rend dépendants de la supervision humaine, et leurs capacités de manipulation fine ainsi que, surtout, leur autonomie énergétique restent très inférieures aux standards humains. Une journée de travail complète de huit heures sans recharge pourrait ne pas être disponible avant une bonne décennie.

La robotique humanoïde n’est pas pour tout de suite. Certes, l’IA et la perception visuelle sont en rapide progression. Mais la manipulation, bien qu’ayant gagné en flexibilité, reste freinée par une couverture sensorielle limitée et devrait nécessiter cinq années supplémentaires. Mais le principal verrou demeure l’alimentation : malgré les avancées des batteries lithium, les gains restent incrémentaux et l’autonomie robotique n’atteindra pas le niveau humain avant une décennie.

Enfin, l’informatique quantique n’est pas plus épargnée. Présentée comme la prochaine frontière avec un potentiel de marché de 250 milliards de dollars, elle fait face à des obstacles fondamentaux que Bain détaille sans complaisance. Plus de 60% de cette valeur projetée repose sur le machine learning quantique, que le rapport qualifie de « mostly theoretical » sans percées algorithmiques majeures en vue. Les barrières techniques restent monumentales : problèmes de fidélité et correction d’erreurs, temps de cohérence limités, absence de mémoire quantique fiable, difficultés de chargement des données classiques, et goulots d’étranglement dans le contrôle des qubits. Bain estime qu’il faudra au minimum 10 à 15 ans avant que les ordinateurs quantiques ne puissent remplacer les charges de travail d’IA générative. Le marché actuel, inférieur à 1 milliard de dollars annuel, pourrait atteindre seulement 5 à 15 milliards d’ici 2035 – loin des promesses initiales. Paradoxalement, alors que 73% des professionnels IT reconnaissent la menace quantique pour la cybersécurité, seulement 9% ont développé une feuille de route pour la cryptographie post-quantique, créant une vulnérabilité systémique face aux stratégies de « harvest now, decrypt later » déjà en cours.

Au final, ce vertigineux et peu complaisant (ça change) tableau dessiné par Bain & Company, rappelle aux DSI qu’ils se trouvent à un carrefour historique où l’inaction devient plus risquée que l’action imparfaite. Il faut construire en marchant, miser sur la vitesse plutôt que sur la pureté, et transformer l’organisation pendant que les standards se figent. Trois chantiers s’imposent dès maintenant : moderniser les plateformes core en anticipant l’arrivée des agents, sécuriser des partenariats énergétiques avant la pénurie, et préparer les équipes à piloter des systèmes qu’elles ne contrôleront plus totalement.

Les DSI doivent accepter leur nouveau rôle : orchestrer des écosystèmes hybrides (jardins clos, solutions sur-mesure, agents semi-autonomes) dans un monde fragmenté qui impose le multi-régional par défaut. Le défi sera de maintenir une cohérence stratégique tout en embrassant le chaos tactique, d’investir sans garantie, de standardiser tout en personnalisant, d’automatiser sans exclure l’humain.

Avec un message reçu fort et clair : si l’IA ne peut pas s’autofinancer, elle peut encore moins se permettre d’attendre ceux qui hésitent.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :