Newtech

Ce sont bien des GPU NVidia qui animeront le booster du JUPITER

Par Laurent Delattre, publié le 14 novembre 2023

C’est la future star de l’IA et des prochains HPC. Le nouveau GPU H200 de NVidia devrait encore assoir un peu plus la main mise du fabricant sur les Workloads IA et son succès en bourse… Et faire les beaux jours de la première machine exaflopique européenne…

Avec une capitalisation boursière proche de 1.200 milliards de dollars et un Chiffre d’Affaires annuel proche des 25 milliards de dollars (qui a doublé en 2022 avec les besoins GPU pour les IA), Nvidia s’impose comme le fabricant de puces vedette du marché et le leader incontesté des fournisseurs d’accélérateurs d’IA. En témoigne son omniprésence dans tous les derniers HPC apparus dans le TOP500, le classement des supercalculateurs. Il parait désormais loin le temps où la marque était plus connue des gamers que des administrateurs de datacenters. Et l’engouement pour l’IA générative – qui a propulsé la demande pour ses GPU – a largement contribué à la hausse fulgurante de son action de plus de 230% depuis début 2023.

Un GPU taillé pour l’IA générative

Cette semaine, NVidia a lancé son « H200 », successeur du très populaire « H100 » et déjà considéré comme la star des accélérateurs de workloads IA. Très attendu par les acteurs de l’IA générative en quête d’un nouveau bond de puissance pour entraîner leurs futurs LLMs et générateurs d’images et de vidéos, le « H200 » confirme l’engagement de NVidia dans la course à l’innovation en IA et sa volonté de rester au sommet d’un univers qui par ailleurs aspire à des alternatives alors que l’approvisionnement en GPU reste toujours plus que tendu (cf Microsoft qui a signé un accord avec Oracle pour permettre à l’IA Bing d’exploiter les GPU d’OCI).

Le « H200 » reste un GPU même si le « G » (pour Graphic) n’est ici qu’accessoire. Les GPU sont prisés pour les traitements IA en raison de leur bande passante mémoire exceptionnelle qui booste l’analyse des données et leur capacité à effectuer un grand nombre de calculs matriciels en parallèle, nécessaires au fonctionnement des réseaux neuronaux. Ils se montrent les plus adaptés aux travaux d’apprentissage mais s’avèrent aussi souvent plus puissants que les NPU du marché dans les inférences. Preuve en est les explications des responsables d’OpenAI et de Bing IA qui affirment depuis des mois que les temps de réponse de ChatGPT et Bing Chat ne peuvent être accélérés par manque de disponibilité de GPU sur le marché.

À LIRE AUSSI :

Grâce à sa mémoire HBM3e embarquée de 141 Go, le H200 offre une bande passante de 4,8 To par seconde. La bande passante est multipliée par 1,4 fois et la capacité par 1,8 fois par rapport à la première génération de puce Hover (les H100). Les performances sont multipliées par 2,5 fois par rapport aux A100. Chaque GPU H200 délivre 4 Pétaflops (en 8 bits) sur les traitements d’apprentissage Tensor Flow. Il délivre 34 TFlops en calculs HPC sur 64 bits. Sur l’inférence de GPT-3 (en 175 milliards de paramètres), le H200 se montre 1,6 fois plus performant que le H100. Sur l’inférence LLama 2 (le LLM open source de Meta de 70 milliards de paramètres), le H200 se révèle 2 fois plus performant que le H100.

Le H200 sera disponible sous forme de GPU à intégrer dans les serveurs, sous forme de cartes GPU pour serveurs NVidia GHX H200 combinant de 4 à 8 GPU mais aussi en déclinaison « Superchip GH200 » combinant une partie CPU (dénommée Grace en architecture ARM) et une partie GPU (H200).

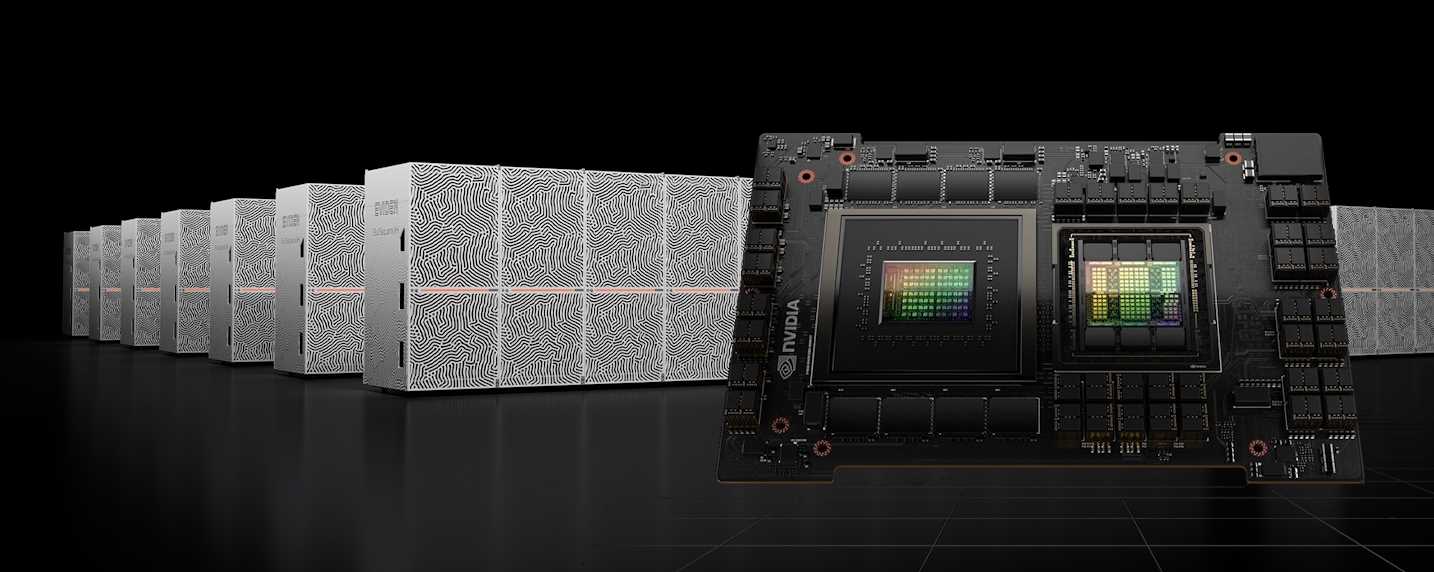

Au cœur du booster module du JUPITER

Justement c’est ce « Superchip GH200 » que l’on retrouvera également sur le JUPITER. Le consortium EuroHPC avait annoncé en octobre dernier que son premier ordinateur exaflopique, le JUPITER, hébergé au centre de calcul JSC de Jülich en Allemagne serait construit par Eviden (ex ATOS) de façon bicéphale avec un cluster général animé par des processeurs Rhéa-1 de l’européen SiPearl et un « Booster Module » dont la conception n’avait pas encore été dévoilée. On sait désormais que ce Booster Module ne sera pas doté de CPU SiPearl contrairement au « General Cluster ».

Cette semaine, NVidia a bien confirmé être le fournisseur des composants de ce Booster Module. Ce cluster – qui devrait principalement être utilisé pour des workloads IA et certaines simulations – sera équipé d’environ 24.000 « Superchips » NVidia GH200 – combinant CPU et GPU -, interconnectés par un réseau NVidia Quantum-2 Infiniband. Chaque nœud de ce cluster « booster » embarquera 4 ‘superchips’ GH200, autrement dit offrira 288 cœurs ARM Neoverse (chaque CPU Grace embarque 72 cœurs) et 4 GPU H200.

À LIRE AUSSI :

Ne pas s’endormir sur ses lauriers

À l’occasion de la conférence Future of Business du Harvard Business Review, le CEO de NVidia, Jensen Huang, a surpris l’auditoire en affirmant « nous n’avons pas à prétendre que notre entreprise est toujours en danger. En fait elle est réellement toujours en danger et nous le ressentons à chaque instant ».

Cela peut surprendre pour une entreprise dont l’action en bourse ne cesse de flamber. Mais pour Jensen Huang « aucune compagnie n’est assurée de survivre. Ne pas se penser en danger, c’est enfouir sa tête dans le sable ». Une remarque qui fait étrangement écho au livre d’Andy Grove, ex CEO d’Intel : « Only the paranoid survive » (seuls les paranoïaques survivent).

Dans les faits, si NVidia a manqué de concurrence sur les GPU serveurs jusqu’ici, la situation ne saurait durer. AMD, Amazon, Google, Microsoft… tous développent de nouveaux accélérateurs pour l’IA. Avec, en ce qui concerne les hyperscalers, une volonté claire de faire baisser les coûts des infrastructures IA en se débarrassant des GPU NVidia. Il ne sera cependant probablement pas si simple de se passer de NVidia dans les années à venir alors que des modèles comme Gemini de Google/DeepMind ou GPT-5 d’OpenAI préfigurent l’arrivée des fameuses et redoutées AGI (Artificial General Intelligence) et vont nécessiter des ressources encore plus colossales pour leur apprentissage et leur inférence. Sam Altman n’a pas caché, dans une interview au Financial Times cette semaine, déjà anticiper de réclamer encore plus d’argent à Microsoft (qui a investi 10 milliards de dollars dans OpenAI) pour pouvoir donner naissance à GPT-5 et ses successeurs…

À LIRE AUSSI :

À LIRE AUSSI :