Data / IA

GTC 2025 d’Automne : Nvidia fait de l’Amérique le cœur battant de l’IA

Par Laurent Delattre, publié le 31 octobre 2025

De la recherche scientifique aux datacenters, Nvidia orchestre l’intégration totale de l’IA dans l’économie américaine. En reliant GPU, cloud, quantique et télécoms, Jensen Huang a érigé à l’occasion de sa GTC 2025 d’automne une colonne vertébrale technologique mondiale de l’IA sous bannière américaine. Retour sur les principales annonces d’un show made in USA…

La conférence GTC, acronyme de GPU Technology Conference (GTC), est la grand-messe biannuelle de Nvidia, où développeurs, chercheurs, industriels et décideurs politiques viennent écouter Jensen Huang tracer les contours de l’avenir numérique.

L’édition d’automne 2025 se tenait cette semaine à Washington, à quelque pas de la Maison-Blanche, comme un symbole d’un dialogue direct avec le pouvoir américain, alors que, pendant ce temps, Donald Trump allait discuter de certains sujets « chauds » avec le président chinois Xi Jinping, dont l’accès de la Chine à la technologie Blackwell et la récente interdiction de Nvidia en Chine.

Historiquement tournée vers le calcul accéléré et la recherche, l’édition 2025 s’est – comme pour retourner la politesse – beaucoup focalisée (pour ne pas dire trop) sur le made in USA, les infrastructures nationales, les hyperscalers américains et les partenaires américains.

Sans grande surprise, Jensen Huang, le CEO de Nvidia s’est surtout époumoné à présenter une vision où l’IA irrigue tous les secteurs, des datacenters aux véhicules autonomes, et tout ce que fait la firme.

Nvidia à 5 000 milliards de dollars de valorisation

Et il aura suffi de quelques minutes et de quelques petites phrases du CEO pour enflammer Wall Street, qui a propulsé Nvidia au-delà des 5 000 milliards de dollars de capitalisation, un seuil historique, à peine 100 jours après que la firme ait été la première à franchir le palier des 4 000 Mds $ de valorisation cet été.

5000 milliards de dollars… C’est plus que la valorisation cumulée de Tesla, Netflix et Meta ! C’est même plus que le PIB de la France ou de l’Allemagne !

Un emballement en partie fruit d’un malentendu ! Lors de son keynote, Jensen Huang a évoqué « 500 milliards de dollars de commandes », une phrase interprétée comme des revenus immédiats alors qu’il s’agissait d’engagements pluriannuels, comme le précisait plus clairement la magnifique slide affichée derrière l’orateur. Un malentendu qui, après les éclaircissements de la Firme, a entraîné une redescente du titre juste sous la barre des 5000 milliards. Ce qui n’empêche pas Nvidia de peser à elle seule 4,4% de la valeur totale des actions mondiales.

L’ambiance était électrique à Wall Street mais également à la GTC où Jensen Huang n’avait pas d’annonces produits majeures à faire mais plein de bonnes nouvelles à annoncer.

De l’IA, des datacenters au cloud

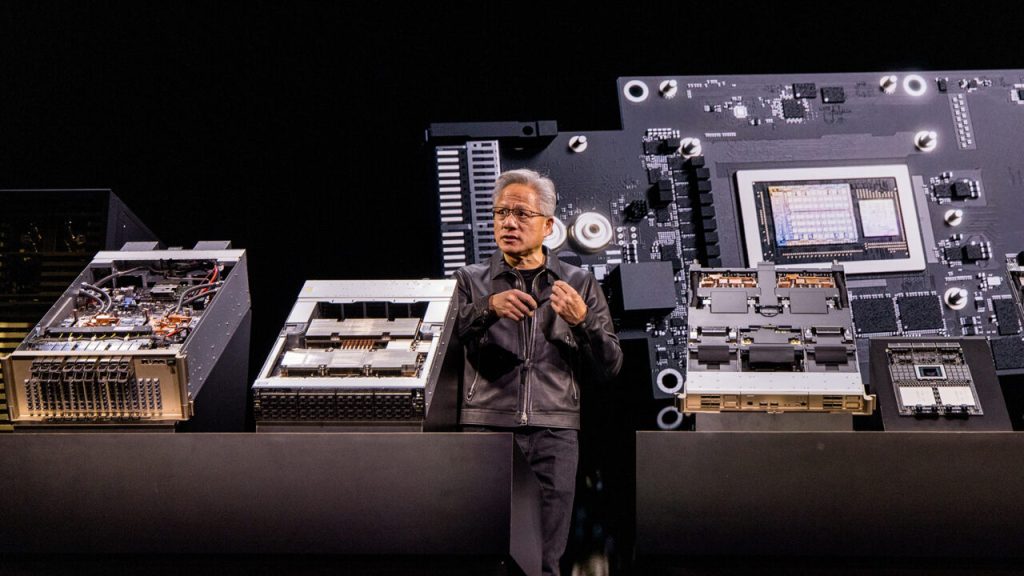

Au cœur du message “entreprise”, Nvidia a officialisé la RTX PRO 6000 Blackwell Server Edition, une carte serveur GPU Blackwell pensée pour l’inférence lourde, la visualisation 3D, les jumeaux numériques et la simulation.

Elle arrive chez les grands constructeurs de serveurs d’entreprise, mais aussi chez les Hyperscalers ! Ces derniers semblent se jeter sur ces puces non pas pour leurs propres besoins ou ceux des leaders de l’IA mais bien pour les entreprises en quête de puissance GPU à la demande.

Google Cloud a lancé ses VM G4 adossées à cette Blackwell Server Edition.

Microsoft a également annoncé la disponibilité de ces puces « PRO 6000 SE » non seulement dans Azure, mais aussi en Azure Local (edge/onsite), pour rapprocher l’IA des sites industriels ou sensibles.

Bien sûr il y a aussi derrière ces annonces l’ombre de la plateforme « Nvidia AI Enterprise » (avec les microservices IA NIM, le framework Cuda-X, la boite à outils NeMo…) avec la promesse d’une transposition directe des briques IA Nvidia du datacenter privé au cloud public et au edge.

Nvidia multiplie les HPC comme des petits pains

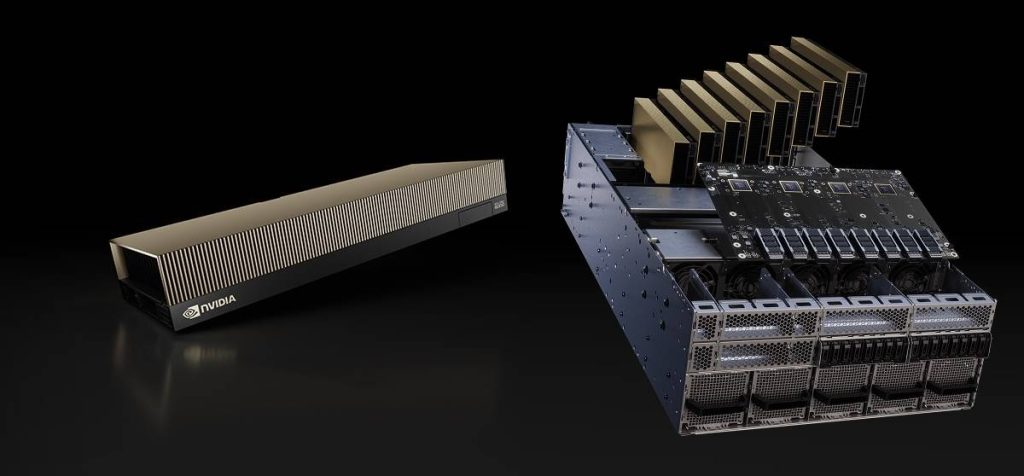

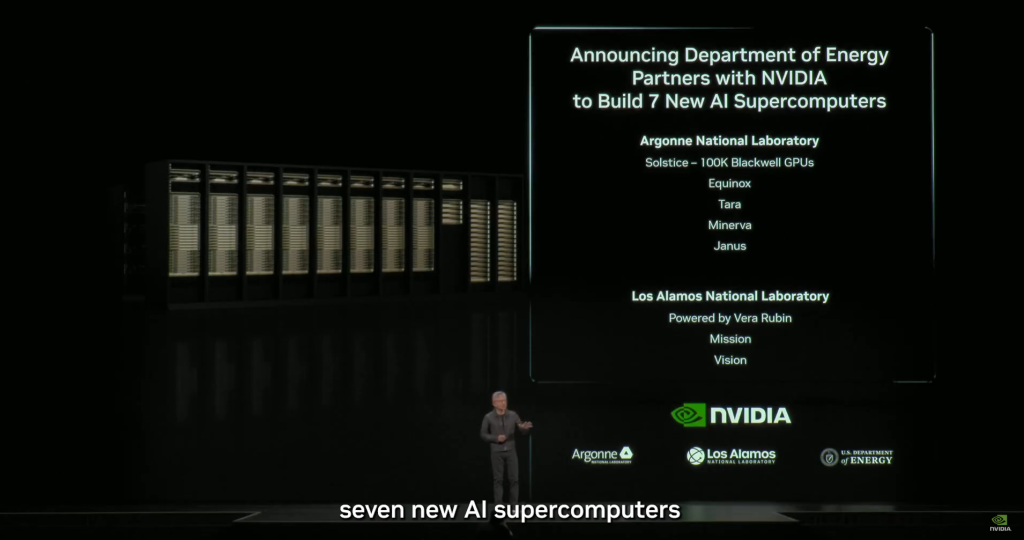

Pour continuer dans l’autosatisfaction américaine, Nvidia a dévoilé les nouveaux HPC Solstice et Equinox, deux supercalculateurs orientés IA construits pour le Département américain de l’Énergie en partenariat avec Oracle. Ils seront installés au laboratoire national d’Argonne et constituent les plus puissantes « usines d’IA » jamais conçues.

Solstice est le plus ambitieux des deux : il embarquera 100 000 GPU Blackwell de Nvidia, ce qui en fera le plus grand supercalculateur d’IA jamais déployé par le DOE. Sa puissance est pensée pour soutenir la recherche scientifique, la sécurité nationale et l’énergie.

Plus compact mais tout aussi stratégique, Equinox se contentera de 10 000 GPU Blackwell. Il doit entrer en service dès 2026 et servira de première étape avant la mise en ligne complète de Solstice.

Ensemble, les deux systèmes offriront une puissance combinée estimée à 2 200 exaflops dédiés à l’IA, un chiffre inédit qui dépasse de loin les capacités actuelles des supercalculateurs traditionnels.

Et ce n’est pas tout ! Au total, sept supercalculateurs américains seront conçus sur les technologies Nvidia dans les prochaines années.

Tous ces systèmes s’appuieront sur la toute nouvelle génération de commutateur Infiniband : le NVidia Quantum-X800, offrant 800 Go/sec de bande passante par port (soit le double de l’actuelle génération Infiniband) ! Le Quantum‑X800 est pensé pour devenir l’épine dorsale des usines d’IA. Ce puissant moteur réseau permet de connecter des dizaines de milliers de GPU Blackwell en un seul système cohérent avec une latence ultra‑faible et des fonctions de calcul « in‑network ».

« L’IA est la technologie la plus puissante de notre temps, et la science son plus grand terrain de jeu », a lancé Huang, en présentant Solstice comme un “moteur de découverte” public.

Nvidia peaufine ses modèles maison

Lors de la GTC, Nvidia a rappelé à tous non seulement son attachement à développer ses propres modèles optimisés pour ses GPU et sa plateforme AI Enterprise mais également son engagement en faveur d’une IA en open source. La firme a dévoilé une série de modèles et de jeux de données ouverts destinés à accélérer l’innovation en intelligence artificielle dans les domaines du langage, de la robotique et des sciences du vivant. Ces technologies, regroupées sous les familles Nemotron, Cosmos, Isaac GR00T et Clara, offrent aux développeurs les fondations nécessaires pour concevoir des agents intelligents spécialisés, capables de raisonner, d’interagir avec le monde physique et de contribuer à la recherche biomédicale.

Avec Nemotron, NVIDIA propose des modèles de raisonnement ultra-efficaces, capables de traiter des documents, d’analyser des images et des vidéos, d’extraire des données structurées et de modérer les contenus dans neuf langues. Ces modèles sont accompagnés de jeux de données inédits et d’outils comme NeMo Data Designer et NeMo-RL, qui facilitent la personnalisation et l’entraînement avancé.

La famille se compose de :

* Nemotron Nano 3 : raisonnement rapide pour agents spécialisés en IT et support.

* Nemotron Nano 2 VL : analyse multimodale de documents, images et vidéos.

* Nemotron Parse : extraction précise de texte et tableaux.

* Nemotron Safety Guard : modération multilingue sur 23 catégories sensibles.

* Nemotron RAG : récupération unifiée sur texte, image, audio et vidéo.

Dans le domaine de l’IA physique, Nvidia enrichit son offre avec Cosmos et Isaac GR00T, des modèles conçus pour simuler des environnements complexes, générer des vidéos à partir d’images fixes, et améliorer le contrôle des robots humanoïdes. Ces avancées s’appuient sur le plus grand jeu de données open source jamais publié pour l’IA physique, incluant plus de 1 700 heures de capteurs de conduite collectés en Europe et aux États-Unis. Des acteurs comme Amazon Robotics, Figure AI et Uber exploitent déjà ces ressources pour entraîner leurs agents physiques à grande échelle.

Enfin, Nvidia Clara ouvre de nouvelles perspectives pour la recherche médicale et biologique. Des modèles comme CodonFM et La-Proteina permettent de décrypter les règles de l’ARN et de générer des structures protéiques complexes, tandis que Clara Reason apporte des capacités de raisonnement explicable aux images médicales. Ces modèles sont mis à disposition sur Hugging Face, Azure AI Foundry et bientôt sur Google Vertex AI, sous forme de microservices NIM pour un déploiement sécurisé et scalable..

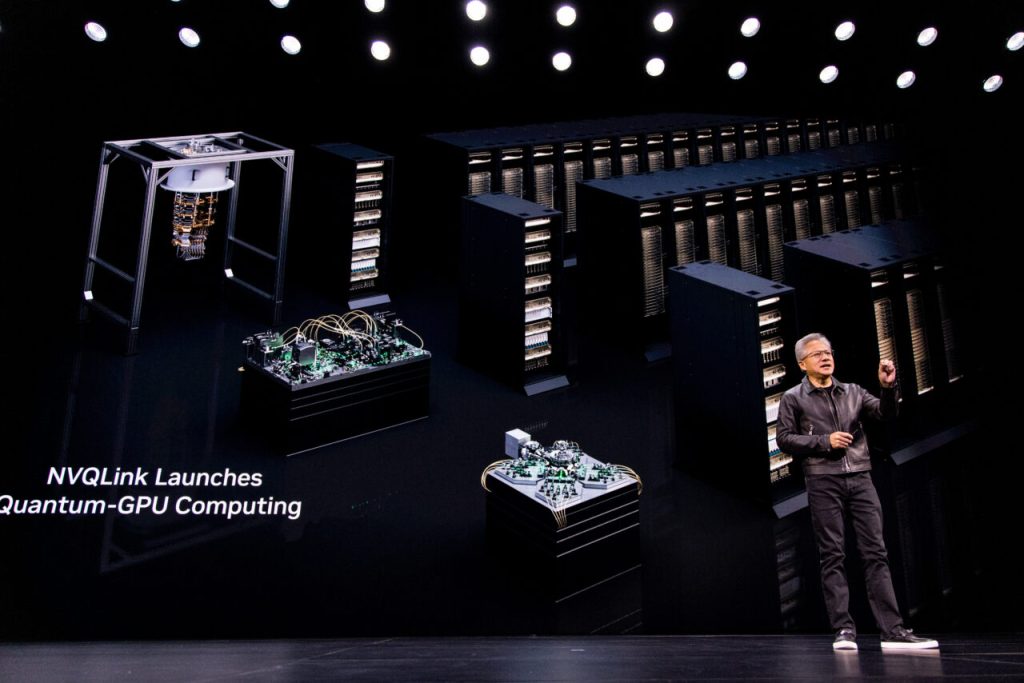

Nvidia cherche sa place dans l’univers quantique

Et si le quantique marquait la fin du règne des GPU dans l’accélération IA ? Le risque existe et Nvidia ne peut l’ignorer, même si un tel remplacement n’arrivera pas au mieux avant une décennie. Alors, la firme américaine commence déjà à se positionner. L’an dernier elle avait inauguré sa stack Cuda-Q.

À GTC 2025, Nvidia a dévoilé NVQlink, une interconnexion ouverte qui relie directement QPU (processeurs quantiques) et GPU classiques avec une latence déterministe pour créer des supercalculateurs hybrides dans laquelle la partie classique ne bride pas la partie quantique. Jensen Huang l’a décrit comme « la pierre de Rosette entre le quantique et le classique ». Parmi les partenaires, figure la startup française Alice & Bob, spécialisée dans la correction d’erreurs quantiques. L’objectif de ce partenariat est d’accélérer la concrétisation de qubits logiques fiables et donc l’arrivée des machines quantiques tolérantes aux fautes.

NVQLink ne se contente pas de relier le QPU au GPU : il vise à standardiser les couches où tout se joue (décider, corriger et recalibrer en temps réel) pour rendre l’informatique quantique tolérante aux erreurs afin que l’ordinateur quantique à qubits logiques tienne la route.

Apparemment, la 6G aux USA ne se fera pas sans Nvidia

Au registre télécoms, Nvidia a dévoilé avec des partenaires américains une pile “All-American AI-RAN” (bonjour le nommage aligné sur la doctrine America First de Trump) centrée sur les USA… Ah, non, pardon… centre sur l’IA pour la future 6G (Américaine donc) !

Pour la préparer, Nvidia annonce publier en open source sa suite logicielle RAN/AI-RAN dénommée « Aerial ».

Nvidia investit en parallèle pour structurer l’écosystème 6G aux États-Unis (tests avec T-Mobile, coopération industrielle, accords avec des équipementiers). L’idée : faire des stations radio des ordinateurs d’IA capables d’orchestrer trafic et inférence au bord du réseau.

Robotique et jumeaux numériques

Nvidia avait déjà largement évoqué l’an dernier et à la GTC de printemps en mars dernier son intérêt plus que prononcé à la fois pour les jumeaux numériques (compagnons de choix de bien des usages IA) et pour la robotique.

Lors de cette édition d’automne, la firme a concrétisé un peu plus sa vision de la “Physical AI” avec IGX Thor, une plateforme Blackwell remaniée pour l’edge industriel et médical et capable de traiter en temps réel des données critiques pour la santé, l’industrie et les transports. Ce nouveau processeur industriel offre des bonds de performances majeurs par rapport à la génération IGX Orin et des capacités temps réel/sûreté fonctionnelle nouvelles.

En parallèle, Nvidia étend son Blueprint Omniverse en version « Mega ». NVIDIA Omniverse est une plateforme de simulation et de collaboration 3D basée sur la norme OpenUSD, conçue pour créer des jumeaux numériques réalistes, former des robots, tester des systèmes industriels et connecter des applications de conception. Nvidia la présente comme l’« OS de l’IA physique » où le virtuel et le réel se rejoignent. C’est à la fois un simulateur universel, un hub collaboratif et un accélérateur industriel.

Avec Omniverse Mega Blueprint, il ne s’agit plus de seulement simuler des cellules de production, mais des flottes entières de robots et des usines entières, jusqu’à la logistique et la conformité, en mêlant OpenUSD, IA et données opérationnelles. Siemens est le premier éditeur à implémenter ce blueprint dans Xcelerator. Foxconn a montré la conception de son usine de Houston dans Omniverse.

Mobilité autonome : quand Nvidia veut s’embarquer dans les taxis

Autre annonce forte de ce GTC 2025 d’automne, Nvidia et Uber s’allient pour bâtir l’un des plus grands réseaux mondiaux de robotaxis (de niveau 4) à partir de 2027, avec des flottes propulsées par la plateforme DRIVE AGX Hyperion 10 et DRIVE AV.

Plusieurs constructeurs, dont Stellantis, fourniront des véhicules L4 à Uber, avec une première série de 5 000 unités annoncée. « Nous pouvons aider Uber à passer à l’échelle », a ainsi expliqué Nvidia, l’objectif étant d’orchestrer à terme 100 000 véhicules autonomes.

Au final, cette GTC 2025 d’automne a confirmé ce que l’on savait déjà. Nvidia s’impose comme le grand architecte de l’IA et investit tout azimut pour ne surtout pas se faire rattraper et conserver son avance. Loin de se contenter de fournir des GPU, Nvidia s’infiltre dans toutes les couches de l’industrialisation de l’IA pour en devenir l’épine dorsale qui anime, héberge et orchestrer GPU, réseau, piles logicielles, jumeaux numériques, RAN 6G et même quantique hybride. Une épine dorsale capable de déplacer l’IA du centre de calcul vers le cloud, l’usine, la route et même l’antenne réseau.

Pour autant cette ascension fulgurante pourrait aussi faire de l’entreprise l’une des premières victimes d’un éventuel éclatement de la supposée bulle IA. Car une grande partie des promesses qui enthousiasment tant les investisseurs repose en réalité sur des partenariats avec des startups/acteurs en hypercroissance dont les engagements (robotaxis, 6G, quantique) représentent des milliards non encore financés et étalés très loin dans le temps. Nvidia est aujourd’hui au sommet, mais son avenir dépendra de la solidité d’un écosystème qui, pour l’instant, promet bien volontiers de dépenser des milliards qu’il est encore loin d’avoir gagnés…

À LIRE AUSSI :

À LIRE AUSSI :