Data / IA

La cybersécurité à l’ère de l’IA en 2026 : enfin des chiffres intéressants…

Par Laurent Delattre, publié le 04 février 2026

Les SOC branchent l’IA générative pour gagner des heures… pendant que les attaquants l’utilisent pour gagner des minutes. Agents IA, prompt injection et serveurs MCP transforment chaque connecteur en porte d’entrée potentielle. Un nouveau rapport signé Darktrace chiffre la maturité des défenseurs, des défenses et des cyberattaquants sur l’IA générative et agentique.

Le nouveau rapport « State of AI Cybersecurity 2026 » de Darktrace, réalisé auprès de 1500 DSI et RSSI à travers le monde y compris en France, a le mérite de chiffrer des tendances que vous n’aurez pas manqué d’expérimenter depuis plusieurs mois. D’une part, l’IA devient un levier dans la défense des infrastructures IT et le rapport montre clairement que ce soutien IA est loin d’être inutile. D’autre part, l’usage de l’IA dans l’entreprise génère une surface d’attaque inédite et la montée des agents IA inquiète. L’intelligence artificielle est devenue à la fois l’arme la plus efficace des défenseurs et le terrain de jeu privilégié des attaquants.

Une dualité que les entreprises peinent encore à maîtriser comme le chiffre le nouveau rapport Darktrace :

* 77% des DSI/RSSI ont intégré l’IA générative dans leur dispositif de cyberdéfense.

* 73 % des DSI/RSSI disent déjà constater un impact significatif des menaces générées par IA sur leur organisation.

L’IA générative s’est imposée dans 77 % des stacks sécurité

Le premier enseignement de l’étude tient à la vitesse d’adoption. En 2024, un quart des professionnels interrogés déclaraient ne pas être familiers avec l’IA générative. Cette époque est révolue. Aujourd’hui, 77 % des organisations ont intégré l’IA générative dans leur dispositif de défense.

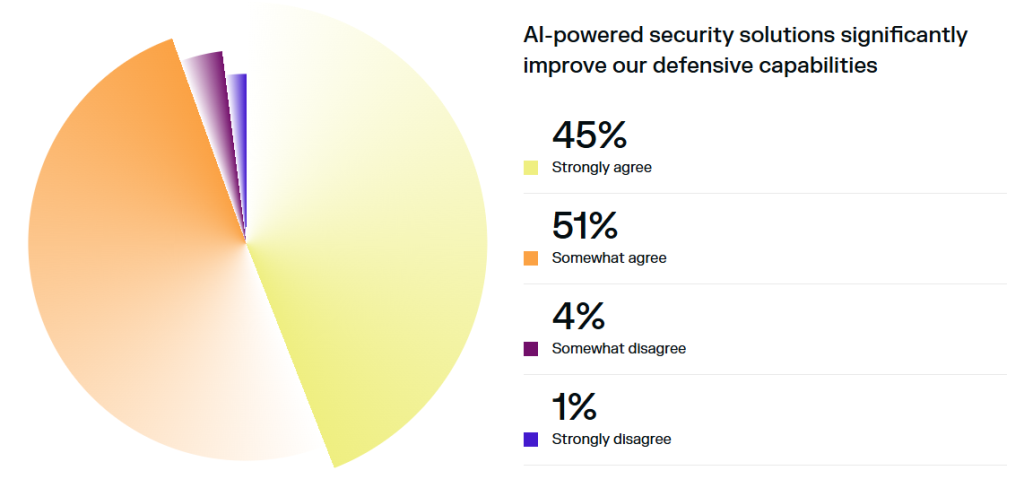

Surtout, et c’est sans doute le chiffre le plus intéressant et le plus surprenant de cette étude, 96 % des répondants RSSI/DSI affirment que l’IA générative améliore significativement leur rapidité et leur efficacité opérationnelle.

Cette adoption massive ne relève pas du simple effet de mode. Face à l’intensification des attaques (87 % des professionnels observent une augmentation du volume de menaces liée à l’IA) l’automatisation devient une nécessité. La détection d’anomalies et l’identification de menaces inédites arrivent en tête des cas d’usage où l’IA démontre sa valeur ajoutée. Le filtrage du bruit, l’accélération du triage et même les premières formes de « réponse autonome » gagnent du terrain.

Pourtant, les RSSI avancent avec prudence. Seuls 14 % d’entre eux autorisent aujourd’hui l’IA à prendre des actions de remédiation de manière totalement autonome. La grande majorité (70 %) maintient un « humain dans la boucle » pour valider les décisions critiques.

Bien au-delà du débat philosophique, c’est d’abord un problème de confiance et d’auditabilité : 92 % des DSI/RSSI disent devoir comprendre comment un outil défensif basé sur l’IA prend ses décisions avant de lui accorder leur confiance, et 74 % limitent explicitement l’autonomie tant que l’explicabilité ne progresse pas.

Les agents IA : nouvelle surface d’attaque, nouvelle source d’angoisse

Si l’IA défensive progresse, c’est bien l’IA offensive qui concentre les principales inquiétudes. Et plus spécifiquement, les agents IA. Ces systèmes autonomes, capables d’exécuter des tâches complexes sans supervision humaine constante, commencent à se déployer dans les workflows opérationnels et les applications SaaS de l’entreprise.

Selon l’étude de Darktrace, 44% des responsables IT interrogés se disent préoccupés par les implications de sécurité liés à l’usage de LLM tiers.

Surtout, ils sont 92 % à se déclarer préoccupés par l’impact de l’IA Agentique sur la sécurité.

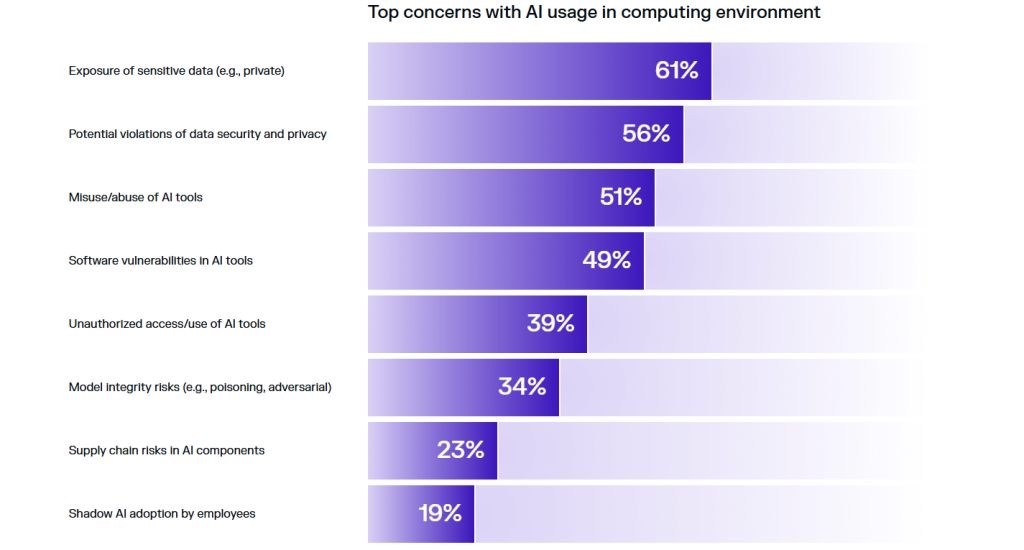

Bien sûr, cette inquiétude se justifie par la nature même de ces agents. Ils accèdent à des données sensibles, prennent des décisions en temps réel et peuvent interagir avec de multiples systèmes simultanément. Darktrace a d’ailleurs observé, au cours du seul mois d’octobre 2025, une hausse de 39 % des téléchargements de données anormaux vers des services d’IA générative. Le volume moyen de ces transferts atteint 75 Mo, soit l’équivalent de 4 700 pages de documents, une fuite de données potentielle à chaque requête mal contrôlée.

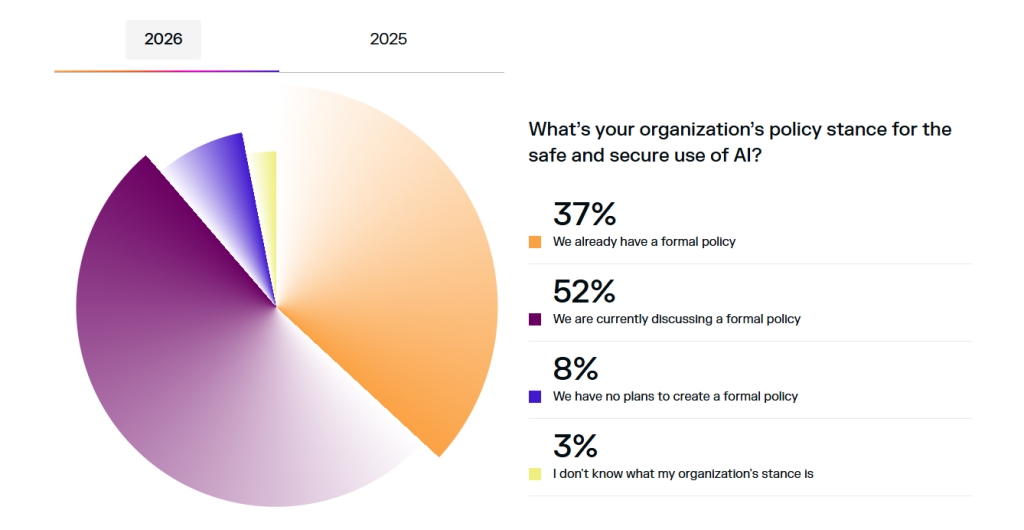

Ce qui frappe également à la lecture de l’étude, c’est le décalage entre l’exposition perçue et la maturité de gouvernance pour y répondre. Certes, toutes ces technologies IA, notamment agentiques, sont encore très immatures. Et leur adoption se fait bien plus rapidement que la mise en place des contrôles de sécurité et des règles internes de bon usage. Les chiffres du rapport confirment ce constat et montrent que les organisations naviguent encore à vue. L’étude révèle que seulement 37 % des entreprises disposent d’une politique encadrant l’usage sécurisé de l’IA, contre 45 % l’an dernier. Plus préoccupant encore : 8 % n’ont aucun projet d’en établir une, contre 3 % précédemment. La gouvernance de l’IA recule alors même que son adoption explose.

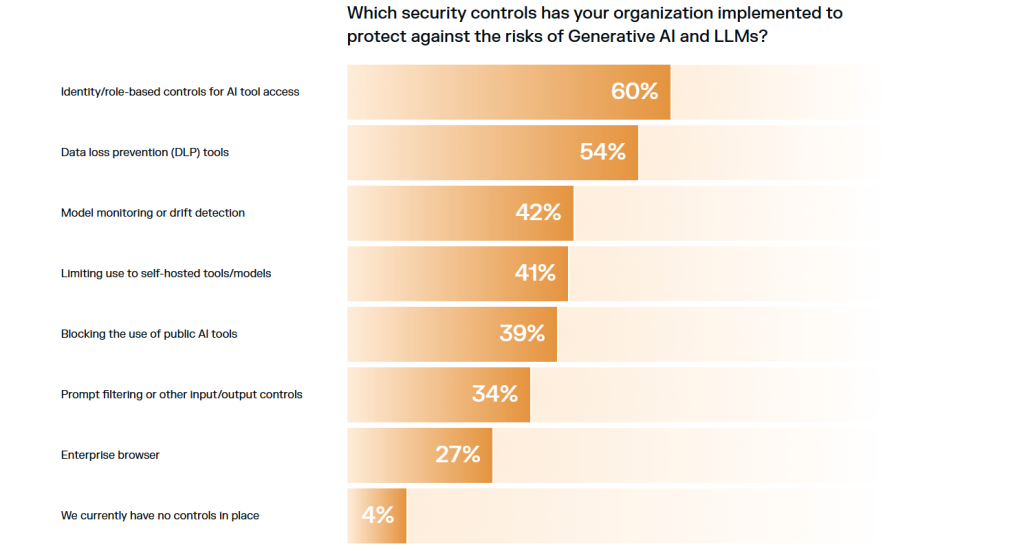

Une IA « dans le SI” n’est pas seulement un modèle à protéger, c’est un ensemble qui ingère et génère de l’information potentiellement sensible, prend des décisions, et peut agir à grande échelle. Tant que l’entreprise ne sait pas où l’IA est consommée, quelles données elle peut ingérer, quels systèmes elle peut actionner, la sécurité reste cantonnée à des correctifs ponctuels. Le rapport souligne d’ailleurs que les contrôles qui remontent comme prioritaires pour encadrer ces usages sont les fondamentaux, au premier rang desquels IAM et DLP.

Des attaques plus rapides, plus “personnalisées”

Du côté des attaquants et des attaques qu’ils mènent, le paysage évolue également suite à un usage malveillant croissant de l’IA. Ce n’est pas une surprise. Ce sujet est largement exploré et médiatisé par les acteurs de la cybersécurité depuis plus d’un an désormais. L’étude insiste néanmoins sur la capacité de l’IA à s’infiltrer tout au long de la « kill chain », de l’intrusion initiale à l’exfiltration.

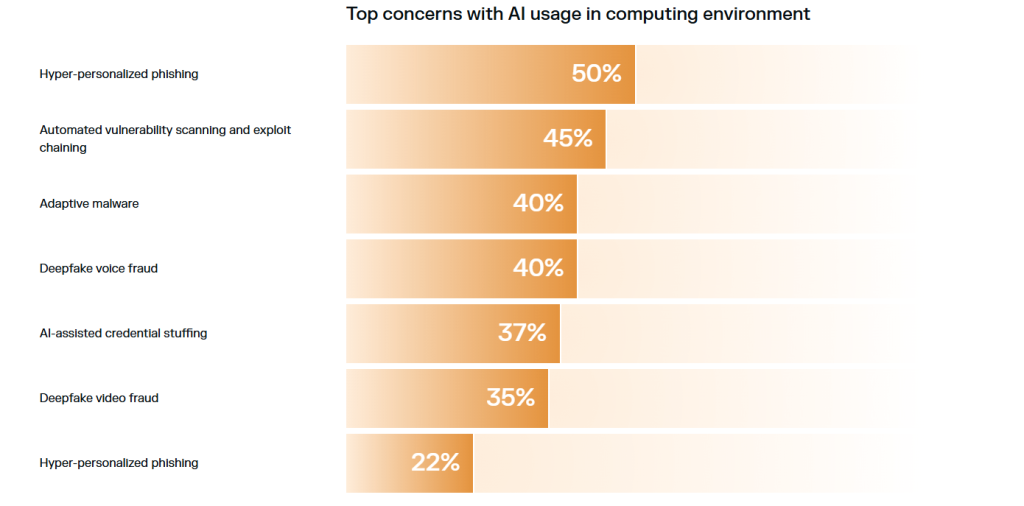

Sans surprise, l’hyper-phishing « sur mesure », autrement dit « le phishing hyper personnalisé », arrive en tête des techniques qui inquiètent le plus les DSI et RSSI : 50% d’entre eux le place en haut de leur liste des menaces les plus redoutées. Suivent le scan automatisé de vulnérabilités (45 %), les malwares adaptatifs (40 %) et les deepfakes vocaux (39 %). Ces techniques exploitent la capacité de l’IA à personnaliser les attaques à grande échelle, à s’adapter aux défenses en temps réel et à usurper des identités avec un réalisme croissant. L’idée n’est pas seulement la qualité rédactionnelle ou la haute crédibilité des leurres.

Ce qui inquiète aussi c’est la capacité à industrialiser des campagnes contextualisées, à tester des variantes, à itérer rapidement. Les chiffres parlent d’eux-mêmes : 73 % des professionnels estiment que les menaces pilotées par l’IA ont déjà un impact significatif sur leur organisation.

Et 91 % considèrent que l’IA rend les attaques de phishing et d’ingénierie sociale plus sophistiquées et plus efficaces. L’industrialisation des cyberattaques par l’IA n’est plus une hypothèse prospective, c’est une réalité opérationnelle.

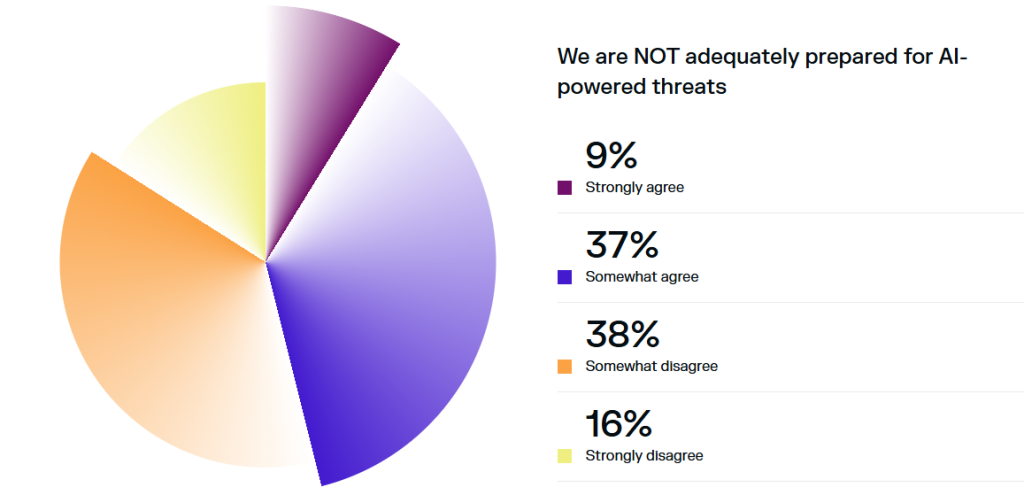

Conséquence directe, la confiance des cyberdéfenseurs s’érode. Après une amélioration notable entre 2024 et 2025, le sentiment de préparation face aux attaques IA a légèrement reculé cette année. Près de la moitié des répondants (46 %) admettent ne pas se sentir prêts à contrer ces nouvelles menaces.

Autre signal faible qui monte vite. Darktrace pointe le fait que les modèles IA et les serveurs MCP (Model Context Protocol) deviennent des cibles courantes. L’éditeur souligne que certaines vulnérabilités sont exploitées “en quelques minutes” après publication.

MCP standardise la connexion d’un LLM à des outils et sources externes, ce qui multiplie mécaniquement les chemins d’accès et portes d’entrée possibles. Les multiples failles révélées en 2025 autour de serveurs MCP ont largement démontré comment un attaquant peut “piéger” l’IA en lui faisant utiliser un outil de travers, ou en l’amenant à exécuter une instruction indirecte qu’elle n’aurait pas dû suivre (tactique du « prompt injection »). Et quand on combine un agent d’IA, plusieurs outils et des droits d’accès trop larges, on peut créer des effets de bord redoutables qui vont d’une simple fuite de données à des actions techniques beaucoup plus graves sur les systèmes, jusqu’à la prise de contrôle d’un serveur dans les cas extrêmes.

Le déficit de compétences, frein numéro un à la défense

Quand on interroge les professionnels sur les principaux obstacles à leur capacité de défense face aux menaces IA, ce n’est ni le budget ni le soutien de la direction qui arrivent en tête. C’est le manque de connaissances et de compétences. Les organisations financent leurs programmes de cybersécurité, mais elles peinent à développer l’expertise nécessaire pour exploiter pleinement les outils IA et comprendre les nouvelles tactiques adverses.

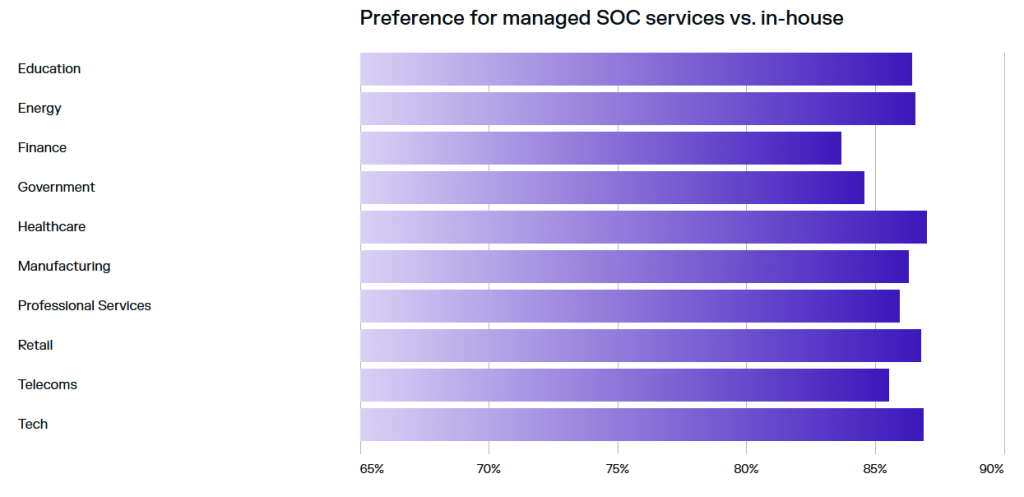

Cette pénurie de compétences se traduit par une dépendance croissante aux prestataires externes : 85 % des professionnels déclarent préférer obtenir leurs nouvelles capacités SOC sous forme de services managés. L’externalisation permet d’accéder à une expertise pointue, de s’adapter à l’évolution rapide des menaces et de libérer les équipes internes pour qu’elles se concentrent sur les priorités métier.

L’étude met également en lumière un décalage de perception entre les échelons hiérarchiques. Les dirigeants tendent à surestimer le niveau d’autonomie accordé à l’IA dans leur organisation (18 % pensent que l’IA dispose d’une forte autonomie) par rapport aux praticiens qui opèrent quotidiennement ces systèmes. Ce « gap de confiance cyber » entre vision stratégique et réalité opérationnelle constitue un risque en soi.

Quelles priorités défensives en 2026 ?

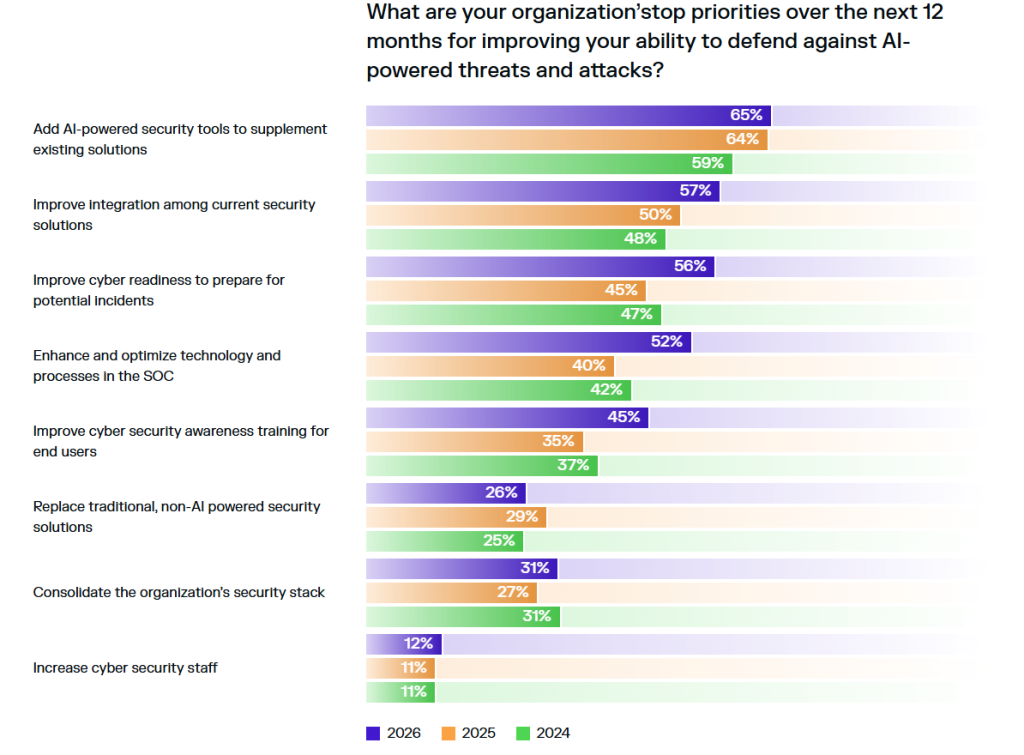

Dans ce contexte, quelles sont les priorités des équipes sécurité pour l’année à venir ? Les priorités budgétaires restent pragmatiques. L’ajout d’outils de sécurité IA arrive sans surprise en tête des investissements prévus, devant l’intégration des solutions déjà en place et la préparation aux incidents. L’objectif poursuivi est aussi de réduire le « bruit » dans les SOC, d’accélérer la qualification et mieux prioriser, plutôt que de chercher une autonomie totale à marche forcée.

L’autre tendance majeure concerne la consolidation des plateformes : 87 % des répondants se disent favorables à une approche plateforme, moins de vendeurs et plus d’intégration native. La multiplication des outils de sécurité a atteint ses limites selon l’étude. Les entreprises recherchent désormais des solutions intégrées offrant une visibilité transverse (réseau, cloud, email, endpoints, IA) avec des intégrations natives plutôt qu’une mosaïque de produits ponctuels nécessitant des tableaux de bord multiples.

Ce qu’il faut retenir

Le paysage tracé par le rapport Darktrace n’est pas une surprise. Que l’IA s’impose à la fois comme une composante essentielle de la cyberdéfense et de la cyberattaque n’est pas une nouveauté. Tout comme le fait que l’IA a créé de nouvelles vulnérabilités que les organisations commencent à peine à cartographier. Ce n’est pas non plus sa lecture qui fera découvrir aux DSI et RSSI que l’IA agentique introduit une nouvelle forme de risque interne, qui dispose de la portée d’action d’un collaborateur mais sans les contextes du monde physique ni la responsabilité humaine intrisèque.

Les mérites de ce rapport sont ailleurs. Le premier est de chiffrer des tendances jusqu’ici peu étudiée comme la perception de l’efficacité des IA défensives. Le second est de sortir la cybersécurité IA du registre “innovation” pour la replacer dans celui de la gouvernance. Il invite ainsi les organisations à étendre dès maintenant leur modèle de sécurité. Il faut inventorier les usages et les chemins de données, traiter les agents comme des identités à part entière avec des droits minimaux, temporaires et traçables, appliquer des contrôles DLP adaptés aux prompts et aux sorties, et verrouiller la chaîne d’intégration des outils et connecteurs type MCP via une logique de listes d’autorisations, de signature, de revue de permissions et de tests d’injection. Dit autrement, il invite les entreprises à la vigilance continue et à transformer dès à présent l’IA en un périmètre piloté, auditable, contractualisé, au même titre que le Cloud et l’identité. Une façon de rappeler que l’IA a relancé de plus belle la course entre attaquants et défenseurs, et que dans cette course l’immobilisme n’est jamais une option.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :