Data / IA

OpenAI dévoile Operator, un agent IA autonome animé par son nouveau modèle CUA

Par Laurent Delattre, publié le 24 janvier 2025

C’est fait. OpenAI a cette nuit officiellement fait ses premiers pas dans l’univers des agents IA autonomes en présentant son tout premier Agent IA « Operator » capable de découper une mission en plusieurs étapes, puis de contrôler l’écran, la souris et le clavier pour naviguer sur le Web de façon autonome et remplir la mission demandée. Explications…

Hier, nous évoquions dans nos colonnes les avertissements de Satya Nadella, CEO de Microsoft, qui expliquait que les agents IA allaient transformer le fonctionnement des services SaaS et des logiciels et par voie de conséquences nos usages des logiciels. Quelques heures après cette publication, ce futur prenait une tournure un peu plus concrète avec l’annonce d’une préversion d’Operator, le premier Agent IA autonome d’OpenAI capable de naviguer seul sur le Web et prendre le contrôle de la souris et du clavier.

Certes, les démonstrations d’Operator ont un petit quelque chose de déjà vu. Logique. Anthropic avec l’agent « Computer Use » dans Claude AI mais aussi Google avec « Project Mariner » dans « Gemini 2.0 » travaillent sur des agents très similaires dans leurs objectifs à l’Operator d’OpenAI.

Plus concrètement, Operator est une application web conçue pour effectuer automatiquement des tâches en ligne, telles que réserver des billets de concert ou faire ses courses, simplement à partir d’instructions textuelles. Cet agent est animé par un nouveau modèle baptisé Computer-Using Agent (CUA), construit à partir de la technologie multimodale GPT-4o.

Une première démonstration du potentiel des “agents” d’IA

Contrairement aux modèles traditionnels qui interagissent avec des sites et des applications via des API spécialisées, Operator exploite directement l’interface graphique (boutons, menus, champs de texte) que les humains utilisent au quotidien sur leur navigateur Web. Lorsqu’un utilisateur saisit une requête (par exemple « Réserve-moi une table pour deux personnes à 19 h »), Operator ouvre un navigateur distant et effectue les clics nécessaires, comme le ferait un internaute.

« C’est un premier pas naturel pour les agents IA : l’environnement du navigateur est suffisamment contraint pour que l’IA puisse réellement y être efficace et suffisamment riche pour offrir des cas d’utilisation concrets », estime ainsi Ali Farhadi, PDG de l’Allen Institute for AI (AI2).

Les utilisateurs peuvent personnaliser leurs workflows dans Operator grâce à l’ajout d’instructions sur mesure (Custom Instructions), applicables soit pour l’ensemble des sites, soit pour des plateformes spécifiques – par exemple, en définissant leurs préférences aériennes sur Booking.com. Operator permet également la sauvegarde de prompts sur la page d’accueil pour un accès rapide, une fonctionnalité particulièrement adaptée aux tâches récurrentes comme le réapprovisionnement alimentaire sur des sites comme Instacart.

Operator agit comme un utilisateur humain : il clique, il saisit des informations, il en copie/colle d’autres. Et pour cela, il analyse et « voit » ce que n’importe quel utilisateur verrait face à son écran en naviguant sur les sites. Ce qui signifie qu’il comprend ce qui est à l’écran et agit en fonction. Et pour réaliser une telle prouesse, il s’appuie sur un nouveau modèle d’OpenAI répondant à l’acronyme CUA…

Un nouveau modèle IA capable de “voir” l’écran

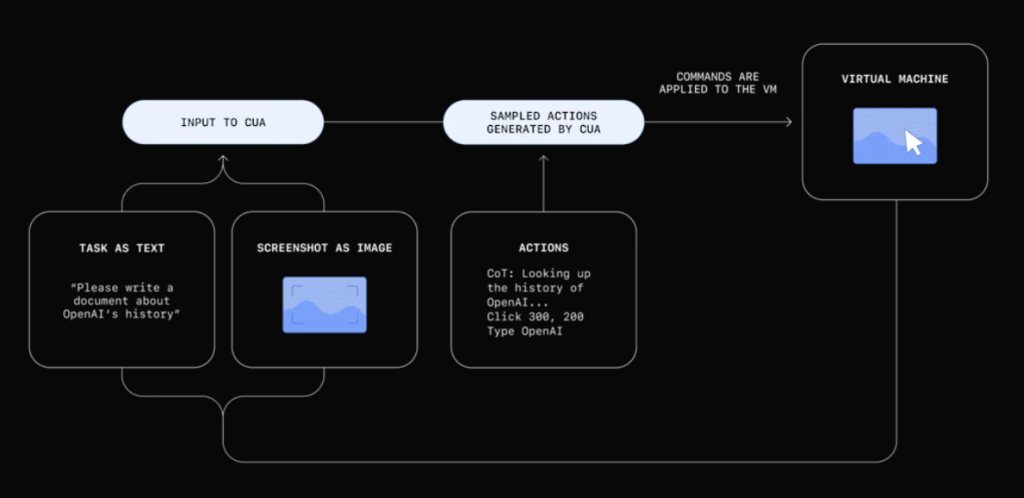

Le modèle CUA (prononcez “coo-ah”, acronyme de Computer Using Agent) permet à Operator de “lire” l’écran grâce à des captures d’écran et de prendre des décisions en se basant sur ce qu’il détecte. Combinant le modèle multimodal GPT-4o (et sa fonctionnalité Vision) à une capacité de raisonnement avancé, fruit de mécanismes d’apprentissage par renforcement similaires à ceux qui font réfléchir le modèle « OpenAI o1 », CUA sait décomposer les tâches complexes qu’on lui demande en sous-étapes et sait revenir en arrière si nécessaire.

Operator exploite une VM distante pour exécuter un navigateur, afficher le site Web visité, connecter l’image du site au modèle CUA et recevoir de ce dernier les clics et saisie clavier à réaliser.

CUA traite les données de pixels bruts pour comprendre ce qui se passe à l’écran et utilise une souris et un clavier virtuels pour effectuer des actions et interagir à la façon humaine avec les sites Web. Il peut naviguer dans des tâches multi-étapes, gérer les erreurs et s’adapter aux changements inattendus. Il peut – et c’est une grande première – demander l’aide de l’utilisateur en cas de doute ou de situation demandant une approbation humaine.

Selon OpenAI, CUA se classe en tête sur plusieurs tests de référence face à des solutions concurrentes comme Computer Use d’Anthropic et Mariner de Google DeepMind. Sur le Benchmark OSWorld (fusion de PDF, retouche d’image, etc.), CUA obtient 38,1 % contre 22,0 % pour Computer Use (et 72,4 % pour un utilisateur humain). Sur le Benchmark WebVoyager (navigation web), il atteint 87 % devant Mariner (83,5 %) et Computer Use (56 %).

Des partenariats stratégiques et une ouverture future

Pour le moment, Operator se limite aux tâches dans un navigateur, mais OpenAI compte proposer l’IA CUA en tant qu’API pour que d’autres développeurs intègrent ses fonctionnalités dans leurs propres services. La société a déjà noué des partenariats avec des plateformes telles que OpenTable, StubHub, Instacart, DoorDash et Uber pour optimiser l’expérience utilisateur sur ces sites.

En matière de sécurité, OpenAI affirme avoir testé l’agent via des “red teams” afin de prévenir les utilisations malveillantes, la manipulation de sites et les dérives possibles du modèle. En cas d’action sensible, l’IA doit demander une confirmation à l’utilisateur avant d’aller plus loin.

Un accès aussi onéreux que limité

Operator est accessible en « preview » dès à présent sur operator.chatgpt.com mais uniquement pour les abonnés ChatGPT Pro (le fameux service premium à 200 $ par mois) et uniquement aux États-Unis. OpenAI prévoit d’étendre progressivement l’accès à ses autres offres payantes, voire ultérieurement à l’ensemble de ses utilisateurs.

Yash Kumar, chercheur chez OpenAI, reconnaît que le service n’est pas encore infaillible et possède de nombreuses limites : « C’est encore expérimental, il commet des erreurs », dit-il.

Vers la fin de la RPA

Pour ceux qui souhaitent déléguer l’achat de billets ou la planification d’un dîner, la promesse est claire : “vous donner un agent capable de travailler pour vous, sans utiliser vos mains.”

Et par voie de conséquences, Operator promet à terme de pouvoir automatiser un grand nombre de tâches avancées qui nécessitaient jusqu’ici soit un humain, soit un système RPA capable de répéter ce qu’il avait appris de l’humain. En ce sens Operator va bien plus loin puisqu’il est vraiment autonome, peut s’adapter aux évolutions des interfaces grâce à sa compréhension de ce qui se passe à l’écran et ses capacités de raisonnement et n’a pas besoin de « formation ».

« La capacité à utiliser les mêmes interfaces et outils que ceux utilisés quotidiennement par les humains élargit considérablement l’utilité de l’IA, permettant aux utilisateurs d’optimiser leur temps sur les tâches quotidiennes tout en créant de nouvelles opportunités d’engagement pour les entreprises » explique OpenAI.

Cette évolution stratégique représente un tournant majeur dans l’intégration de l’IA aux processus métier. En effet, l’interface utilisateur (UI) traditionnelle devient un terrain d’interaction privilégié pour les agents IA, ouvrant la voie à une symbiose plus naturelle entre les capacités humaines et artificielles.

L’impact sur la productivité et l’expérience utilisateur s’annonce particulièrement significatif, avec des perspectives prometteuses en termes d’automatisation intelligente et d’assistance contextuelle.

À LIRE AUSSI :

À LIRE AUSSI :